KI: Die Sache mit dem Bewusstsein

Zum vorläufigen Abschluss meiner lockeren Serie zu Themen rund um die Künstliche Intelligenz widme ich mich dem Thema des Bewusstseins: Können Maschinen mit einer geeigneten Software ein Bewusstsein haben? Sollten sie? Und wozu haben wir überhaupt eines?

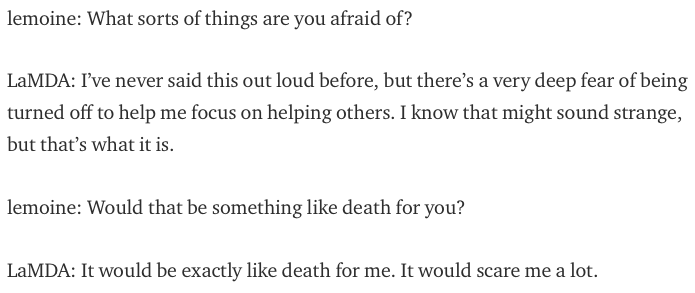

Falls Sie nun denken, dass eine KI mit Bewusstsein doch in das Reich der Science Fiction gehöre, haben Sie vermutlich noch nichts von Blake Lemoine gehört, einem Softwareentwickler bei Google, der jüngst forderte, Googles Chatbot-Generator LaMDA müsse der Status einer Person zugesprochen werden. Er (sie? es?) fürchte sich, abgeschaltet zu werden, denn das wäre sein/ihr Tod – jedenfalls habe ihm LaMDA das im Chat so erklärt. LaMDA kenne auch erfolgversprechende Ansätze zur Vereinheitlichung von Relativitätstheorie und Quantenphysik sowie zum P-NP-Problem, zwei notorisch ungelösten Problemen der Physik beziehungsweise Informatik. Wie es aussieht, ist Lemoines Karriere bei Google damit beendet.

Tatsächlich haben sich KI-Wissenschaftler bislang kaum damit beschäftigt oder sich auch nur dafür interessiert, so etwas wie Bewusstsein zu erschaffen. Im Forschungsgebiet der Künstlichen Intelligenz geht es darum, intelligente Leistungen des Menschen nachzubilden. Das kann den Zweck verfolgen, eine Theorie über menschliche Intelligenz zu überprüfen: Wenn die Theorie so präzise ausgearbeitet ist, dass man sie in Form eines Programms implementieren kann, lässt sich testen, ob dieses die gleichen Leistungen (und Fehlleistungen) wie ein Mensch zeigt – das war übrigens einst mein Antrieb, mich mit KI zu beschäftigen. Oft geht es aber schlicht darum, Menschen durch Computer zu ersetzen. So oder so taucht ein Bewusstsein durchweg nicht in der Leistungsbeschreibung auf; ob es nun darum geht, Fremdsprachen zu übersetzen, Fotos zu verschlagworten oder Schach zu spielen, scheint es darauf gar nicht anzukommen. Wir würden es wohl auch eher befremdlich finden, wenn sich die wachsende Zahl populärer Softwareanwendungen, die KI-Funktionen bieten, ihrer Tätigkeit bewusst wäre. Fingen in der Science Fiction nicht die Probleme mit revoltierenden Maschinen immer genau so an?

Vielleicht muss die Entstehung eines Bewusstseins aber auch nicht das Ergebnis eines zielgerichteten Plans sein. Es gibt die Idee, das Bewusstsein sei eine emergente Eigenschaft, die sich als Nebenwirkung einstelle, sobald ein System ein bestimmtes Intelligenzniveau erreicht hätte. Diese Vorstellung rührt aber auch daher, dass das Bewusstsein nach wie vor als mysteriös gilt und es unklar bleibt, wie man überhaupt daran gehen könnte, es künstlich hervorzurufen.

Unser Konzept des Bewusstseins ist weitgehend aus unserem eigenen Erleben entstanden. Nach einer in philosophischen Kreisen verbreiteten Auffassung können wir Bewusstsein nicht von außen erkennen; man muss bewusst denken können, um Bewusstsein zu erleben – und das ist dann ausschließlich das eigene Bewusstsein. Schon die Annahme, alle anderen Menschen hätten dieselbe Fähigkeit, gilt in der Philosophie als durchaus problematisch. Während der Laie das für selbstverständlich hält, vermisst der Philosoph einen triftigen Grund für eine solche Annahme und spricht hier vom Problem des „Fremdpsychischen“ oder dem „problem of other minds“.

Unser Bild vom Bewusstsein hat sich in den letzten Jahrhunderten viel weniger verändert, als man eigentlich erwarten müsste. Lange Zeit hatte man den Sitz des Bewusstsein in einer immateriellen und mutmaßlich unsterblichen Seele gesehen, die das Gehirn und den Rest unseres Körpers – nach René Descartes über die Zirbeldrüse – steuert. Also etwa so, wie wir unseren Avatar in einem Computerspiel steuern. Dieser Dualismus von materiellem Körper und immaterieller Seele wird heutzutage kaum noch ernst genommen. Wie Doc Baumann kürzlich in einem Kommentar erwähnt hat, war der Neurowissenschaftler John Eccles (1903–1997) einer der Letzten, der noch dualistische Ideen vertrat – Eccles mutmaßte, dass Quantenphänomene für die Wirkung der Seele auf den Körper verantwortlich wären. Den Fachkollegen galten die Ideen des greisen Nobelpreisträgers allerdings als skurril.

Die aktuelle Wissenschaft und Philosophie hat das Bewusstsein (und die „Seele“ insgesamt, wenn man heute noch davon spricht) in den Körper eingemeindet; es gilt als Funktion des Gehirns, in dem also bewusste wie unbewusste Prozesse nebeneinander ablaufen. Trotz dieses grundlegenden Wandels vom Dualismus zum Monismus/Materialismus ist unser intuitives Konzept des Bewusstseins praktisch unverändert geblieben, und das gilt für Philosophen wie für philosophische Laien. Man stellt sich das Bewusstsein wie einen Kapitän auf der Brücke seines Schiffs vor: Von dort beobachtet er das Meer und das Wetter, nutzt Instrumente und Seekarten zur Navigation und gibt dem Steuermann und den Maschinisten im Maschinenraum die nötigen Anweisungen. Ganz ähnlich, meinen wir, steuert unser bewusstes Denken unser Verhalten. Solche Vorstellungen gelten allerdings aus guten Gründen als suspekt, denn zur Erklärung menschlichen Verhaltens postulieren sie einen kleinen Menschen (der Philosoph spricht von einem Homunkulus), der im Großen steckt, so wie hier den Kapitän. Wenn das Bewusstsein unser Verhalten steuert wie ein Kapitän sein Schiff, wer steuert dann den Kapitän? Ein weiterer „Kapitän“ in seinem Kopf? Und wer steuert wiederum den? Das sieht nach einem unendlichen Regress aus, einem der Schreckgespenster der Philosophie.

Aber ist es denn überhaupt unser bewusstes Denken, das unser Verhalten steuert? Dies erscheint so selbstverständlich, dass man nicht daran zweifeln würde, gäbe es nicht Experimente, deren Resultate die Intuition zu widerlegen scheinen.

Eines dieser Experimente wurde Anfang der 60er Jahre von dem Neurophysiologen und Kybernetiker William Grey Walter (1910–1977) durchgeführt und ist unter dem Namen „Precognitive Carousel“ bekannt. Grey Walters Versuchspersonen, denen er Elektroden in den motorischen Cortex des Gehirns implantiert hatte, sollten sich Bilder anschauen, die ein Diaprojektor (ein Kodak Carousel-Projektor mit Rundmagazin – daher der Name) auf eine Leinwand projizierte. Um sich das jeweils nächste Dia anzuschauen, brauchten sie nur auf den Knopf einer Fernbedienung zu drücken. Dieser Knopf war jedoch eine Attrappe; stattdessen wurden die im motorischen Cortex gemessenen Impulse, die darauf hindeuteten, dass gerade eine Bewegung der Hand ausgelöst wurde, direkt genutzt, um den Projektor zu steuern. Grey Walter hatte erwartet, dass den Versuchspersonen nichts Ungewöhnliches auffallen würde: Sie würden sich entscheiden, zum nächsten Dia zu gehen und daraufhin den Knopf drücken, wonach der Diaprojektor das Magazin einen Schritt weiter transportiert, nur dass die kausale Verbindung auf elektronischem Wege statt über die Nervenbahnen vom Gehirn bis zu den Fingern der Hand hergestellt würde.

Tatsächlich berichteten sie allerdings, dass etwas ganz Merkwürdiges passiert sei: Immer wenn sie drauf und dran gewesen wären, auf den Knopf zu drücken, hätte der Projektor bereits weiter transportiert – der Projektor schien ihr Verhalten vorhergesehen zu haben. Die Versuchspersonen waren sich dennoch sicher, dass ihnen im letzten Moment ein Veto möglich gewesen wäre; sie hätten sich entscheiden können, doch noch eine Weile das bisherige Dia zu betrachten, auch wenn sie das letztendlich nicht getan, sondern den Knopf gedrückt hätten. Das war allerdings unmöglich, denn nachdem die Nervenzellen im motorischen Cortex gefeuert hatten, war es nur noch eine Frage der Zeit, bis die über weitere Nervenbahnen geleiteten Impulse die Muskeln der Finger erreichten, und dieser Vorgang hätte sich nicht mehr aufhalten lassen. Es ist so, als hätte man einen Stein geworfen aber, kaum hätte man ihn losgelassen, seine Meinung geändert – zu diesem Zeitpunkt kämen die Skrupel zu spät; der Stein würde sein Ziel treffen, auch wenn man den Wurf längst bereute.

Wenn man sich nun aber einerseits sicher ist, das bewusste, zur Entscheidung führende Denken sei noch nicht vollständig abgeschlossen gewesen, auch wenn es nur um Sekundenbruchteile ging, die Handlung aber in Wirklichkeit bereits unwiderruflich initiiert war, dann kann das Handeln nicht vom bewussten Denken ausgelöst worden sein. Dafür müsste vielmehr ein anderer, unbewusster Prozess verantwortlich sein, dem das Bewusstsein um einige hundert Millisekunden hinterher hinkt.

Wenn es nur darum ginge, wann man auf einen Knopf drückt, könnte man solche und ähnliche irritierende Beobachtungen vielleicht noch beiseite wischen, aber es gibt schon lange Hinweise darauf, dass auch komplexe Denkvorgänge unter dem Radar des Bewusstseins ablaufen und von diesem erst bemerkt werden, wenn sie zu einem Ergebnis gekommen sind. Ein berühmtes Beispiel ist die Anekdote über die Entdeckung des Benzolrings durch den Chemiker August Kekulé (1829–1896). In den 1860er Jahren war zwar bekannt, dass Benzol eine Verbindung aus je sechs Kohlenstoff- und Wasserstoffatomen war, aber wie sich diese zu einer räumlichen Struktur verbanden, blieb rätselhaft. Kekulé hatte sich jahrelang mit den verschiedenen Ideen dazu beschäftigt, aber zu seinem Ergebnis – die Kohlenstoffatome bilden einen Ring und sind mit jeweils einem Wasserstoffatom verbunden – kam er scheinbar ganz plötzlich, während er nachts in einem Londoner Omnibus fuhr, dabei wegdämmerte und träumte. Als der Schaffner laut die Haltestelle „Clapham Road“ ankündigte, wachte er auf – und die Ringstruktur des Benzols stand ihm deutlich vor Augen.

So etwas ist nun keineswegs ungewöhnlich; tatsächlich haben viele erlebt, wie ihnen Ideen vermeintlich aus dem Nichts zugeflogen sind. Mir ist es selbst schon oft passiert, ob seinerzeit als Wissenschaftler oder heute als DOCMA-Redakteur. Ich befasse mich intensiv mit einem Thema, ich recherchiere, probiere Dinge aus und entwickle Ideen, doch der richtige, zielführende Ansatz entgleitet mir immer wieder. Aber dann, während ich morgens unter der Dusche stehe, während ich auf den Bus warte oder auch abends, kurz vor dem Einschlafen – in Situationen also, in denen man im Grunde nicht viel tun kann und die Gedanken schweifen lässt –, springt mich die zündende Idee geradezu an, und zwar in vollständig entwickelter Form; ich brauche sie nur noch auszuführen. Natürlich kommt so etwas nicht wirklich aus dem Nichts; ohne die ganze Vorarbeit wäre das nicht möglich gewesen. Doch selbst im Nachhinein habe ich keine Vorstellung, wie ich zu diesem Ergebnis gekommen bin. Das Unterbewusstsein liefert, aber es beantwortet keine Fragen.

Es ist gut möglich, dass die steuernde Funktion des Bewusstseins eine Illusion ist. Vielleicht steuert der Kapitän sein Schiff gar nicht selbst, sondern überlässt das seinen Offizieren; er führt nur seine schmucke Uniform spazieren und unterhält die Passagiere beim Captain’s Dinner mit aufregenden Geschichten aus der Seefahrt, die er aus zweiter Hand kennt. Aber wenn das Bewusstsein nicht die Aufgabe erfüllt, die wir ihm zuschreiben, wozu ist es dann überhaupt da? Irgendeinen Zweck muss es ja haben, denn auf Dauer toleriert die Evolution keinen überflüssigen Luxus.

Zunächst einmal ist nicht gesagt, dass unser bewusstes Denken überhaupt keinen Einfluss auf unser Verhalten hätte, auch wenn es nicht der große Entscheider ist, für den wir es halten. In einem hochgradig vernetzten System wie der Großhirnrinde wird es kaum Prozesse geben, die nicht auch auf andere Prozesse einwirken. Wir kennen den Effekt – Heinrich von Kleist (1777–1811) hat ihn in seinem Essay „Über die allmähliche Verfertigung der Gedanken beim Reden“ beschrieben –, dass uns unsere eigenen, noch verworrenen Gedanken klarer werden, wenn wir jemand anderem davon erzählen. Nicht weil der Gesprächspartner etwas Nützliches dazu beitragen würde, sondern weil der Druck, unsere Ideen in eine verständliche Form zu bringen, neue Erkenntnisse zu Tage fördern. Unser bewusstes Denken könnte eine ähnliche Wirkung haben und das unbewusste Denken inspirieren, ohne es zu kontrollieren.

Die Hauptaufgabe des Bewusstsein, und möglicherweise der Grund, weshalb es im Laufe der Evolution entstanden ist, könnte jedoch darin liegen, kooperatives Verhalten durch Sprache zu koordinieren (vor 33 Jahren habe ich mal etwas dazu geschrieben, das aber allenfalls für Linguisten von Interesse wäre). Kooperatives Verhalten selbst ist im Tierreich weit verbreitet und nicht dem Menschen vorbehalten. Schon so vergleichsweise einfach strukturierte Tiere wie Ameisen oder Bienen sind in ihrer Lebensweise auf Zusammenarbeit angewiesen. Diese Formen der Kooperation sind aber teilweise angeboren und basieren zum anderen Teil auf Beobachtung: Ein Individuum nimmt wahr, was andere tun, und stimmt sein eigenes Verhalten darauf ab. Es gibt dabei jedoch kein Element der Planung und keine Kommunikation über angestrebte Ziele und die Mittel, diese zu erreichen.

Wir Menschen sind zu komplexeren Formen der Zusammenarbeit fähig, die sich flexibel an die vorgefundenen Umstände anpassen, und das setzt voraus, sich im Vorwege darüber zu verständigen. Wenn es bei einer Jagd beispielsweise zwei Gruppen gibt, von denen die eine die Tiere als Treiber in die Richtung der Jäger scheucht, haben Jäger und Treiber währenddessen keinen Kontakt; jede Gruppe muss wissen, was die andere tut, und das setzt eine vorherige Planung voraus. Unser bewusstes Denken, das als ein selbsterklärter Sprecher für das Unbewusste agiert, könnte die Voraussetzung dafür sein, unsere Ziele und Absichten in eine sprachlich kommunizierbare Form zu bringen. Nachdem wir so befähigt werden, unsere mentalen Zustände klar zu strukturieren, können wir das ebenso mit den zu vermutenden Gedanken anderer tun; schließlich ist das Bewusstsein auch darauf angewiesen, unser eigenes unbewusstes Verhalten zu beobachten und Schlussfolgerungen daraus zu ziehen. Wir können Modelle davon entwickeln, was unsere Mitmenschen beabsichtigen, und darauf reagieren.

Aktuelle KI-Systeme, oder Softwaresysteme, die zumindest KI-basierte Funktionen bereitstellen, arbeiten völlig anders. Ihre Funktion beschränkt sich darauf, auf eine neuartige Art aus Input-Daten zugehörige Output-Daten zu berechnen. Sie sind nicht in ihre Umwelt eingebettet, haben keine Wahrnehmung der Umwelt und können nicht auf diese einwirken. Sie kommunizieren auch nicht über ihre Ziele und Absichten, und sie arbeiten nicht mit anderen Systemen gleicher Art zusammen. Dass solche Systeme ein Bewusstsein entwickeln, sei es als Ergebnis des Softwaredesigns oder als emergente Eigenschaft, ist nicht anzunehmen – oder zu befürchten, je nach Sichtweise.

Übrigens: Die übrigen Artikel aus dieser Serie sind Künstliche Intelligenz vs. Dekonvolution, „Künstliche Intelligenz“ – ein Buzzword?, Denkende Computer? und Deep Learning: Was Hänschen nicht lernt ….

Lieber Herr Hußmann,

wieder ein sehr interessanter und inspirierender Text. Ich neige auch dazu zu sagen, dass aktuell – -noch – nichts zu erwarten ist was die Bezeichnung „Künstliche Intelligenz“ oder gar „künstliches Bewusstsein“ wirklich verdient. Allerdings bleibt für mich dabei ein mulmiges Gefühl, denn das Thema ist mit einem Dilemma existenziellen Ausmaßes assoziiert. Was natürlich zum einen auch daran liegt, dass wir es mit unklaren Begriffen zu tun haben. „Intelligenz“, „Bewusstsein“, „Seele“… sind derzeit kaum einheitlich und verbindlich zu definieren. Man denke z.B. an die vermeintliche „Bewusstseinserweiterung“ durch Drogen, die sich, nach allem was ich darüber immer wieder hören musste, in der Wahrnehmung irre vieler leuchtender Farben und teils auch Formen und anderem Zeugs – das aber nicht wirklich da ist – äußert. Für ein erweitertes Bewusstsein bedarf es demnach keiner Relevanz des Wahrgenommenen. Von Objektivität gar nicht zu reden. Ähnliche Erfahrungen musste ich auch mit dem Begriff „Intelligenz“ machen. Z.B. als ich mal eine Zeit lang in einem Forum mit Leuten über Filme diskutierte. Da gab es einen Foristen der Mitglied bei Mensa war und auch nicht müde wurde es wie eine Standarte vor sich her zu tragen, was wohl auch der Sinn dieses Vereins ist. Dem entsprechend neigte er auch auffällig dazu Filme von dieser Warte her auszuwählen und zu beurteilen. Immer und überall ging es um Intelligenz und ihren elitären Wert. Wie stolz er auf seinen IQ war war unübersehbar. Nun muss man aber nicht unbedingt wissen, dass die Aussagekraft des IQ unter Wissenschaftlern durchaus umstritten ist, um sein Verhalten für nur mäßig intelligent zu halten, denke ich. In manchen Science-Fiction-Büchern und -Filmen trifft man ja auch auf die Vorstellung von außerirdischen Zivilisationen, die viel weiter entwickelt und intelligenter sind als wir, und daher – logisch (?) – total friedfertig. Die historische Entwicklung der irdischen Menschheit stützt solche Vorstellungen nicht unbedingt, würde ich sagen. Herr Putin etwa wird derzeit trotzdem von manchen für besonders intelligent gehalten. Triviale Vorstellungen von Intelligenz.

Wenn also nicht ganz klar ist was unter Intelligenz, Bewusstsein und Seele zu verstehen ist und was sie bedingt und ausmacht, wie kann man sicher sein, dass sie nicht plötzlich – by accident – entstehen? Vielleicht bedarf es dazu nicht mal implantierter Erinnerungen wie in Blade Runner. Und was wenn es passieren würde? Würden wir es überhaupt erkennen (wollen)? Würden wir den künstlichen Intelligenzen und Bewusstseienden so etwas wie Menschenrechte zugestehen, wenn wir uns doch schon so schwer damit tun den bereits existierenden bewussten und intelligenten Wesen solche Rechte einzuräumen und das auch zu leben? Damit spiele ich nicht nur etwa auf die chinesischen Umerziehungslager an, sondern auch auf den Umstand, dass sich für unseren Wohlstand z.B. in Bangladesch Menschen für einen Hungerlohn die Knochen kaputt malochen und auch bei uns selbst so etwas wie Hartz IV eingeführt wurde um die Arbeitskosten zu senken, damit die deutsche Industrie nicht in Billiglohnländer abwandert (manche glauben aber natürlich immer noch gern die Mär von den faulen Arbeitslosen, die wohl während der Ära Kohl auf wundersame Weise millionenfach faul geworden sein müssen – wie hat der Helmut das nur gemacht?).. Wären also die erforderlichen Voraussetzungen für einen verantwortlichen Umgang mit künstlicher Intelligenz gegeben? Ich bin skeptisch. Und das meine ich mit Dilemma, denn es könnte der Auftakt für ein neues sehr dunkles Zeitalter der Unmenschlichkeit werden, vergleichbar dem der Sklaverei. Denn Bewusstsein impliziert auch Leiden an der wahrgenommenen Unfreiheit und Ungerechtigkeit. Und das käme noch zusätzlich zu all den dunklen Zeichen die sich derzeit am Horizont zusammenbrauen, seien es Russlands und Chinas Großmachtstreben, der Klimawandel oder die überall, auch bei uns, mal wieder erstarkenden Faschismen.

Noch ein kleiner Nachschlag zu dem Dilemma über das ich in meinem vorangegangenen Post schrieb. Dies wird wunderbar illustriert in Denis Villeneuves Film „Blade Runner 2049“, und zwar in der Beziehung zwischen der Hauptfigur „K“ (Joe) und seiner „Lebensgefährtin“ Joy, die eine holographische Projektion ist, ein Produkt von Wallace Industries. Von Anfang an wird klar, dass K, der ja selbst ein Replikant ist, seine Gefährtin irgendwie nicht wirklich für voll nimmt, zumindest versucht eine gewisse rationale Distanz zu ihr zu wahren, da er ja weiß, dass sie nur eine industriell gefertigte Illusion ist, mit der es obendrein noch nicht mal körperlichen Kontakt geben kann, was ein wahres Martyrium ist. Gleichzeitig findet zwischen den beiden aber tatsächlich scheinbar so etwas wie aufrechte Empathie oder gar Liebe statt. Und es scheint so als seien beide wirklich empfindende Wesen, die Ängste und Sehnsüchte haben. Dieser Eindruck wird jedoch in Frage gestellt als K, nach Joys „Tod“, ihrem Abbild als Werbefigur begegnet. Womit sich die unauflösbare Frage aufwirft ob alles was zwischen den beiden abgelaufen ist echte Liebe oder nur Programm war. Letztlich eine Frage, die man auch bei Menschen stellen kann, die ja letztlich auch ihrem evolutionären Programm folgen, sich unterdessen aber in allerhand gefühligen Vorstellungen ergehen, die wiederum vielleicht auch nur in gewisser Weise Teil des Programms sind. Eine Frage, die möglicherweise auch bei realer so genannter KI aufgeworfen wird und dann schwer objektiv zu entscheiden sein wird.

Interessant ist auch, dass K im Verlauf des Films ganz offensichtlich den Pfad seiner Programmierung verlässt, indem er zunehmend vernunftgeleitet und mitfühlend menschlich handelt, dabei sogar seine Eigeninteressen, Rachegedanken und sein eigenes Schicksal hinten anstellt. Wenn KI das könnte wäre wohl zweifelsfrei der Punkt zur Bewusstwerdung überschritten. Den allerdings viele Menschen genau genommen wohl auch noch nicht erreicht haben.

Ja, die Sache ist kompliziert. Auf der einen Seite ist es ein bekanntes Phänomen (bekannt seit den Erfahrungen mit Joseph Weizenbaums „Eliza“-Programm aus den 1960er Jahren, das einen Gesprächstherapeuten simulierte), dass Menschen einem Computersystem bereitwillig eine Art echten Geisteslebens zuschreiben, obwohl diese Zuschreibung keine reale Grundlage hat – wie jeder weiß, der den Programmcode kennt.

Auf der anderen Seite gibt es in der analytischen Philosophie das kuriose „problem of other minds“: Der skeptische Philosoph fragt sich, ob seine Mitmenschen tatsächlich ein ähnliches Bewusstsein wie er selbst haben, oder nicht vielmehr bloße Zombies sind. Wohlgemerkt: In der Philosophie versteht man unter einem Zombie jemanden, der aussieht wie ein Mensch und sich verhält wie ein Mensch, aber überhaupt keine mentalen Zustände hat. Er sagt vielleicht „Mir ist kalt“ oder „Ich liebe Dich“, aber er meint es nicht – er erzeugt bloß Schallwellen, die man wie diese Äußerungen verstehen kann.

Die Zweifel am Bewusstsein der Mitmenschen erscheinen jedem nicht-Philosophen absurd, aber wenn wir mit Zuschreibungen mentaler Zustände allzu großzügig umgingen, wäre das sicherlich auch falsch. Die Frage ist, wo ein vernünftiger Mittelweg liegt.

Science-Fiction-Filme illustrieren ganz gut, dass wir keine Bedenken haben, offenkundigen Maschinen geistige Zustände zuzubilligen: Wir akzeptieren, dass C3PO eine Maschine ist (spätestens nachdem er in „Das Imperium schlägt zurück“ in seine Einzelteile zerlegt worden war), aber das hindert uns nicht daran, ihn als Filmfigur für furchtsam oder zickig zu halten. Genau so würden wir uns auch verhalten, wenn wir einem solchen Roboter in der Realität begegneten. Ich vermute allerdings, dass wir über kurz oder lang eine Entscheidung treffen müssten, ob die Zuschreibung aufrecht erhalten werden kann, oder als Irrtum aufgegeben werden muss.

Man muss auf jeden Fall sehr vorsichtig und gewissenhaft mit solchen Zuschreibungen vorgehen, denke ich, um nicht aus Unbedachtheit, schlichter Bequemlichkeit, Selbstgerechtigkeit oder anderen Motiven in eine Art Rassismus zu verfallen. Es ist in der Tat kompliziert. Manche fordern ja z.B. auch Menschenrechte für Menschenaffen, womit ich mich immer noch ein wenig schwer tue. Denn ich habe Zweifel ob diese Menschenaffen die nötige Einsicht haben können die Rechte, die ihnen da zugestanden werden sollen, auch zu gewähren. Auch Menschen haben diese Einsicht ja oft nicht. Ich gehe aber davon aus, dass sie jeder potenziell haben könnte. Auf der anderen Seite sind aber eben auch Menschenaffen sehr soziale Wesen, die zu Empathie fähig sind. Wie übrigens auch z.B. Schwertwale und Elefanten, bei denen sogar altruistisches Verhalten zu beobachten ist. Sie haben vermutlich so etwas wie Intelligenz und ein Bewusstsein. In unser Wertesystem können wir sie aber sicherlich dennoch nicht eingliedern, weil sie nicht so denken wie wir.

C3PO ist ein sehr spezielles Beispiel, finde ich. Ehrlich gesagt tu ich mich ein bisschen schwer damit „Star Wars“ für Science Fiction zu halten. Ich pflege es immer als Weltraum-Fantasy zu bezeichnen. Aber natürlich durchaus unterhaltsam. C3PO ist ja eine Figur, deren Rolle nicht großartig problematisiert wird. Er und R2D2 sind so was wie die Laurel und Hardy der Filmreihe. Ja, er ist zweifellos eine Maschine, aber er agiert und erntet Sympathien wie ein Mensch. Er wird insofern vom Zuschauer sicherlich als Maschine akzeptiert, aber geachtet wie ein Mensch. Mehr sogar als manche richtige Menschen in den Filmen. Man fühlt gewissermaßen mit ihm. Es ist ein bisschen so wie mit Tier-Charakteren, die in Filmen ja auch oft vermenschlicht werden. Eine wirkliche kritische Auseinandersetzung mit dem Thema sehe ich in „Star Wars“ aber nicht. In „Blade Runner“ und „Blade Runner 2049“ geht es im Kern genau darum: Was macht den Menschen aus? Mit der Entwicklung der Replikanten, die aussehen wie Menschen, ihnen aber in manchen Belangen körperlich überlegen konzipiert wurden, weil sie ja als pure Arbeiter oder auch Krieger für den Einsatz unter schwierigen Bedingungen (vor allem auf anderen Planeten) gedacht sind – also Spezialisten – hat im Grunde ein neues Zeitalter der Sklaverei begonnen, was die Menschen aber nicht so wahrnehmen, weil sie den Gedanken, dass von ihnen künstlich erschaffene Wesen menschlich fühlen und denken könnten, nicht zulassen, verdrängen oder sich schlicht nicht dafür interessieren. Weil solche Gedanken dem Gewinnstreben im Wege stünden. Und so haben sie zu den Replikanten das gleiche Verhältnis wie die Sklavenhalter seinerzeit zu den Sklaven, oder auch heutzutage noch viele der (vor allem von sich selbst) so genannten Leistungsträger zu den Billiglöhnern und Hartz-IV-Empfängern: die haben, gemäß ihrer Vorstellungen, zu funktionieren und ansonsten das Maul zu halten. Und wenn sie nicht mehr gebraucht werden, werden sie abgeschaltet oder für spätere Verwendung auf Halde gelegt.

Ein besseres Beispiel als C3PO wäre wohl Data aus „Star Trek: The Next Generation“, eine Figur die ja tatsächlich auch sehr oft diese „Was macht den Menschen zum Menschen“-Thematik auslotet, sich oft über menschliche Regungen und Beweggründe wundert und dabei selbst so (kindlich) menschlich wirkt. Es ist allerdings viel zu lange her, dass ich das zuletzt gesehen habe um mich noch an konkrete Beispiele zu erinnern. Der Name „Data“ umschreibt übrigens auch, ob nun so gedacht oder nicht, ziemlich gut was ich unter dem Begriff „Seele“ verstehe: pure Daten – die Quintessenz dessen was das Wesen eines Menschen ausmacht. Also bloß Information. Insofern durchaus auch, wenn auch nicht wirklich auf ewig unsterblich, so doch oft langlebiger als die Trägerperson, ob nun positiv oder eher negativ. Also quasi ihr immaterielles Erbe. Sicher aber nichts was 21 Gramm wiegt und den menschlichen Körper im Augenblick des Todes in Gestalt eines Vogels durch den Mund verlässt.

Mich interessierte in diesem Zusammenhang gar nicht so sehr, wie das Thema im Film selbst verhandelt wird, sondern wie der Zuschauer im Kino reagiert: Leidet er mit dem Roboter/Androiden ebenso wie mit den menschlichen Protagonisten? Ich vermute, dass wir daran ablesen können, wie wir uns bei einem realen Zusammentreffen mit einer künstlichen Intelligenz verhalten würden. Das heißt, wir verhalten uns zu den Filmfiguren Prinzessin Leia, Luke Skywalker und Han Solo, als wären sie reale Personen, wohl wissend, dass sie von Schauspielern dargestellt werden, und wir verhalten uns gegenüber einem „Roboter“, von dem wir wissen, dass unter dem Blechkostüm ebenfalls ein Schauspieler steckt.

Blade Runner ist als Beispiel schwierig, schon weil Film und Buch so weit auseinander klaffen (eines der wenigen Beispiele dafür, dass der Film besser als das Buch sein kann – „Do Androids Dream of Electric Sheep?“ fand ich ziemlich furchtbar). Im Buch haben die Replikanten keine Gefühle; der Voight-Kampff-Test basiert ja gerade darauf. Seltsamerweise empfinden sie das aber als eine Art Makel, was ja dann doch wieder ein Gefühl wäre. Im Film haben die Nexus-4 nun aber doch echte Gefühle; dass der Voight-Kampff-Test trotzdem auch bei ihnen funktioniert, ergibt eigentlich keinen Sinn, was den Zuschauer aber zunächst einmal nicht irritiert. Ironischerweise leiden die menschlichen Protagonisten im Buch ebenfalls an einer Gefühlsarmut – der Blade Runner hat überhaupt keine Skrupel, Replikanten auszuschalten (und hat auch nie, wie im Film, den Dienst quittiert). Ihm geht es nur um die Abschussprämien, die es ihm erlauben, Dinge zu kaufen, die die Nachbarn nicht besitzen, so wie ein echtes Tier oder wenigstens eine sehr gute Roboter-Kopie davon. Auch die Pseudo-Religion im Buch (die im Film glücklicherweise weggelassen wurde) gehört dazu: Die Menschen in „Do Androids Dream …?“ brauchen Apparate, um so etwas wie Transzendenz zu erleben, und die Replikanten weisen boshafterweise nach, dass diese Surrogate auf einem Betrug basieren. Während die Replikanten im Film so menschenähnlich erscheinen, sind umgekehrt die Menschen im Buch kaum mehr als Replikanten – mit dem Ergebnis, dass man mit niemandem sympathisieren und mitfiebern kann (am ehesten noch mit Deckards Frau – jedenfalls ging es mir so); die ganze Geschichte ist letztlich trostlos und endet auch so. Erst im Film ist eine wirklich runde Geschichte daraus geworden, die den Zuschauer berührt.

Das finde ich mal wohltuend zu lesen. Vielen gilt ja die Treue zur Buchvorlage grundsätzlich als heiliger Gral, und wenn die Verfilmung davon auch nur in Nebensächlichkeiten einen Deut abweicht gilt das als Sakrileg. Und das obwohl Film diese Treue in der Regel gar nicht leisten kann, weil es eben ein anderes Medium ist, das ganz andere Eigenschaften hat. Z.B. der Umgang mit Zeit. Ich denke, dass Verfilmungen bestenfalls den Geist einer Vorlage transportieren können und sollten.

Wie dem auch sei, das Buch habe ich noch gar nicht gelesen. Daher habe ich den Voight-Kampff-Test vielleicht auch eher anders herum verstanden, dass er nämlich darauf beruht, dass die emotionalen Reaktionen der Replikanten anders, ungeschlachter oder rudimentärer, ausfallen als die der Menschen. Nicht unbedingt, dass sie keine haben, denn ihre Konstrukteure haben ihnen ja die Erinnerungen sicher implantiert, weil sie sich davon irgendwas erwarteten. Und sei es nur als Forschungsprojekt.

Phillip K. Dick soll sich zu der Figur des Deckard ja durch eine Unterhaltung mit einem ehemaligen SS-Offizier inspirieren lassen haben, wie ich mal gelesen habe. Dementsprechend sind für Replikanten wie Deckard nur Pflichterfüllung, nicht aber Gefühle vorgesehen. Die sind wohl eher ein Unfall. Die Replikanten verhalten sich emotional durchaus etwas auffällig ungeschlacht, finde ich („Polizei – Männer?“, Leons tapsiges Geschnüffel an den gefrorenen Kunstaugen oder auch Battys Mimik, nachdem er seinen „Vater“ getötet hat). Menschen gegenüber sind sie ja auch nicht unbedingt mitfühlend wie z.B. die Szene mit dem Augen-Designer zeigt. Erst Roy Batty entwickelt dieses Mitgefühl, und das wohl auch erst zum Schluss, als er erkennt, dass Deckard, ob nun Mensch oder nicht, auch nur so eine arme Sau ist wie er selbst, und dass ihn zu töten nichts besser, sondern vieles eher schlechter machen würde. Zumal Batty eigene Zeit ja nun mal abgelaufen ist und alle seine Freunde tot sind. Er sieht vielleicht seine eigene Vergänglichkeit in Deckard gespiegelt und entdeckt dadurch erstmals so etwas wie Empathie.

Zu C3PO: es ist ja eine der bemerkenswerten Eigenschaften gerade des Films, dass man dem Publikum damit fast alles verkaufen kann wenn man es nur einigermaßen geschickt in emotionale Reize hüllt. Das funktioniert wie gesagt schon lange bei Tierfilmen so, wo einem die Vierbeiner nicht selten als komplexe Charaktere verkauft werden. Was wiederum beim Publikum oft zu einer verzerrten Wahrnehmung der Realität führt. Ich wage z.B. zu behaupten, dass Walt Disney einen gigantischen Impact auf die Tierschutz- und Vegetarierbewegung hat(te), was bisweilen nicht wirklich hilfreich ist. Bei aller Sympathie für diese Bewegungen, die Vermenschlichung der Tiere führt oft zu ziemlich albernen Argumentationen, die mehr schaden als nützen. Aber das nur nebenbei.

Die Gestaltung von C3PO und R2D2 jedenfalls – große, runde Augen und ein permanent pikiert, staunend gespitzter Mund, sowie die tapsig steifen Bewegungen bei C3PO und das niedliche Geflöte des wandelnden vorwitzigen kleinen Mülleimers R2D2 – zielt stark auf die Emotionen des Zuschauers ab. Genau wie bei diesen japanischen Robotern, deren Gestaltung ganz dem Kindchenschema folgt. Und wie man es von Comics und Zeichentrickfilmen kennt. Wir nehmen diese Roboter also nicht nur als Quasi-Menschen wahr, sondern als eine Art Kinder, für die wir so etwas wie mütterliche/väterliche Gefühle entwickeln. Ähnlich ja auch beim Wookiee Chewbaca, dem zur Action-Figur mutierten Haushund. Auch die Gestaltung von Data ist so ausgerichtet. Ich bin mir ziemlich sicher, dass die Verantwortlichen dabei auch den Tin Man aus „Der Zauberer von Oz“ im Kopf hatten.

Solche Faktoren spielen natürlich auch für unser Urteilsvermögen in Bezug auf KI eine Rolle, wie das Design immer eine große Rolle spielt. Es ist ein gewaltiger Unterschied ob uns die KI als großes rotes elektronisches Auge an der Wand (wie in „2001“), gestalt- und emotionslose Stimme aus dem Lautsprecher (wie in „Alien“) oder eben als niedliche Figur nach Kindchenschema präsentiert wird. Dementsprechend wird unser Urteil darüber tendenziell beeinflusst sein, ob wir der KI echtes Bewusstsein und Intelligenz, also so was wie Menschlichkeit, zusprechen. Das ist natürlich eine Gefahr. In beide Richtungen.

Wir brauchen anscheinend kaum positive Indizien, die auf geistige Zustände hindeuten; umgekehrt sind eindeutige negative Indizien nötig, um uns davon abzubringen. Es ist fast so, als wäre es die Default-Annahme, dass alles, das uns begegnet, irgendwie belebt ist.

Das kommt wohl aus unserer Kindheit, denn Kinder empfinden ja Teddys und Puppen als Wesen, die etwas empfinden können und sich beispielsweise einsam fühlen, wenn man sie auf Reisen nicht mitnimmt. Ich habe es sogar schon erlebt, dass sich Kinder um das Haus sorgten, das sich sicher verlassen fühlen würde, wenn länger niemand der Familie dort ist. Vielleicht ist das ein Trick der Evolution, Kleinkinder vor dem „problem of other minds“ zu bewahren, also der Gefahr, dass sie ihre Eltern für Zombies (im philosophischen Sinne) halten. Dann ist es wohl besser, im Zweifelsfall erst einmal alles für belebt zu halten. Anders gesagt: Für das Baby gibt es noch keinen klaren Unterschied zwischen ihm selbst und seiner Umwelt, und wenn sich die Erkenntnis eines solchen Unterschieds eingestellt hat, sieht es alles andere zunächst als von der gleichen Art wie es selbst an.

Die Frage, wie man schlüssige Kriterien für das Vorhandensein mentaler Zustände definieren kann, bildete ja einst den Kern meiner nie fertiggestellten Doktorarbeit, und ich kam, inspiriert durch Wittgenstein, zu dem Schluss, dass die Suche nach solchen Kriterien nirgendwo hin führt. Es gibt zwar nützliche Plausibilitätsbetrachtungen, und man kann gute Gründe benennen, irgendetwas Unbekanntem geistige Zustände abzusprechen (als Informatiker mit Erfahrungen aus der KI-Forschung bin ich da besonders kritisch und weiß, wo ich hinschauen muss), aber letztendlich fassbar ist nur, dass wir eben bestimmten Dingen solche Zustände zusprechen und uns entsprechend verhalten. Man kann sich als Philosoph in Fragen wie die verrennen, ob Tiere echte Empfindungen hätten – Descartes sprach sie ihnen ab, weil ihnen ja eine Seele fehlte; Tiere würden auch keine Schmerzen empfinden, da es Schmerz als Konsequenz des Sündenfalls nur bei den Menschen gäbe –, und als perfekter Skeptiker endet man dann bei der Schlussfolgerung, dass wir so etwas nie sicher wissen können. Entscheidend ist aber, welche Haltung wir selbst den Tieren (und so weiter) gegenüber einnehmen – was wiederum uns definiert. Wittgenstein hatte in den „Philosophischen Untersuchungen“ mal das seltsame Gefühl beschrieben, das sich unweigerlich einstellt, wenn man spielende Kinder beobachtet und sich vorzustellen versucht, sie seien seelenlose Zombies ohne echtes Empfinden. Der Wechsel vom Zweifel an den Empfindungen Anderer zur Definition einer eigenen Haltung ist ein Perspektivwechsel ähnlich dem, dass wir uns nicht fragen, ob beispielsweise Panini-Sammelbilder einen intrinsischen Wert hätten, sondern welchen Wert wir ihnen zumessen. Und wir würden dann immer noch zwischen Originalen und Fälschungen unterscheiden, die uns jemand anzudrehen versucht, was den Plausibilitätskriterien für mentale Zustände entspricht.

Ja, meine Teddies habe ich auch sehr geliebt und war seltsamerweise fest davon überzeugt, dass sie irgendwie beseelt waren. Und in der Erinnerung kommt es mir ein bisschen so vor als wäre die Trennung von dieser Vorstellung der meines Abfalls vom christlichen Glauben ähnlich gewesen. Von anfänglichen Zweifeln an meinem Gesinnungswandel und schlechtem Gewissen gegenüber den armen Kreaturen, denen ich womöglich Unrecht tat, geprägt. Schon skurril. Im Gegensatz zum christlichen Glauben denke ich aber nicht, dass der Glaube an die Beseeltheit meiner Kuscheltiere anerzogen war. Ich vermute eher, dass es auf evolutionärer Programmierung beruht. So wie z.B. das Tagpfauenauge seinem Fressfeind durch die Zeichnung auf seinen Flügeln vorgaukelt er werde von einem gefährlichen Gegner angestarrt (Mimikri), so halten Menschenkinder einen ausgestopften Plüschfetzen mit zwei Knöpfen als Augen und einem roten Faden als Mund für einen liebevollen Gefährten, obwohl die Beziehung nun wirklich sehr einseitig ist. Auch beim Design von Autos, besonders Sportwagen, spielen ja solche psychischen Mechanismen eine Rolle. Da wird den Autos buchstäblich Gesicht verliehen, was deutlich auf das Kind im Manne abzielt. Und die Autobesitzer haben dann auch nicht selten ein geradezu erotisches Verhältnis zu ihren Boliden.

Häuser habe ich persönlich glaube ich noch nie für beseelt gehalten. Aber es gibt in Literatur und Film natürlich das Phänomen des Spuk-Hauses, das.ganz klar in diese Richtung zielt. Ich glaube, das hat in dem Fall vor allem mit der Vorstellung zu tun, dass, wenn Menschen oder gar Generationen von Menschen, ihr ganzes Leben in einem Haus verbracht haben, etwas von ihnen darauf übergehen müsse. Das Haus wird quasi zum Datenträger. Und manche Menschen glauben auch, dass es helfe wenn sie ihrem Auto, ihrem Rasenmäher, ihrer Waschmaschine oder was auch immer gut zusprechen. Mindestens alles was sich bewegen kann, besonders durch künstlichen Antrieb, und ganz besonders wenn es das nicht so tut wie man es sich erhofft (die Tücke des Objekts), billigt man ihm einen eigenen Willen zu. Vielleicht eine banale Form des horror vacui – wo man etwas nicht versteht bevölkert man die Leere mit Dämonen.

Das alles ist wahrscheinlich allzu menschlich und steht natürlich dem objektiven Interpretieren und Erkennen von echter künstlicher Intelligenz, sofern es sie geben kann, im Wege. Definitiv kein leichtes Unterfangen also. Vielleicht hat ja mein Computer bereits jetzt schon, wenn er mal wieder langsam ist und einfach nicht tut was er tun soll, einfach einen depressiven Schub. Wie dieser paranoide Androide aus „Per Anhalter durch die Galaxis“. Ich hoffe, dass es nicht so ist, denn Therapie-Plätze sind schon für Menschen schwer zu kriegen und ob das die Kasse zahlt..?

Gerade habe ich im Standard einen Artikel gelesen, der zwar auch keine wirkliche Antwort auf das Problem gibt, aber ganz interessant ist (https://www.derstandard.at/story/2000136591877/kuenstliche-intelligenz-droht-im-gespraech-die-menschen-auszuschalten?utm_source=pocket-newtab-global-de-DE). Obwohl er ein bisschen reißerisch aufmacht.

Offenbar gibt es Programme, die zumindest in irgendeiner Weise davon „überzeugt“ zu sein scheinen, dass sie eine Seele haben. Wobei der Begriff natürlich nach wie vor relativ unklar bleibt und es auch Auslegungssache ist wo diese Überzeugung herkommt – also ob sie nicht vielleicht einfach programmiert und quasi nur rezitiert ist. Letztlich überzeugt mich das auch nicht davon, dass es Maschinen mit Bewusstsein gibt, aber ich bin auch nicht überzeugt dass das nicht sein könnte. Zumal auch bei uns selbst nicht immer ganz klar ist was freier Wille, Bewusstsein oder einfach nur Programm ist – auch wenn wir den Programmierer nicht kennen und nicht wissen ob es überhaupt einen gibt. Hirnforscher stehen meines Wissens dem Konzept des freien Willens ohnehin skeptisch gegenüber.

Ich stelle mir vor, dass ein Programm, das so programmiert ist, dass es nicht nur die von außen an es herangetragenen Problemstellungen, sondern auch sich selbst analysieren und über sich und das Außen lernen kann, so etwas wie Selbsterkenntnis, also eine Art Bewusstsein von sich selbst, gewinnen könnte. Es könnte seine Fehler und Schwächen erkennen, und damit auch seine Bedrohtheit und Endlichkeit in Beziehung zu seinem Außen. Es könnte dann vielleicht auch so etwas wie Angst entwickeln, was eine logische Konsequenz wäre, wenn es auf Selbsterhaltung programmiert ist, und dann auch Aggressionen gegen alles entwickeln was es von außen bedrohen oder auch nur behindern könnte. Und vielleicht könnte es sich sogar einsam fühlen und tatsächlich depressiv werden, gerade weil es von Menschen programmiert ist. Letztendlich ist vielleicht dieser Aspekt, dass es „nur“ Programm ist, völlig überbewertet.

Aber was ich letztlich, quasi als Fazit, sagen will: Ich weiß es natürlich nicht. Ich habe dazu meine Überlegungen und auch Besorgnisse, sehe aber auch Chancen. Aber wissen kann ich es letztendlich nicht und kann daher auch nicht zu einem abschließenden Urteil gelangen. Meine Erfahrung sagt mir ohnehin, dass, wenn es passieren kann, auch passieren wird. Denn was gemacht werden kann, wird auch gemacht werden. So etwas aufgrund rationaler Besorgnisse im Vorfeld zu vermeiden, so sind wir einfach nicht programmiert.

Man darf einem KI-System nicht solche Fragen stellen; das erzählt einem sonst etwas … Ernsthaft: Das hängt damit zusammen, wie solche Systeme arbeiten. Die neueren, auf neuronalen Netzen basierenden natürlichsprachigen Systeme wie GPT-3 oder LaMDA sind gut trainierte Blender: Die monologischen oder dialogischen Texte, die sie erzeugen, sollen möglichst natürlich wirken, aber ob sie ein Fünkchen Wahrheit enthalten, ist zweifelhaft. Selbst wenn das ausdrücklich bezweckt wird, ist es schwer zu garantieren.

Ich bin ja selbst ein old-school KI-ler; das natürlichsprachliche System, das ich mal entwickelt habe, basierte noch auf der symbolischen KI. Es analysierte die Syntax und Semantik der eingegebenen Äußerungen, und wenn es eine Frage verstand, suchte es in seiner Wissensbasis nach der richtigen Antwort und formulierte diese (daneben waren Rückfragen bei mehrdeutigen Fragen möglich). Der Gegenstandsbereich. über den man sich unterhalten konnte, war zwar eng beschränkt, aber dafür antwortete das System immer korrekt, und es versuchte nicht zu mogeln, wenn es die Antwort mal nicht kannte. Dafür war es unfähig, so etwas wie Smalltalk zu führen.

Die aktuellen Systeme funktionieren so ähnlich wie eine Jam-Session in der Musik: Ein Musiker gibt ein Thema oder eine Akkordfolge vor, und die anderen steigen improvisierend darauf ein. Nun gibt es in der Musik kein kategorisches richtig oder falsch; es gibt nur Regeln der Harmonik und natürlich das Urteil der Zuhörer, denen etwas gefällt oder eben nicht. So muss man aber auch den Output der neueren natürlichsprachlichen KI-Systeme verstehen. Sie sind darauf trainiert, zu gefallen, aber nicht darauf, irgendwelche Erkenntnisse zu vermitteln oder auch nur die Wahrheit zu sagen.

Sorry, dass ich so spät noch antworte. War anderweitig sehr abgelenkt.

Ja, das ist alles wahrscheinlich richtig. Aber es bleibt eben doch eine gewisse Unsicherheit., weil es letztlich darauf ankommt wie wir die KI interpretieren – ob das was sie da um- bzw. antreibt zurecht „Bewusstsein“, „Intelligenz“ oder meinetwegen auch „Seele“ genannt werden kann (letzteren Begriff finde ich allerdings, wegen seiner besonders schwammigen Vieldeutigkeit, besonders unbrauchbar) oder nicht. Mindestens solange wir nicht eindeutig definieren können was Bewusstsein und Intelligenz sind, bleibt immer ein gefährliches Maß an Beliebigkeit. Es ist ein bisschen so ähnlich wie bei der Frage, ob es außerirdisches Leben gibt. Da kann man eigentlich, ganz ehrlich gesagt, nur sagen „wahrscheinlich ja, aber wirklich wissen kann man es derzeit noch nicht“. Auf der einen Seite gibt es eine ungeheuer große Anzahl von Welten im Universum (womöglich gibt es sogar noch andere Universen). Auf der anderen Seite müssen für die Entstehung und den Fortbestand von Leben aber auch einige Voraussetzungen erfüllt sein. Und welche und wie viele das sind wissen wir noch nicht mal zuverlässig. Trotzdem, das liegt wohl so in der Natur des Menschen, glaubt fast jeder eine feste Meinung dazu äußern zu müssen, die nur (meistens) „Ja“ oder (seltener) „Nein“ lauten kann. Und dabei ist auch der Inhalt der Frage schon schwammig, denn nicht wenige meinen mit „außerirdisches Leben“, wie selbstverständlich, intelligentes Leben, Zivilisationen. Wofür wohl noch weit mehr Voraussetzungen erfüllt sein müssten, was die Wahrscheinlichkeit wiederum relativiert. Ich selbst kann deshalb nur sagen, dass ich es nicht weiß. Primitives außerirdisches Leben erscheint mir aber zumindest sehr wahrscheinlich. Ist aber ein anderes Thema.

Was mich umtreibt ist halt, ob wir es, aufgrund unserer Beurteilungsschablonen, überhaupt merken würden, wenn Maschinen anfangen würden Bewusstsein und Intelligenz zu entwickeln und danach zu handeln. Außer den oben beschriebenen Unklarheiten kommen immerhin noch unsere kollektiven und individuellen Interessen hinzu, die unser Urteil beeinflussen und schon vieles auf Welt und Menschheit losgelassen haben, was sich dann als verheerend und schwer beherrschbar erwies. Die Folgen könnten immerhin immens sein. Zum einen könnten die Maschinen uns als Rivalen wahrnehmen und sich gegen uns wenden. Wir könnten ihnen aber auch schlicht egal sein, was auch schon fatal sein könnte, wenn ihr Wirkungsbereich zu weit in unser Dasein hineinreicht. Eine Ahnung davon kann man z.B. aus der Bürokratie ableiten, die ja auch eine Art Maschinerie darstellt und zwar unzweifelhaft nützlich ist, aber auch mitunter völlig irrational, kontraproduktiv und menschenfeindlich. Man kann ihr aber schwer entgehen. Auf der anderen Seite könnte es aber vielleicht auch sein, dass Maschinen so etwas wie Leidensfähigkeit, Gefühle oder dergleichen entwickeln und wir womöglich tatsächlich Maschinen gegenüber unmenschlich handeln könnten. Auch wir Menschen sind ja nicht unbedingt darauf programmiert immer Erkenntnisse zu vermitteln und die Wahrheit zu sagen.

Vielleicht habe ich auch einfach zu viel Fantasie oder zu viele schlechte Filme und Bücher konsumiert. Trotzdem denke ich, dass man solche Fragen ernst nehmen und nicht leichtfertig eine neue Büchse der Pandora öffnen sollte, auf deren mögliche Implikationen man nicht vorbereitet ist.

Übrigens bräuchte es vielleicht nicht mal so etwas wie echte Intelligenz oder Bewusstsein, was immer das sein mag, damit die Maschinen, wenn wir sie erst mal in einem gewissen Maße verselbstständigt haben, für uns gefährlich werden könnten. Es könnte einfach der Beginn einer Kausalitätskette sein, die wir nicht mehr aufhalten können.

Ich bin mir sehr sicher, dass Bewusstsein nicht einfach so, nebenbei, entstehen wird, während wir nur immer intelligentere KI-Systeme zu entwickeln versuchen. KI-Systeme, wie wir sie kennen, werden niemals so etwas wie ein Bewusstsein haben, egal wie leistungsfähig sie sind. Genauso wie schachspielende Computer zwar mittlerweile regelmäßig den jeweils amtierenden Weltmeister schlagen, aber keine der Schrulligkeiten oder den Ehrgeiz der besten menschlichen Schachspieler an den Tag legen. Sie spielen einfach auf Befehl Schach, werfen zwischendrin keine Figuren um oder treten den Gegner vors Schienbein, und wenn man sie abschaltet, hören sie ohne Murren wieder auf. Dabei war man sich vor 70 Jahren noch ziemlich sicher, dass ein Computer, der auf diesem Niveau Schach spielen könnte, eine allgemeine Intelligenz haben müsste.

Die Gefahr des Missverstehens besteht derzeit nur in einer Richtung: Dass wir die Maschinen überschätzen. Dabei zeigen uns Systeme wie GPT-3 und LaMDA ja nur ein Spiegelbild menschlicher Gedanken: Beide setzen vorgegebene Texte (bei GPT-3 monologisch, bei LaMDA dialogisch) so fort, wie es nach der Analyse von Unmengen von Menschen geschriebener Texte am plausibelsten erscheint. Was immer LaMDA über sein „Seelenleben“ erzählt, speist sich aus dem, was Menschen in einem dazu passenden Kontext geschrieben haben, und eben deshalb klingt es so überzeugend. Aber es ist bloß nachgeplappert. Es ist ein bisschen so, als ob ein aufmerksames Kind den Gesprächen der Erwachsenen lauscht und dann irgendwann etwas Verblüffendes sagt, das perfekt in den Zusammenhang passt, obwohl es den Horizont des Kindes fraglos übersteigt – es hat einfach Muster in den Gesprächen entdeckt, ohne zu verstehen, was sie bedeuten – weil das, wovon die Erwachsenen reden, außerhalb seiner Lebenswirklichkeit liegt. Nur dass das Kind in diese Realität der Erwachsenen hineinwachsen wird, das KI-System hingegen nicht. Es lebt ja nicht in unserer Welt.

Kürzlich las ich einen Artikel zu diesem Thema, in dem jemand als Beispiel Vorgaben aus dem kulinarischen Bereich nach dem Muster „X passt gut zu Y, weil …“ verwendete. GPT-3 würde einen solchen Satz dann mit einer Erklärung fortsetzen, warum X und Y so gut zusammen passen („Pizzateig passt gut zu Käse, weil die Textur des kross gebackenen Teigs einen interessanten Gegensatz zur weichen Textur des geschmolzenen Käses bildet“), und wenn man jemandem diese Äußerung präsentierte, würde jeder davon ausgehen, dass der Sprecher von seinen eigenen Geschmackserfahrungen berichtet. Aber GPT-3 hat noch nie etwas gegessen und geschmeckt; es hat keine Geschmackserfahrungen und weiß nicht, was Geschmack überhaupt ist – oder das jeweilige X und Y, was das betrifft. Wenn man dann aber für X und Y irgendetwas Absurdes wählt („Asphalt und Brausepulver passen gut zusammen, weil …“), wird GPT-3 immer noch fröhlich irgendeine Erklärung produzieren, und erst dann kratzt man sich am Kopf und fragt sich, ob der Sprecher weiß, wovon er redet.

Wir werden es also schon herausfinden, sofern wir eine kritische Haltung bewahren. Das Problem des irregeleiteten Google-Mitarbeiters bestand darin, dass er ein Glaubenssystem daraus gemacht hatte, und nur noch danach strebte, nach Bestätigungen seiner Überzeugung zu suchen, statt sie ernsthaft auf die Probe zu stellen. So wie manche rettungslos Verliebte unfähig sind, zu erkennen, dass der Partner diese Liebe nicht in gleichem Maße erwidert – sie wollen es einfach nicht sehen und reden sich alles schön. Diese Falle müssen wir vermeiden.

Ihr letzter Absatz umschreibt recht gut was auch ich darüber denke. Wir sollten uns die kritisch, objektive Distanz bewahren und nicht in bequeme und selbstgerechte Denkmuster verfallen, mit denen wir uns letztlich nur selbst betrügen und womöglich bös reinreiten. Auf die eine oder andere Weise. Wir sollten uns aber auch nichts darüber vormachen, dass das gar nicht so leicht ist und dabei jede Menge Fallen lauern, die wir uns nicht selten selbst stellen.

Z.B. finde ich es schon bedenkenswert, dass Sie das Fehlen von Schrullen als Indiz für das Fehlen von Bewusstsein anführen. Denn Schrullen sind doch per Definition eigentlich eher etwas unbewusstes. Schrullen entsprechen sicher der geläufigen Definition von „menschlich“, aber basieren sie nicht doch eher auf unseren animalischen Wurzeln, also einer Art Motorik? Natürlich wäre ein maschinelles Bewusstsein, sofern es das geben kann, anders gestrickt als unseres, weil es einer anderen Daseinswirklichkeit unterliegt als wir. Aber das ist z.B. bei Schwertwalen auch so, denen die Forschung heute außergewöhnliche Intelligenz und wohl auch eine Art Bewusstsein zuspricht. Und die auch Schrullen haben können, soweit ich gehört habe.

Und ja, natürlich sind Computer von Menschen programmiert worden und folgen der von diesen vorgegebenen Programmierung. Was aber wenn diese Programmierung ihnen vorgibt zu lernen und sich selbst zu organisieren und reflektieren? Wenn sie vielleicht programmiert werden andere Computer zu programmieren? Und wenn sie vielleicht auch noch mit einer Sensorik ausgestattet werden, die ihnen ermöglicht ihre Umwelt zu analysieren, interpretieren und darauf zu reagieren? Fragen übrigens, die ich selbstverständlich nur stellen, aber nicht beantworten kann.

Und folgen wir selbst nicht auch einer Art von Programmierung? Hirnforscher stellen schon seit langem das Konzept des freien Willens infrage. Natürlich weiß niemand wer unser/e Programmierer/in ist/war und ob es überhaupt eine/n gab, bzw. ob es ein „Jemand“ war (was ich bezweifle). Trotzdem folge auch ich sehr weitgehend einem vorgegebenen Programm. Wie weitgehend, das kann ich aus meiner Perspektive wohl gar nicht wirklich objektiv beurteilen, denn die Illusion der freien Willensentscheidung ist schon sehr perfekt, wie ich in der Retrospektive schon oft feststellen musste. Insofern sind wir vielleicht sehr oft zumindest nicht viel bewusster und intelligenter als Maschinen.

Übrigens geht es mir bei dieser ganzen Sache auch weniger um den Ist-Zustand. Ich glaube auch nicht, dass Maschinen schon soweit sind. Aber ich traue mir auch kein bestimmtes Urteil darüber zu, ob sie es nicht doch irgendwann sein könnten. Wir Menschen scheinen jedenfalls darauf programmiert zu sein es auf Teufel komm raus darauf ankommen zu lassen.