Der faustische Pakt in der Hosentasche: Wie ein Sensor die Fotografie für immer veränderte

Die Fotografie ist tot. Lang lebe die Fotografie. Diese paradoxe Feststellung beschreibt treffend den Zustand unserer visuellen Kultur, seit das Smartphone seinen Siegeszug angetreten hat. Was einst ein bewusster Akt des Festhaltens war, ist zu einem permanenten visuellen Bewusstseinsstrom geworden. Die Kamera ist nicht mehr nur ein Werkzeug, sie ist ein Körperteil, eine Erweiterung unseres Gedächtnisses und unserer Kommunikationsfähigkeit. Im Zentrum dieser tektonischen Verschiebung steht keine neue Kameramarke und kein revolutionäres Objektiv, sondern die unscheinbare Arbeit eines Professors, dessen Forschung heute in Milliarden von Geräten steckt.

Der Revolutionär

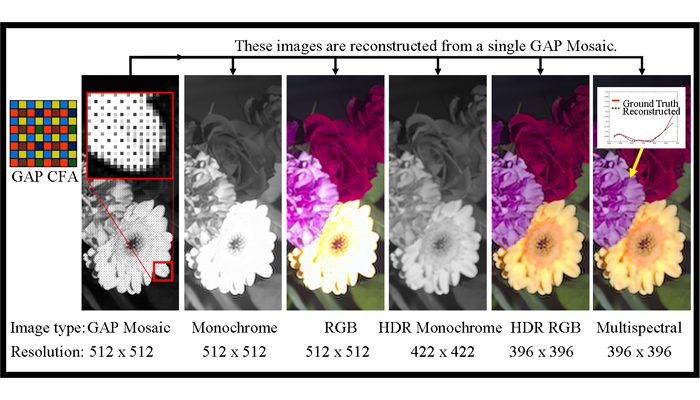

Die Rede ist von Shree Nayar, Leiter des Imaging and Vision Laboratory an der Columbia University. Er und sein Team knackten eine der härtesten Nüsse der digitalen Fotografie: die Bewältigung hoher Kontrastumfänge in einer einzigen, schnellen Aufnahme. Jeder Fotograf kennt das Dilemma: Entweder der Himmel brennt aus, oder die Schatten saufen im Schwarz ab. Die bisherige Lösung, das klassische HDR-Verfahren, war ein rechenintensiver Kompromiss aus mehreren Aufnahmen, oft geplagt von Bewegungsartefakten und einem unnatürlichen Bildeindruck. Nayars Ansatz war fundamental anders und genial einfach. Seine „Assorted Pixel“-Technologie weist benachbarten Pixeln auf dem Sensor unterschiedliche Belichtungszeiten zu – und das simultan. Ein Pixel fängt die Lichter mit einer kurzen Belichtung ein, sein direkter Nachbar die Schatten mit einer langen. Ein ausgeklügelter Algorithmus verrechnet diese unterschiedlichen Helligkeitsinformationen unmittelbar nach der Aufnahme zu einem einzigen Bild mit einem enormen Dynamikumfang. Sony lizenzierte diese Technologie und baute sie in seine Sensoren ein, die heute das Herzstück unzähliger Smartphones von Apple bis Google bilden.

Vom Bildermacher zum Bildverwerter

Die technische Eleganz dieser Lösung ist jedoch nur die eine Seite der Medaille. Die andere, weitaus folgenreichere ist die kulturelle Umwälzung, die sie lostrat. Mit der Fähigkeit, technisch anspruchsvolle Lichtsituationen per Knopfdruck zu meistern, wurde die Fotografie endgültig von ihren technischen Fesseln befreit und radikaler demokratisiert als je zuvor. Was die Kodak Brownie für das Bürgertum des frühen 20. Jahrhunderts und die Polaroid für die Partykeller der Siebziger war, ist das Smartphone für die gesamte globalisierte Welt – nur eben universeller, schneller und vernetzter. Schätzungen zufolge werden heute rund 85 Prozent aller Bilder mit dem Telefon aufgenommen.

Diese Allgegenwart hat unsere Beziehung zum fotografischen Bild von Grund auf verändert. Das Fotografieren ist keine geplante Handlung mehr, sondern eine reflexhafte Reaktion. Wir dokumentieren nicht mehr nur die Höhepunkte des Lebens, wir kommunizieren durch Bilder. Das Foto des Mittagessens ist kein Stillleben, sondern eine soziale Statusmeldung. Der Sonnenuntergang ist kein Landschaftsbild, sondern ein geteiltes Gefühl. Die Fotografie wurde von einer Kunstform zu einer Sprache, von einem Handwerk zu einer Geste.

Das Paradox der Bilderflut

Doch dieser Siegeszug hat einen hohen Preis. Es ist ein faustischer Pakt, den wir eingegangen sind: Im Tausch gegen die mühelose, allgegenwärtige Bilderzeugung haben wir die Wertigkeit des einzelnen Bildes geopfert. Nie wurde mehr fotografiert, und nie war das einzelne Bild potenziell bedeutungsloser. In der täglichen Kakofonie von Milliarden geteilter Aufnahmen verkommt die einzelne Fotografie zum visuellen Grundrauschen, das für einen flüchtigen Moment auf einem Bildschirm aufleuchtet, bevor es von der nächsten Aufnahme verdrängt wird.

Gleichzeitig verschiebt sich die Grenze zwischen Dokumentation und Kreation. Die computational photography, deren Fundament Nayar legte, nimmt dem Fotografen immer mehr Entscheidungen ab. Der Algorithmus entscheidet über die „richtige“ Belichtung, optimiert Farben, schärft Konturen und bügelt Hautunreinheiten glatt, noch bevor der Anwender den Finger vom Auslöser genommen hat. Die Kamera ist kein neutrales Aufzeichnungsgerät mehr, sondern ein aktiver Komplize der Bildgestaltung, der eine voroptimierte, gefällige Version der Wirklichkeit anbietet. Die Frage ist nicht mehr nur „Was zeige ich?“, sondern „Welche algorithmisch interpretierte Realität wähle ich aus?“.

Diese Entwicklung führt die Idee der fotografischen Authentizität ad absurdum und offenbart gleichzeitig eine tiefere Wahrheit: Das fotografische Bild war nie eine objektive Abbildung der Realität. Es war immer schon eine Konstruktion, geformt durch die Wahl des Ausschnitts, des Moments und der technischen Parameter. Die Smartphone-Fotografie treibt diese Konstruktion lediglich auf die Spitze, indem sie den Prozess automatisiert und für jeden verfügbar macht.

Shree Nayars Forschung ist derweil schon einen Schritt weiter. Seine neuesten Sensoren können nicht nur die Intensität und Farbe des Lichts messen, sondern auch dessen Polarisation. Damit wird es möglich, Materialeigenschaften zu erkennen, Reflexionen zu eliminieren oder durch bestimmte Oberflächen wie Nebel hindurchzusehen. Die Kamera lernt, nicht nur abzubilden, sondern die physikalische Beschaffenheit der Welt zu interpretieren. Was heute noch im Labor stattfindet, wird morgen die nächste Stufe der Smartphone-Fotografie zünden und unsere Wahrnehmung erneut herausfordern.

Am Ende bleibt die Erkenntnis, dass die größte Revolution nicht in der Technik selbst liegt, sondern in den Fragen, die sie aufwirft. In einer Epoche, in der jeder zum Sender geworden ist, besteht die eigentliche Kunst nicht mehr im Machen, sondern im Sehen und Verstehen. Die Fähigkeit, Bilder kritisch zu lesen, ihre Codes zu entschlüsseln und ihre manipulative Kraft zu durchschauen, wird zur zentralen Kulturtechnik des 21. Jahrhunderts.

Parallel zu den Forschungen an der Columbia University und meines Wissens unabhängig davon entstanden bei Fujifilm die SuperCCD-EXR- und CMOS-EXR-Sensoren, die ebenfalls mit nebeneinander liegenden, für dieselben Farben empfindlichen Sensorpixeln den Dynamikumfang um ein oder zwei EV vergrößerten.

Zur Vorgeschichte dieser Entwicklungen gehören Fujis SuperCCD-SR-Sensoren, eingeführt 2003, die unter jeder Mikrolinse zwei unterschiedlich empfindliche Pixel enthielten. Durch eine Verrechnung von deren Signalen ließ sich der Dynamikumfang um einen festen Wert vergrößern. Wenn nun aber zwei nebeneinander liegende Pixel durch dieselbe Mikrolinse schauen, sehen sie nicht immer dasselbe; nur wenn das jeweilige Detail fokussiert ist, fällt auf beide dasselbe Licht, während sie vor und hinter der Schärfenzone in verschiedene Richtungen schielen. Das konnte in seltenen Fällen zu Doppelkonturen im Unschärfebereich führen, inspirierte aber auch zur Entwicklung eines Phasendetektions-AF mit dem Bildsensor. Fujis Ingenieure zweckentfremdeten das SuperCCD SR in einem Experiment für einen „proof of concept“ eines solchen Autofokus, der dann Jahre später Eingang in die Kameras fand. 2004 wurde aber zunächst das SuperCCD SR II eingeführt, bei dem jedes Pixel seine eigene Mikrolinse hatte.

Fujis SR-Technologie erkaufte die Vergrößerung des Dynamikumfangs mit einer geringeren Auflösung, weshalb man sich zwischen Kameramodellen mit SuperCCD SR (und maximalem Dynamikumfang) und solchen mit SuperCCD HR (mit maximaler Auflösung) entscheiden musste. Erst mit dem SuperCCD EXR (eingeführt 2008) konnte man in einer Kamera beides haben. Das SuperCCD EXR hatte weiterhin je zwei nebeneinander liegende, für dieselbe Farbe empfindliche Pixel, die aufgrund ihres identischen Aufbaus zunächst gleich empfindlich waren. Die Belichtungszeit jeweils eines der beiden Pixel ließ sich aber optional auf die Hälfte oder ein Viertel der Belichtungszeit des anderen verkürzen, indem dieses Pixel erst verzögert auf Null zurückgesetzt wurde. Zum Schluss ließen sich dann zwei um 1 oder 2 EV unterschiedlich belichtete Pixel auslesen und zu einem Bild mit höherem Dynamikumfang verrechnen, aber man konnte die Pixel auch gleich belichten, ihre Signale unabhängig voneinander auswerten und ein hochaufgelöstes Bild berechnen.

2011 war das Ende der CCD-Technologie gekommen und Fuji ersetzte sie durch CMOS-EXR-Sensoren, die abgesehen davon aber dieselbe Methode zur optionalen Vergrößerung des Dynamikumfangs nutzten, indem von zwei Sensorpixeln eines für dieselbe Farbe empfindlichen Paares eines optional kürzer belichtet wurde.

Die Weiterentwicklung der CMOS-Sensoren durch auf den Sensorchip integrierte A/D-Wandler machte solche Verfahren später teilweise überflüssig. Das Ausleserauschen dieser Sensoren, wie sie vor allem Sony herstellte – Canon zog erst viel später nach – war so gering, dass man sie problemlos knapper belichten konnte, um bei kontrastreichen Szenen die Lichterzeichnung zu bewahren. Die zum Ausgleich nötige Anhebung von Schatten und Mitteltönen verstärkte zwar das Rauschen, das aber gut beherrschbar blieb. Fuji, die sich zunehmend auf Systemkameras mit APS-C-Sensoren konzentrierten, gaben die eigene Sensorproduktion auf und beschränkten sich darauf, ihre selbstentwickelten Sensorkonzepte wie das Farbmoirés vermeidende XTrans-Farbfiltermuster von Sony realisieren zu lassen, deren Sensorfertigung ein hinreichend breites Spektrum an Customizing-Optionen bot.

Im Bereich der kleinen Sensoren für Smartphones und Kompaktkameras bewährt sich die Technik unterschiedlich belichteter Sensorpixel aber bis heute. Bei Sensoren mit Quad-Bayer-Farbmuster, bei denen ohnehin jeweils zwei mal zwei für dieselbe Farbe empfindliche Pixel nebeneinander liegen, bietet es sich an, die Hälfte von ihnen optional kürzer zu belichten.