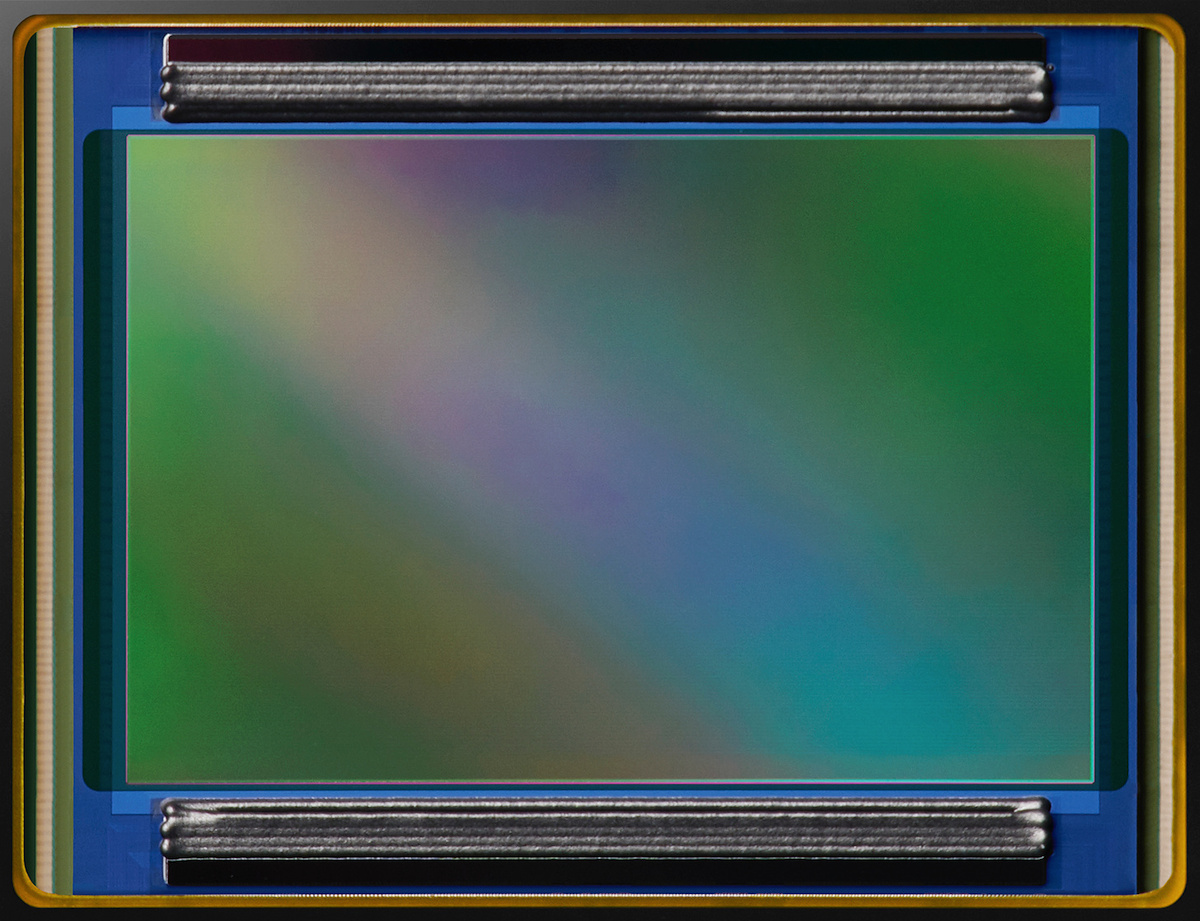

Sensorgeflüster: Kann Sony das Quad-Bayer-Problem mit KI lösen?

Quad-Bayer- und Quad-Quad-Bayer-Sensoren mit fabelhaften Auflösungen von bis zu 200 Megapixeln sind der Stand der Technik in Smartphone-Kameramodulen, haben aber einen Nachteil: Ihre tatsächliche Detailauflösung wird der beeindruckenden Pixelzahl nicht vollauf gerecht. Sonys neuer Lytia 901 verwendet nun einen auf den Chip integrierten KI-Prozessor für das bei solchen Sensoren nötige Remosaicing, um diesen Mangel zu beheben. Aber ist das nicht ein viel zu umständlicher Ansatz?

Schon seit etlichen Jahren sind Megapixelzahlen nichts mehr, mit dem Besitzer einer Systemkamera noch einen Stich beim Kameraquartett bekämen. Smartphones mit ihren relativ kleinen Sensoren – selbst die Größten unter ihnen sind kleiner als ein Micro-Four-Thirds-Sensor – haben schon 200 Megapixel erreicht, während sich selbst Mittelformatkameras mit 100 oder 150 Megapixeln begnügen müssen.

Wie konnte es passieren, dass die kleinen Sensoren ihren größeren Geschwistern hier den Rang abgelaufen haben? Ihre Pixel messen nur noch 0,6 oder 0,7 µm und können daher nicht allzu viel Licht sammeln, was bei weniger als exzellenten Lichtverhältnissen Probleme bereitet. Die Hersteller haben aber einen Ausweg gefunden, und diese Lösung beruht auf einem Farbfiltermuster, das nur auf den ersten Blick wie das vertraute, von Bryce E. Bayer erfundene Bayer-Muster aussieht.

Sony spricht hier von Quad-Bayer oder Quad-Quad-Bayer, während es Samsung Tetra beziehungsweise Tetra2 nennt; gemeint ist jeweils dasselbe. Die roten, grünen und blauen Farbfilter, die beim Bayer-Muster abwechselnd die einzelnen Sensorpixel bedecken, erstrecken sich bei Quad-Bayer/Tetra über 2×2 und bei Quad-Quad-Bayer/Tetra2 über 4×4 Pixel. (Samsung kennt noch eine Nona-Variante mit 3×3 Pixeln.) Damit sind vier beziehungsweise 16 unmittelbar benachbarte Sensorpixel für dieselbe Farbe empfindlich, und so ist ein Binning möglich, das die Empfindlichkeit auf Kosten der Auflösung vergrößert.

Unter dem englischen Begriff Binning versteht man, benachbarte Sensorpixel zu einem größeren Pixel zusammenzufassen. Beim klassischen Hardware Binning werden die in den einzelnen Pixeln gesammelten elektrischen Ladungen zunächst in einen Ladungsspeicher verschoben, der dann ausgelesen wird. Man kippt sozusagen mehrere Ladungen in einen Eimer (englisch „bin“), um ein größeres Pixel zu simulieren, das von sich aus größere Ladungen sammeln kann. Eine Alternative dazu ist das Software Binning, bei dem die Sensorpixel zunächst ausgelesen und digitalisiert werden, woraufhin man die Werte benachbarter Pixel addiert. Bei modernen Sensoren mit niedrigem Ausleserauschen liefert Software Binning kaum schlechtere Ergebnisse als das technisch aufwendigere Hardware Binning.

Bei monochromen Sensoren sind die Binning-Varianten eine gute Option, Auflösung gegen mehr Rauschabstand und einen höheren Dynamikumfang einzutauschen, aber bei Sensoren mit einem Farbfiltermuster wären sie nicht so einfach anwendbar: Benachbarte Pixel sind jeweils für eine andere Farbe empfindlich, und wenn man sie kombinieren würde, gingen die Farbinformationen verloren. Farbfilter im Bayer-Muster, die jeweils eine größere Gruppe von Pixeln abdecken, lösen dieses Problem.

Farbfilter für 2×2 Pixel (Quad-Bayer/Tetra) erlaubten schon vor etlichen Jahren Sensoren mit beispielsweise 40 Megapixeln, deren Auflösung sich auf 10 Megapixel reduzieren ließ, wenn die Lichtverhältnisse das erforderten, und diesen folgten Konstruktionen mit 48/12 und 64/16 Megapixeln. Mit 4×4 Pixel großen Farbfiltern (Quad-Quad-Bayer/Tetra2) sind sogar 200 Megapixel erreichbar, aber wenn man die jeweils 16 gleichfarbigen Pixel zusammenrechnet, bleiben wiederum nur 12,5 Megapixel übrig.

Auf diese Weise kann man also auch bei farbfähigen Sensoren mit Binning arbeiten, aber wie soll man vorgehen, wenn es hell genug ist und man die volle Sensorauflösung nutzen möchte? Um aus den Daten von Pixeln mit Bayer-Muster, die jeweils nur für eine Farbe empfindlich sind, vollständige RGB-Bildpixel zu berechnen, muss man die fehlenden zwei Drittel der Farbinformationen aus Nachbarpixeln interpolieren, die die benötigte Farbe registrieren. Neuerdings werden die konventionellen Algorithmen für dieses sogenannte Demosaicing immer öfter durch KI-basierte Verfahren ersetzt. Dazu trainiert man KI-Modelle mit fein aufgelösten Bildern und deren Mosaikversion, wie sie der Sensor sie sieht. Am Ende rekonstruiert das KI-Demosaicing statt gelegentliche störender Artefakte realistisch wirkende Details, wie sie in Bildern tatsächlich vorkommen.

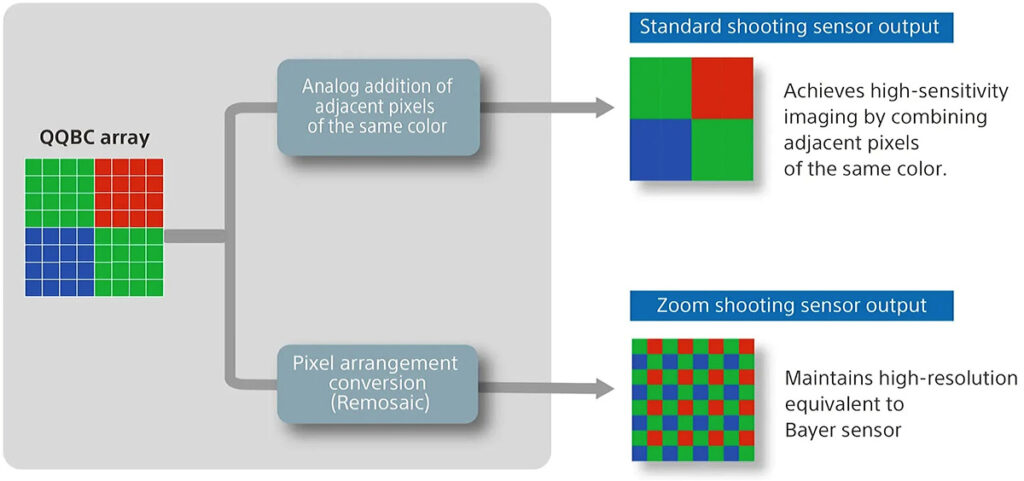

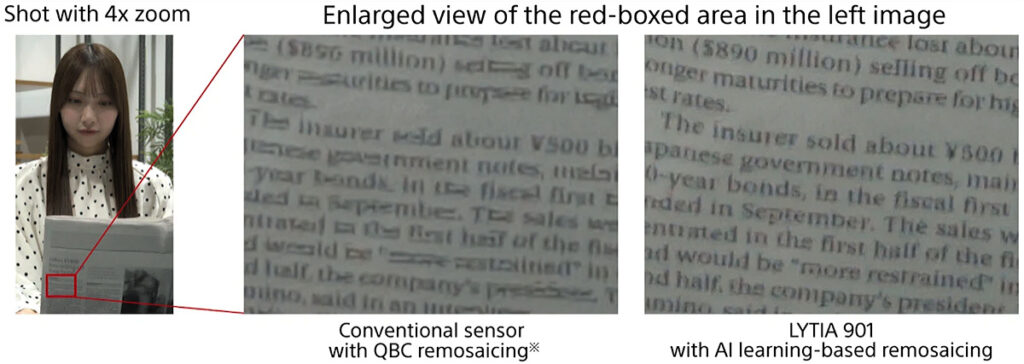

Bei (Quad-)Quad-Bayer-Sensoren gibt es ein Problem: Da vier oder 16 benachbarte Sensorpixel für dieselbe Farbe empfindlich sind, findet man andersfarbige Pixel für die nötige Interpolation der fehlenden Farbinformationen erst in größerer Entfernung. Das würde die erreichbare Auflösung reduzieren, aber zunächst stellt sich noch ein anderes Problem: Geeignete Demosaicing-Verfahren, seien sie konventionell algorithmisch oder auf KI-Modellen basierend, wären erst noch zu entwickeln. Die Sensorhersteller beschritten daher einen Umweg: Mit einem Remosaicing erzeugt der Sensor Pixel im vertrauten Bayer-Muster, mit denen ein Demosaicing auf die übliche Art möglich ist. Sonys Abbildung oben illustriert das Prinzip.

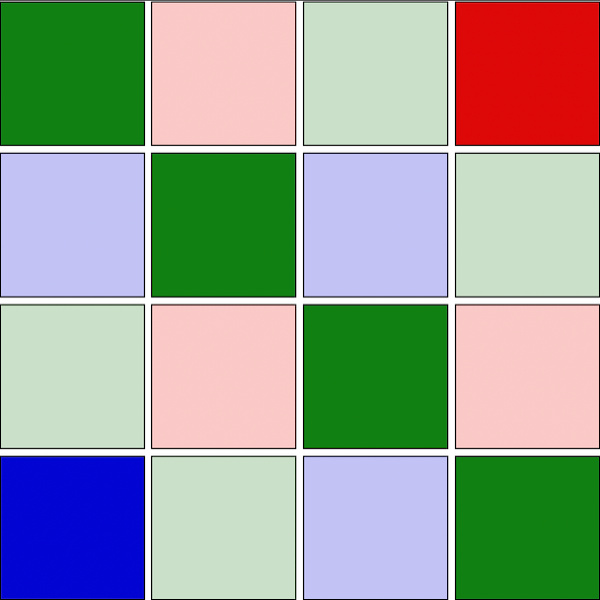

Aber das ist leichter gesagt als getan. Die Abbildung links zeigt, was beim Remosaicing eines Quad-Bayer-Sensors passieren muss: Von 16 Pixeln liefern nur vier grüne und je ein rotes und ein blaues Pixel Informationen über die benötigte Farbe, während die Werte für zehn Pixel interpoliert werden müssen. Dabei werden die aus dem Sensor ausgelesenen Pixelwerte – nachdem sie ihren Dienst zur Interpolation anderer Pixel geleistet haben – durch interpolierte Werte ersetzt und gehen für die weitere Bildverarbeitung verloren. Beim anschließenden Demosaicing könnte man diese Daten gut gebrauchen, aber dazu ist es dann zu spät. Beispielsweise wird ein grünempfindliches Pixel durch interpolierte rote Farbinformationen ersetzt, die das Bayer-Muster an dieser Stelle vorsieht. Das Demosaicing versucht dann Grün und Blau zu rekonstruieren, und die Werte für Grün zumindest lagen ja zunächst vor, müssen nun aber ebenfalls aus Nachbarpixeln interpoliert werden. Statt für jedes Pixel zwei Drittel der Farbinformationen zu interpolieren, genügt das bei Quad-Bayer nur für sechs von 16 Pixeln; die übrigen zehn müssen vollständig interpoliert werden. Bei Quad-Quad-Bayer ist das Verhältnis dasselbe, aber die für andere Farben empfindlichen Pixel, die für eine Interpolation nötig sind, sind noch weiter entfernt.

Im Ergebnis leidet darunter die Auflösung, die nicht den Standard erreicht, den man sich angesichts der Megapixelzahl verspricht. Sonys jüngst vorgestellte Quad-Quad-Bayer Sensor Lytia 901 mit 200 Megapixeln soll diesem Problem künftig abhelfen. Die Idee ist, für das Remosaicing ein KI-basiertes Verfahren einzusetzen, wie es sich ja schon beim Demosaicing bewährt hat. Damit die aufwendigen Berechnungen mit hoher Geschwindigkeit ausgeführt werden können, hat Sony die KI auf den Sensorchip integriert. Smartphone-Hersteller müssen also nicht umdenken; ihre Kameramodule bekommen aus dem Sensor die gewohnten Bilddaten, nur dank der KI in höherer Qualität als gewohnt.

Bis wir Sonys Versprechen in der Praxis auf die Probe stellen können, werden wohl noch ein paar Monate vergehen, aber dann wird der Lytia 901 in höherpreisigen Smartphones Einzug halten. Nach den Erfahrungen mit dem KI-basierten Demosaicing ist tatsächlich mit einem Qualitätssprung zu rechnen; wie groß er ausfällt, bleibt abzuwarten.

Aber ist diese Vorgehensweise nicht unnötig komplex? Durch das Remosaicing mit anschließendem Demosaicing gehen wertvolle Sensordaten verloren; ein KI-Verfahren kann sie immerhin geschickter rekonstruieren – man könnte auch sagen: erraten –, als es die bisher angewandten Algorithmen tun, aber wäre es nicht naheliegender, echte Sensordaten gar nicht erst wegzuwerfen, nur um sie später mühsam und nur annähernd wiederherzustellen? Dazu müsste man auf ein Remosaicing verzichten und stattdessen ein Verfahren für das direkte Demosaicing von Quad-Bayer- und Quad-Quad-Bayer-Sensoren entwickeln.

Prinzipiell wäre das durchaus möglich. Adobe beispielsweise hat zwei verschiedene KI-Modelle für das Demosaicing von Sensoren mit Bayer-Muster einerseits und Fujis X-Trans-Muster andererseits trainiert, um beiden gleichermaßen gerecht zu werden. Genauso könnten sie auch KI-Modelle für Quad-Bayer- und Quad-Quad-Bayer-Sensoren trainieren. Da dabei eine weit größere Zahl von Nachbarpixeln zu berücksichtigen wäre, würde der nötige Rechenaufwand jedoch erheblich anwachsen. Zudem müsste das KI-Modell nicht nur im Raw-Konverter auf einem Desktop-Computer in akzeptabler Zeit zu einem Ergebnis kommen, sondern auch in der Kamera beziehungsweise im Kameramodul eines Smartphones. Vermutlich ist die Hardware auf dem derzeitigen Stand der Technik dem noch nicht gewachsen.

Damit bliebe noch eine zweite Alternative. Die Sensorhersteller könnten auf Farbfilter für je 2×2 oder 4×4 Pixel verzichten und beim einfachen Bayer-Muster bleiben. Binning wäre dann nicht mehr möglich, aber vielleicht auch gar nicht nötig. Stattdessen würde man auch bei schlechten Lichtverhältnissen zunächst ein hochaufgelöstes Bild auslesen und digitalisieren, und es erst nach dem Demosaicing zu einem RGB-Bild auf ein Viertel (2×2) beziehungsweise ein Sechzehntel (4×4) der Auflösung herunterskalieren. Auch auf diese Weise würde man einen größeren Rauschabstand und einen höheren Dynamikumfang erzielen, und wenn der Effekt auch nicht ganz so stark wie beim Binning ausfiele, würde man dafür an effektiver Detailauflösung gewinnen. Bevor sich ein Hersteller auf ein solches Experiment einlässt, gibt es allerdings keine praktische Bestätigung, ob das rund 50 Jahre alte Bayer-Muster nicht auch bei Sensoren mit einer extrem hohen Anzahl extrem kleiner Pixel ein erfolgversprechender Ansatz sein könnte.