„Künstliche Intelligenz“ – ein Buzzword?

Kürzlich hatte ich hier angesprochen, dass das Schlagwort „Künstliche Intelligenz“ gerade im Bereich der Bildbearbeitung oft inflationär gebraucht wird. Neue Features von Anwendungen oder auch der Firmware von Kameras mögen beeindruckende Ergebnisse erzielen (siehe die Beiträge von Olaf Giermann an dieser Stelle), aber mit Intelligenz haben sie wenig zu tun. Damit stellt sich die Frage, was denn nun eigentlich Künstliche Intelligenz ist.

Eine in KI-Kreisen gängige Definition besagt, dass ein Computersystem, das Leistungen vollbringt, die man bei einem Menschen als intelligent bezeichnen würde, ebenfalls als intelligent gelten müsse – eben künstlich intelligent. Diese Definition geht auf Alan Turing (1912–1954) zurück, der als pragmatisches Kriterium ein Imitationsspiel vorschlug, in dem man schriftlich mit einem Menschen und einem Computer kommuniziert und herausfinden müsste, wer der Mensch und wer der Computer ist. Wenn der Computer nicht mehr sicher von einem Menschen zu unterscheiden wäre, hätte er diesen sogenannten Turing-Test bestanden und müsste folglich als intelligent gelten („Computing Machinery and Intelligence“). Der pragmatische Grundgedanke ist noch älter; Denis Diderot schrieb bereits 1746, dass er einen Papagei, der jede an ihn gerichtete Frage beantworten könnte, ohne Zögern als intelligent bezeichnen würde.

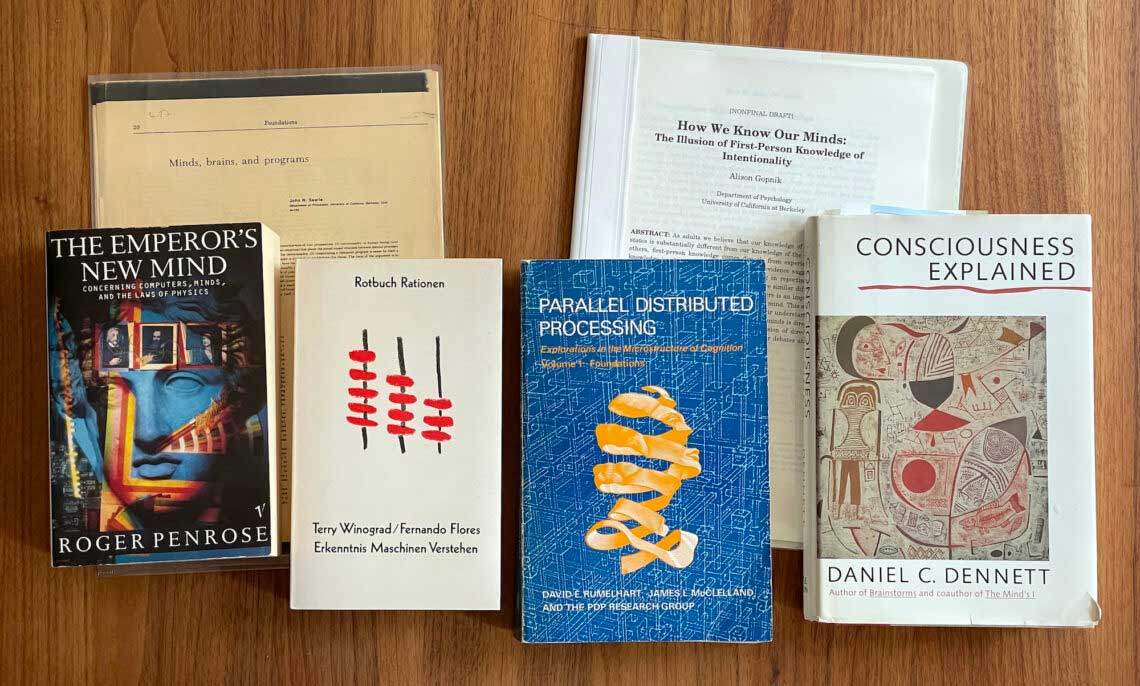

Außerhalb der KI-Szene wurde diese Definition immer wieder kritisiert, so beispielsweise von dem Philosophen John R. Searle und dem Physiker Roger Penrose. Searle unterscheidet zwischen einer schwachen KI-These, nach der KI-Systeme theoretisch alle möglichen, normalerweise als intelligent bezeichneten Leistungen erbringen können, und er ist bereit, diese der KI zuzugestehen. Dagegen argumentiert er gegen die starke KI-These, dass KI-Systeme tatsächlich so etwas wie die menschliche Intelligenz besäßen. Maschinen verfügten nämlich prinzipbedingt nicht über intentionale Zustände, wie sie charakteristisch für das menschliche Denken seien. Intentionale Zustände haben nichts mit Intentionen, also Absichten zu tun. Um mich selbst aus meiner nie fertiggestellten Dissertation zu zitieren: „Im übertragenen Sinn versteht man seit Franz Brentano unter Intentionalität die Eigenschaft geistiger Zustände, einen Gegenstand in der Welt zu haben, sich auf etwas außerhalb der geistigen Sphäre zu beziehen.“ Ein Computer kann einen Output aus Zahlen oder Symbolen produzieren, aber damit, so Searle und andere KI-Kritiker, ist nichts gemeint. Erst wir legen dem Output des Computers eine Bedeutung bei. (Übrigens ist auch dieser Ansatz älter; schon Leibnitz hatte 1714 mit seinem Mühlengleichnis in der Monadologie ähnlich argumentiert.) Nun ist es allerdings ein Problem von Searles Kritik, dass er nicht klar definieren kann, was das menschliche Gehirn Besonderes tut, das dessen Zustände zu intentionalen Zuständen machte. Er spricht stattdessen nur vage von „kausalen Eigenschaften“ des Gehirns, ohne zu sagen, worin diese bestehen. Searle würde auch einem hypothetischen Außerirdischen mit einer völlig anderen Biologie echte Denkprozesse zugestehen, kann dann aber nicht erklären, was dem KI-System Entscheidendes fehlt, das der Mensch und der Außerirdische jedoch besäßen, oder woran man beim Außerirdischen festmachen könnte, dass er es besitzt.

Wenn ich nun aber von Künstlicher Intelligenz als bloßem Buzzword spreche, dann hat das einen anderen Hintergrund. Dass eine Photoshop-Funktion, die ein Vordergrundmotiv erkennt und dessen Hintergrund austauscht, ebensowenig ein Hinweis auf eigenständiges Denken unserer Software liefert, wie ein Demosaicing-Verfahren in Lightroom, das jeweils passende Details ergänzt, ist offensichtlich; darüber lohnt es sich nicht zu streiten. Aber wieso sollte es etwas mit Künstlicher Intelligenz zu tun haben?

KI-Systeme basieren heutzutage fast immer auf neuronalen Netzen. Das war nicht immer so: Ansätze, die sich an biologischen Nervensystemen orientierten, spielten zwar in der Anfangszeit der KI in den 50er und 60er Jahren eine Rolle, aber danach dominierten für einige Jahrzehnte symbolische Ansätze. KI-Systeme arbeiteten mit symbolischen Ausdrücken, die Wissen repräsentieren sollten, und Regeln, die solche symbolischen Ausdrücke verarbeiteten – ganz ähnlich Systemen der formalen Logik, und teilweise wurden auch ausdrücklich logische Formalismen wie der Prädikatenkalkül genutzt, um einen Computer Schlussfolgerungen ziehen zu lassen. Erst Ende der 80er Jahre gewannen künstliche Nervensysteme wieder an Bedeutung, und im Verlauf der 90er Jahre begann sich die manchmal als „Konnektionismus“ benannte Richtung der KI durchzusetzen.

Die Grundelemente eines neuronalen Netzes sind einfache Recheneinheiten als simulierte Neuronen, die man sich allerdings nicht als Nachbildungen echter Nervenzellen vorstellen darf; von diesen sind sie lediglich inspiriert. Die künstlichen Neuronen eines Netzes sind miteinander verbunden, und sie verrechnen ihre Inputs – im Prinzip durch eine einfache Addition – zu einem Output, mit dem wiederum andere künstliche Neuronen verbunden sind. Was ein neuronales Netz leistet, wird durch die Verbindungen zwischen den Zellen bestimmt, die unterschiedlich stark sind und sowohl additiv wie subtraktiv wirken können. Eine Matrix mit den Stärken aller Verbindungen ist daher bereits eine vollständige Beschreibung des Netzes. Die Zellen unseres Nervensystems sind sehr viel komplexer; sie erzeugen Folgen von Impulsen, wobei nicht nur deren Frequenz bedeutsam ist, wie man früher glaubte, sondern auch deren Timing – Details, die in neuronalen Netzen nicht abgebildet sind.

Die grobe Vereinfachung der künstlichen Neuronen ist durchaus erwünscht, denn sie macht es auch einfacher, die optimalen Verbindungen im Netz mit Verfahren des maschinellen Lernens herauszufinden. Klassische algorithmische Ansätze in der Informatik basieren darauf, Rechenverfahren auszutüfteln, die aus einem Input den gewünschten Output berechnen. Neuronale Netze werden dagegen nicht von Softwareentwicklern entworfen, obwohl das theoretisch möglich wäre; vielmehr sammelt man zunächst eine Fülle – Hunderttausende oder Millionen – von Beispielen typischer Inputs und der jeweils gewünschten Outputs, mit denen das Netz dann ohne weitere Überwachung automatisch trainiert wird. Da es zunächst keine an die Problemstellung angepasste Verschaltung der Zellen gibt, werden die Outputs erst einmal weit vom Soll abweichen, und aus den Abweichungen werden Korrekturwerte berechnet und durch das Netz propagiert, um sie in den folgenden Schritten zu reduzieren. Wenn man bei der Vorplanung der Netzarchitektur und der Auswahl der Trainingsdaten alles richtig gemacht hat, schrumpfen die Abweichungen nach unzähligen Lernschritten auf nahe Null, und zwar nicht nur für die im Training verwendeten Input-Output-Paare, sondern auch für solche, die das Netz noch nie zuvor gesehen hatte. Das bedeutet dann, dass es eine Generalisierungsleistung erbracht, also irgendwie erlernt hat, beliebige Eingaben im gewünschten Sinne zu verarbeiten, statt lediglich vorgegebene Antworten auf vorgegebene Fragen auswendig zu lernen.

„Irgendwie“ ist dabei wörtlich zu nehmen, denn wie das Netz verallgemeinert hat, weiß man nicht, und es herauszufinden ist noch einmal eine Herausforderung für sich. Manchmal geht die gefundene Generalisierung in die Irre, wie beispielsweise bei einem neuronalen Netz, das Züge auf Fotos erkennen sollte, aber stattdessen Bahnhöfe erkannte, weil alle im Training verwendeten Bilder Züge zeigten, die an einem Bahnhof hielten. In China war man auf die schräge Idee verfallen, Verbrecher an ihrer Physiognomie zu erkennen, was zunächst auch zu gelingen schien – aber das anhand von Porträts von Gefängnisinsassen einerseits und gesetzestreuen Bürgern andererseits trainierte Netz erkannte die Verbrecher lediglich an ihrer Sträflingskleidung, bestätigte also bloß die Urteile der Gerichte, die sie verurteilt hatten.

Der wesentliche Unterschied zwischen neuronalen Netzen und anderen Berechnungsverfahren besteht gar nicht in den Netzen selbst, die ja bloße Implementationen eines recht simplen mathematischen Kalküls sind, sondern in ihrer Entwicklung durch Verfahren maschinellen Lernens, mit denen man sich schrittweise durch Versuch und Irrtum an die gesuchte Lösung herantastet. Einen solchen Ansatz kann man für alle möglichen Problemstellungen nutzen, und die müssen nichts mit Künstlicher Intelligenz zu tun haben – wie etwa im Bereich der Bildbearbeitung. Wenn Softwarehersteller im Zusammenhang mit ihren Produkten von KI sprechen, dann ist damit meist nur gemeint, dass sie für ihre Berechnungen neuronale Netze nutzen, deren Verbindungen in einem maschinellen Lernverfahren optimiert wurden. Obwohl KI-Systeme durchweg ebenso arbeiten, kann man nicht umgekehrt schließen, dass neuronale Netze und maschinelles Lernen automatisch Künstliche Intelligenz ergeben würden.

In meiner Kindheit wurden Computer generell noch als „Elektronengehirne“ bezeichnet, aber das bedeutete nicht, dass sich eine Buchhaltungssoftware damals eigene Gedanken gemacht hätte. In der gleichen Zeit wurden Blitzgeräte, deren Leistungsabgabe von den Messwerten einer Fotozelle gesteuert wurden, auch noch als „Computerblitze“ bezeichnet, und so wie die „Elektronengehirne“ und „Computerblitze“ mittlerweile aus dem Sprachgebrauch verschwunden sind, wird man in Zukunft hoffentlich sparsamer mit dem Etikett „KI“ umgehen.

Welchen Status man einer richtigen Künstlichen Intelligenz dann zubilligen mag, bleibt eine Frage für sich.

Lieber Herr Hußmann,

vielen Dank für diesen ausführlichen kritischen Bericht über KI.

In den 90-ger Jahren trieb ich philosophische Studien in Frankfurt. In einem Seminar bei den Philosphen über Konnektionismus hielt ich ein Referat zusammen mit einem weiteren Studenten über neuronale Netzwerke und ihrer Möglichkeiten Erkenntnisse zu gewinnen. Es ging natürlich auch um den berühmten Turing-Test.

Damals war ja der Begriff „neuronale Netzwerke“ gefühlt jeden Tag irgendwo in der Öffentlichkeit zu hören. Nun gut, was hat das mit KI heute zu tun?

Es erscheint mir wie damals nur unter den Vorzeichen, die Sie in Ihrem Bericht skizziert haben und dem riesigen Schild KI. Unser damaliges Fazit kann ich kurz angeben und das gilt auch für die heutige KI. Salopp gesagt: KI gewinnt keine Erkenntnisse, die Ergebnisse eines KI-Prozesses suggerieren das. Wir, die Menschen sind in der Lage aus den komplexen Ergebnissen der schieren Rechenleistung Schlüsse zu ziehen, doch die Programme können das nicht. Es hat sich mal wieder eine riesige PR-Maschinerie in Gang gesetzt um die Tücken und Gemeinheiten dieser KI zu kaschieren.

Grüße von

fottopit

Dankeschön für einen Artikel, der wesentlich mehr Tiefe ins Thema bekommt als in der Fastfoodpresse üblich ist.

Immerhin würden auch manche Menschen durch den Turing Test fallen, da sie nicht viel mehr tun als gelernte Satzbausteine nachzuplappern. Zum Verkauf von Firmenanteilen ist es wichtig, viel Wind zu machen – Bullshit-Bingo-Buzzwords sind ein Marketinginstrument für Leute, die Kompetenz vortäuschen, daher ist nicht überal K.I. (Blockchain, Cloud, etc.etc.) drin wo es draufsteht.

Das meiste was wir als K.I. angepriesen bekommen ist Zahlenvergleich per Statistik, neuronale Netze ein Feedbackprinzip wie Gegenkopplung in einem Schaltkreis. Das was diese Methode nicht hinbiegen kann sind Lücken und Fehler im theoretischen Modell, sind die auch in der Messmethodik vorhanden wird es halt erstmal nicht auffallen.

Künstliche Intelligenz war noch nie intelligent. Das Meiste ist nur Musterverarbeitung. Von Intelligenz, egal in welcher Definition, kann bis heute keine Rede sein.

Na ja, „Musterverarbeitung“ ist ein weites Feld. Als jemand, der selbst in diesem Bereich aktiv war, würde ich das, womit ich mich damals beschäftigt habe, allerdings nicht als Musterverarbeitung bezeichnen, da der Begriff eher in die Irre führt.