Wer präzise Bildgestaltung mit KI-Bildgeneratoren umsetzen möchte, kennt das Problem: Die Integration spezifischer Objekte oder Personen in verschiedene Szenarien war bislang eine Herausforderung. Mit dem neuen Omni-Reference-Feature von Midjourney 7 könnte sich das grundlegend ändern. Die Funktion verspricht, die Art und Weise zu transformieren, wie wir mit KI-generierten Bildern arbeiten.

Was Omni-Reference wirklich kann

Midjourney etabliert sich immer stärker als wichtiges generatives KI-Werkzeug für Fotografen und Bildbearbeiter. Das neue Omni-Reference-Feature bildet dabei einen zentralen Bestandteil des V7-Updates. Die Funktion ermöglicht es, bestimmte Personen oder Objekte überzeugend in verschiedene Bildkompositionen zu integrieren. Während bisherige Ansätze oft zu inkonsistenten Ergebnissen führten, zielt Omni-Reference darauf ab, bereitgestellte Bildelemente wie Logos, reale Personen, digitale Charaktere oder Objekte deutlich naturgetreuer in neue Bildkompositionen zu übertragen.

Dies stellt für professionelle Anwender einen bedeutenden Fortschritt dar. Bisher war es ein mühsamer Prozess, konsistente Darstellungen desselben Objekts über mehrere Bilder hinweg zu erreichen – oft mit frustrierenden Ergebnissen. Die Fähigkeit, ein Referenzbild als visuelle Konstante zu verwenden, eröffnet völlig neue Möglichkeiten für die narrative Bildgestaltung und kommerzielle Anwendungen.

Teil einer beeindruckenden Update-Serie

Omni-Reference ist nicht isoliert zu betrachten, sondern Teil einer beeindruckenden Serie von Updates, die Midjourney seit der Vorstellung von Version 7 veröffentlicht hat. Erst kürzlich wurde der Parameter „–exp“ eingeführt, der experimentelle Funktionen freischaltet. Mit dieser Entwicklungsdynamik zeigt das Unternehmen, wie ernsthaft es an der kontinuierlichen Verbesserung seiner Plattform arbeitet.

Omni-Reference reiht sich in ein wachsendes Arsenal von Referenzwerkzeugen ein. Neben dem bereits bekannten Style-Reference-Feature (–sref), das den Look und das Feeling eines Bildes übertragen kann, und den Character-References (–cref und –cw) für konsistente Charakterdarstellungen, bietet Omni-Reference nun die Möglichkeit, spezifische Objekte zuverlässig zu implementieren.

Diese Entwicklung ist Teil einer größeren Evolution bei Midjourney. Das V7-Update bringt angeblich in Zukunft neben dem Omni-Reference-Feature auch Video- und 3D-Funktionen. Damit reagiert das Unternehmen auf die wachsenden Anforderungen von professionellen Kreativen, die über statische Einzelbilder hinausdenken müssen.

Das Referenz-Ökosystem von Midjourney verstehen

Um die Bedeutung von Omni-Reference vollständig zu erfassen, lohnt ein Blick auf das gesamte Referenz-Ökosystem von Midjourney. Schon länger konnten Nutzer eigene Bilder als Vorlage verwenden und damit entweder ähnliche Bilder generieren oder auf Basis dieses Bildes völlig neue Motive erschaffen.

Die Character Reference-Funktion (–cref) ermöglicht es bereits, eine Person aus einem Vorlagenbild in verschiedene Szenarien zu übertragen. Dies war ein wichtiger Schritt in Richtung konsistenter Charakterdarstellung. Style Reference (–sref) hingegen konzentriert sich auf die Übertragung des visuellen Stils einer Vorlage. Fotos haben als Vorlagen bisher eher schlecht als recht funktioniert.

Praktische Anwendungsmöglichkeiten für Fotografen und Designer

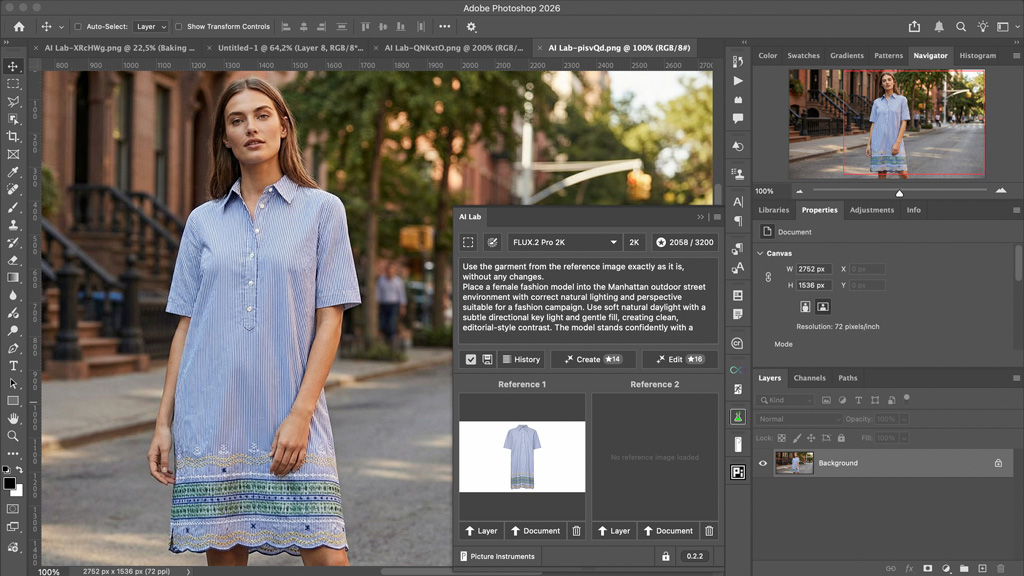

Für Fotografen und Bildbearbeiter ergeben sich durch diese Technologie faszinierende neue Arbeitsmethoden. Die präzise Kontrolle über visuelle Elemente erlaubt es, Produkte in verschiedenen Umgebungen zu visualisieren, ohne aufwendige Fotoshootings durchführen zu müssen. Ein Werbeprodukt kann so beispielsweise in unterschiedlichsten Szenarien dargestellt werden, wobei die Produktdarstellung selbst konsistent bleibt. Das selbe gilt für Porträtaufnehmen. Auch für konzeptionelle Arbeiten bietet sich enormes Potenzial. Die Möglichkeit, dasselbe Objekt oder dieselbe Person in verschiedenen Szenen erscheinen zu lassen, erleichtert das Erzählen visueller Geschichten erheblich. Was früher aufwendige Composings erforderte, könnte nun mit wenigen Prompts und einem guten Referenzbild umgesetzt werden.

Technische Hintergründe und Limitierungen

Wie bei allen KI-Bildgenerierungstechnologien gibt es natürlich auch bei Omni-Reference Einschränkungen. Die Technologie befindet sich noch in einer experimentellen Phase und wird sicherlich nicht in allen Szenarien perfekt funktionieren. Besonders komplexe Objekte mit vielen Details oder spezifischen Materialien könnten weiterhin Herausforderungen darstellen.

Zukunftsaussichten und Wettbewerbsvergleich

Mit der Einführung von Omni-Reference verteidigt Midjourney 7 seinen Platz an der Spitze der KI-Bildgenerierungstools. Während andere Plattformen ähnliche Funktionen anbieten, scheint Midjourney besonders auf die nahtlose Integration und Benutzerfreundlichkeit zu setzen.

Für professionelle Anwender bedeutet dies eine zunehmend ausgereifte Toolbox, die immer mehr klassische Bildbearbeitungsarbeitsschritte automatisieren oder zumindest deutlich vereinfachen kann. Die Grenzen zwischen traditioneller Bildbearbeitung und KI-generierter Bildschöpfung verschwimmen dadurch weiter.

Fotografen und Designer tun gut daran, diese Entwicklung aufmerksam zu verfolgen und in ihre Arbeitsabläufe zu integrieren. Es geht dabei nicht darum, bestehende Fähigkeiten zu ersetzen, sondern das kreative Arsenal zu erweitern und repetitive Aufgaben zu automatisieren, um mehr Zeit für die wirklich anspruchsvollen kreativen Entscheidungen zu haben.

Könnt ihr in der nächsten DOCMA Ausgabe ausführlich darauf eingehen mit Praxisbeispielen, wie man es in einer Werbeagentur einsetzen könnte?