NVIDIA und Black Forest Labs: FLUX.1 Kontext [dev] vereinfacht Bildbearbeitung mit KI und RTX

Black Forest Labs hat erst im Mai die FLUX.1 Kontext-Familie von Bildmodellen vorgestellt, die sowohl die Bildgenerierung durch Textanweisungen als auch die Modifikation vorhandener Bilder beherrschen. Sie akzeptieren also sowohl Text- als auch Bildprompts. Gemeinsam mit NVIDIA wurde inzwischen eines dieser Modelle, FLUX.1 Kontext [dev], für NVIDIA RTX GPUs optimiert. Die Integration von TensorRT – einer Softwarebibliothek zur Beschleunigung von KI-Anwendungen – sorgt dafür, dass die Bildbearbeitung auf RTX-Systemen bis zu doppelt so schnell abläuft wie bisher. Gleichzeitig wird weniger VRAM (Video Random Access Memory) der Grafikkarte beansprucht. Dadurch lassen sich auch auf leistungsfähigen, aber bezahlbaren Workstations komplexe Bildänderungen in Echtzeit durchführen.

Intuitive Bedienung, schnelle Ergebnisse

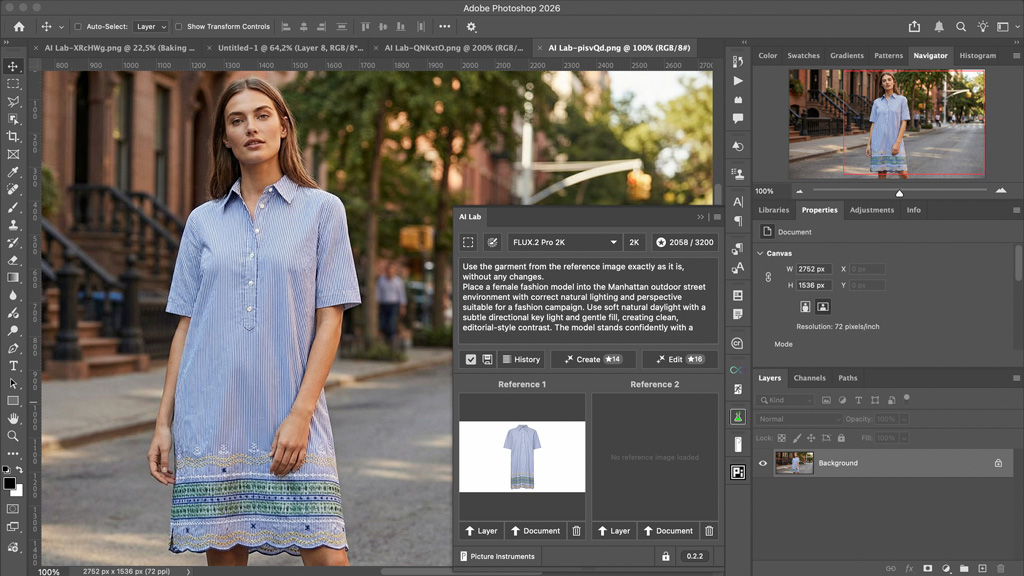

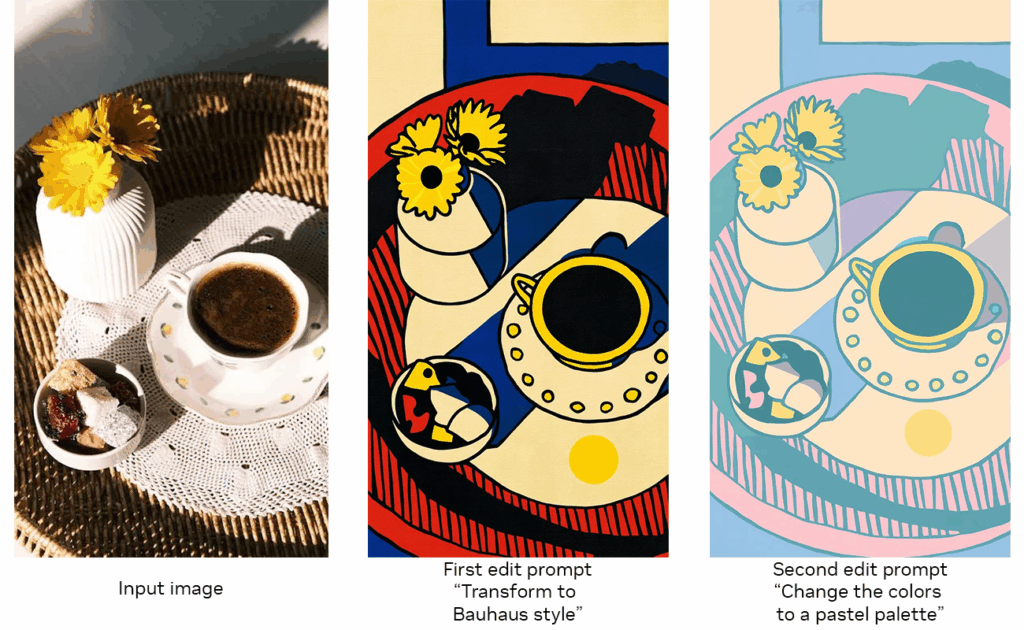

FLUX.1 Kontext [dev] soll den kreativen Prozess vereinfachen. Die Bedienung erinnert an einen digitalen Skizzenblock, der auf Sprache hört. Wer beispielsweise ein Porträt aufhellen, den Hintergrund austauschen oder den Stil eines Referenzbilds auf eine neue Szene übertragen möchte, beschreibt das gewünschte Ergebnis einfach in Alltagssprache. Das Modell setzt die Vorgaben um, ohne dass eine Feinabstimmung oder tiefgehende Vorkenntnisse nötig sind. Einzelne Bildelemente lassen sich gezielt anpassen, ohne das gesamte Bild zu verändern – etwa indem ein Hut aufgesetzt oder die Farbe eines Pullovers geändert wird.

Zugänglichkeit und Integration

Das Modell steht auf der Plattform Hugging Face in zwei Varianten bereit: als Torch-Version für klassische KI-Workflows und als TensorRT-optimierte Version für maximale Geschwindigkeit auf RTX-Grafikkarten. Wer FLUX.1 Kontext [dev] ausprobieren möchte, kann das Modell direkt in ComfyUI – einer beliebten Open-Source-Oberfläche für KI-Bildbearbeitung – verwenden. Black Forest Labs bietet außerdem einen Online-Spielplatz an, auf dem sich das Modell ohne Installation testen lässt. Für Entwickler ist eine Microservice-Version (NIM) angekündigt, die ab August verfügbar sein soll. NVIDIA arbeitet zudem an Beispielcode, um die Integration in bestehende Arbeitsabläufe zu erleichtern.

Weitere Entwicklungen: Unterstützung für Google Gemma 3n

NVIDIA kündigt außerdem die Unterstützung für das multimodale KI-Modell Gemma 3n von Google auf RTX- und Jetson-Systemen an. Im Rahmen des Project G-Assist Plug-In Hackathons können Entwickler bis zum 16. Juli Plug-ins für dieses System entwickeln. Ein begleitendes Webinar findet am 9. Juli von 19:00 bis 20:00 Uhr MESZ statt. Dort werden die Grundlagen von Project G-Assist vorgestellt und Fragen beantwortet.

Mehr dazu lesen Sie im NVIDIA-Blog.