Räume transformieren

Nein, hier geht es nicht um Einsatz in 4 Wänden, die Docutainment-Reihe, in der die Moderatorin Tine Wittler die Wohnungen wildfremder Menschen umgestaltete. Nicht von Wohnräumen ist die Rede, sondern von mehrdimensionalen Räumen im mathematischen Sinn. In solchen Räumen befinden sich die Bilder in einem Bildbearbeitungsprogramm.

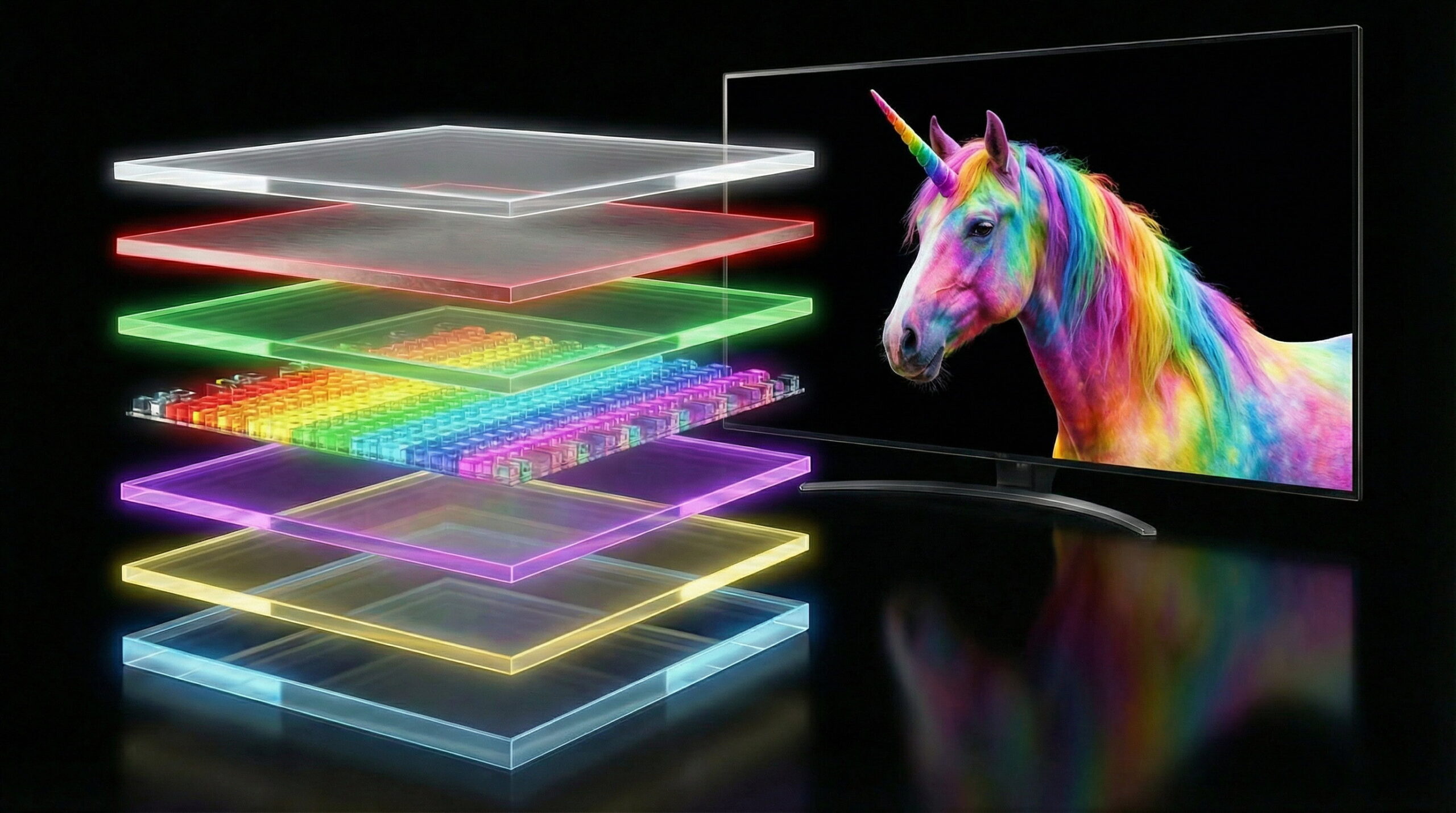

Klingt kompliziert? Dabei ist es gar nicht so schwierig. Digitalkameras produzieren Bilder aus Zeilen und Spalten von Pixeln, wobei jedes Pixel ein RGB-Wert ist, also die Helligkeiten der drei additiven Grundfarben Rot, Grün und Blau angibt. Mathematisch gesehen haben wir es mit einem dreidimensionalen Koordinatensystem zu tun, mit einer Dimension für die x-Koordinate, einer zweiten für die y-Koordinate und einer dritten für die Farbkanäle. Dabei müssen die Farbkanäle nicht zwingend für Rot, Grün und Blau stehen; wir können das Bild auch in die subtraktiven Grundfarben des Vierfarbdrucks, also Cyan, Magenta, Gelb und Schwarz umrechnen. Oder wir beschreiben die Farbwerte durch den Farbton, die Sättigung und die Luminanz. (Wenn wir ein solches Bild in einer Anwendung wie Photoshop bearbeiten, können wir Masken verwenden, die aber nur ein weiterer Kanal sind; es bleibt bei drei Dimensionen. Erst mit der Einführung von Ebenen kommt eine vierte Dimension hinzu, die die Nummer der Ebene angibt.)

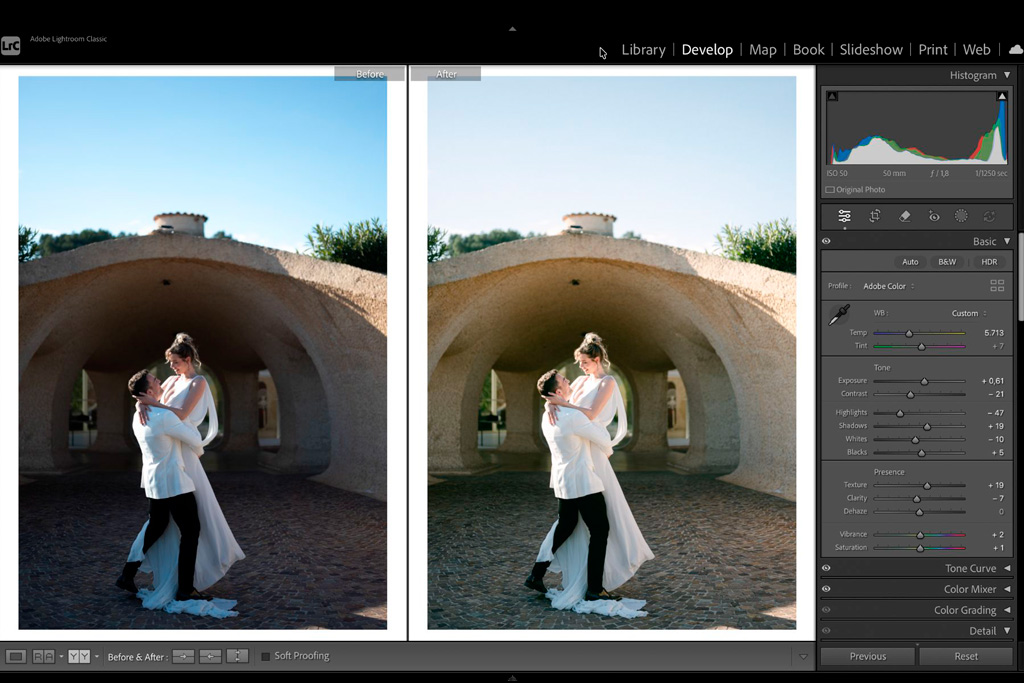

Manchmal ist es für die Bildbearbeitung nützlich, ein Bild von einem Raum in einen anderen zu transformieren. Wenn wir ein Bild beispielsweise vom RGB in L*a*b umwandeln, können wir mit einer Gradationskurve die Tonwerte im L-Kanal anpassen, ohne dass sich dabei ungewollt die Farbsättigung ändert – was unweigerlich passieren würde, wenn wir die Gradationskurve auf die drei RGB-Farbkanäle anwenden. In Lightroom basieren die Farbeinstellungen überwiegend auf dem HSL-Farbmodell, weil sich die üblicherweise gewünschten Anpassungen am einfachsten auf der Basis des Farbtons, der Sättigung und der Helligkeit ausdrücken lassen – im RGB-Modell wäre das kniffliger. Auch für die Beschreibung der Position der Bildpixel gibt es Alternativen: Eine Umwandlung kartesischer Koordinaten in Polarkoordinaten ist zum Beispiel nützlich, um Bilder von 360°-Panoramakameras zu bearbeiten, die sphärische Panoramen aufnehmen.

Solche Umwandlungen sind seit langem bekannt und vertraut. Die neueren KI-Verfahren arbeiten nun allerdings mit Räumen, die nicht nur eine Handvoll, sondern Tausende, Millionen oder Milliarden Dimensionen haben. Vor zwanzig Jahren sagte ich mal im Scherz, die Unterdrückung des Rauschens in Bildern von Digitalkameras sei eigentlich ganz einfach: Man müsse die zu entrauschenden Bilder nur in einen vieldimensionalen Raum transformieren, in dem alles Rauschen in einem zusammenhängenden Bereich dieses Raums läge. Wenn man dann alle Werte in diesem Bereich auf Null setzte und das Bild wieder in den RGB-Raum zurückverwandelte, erhielte man ein rauschfreies Ergebnis. Ein Scherz war das aber nur insofern, als ich behauptet hatte, dass eine solche Transformation einfach sei. Tatsächlich lassen sich die aktuellen KI-basierten Rauschunterdrückungsverfahren so interpretieren, dass sie genau das tun – denn heute, anders als vor 20 Jahren, ist es technisch möglich.

Mit Räumen im mathematischen Sinn haben wir es auch bei KI-Verfahren zur Motiverkennung und zur Bildgenerierung zu tun. Diese Räume enthalten aber nicht nur ein Bild – wobei die einzelnen Punkte im Koordinatensystem Pixel oder andere kleinste Bildbestandteile sind –, sondern unzählige Bilder. Jeder Punkt im Raum steht dann für ein Bild oder Bildmotiv.

Wozu ist das gut? Wenn wir beispielsweise mehrere Fotos einer Katze vergleichen, die sie von vorne, von hinten und von der Seite zeigen, mit unterschiedlichen Körperhaltungen und aus verschiedenen Entfernungen, dann sind sich die RGB-Bilder nicht besonders ähnlich. Die Pixel für Pixel berechnete Differenz kann auch mal größer als die zwischen dem Bild der Katze und dem eines Hundes ähnlicher Fellfarbe sein. Rechnet man die Bilder dagegen aus ihren RGB-Räumen in einen vieldimensionalen Raum um, in dem jeweils ähnliche Bilder und Motive benachbart sind, sich also im Raum um so näher sind, je mehr sie sich ähneln, dann sind Vergleiche trivial. Alle Bilder derselben Katze finden sich in einem eng begrenzten Gebiet, umgeben von einer Zone mit Bildern anderer Katzen, während die Hundebilder in einer anderen, weiter entfernten Zone liegen.

Um nun die Ähnlichkeit zweier Bilder zu bestimmen, ermittelt man ihre Koordinaten im vieldimensionalen Raum und und berechnet die Distanz dieser Punkte. Falls eine der Dimensionen beispielsweise für das Alter steht, braucht man nur deren Wert zu ändern, um Bilder derselben oder einer sehr ähnlichen Katze zu finden, die jünger beziehungsweise älter ist. Analog funktioniert das mit vielen anderen Eigenschaften/Dimensionen.

Weitere Möglichkeiten ergeben sich, wenn man neben dem Raum der Bilder einen Raum von Bildbeschreibungen erzeugt – und zwar so, dass einer Bildbeschreibung dieselben Koordinaten zugeordnet werden wie dem so beschriebenen Bild. Damit kann man zu einer Textbeschreibung passende Bilder an denselben Koordinaten finden, und umgekehrt zu einem Bild die dazugehörige Beschreibung. Genau so funktionieren generative KI-Systeme der Text-zu-Bild-Variante – beziehungsweise deren umgekehrten Anwendung, vom Bild zum Text.

Hinter den Leistungen einer KI steht also deren Fähigkeit, die Räume, in denen Informationen gespeichert sind, in andere Räume zu transformieren, in denen sich die zu bewältigenden Aufgaben auf triviale Weise lösen lassen. Tine Wittler konnte das nicht.

„Um nun die Ähnlichkeit zweier Bilder zu bestimmen, ermittelt man ihre Koordinaten im vieldimensionalen Raum und berechnet die Distanz dieser Punkte.“

Ist die Ähnlichkeit dann nicht schon dadurch bestimmt, dass die Koordinaten der Bilder „nahe“ beieinander liegen, also die Ähnlichkeit schon vor ihrer Bestimmung fest steht? Interessanter als die Untersuchung ist doch die Kreation solch eines Raums.

Muss dann nicht bei jeder neuen Frage nach einer „Ähnlichkeit in Bezug auf“ so ein Raum neu sortiert werden um dann Nähen zu berechnen?

Dass die Koordinaten nahe beieinander liegen, ist ja das, was man mit der Berechnung der Distanz ermittelt.

Der Raum muss dabei nur einmal erzeugt werden, oder jedenfalls nicht für jede neue Frage. Und ja, wie man den Raum erzeugt, ist die eigentlich spannende Frage, aber das geschieht mit Hilfe maschinellen Lernens und ist im Detail nicht so einfach zu durchschauen. Wir können solche Verfahren nur deshalb nutzen, weil es mittlerweile hinreichend leistungsfähige Computersysteme gibt, wie man sie für das maschinelle Lernen auf der Basis riesiger Bilddatenbestände braucht, und selbst diese Computersysteme sind noch längere Zeit damit beschäftigt. Aber das passiert beim Hersteller; wenn das Ergebnis vorliegt, können wir es mit vergleichsweise geringen Anforderungen an die Rechenleistung auf unserem Computer anwenden.

OK, das reduziert natürlich die praktische Anwendung, wenn das komplexe „Sortierkriterium“ vorgegeben ist.

Suche ich Bilder mit z.B. ähnlichem Histogramm, braucht es kein maschinelles Lernen.

Bis zum „prompten“ von Auto-Capture-Bedingungen für Kameras, die über die einer Z9 hinaus gehen, ist es also noch ein langer Weg…