Die Büchse der Pandora ist jetzt noch weiter geöffnet, und sie hat einen besonders albernen Namen: Nano Banana. Was vor wenigen Wochen noch als Experiment von Google DeepMind galt, wird nun bald für jedermann zur Realität. Die Neuigkeit liegt jedoch nicht in der Veröffentlichung eines weiteren KI-Bildgenerators. Die Disruption geschieht dort, wo sie niemand erwartet hätte: direkt im Suchschlitz von Google. Die Bildbearbeitung, einst eine Domäne hochspezialisierter Experten und professioneller Software, wird bald zu einer allgegenwärtigen Funktion des Internets selbst.

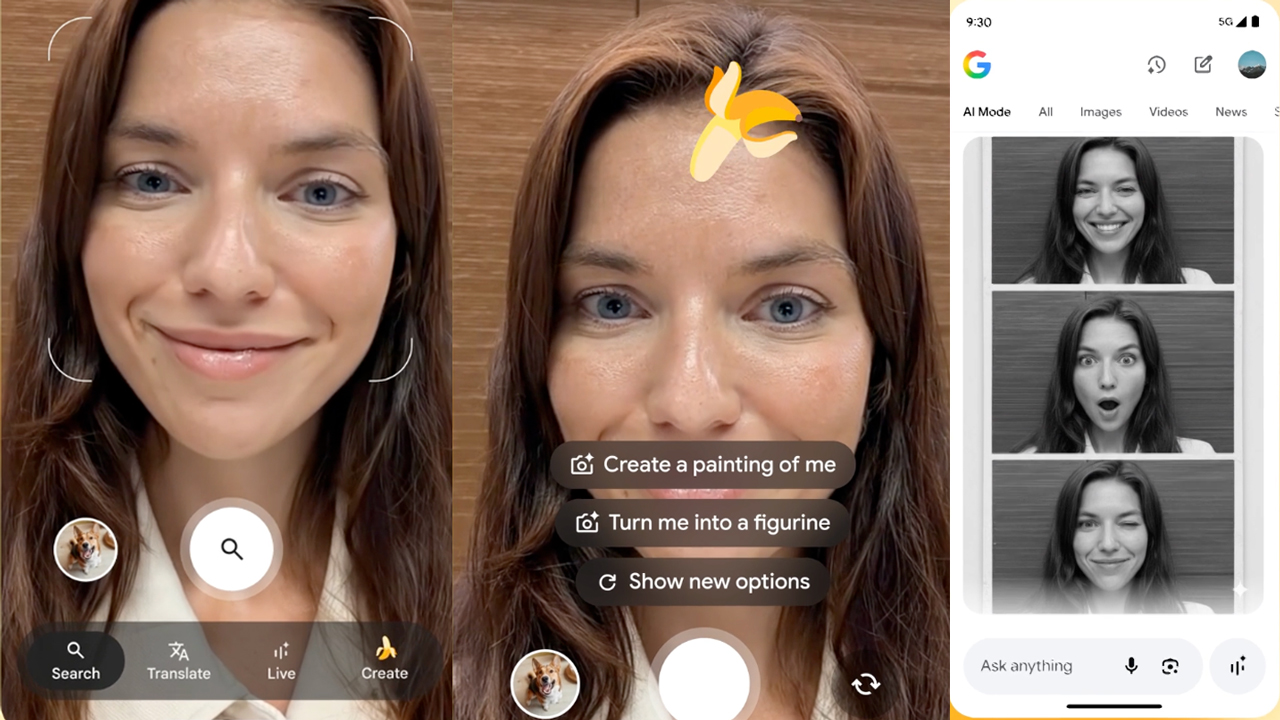

Während Adobe seine Firefly-Modelle mühsam in die Creative Cloud integriert, wählt Google einen radikal anderen, weitaus aggressiveren Weg: Nano Banana wird nicht als eigenständiges Werkzeug ausgerollt, sondern als integraler Bestandteil von Google Search, zugänglich über Google Lens und den neuen AI Mode. Die Funktion wird zunächst in den USA und Indien auf Englisch freigeschaltet, weitere Länder und Sprachen sollen bald folgen. Damit ist klar: Dies ist kein Nischenprodukt für Kreative, sondern ein Massenwerkzeug, das die Art und Weise, wie Milliarden von Menschen mit visuellen Inhalten umgehen, für immer verändern wird.

Die Allgegenwart der Manipulation

Der klassische Arbeitsablauf eines Bildmachers – Aufnahme, Auswahl, Bearbeitung, Layout – wird damit frontal angegriffen. Die neue Realität sieht so aus: Man zückt sein Smartphone, visiert über die Kamera ein Objekt an – oder wählt ein bestehendes Bild aus der eigenen Galerie – und beginnt direkt in der Suchoberfläche einen Dialog mit der KI. „Ändere die Farbe dieses Mantels in Königsblau“, „Platziere diesen Hund in einer futuristischen Stadtlandschaft“ oder „Entferne die Touristen im Hintergrund“. Was früher viel Zeit in Photoshop gekostet hätte, wird zu einer Sache von Sekunden und einer einfachen Texteingabe.

Die Stärke von Nano Banana liegt weniger in der Generierung völlig neuer Bilder aus dem Nichts – obwohl das auch möglich ist – als vielmehr in der präzisen und kontextsensitiven Bearbeitung bestehender Bilddaten. Das System, das auf dem neuen Modell Gemini 2.5 Flash Image basiert versteht die semantischen Zusammenhänge innerhalb eines Bildes Es weiß, was ein Vordergrund ist, erkennt Objekte und deren Grenzen und kann gezielt einzelne Elemente verändern, ohne den Rest der Szene zu beeinträchtigen. Die pixelperfekte Bearbeitung, einst das Aushängeschild professioneller Retusche, wird zur automatisierten Funktion.

Googles Strategie der Integration geht aber noch weiter. Die Technologie soll nicht nur in der Suche, sondern auch in Google Photos und sogar in der Recherche-Anwendung NotebookLM verfügbar sein. Damit sammeln Sie in NotebookLM Material für ein Projekt und können direkt im Dokument Stimmungsbilder,konzeptionelle Visualisierungen oder Infografiken per Texteingabe anfertigen. In Google Photos wird die Bildverwaltung zur Bildtransformation. Die Grenzen zwischen Archiv, Werkzeug und Endprodukt lösen sich weiter auf.

Vom Befehl zur Konversation

Die Interaktion mit der KI entwickelt sich dabei vom reinen Befehl zur Konversation. Das Prompting wird dialogorientiert. Google selbst gibt ein bezeichnendes Beispiel: Man lässt die KI einen neuen Mantel für eine Person im Bild entwerfen. Ist man mit dem Ergebnis zufrieden, kann man im selben Dialogfenster direkt fragen, wo man ähnliche Mäntel kaufen kann. Hier zeigt sich das wahre Gesicht der Strategie: Nano Banana ist nicht nur ein Kreativwerkzeug, sondern auch eine nahtlose Brücke zum E-Commerce. Jedes Bild wird zur potenziellen Einkaufsliste, jede visuelle Idee zum direkten Konsumimpuls.

Für uns als professionelle Bildgestalter bedeutet dies: Die technische Beherrschung von Ebenenmasken, Auswahlwerkzeugen und Frequenztrennung verliert weiter an Bedeutung. An ihre Stelle tritt die Fähigkeit zur präzisen visuellen Regie. Der Wert unserer Arbeit verlagert sich von der handwerklichen Ausführung zur konzeptionellen Kuration und zur strategischen Intention. Wer kann die besten Ideen formulieren? Wer hat die visuelle Bildung, um aus den unendlichen Möglichkeiten, die die KI anbietet, die eine, wirklich überzeugende auszuwählen?

Die alten Debatten über die Authentizität von Fotografie wirken angesichts dieser Entwicklung beinahe rührend nostalgisch. Die Frage ist nicht mehr, ob ein Bild bearbeitet wurde, sondern ob es überhaupt noch einen realen Ursprung hat. Google verspricht zwar, KI-generierte Inhalte mit sichtbaren und unsichtbaren Wasserzeichen (SynthID) zu kennzeichnen, doch die Flut an manipulierten, neu zusammengesetzten und rein fiktionalen Bildern wird unsere Medienkompetenz auf eine harte Probe stellen.

Wir stehen nicht vor einem neuen Werkzeug, sondern vor einem neuen visuellen Paradigma. Die Bildbearbeitung verlässt endgültig die geschlossenen Räume der Studios und Fachprogramme und wird zu einer trivialen, allgegenwärtigen Funktion, eingebettet in die Infrastruktur unseres digitalen Alltags. Die Banane aus dem Suchschlitz mag harmlos klingen, doch sie ist der Vorbote einer Zukunft, in der die Erfindung von Bildern so einfach sein wird wie das Eintippen einer Suchanfrage. Unsere Aufgabe ist es, in dieser neuen Welt nicht nur die Technik zu beherrschen, sondern vor allem die visuelle Urteilskraft zu bewahren.