Nachdem der Vorhang in Cupertino gefallen ist, bleibt für Fotografen und Bildbearbeiter die eine, entscheidende Frage: Was von der glanzvollen Präsentation ist mehr als nur „amazing“, „gorgeous“, „best ever“ – also Produktpflege – und hat das Zeug, den professionellen Alltag spürbar zu verbessern? Die Antwort liegt nicht in einem einzelnen Feature, sondern im fein abgestimmten Zusammenspiel aus der neuen Kameratechnik des iPhone 17 Pro, der Rechenleistung des A19 Pro Chips und einer tief im System verankerten, aber noch bemerkenswert zurückhaltend präsentierten „Apple Intelligence“. Wer auf eine Revolution durch generative Bildsynthese gehofft hatte, wurde enttäuscht. Wer hingegen auf ein verfeinertes, schnelleres und vor allem autarkes Werkzeug setzt, dürfte aufhorchen.

Das Ende der Kompromisse: Die Kamera des iPhone 17 Pro

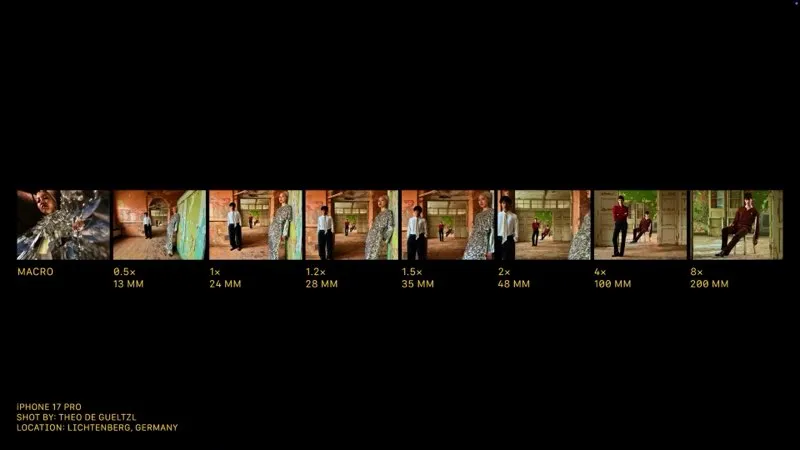

Die wohl folgenreichste Neuerung für die fotografische Praxis steckt im Kameramodul des iPhone 17 Pro und Pro Max. Apple hat hier endlich eine Altlast über Bord geworfen und stattet nun alle drei rückwärtigen Optiken – vom Ultraweitwinkel bis zum Tele – mit identischen 48-Megapixel-Sensoren aus. Dieser Schritt beendet den sichtbaren Qualitätsabfall, der bisher beim Wechsel der Brennweiten oft zu Brüchen in der Detailzeichnung, im Rauschverhalten und in der Farbanmutung führte. Reportage- und Porträtfotografen können nun den gesamten Zoombereich als eine durchgehende optische Einheit betrachten, was eine deutlich konsistentere Bildsprache über eine ganze Serie hinweg ermöglicht.

Der optische Zoom wurde dabei auf eine kleinbild-äquivalente Brennweite von rund 200 Millimetern erweitert, was einer etwa 8-fachen Vergrößerung gegenüber der Hauptkamera entspricht. Das ist ein enormer Gewinn an Reichweite für unauffällige Personenaufnahmen oder das Verdichten von Landschaftselementen. Die erhoffte Einführung einer mechanischen Blende zur besseren Steuerung der Schärfentiefe blieb jedoch aus; hier verlässt sich Apple weiterhin auf die rechnerische Magie des Porträtmodus.

Frontkamera

Apple hat für alle iPhone 17-Modelle eine Frontkamera angekündigt, die über eine neue „Center Stage”-Funktion verfügt, so dass Nutzer ihr Smartphone nicht mehr drehen müssen, um die Ausrichtung der Aufnahme zu ändern.

Die neue Kamera ist Apples „größter Frontkamerasensor aller Zeiten” und fällt durch ihr quadratisches Format auf, das nicht mehr dem Seitenverhältnis 4:3 entspricht. Das bedeutet, dass Selfie-Fans vertikale oder horizontale Selfies aufnehmen können, ohne das Telefon tatsächlich bewegen zu müssen.

Darüber hinaus ändert ein KI-System automatisch das Sichtfeld und die Drehung der 18-Megapixel-Kamera, je nachdem, wie viele Personen jemand auf das Bild bringen möchte.

Video

Entgegen vieler Gerüchte ist die Aufzeichnung in 8K-Auflösung noch nicht möglich. Erstmals können iPhones mit der Apple-eigenen Kamera-App gleichzeitig mit der Front- und der Hauptkamera aufzeichnen. Festgehalten wird also der Filmende und auch das, was er sieht. Diese Funktion ist ideal für Interviews, Reportagen oder Reaktionsvideos, da sie den oft mühsamen Prozess der späteren Synchronisation zweier getrennter Quellen überflüssig macht.

Die Vorgänger, also die iPhone 16 Pro-Modelle, verfügen bereits über sehr leistungsstarke Videokameras, und das iPhone 17 Pro legt mit ProRes RAW-Aufzeichnung und Genlock noch einmal etwas nach. Diese Funktionen machen es zu einer etwas leistungsfähigeren Kamera für den professionellen Video-Workflow. Beide iPhone 17 Pro-Modelle nehmen mit allen drei Rückkameras 4Kp120-Videos und Dolby Vision HDR-Videos auf.

Das Gehirn im Hintergrund: Apple Intelligence und der A19 Pro

Die wahre Stärke der neuen Generation entfaltet sich im Verborgenen. Der A19 Pro Chip liefert nicht nur die nötige Rechenleistung für die Verarbeitung der riesigen Datenmengen von drei 48-Megapixel-Sensoren und 4K-Video, sondern ist auch die Hardware-Basis für Apples KI-Strategie. Anders als Google oder Adobe setzt Apple weiterhin konsequent auf „On-Device-Processing“. Nahezu alle intelligenten Funktionen, von der Szenenanalyse über die Belichtungssteuerung bis hin zum neuen „Clean-Up“-Werkzeug zum Entfernen störender Objekte in die Fotos-App der 2026er Betriebssysteme, laufen lokal auf dem Gerät ab.

Für jeden, der mit sensiblen Bilddaten hantiert, ist dieser datenschutzfreundliche Ansatz ein Vorteil. Ein weiterer, lange überfälliger Schritt ist die Einführung einer verbesserten Camera App. Funktionen wie manueller Weißabgleich, Fokus-Peaking zur Schärfekontrolle und die Anzeige von Zebra-Mustern für Überbelichtungswarnungen sind wohl mit dem neuen iOS 2026 direkt ins System integriert. Das würde viele Drittanbieter-Apps zwar nicht überflüssig machen, senkt aber die Einstiegshürde für eine professionellere Arbeitsweise erheblich. Mehr dazu erfahren wir ab dem 15. September, wenn die neuen Geräte verfügbar sind und die neuen Systemupdates zum Download bereit stehen.

Der Schreibtisch als Kommandozentrale: macOS Tahoe

Die auf dem iPhone begonnene Arbeit findet auf dem Mac ihre logische Fortsetzung. Das neue Betriebssystem macOS Tahoe integriert die Apple Intelligence nahtlos in den Desktop-Alltag. Die Spotlight-Suche durchforstet nun auch Bildinhalte auf lokalen und angeschlossenen Laufwerken und erkennt Objekte, Texte und Gesichter. Ein einfacher Befehl wie „Finde das Foto mit dem blauen Oldtimer am Comer See“ liefert dann hoffentlich in Sekunden Ergebnisse, für die man früher komplexe Metadaten-Suchen bemühen musste.

Für Studios und Agenturen ist besonders relevant, dass Apple Entwicklern den Zugriff auf das lokale KI-Modell gewährt. Das ebnet den Weg für eine neue Generation von Plug-ins, etwa für Photoshop oder Capture One, die komplexe Aufgaben direkt auf der lokalen Maschine ausführen können – schnell, privat und ohne die Latenz oder die Kosten eines Cloud-Abos. Hier positioniert sich Apple als Gegenentwurf zum zunehmenden Cloud-Zwang anderer Anbieter und stärkt den Mac in seiner Rolle als autarke und verlässliche Produktionszentrale. Man muss dabei aber im Auge behalten, dass Apples Hardware bisher alles andere als für Generative KI optimiert ist.

Fazit: Evolution statt Disruption

Die Apple-Keynote vom September 2025 war kein Paukenschlag, der die Fotografie neu erfindet. Sie war vielmehr die Demonstration einer konsequente, auf kleine jährliche Schritte ausgelegten Produktphilosophie. Mit dem iPhone 17 Pro erhalten Fotografen ein Werkzeug, das durch seine optische Konsistenz, die neuen Videofähigkeiten und den erweiterten Zoombereich an professioneller Relevanz gewinnt.

Die dahinterliegende Apple Intelligence ist kein leider kein potenter Bildgenerator, sondern ein eher unaufdringlicher, aber möglicherweise funktionaler Workflow-Beschleuniger, der aber immerhin die Privatsphäre des Nutzers respektiert. Apple unterstützt seine Fotografen mit Hardware-KI und gibt ihnen auf Systemebene funktionserweiternde Werkzeuge an die Hand. Wenn die Authentizität des Bildes zunehmend infrage gestellt wird, ist dieses Bekenntnis zur „zurückhaltend KI-unterstützten“ Fotografie vielleicht die wichtigste Botschaft.

„Die erhoffte Einführung einer mechanischen Blende (https://www.phonecare.com/blog/iphone-17-soll-angeblich-eine-mechanische-blende-fur-den-portratmodus-haben) zur besseren Steuerung der Schärfentiefe blieb jedoch aus; hier verlässt sich Apple weiterhin auf die rechnerische Magie des Porträtmodus.“

Der verlinkte Artikel auf Phonecare verbreitet Unsinn: „Mit einem mechanischen System könnten Benutzer manuell eine kleinere Blende einstellen. Dies würde es ermöglichen, Fotos mit einem geringen Schärfentiefe-Effekt aufzunehmen, bei dem das Motiv im Fokus bleibt, während der Hintergrund unscharf ist. Apple bietet diesen Effekt bereits auf iPhones im Porträtmodus an, jedoch wird er künstlich erzeugt, während diese Änderung ihn natürlich machen würde.“ Eine mechanische Blende würde die Öffnung verkleinern, so weit ist es noch richtig, aber damit würde die Schärfentiefe vergrößert, während es beim Porträtmodus ganz im Gegenteil darum geht, die Schärfentiefe scheinbar zu verringern. Eine mechanische Blende und der Porträtmodus wären also keine Alternativen, sondern würden sich ergänzen – zur Vergrößerung der Schärfentiefe blendet man mechanisch ab, während man für einen unscharfen Hintergrund den Porträtmodus nutzt. Da die Schärfentiefe aber selbst bei offener Blende noch relativ groß ist, hielte sich der praktische Nutzen einer mechanischen Blende in Grenzen. Eine echte optische Alternative zum Porträtmodus würde keine Blende, sondern lichtstärkere Objektive erfordern, aber aufgrund des begrenzten Platzes im Gehäuse gibt es da wenig Spielraum.

Oben im Text: ist das Wort „Perspektive verdichtet“ im Bezug auf das neue Teleobjektiv genannt.

Das ist doch nur ein Crop !! (immerhin aus nicht mehr 12MP sondern jetzt aus 48MP.

Die verteilen sich jetzt auf 23,5mm². statt auf 15,3mm². Also 4x soviel Pixel auf nicht mal 2x soviel Fläche.

Warum baut Apple so einen hässlichen „Wubbel“ und setzt dann nicht mal ihren „Maincamera“ Chip hinter alle 3 Linsen ein ? Der hat immerhin 71,5mm² und bietet ja nachweislich die beste Bildqualität.

Übrigens ist die Brennweite nicht mehr 120mm (iPhone 16pro) sondern nur noch 100mm (iPhone 17pro)

Bin wirklich mal gespannt, auf die ersten Qualitätsvergleiche gegenüber dem Vorgänger-iphone.

Insbesondere : iPhone 16pro mit der Vorsatzlinse von Reflex 210mm vor die Mainkamera gescraubt vs. iPhone 17pro und 8x gezoomt mit der neuen „Telelinse“….

Eine verdichtete Perspektive entsteht durch den Aufnahmestandpunkt, nicht durch die Brennweite. Der engere Bildwinkel und die stärkere Vergrößerung ergeben sich wiederum durch das Zusammenspiel von Brennweite und Bildformat. Ob man die Brennweite verlängert oder das Bild beschneidet, macht hinsichtlich der Perspektive keinen Unterschied. Einen Unterschied gibt es zwar bei der Zahl der Pixel, was aber für den Hauptzweck solcher Aufnahme, nämlich das Teilen in den sozialen Netzen, keinen nennenswerten Unterschied macht – 12 Megapixel sind da mehr als genug.

Prinzipiell wäre es natürlich gut, wenn alle drei Kameramodule so große Sensoren wie die Hauptkamera hätten (anders als oben geschrieben handelt es sich nicht um identische Sensoren; lediglich ihre Pixelzahl – 48 Megapixel im Quad-Bayer-Muster – ist gleich), aber dann müssten die realen Brennweiten entsprechend länger sein und insbesondere das Teleobjektiv wäre schwieriger unterzubringen, ohne das Gehäuse zu vergrößern.

Dass die kleinbildäquivalente Brennweite der Telekamera „nur“ 100 statt 120 mm beträgt, hängt damit zusammen, dass ihr Sensor nun deutlich größer als der entsprechende Sensor im Vorgängermodell ist (23,5 statt 15,3 mm²). Außerdem hat er viermal so viele Pixel, so dass es insgesamt auf eine Verbesserung gegenüber dem 16 Pro hinaus läuft, selbst wenn man über die 100 mm hinaus digital zoomt. Bei 100 mm hat das 17 Pro die Nase vorn, denn es kann bereits komplett auf seine Telekamera umschalten, während das 16 Pro noch das Bild der (geringer auflösenden) Telekamera mit einem beschnittenen Bild der Hauptkamera kombinieren muss. Konkret: Bei 100 mm macht das 17 Pro aus den 48 Megapixeln seiner Telekamera ein Bild, das 16 Pro aus 12 Megapixeln seiner Telekamera und 3 Megapixeln der Hauptkamera (denn mehr bleibt nach dem Beschnitt nicht übrig).

Die Aussage ist nicht ganz richtig: Eine verdichtete Perspektive ist das Ergebnis der Kombination aus Aufnahmestandpunkt und Brennweite. Der Aufnahmestandpunkt allein ändert die Perspektive, während die Brennweite primär den Bildausschnitt bestimmt, aber auch die Wahrnehmung des Abstands zwischen Vorder- und Hintergrund beeinflusst. Wenn Sie eine Weitwinkelbrennweite verwenden und sich dem Motiv nähern, wird die Perspektive oft als gedehnt empfunden, wohingegen eine lange Brennweite bei gleichem Bildabstand den Raum staucht.

„Ob man die Brennweite verlängert oder das Bild beschneidet, macht hinsichtlich der Perspektive keinen Unterschied. Doch aber in der Bildwirkung ! Es ergibt sich die „telemäßige Stauchung“ der Ansicht. Was bei einem „nur crop“ Ausschnitt gleich bleibt. Und was für den Einen „noch nicht einmal doppelt so groß“. ist für den Anderen „deutlich größer“ 😉 Und ich denke mal, da hat sich auch der Bildkreis ändern müssen, der jetzt ja eine größere Fläche ausleuchten muss. Und auch wenn der Chip nun etwas größer ist, bedeutet es deswegen nicht zwanghaft, daß sich die Brennweite dadurch ändert.

Die Effekte einer Dehnung oder Stauchung der Perspektive entstehen allein durch die Entfernung zum Motiv, also den Aufnahmestandpunkt. Eine Aufnahme mit längerer Brennweite und eine beschnittene Aufnahme mit kürzerer Brennweite sind in ihrer Bildwirkung identisch; nur ihre Auflösung unterscheidet sich.

Das kann man seit Albrecht Dürers Zeiten in jedem Lehrbuch zur Perspektive nachlesen – wir hatten es auch schon öfter in DOCMA erklärt –, oder man probiert es einfach selbst aus, wenn man es nicht glaubt.

Aber nichtsdesdotrotz: die neuen Lamborghini farbenden Telefone haben jetzt PRORES RAW und Genlock

Das ist cool.