Apple-KI: Besseres Textverständnis, neue Möglichkeiten und Bildbearbeitung mit Textbefehlen

Apple hat für die nächste iOS-Version Großes angekündigt – insbesondere im Hinblick auf künstliche Intelligenz. Was wir vielleicht erwarten können, zeigen kürzlich einige Veröffentlichungen.

Apple-KI: Der Stand der Dinge

KI spielt auf Apple-Geräten bis dato noch keine große oder hilfreiche Rolle, wenn man sich auf Apple-Software selbst beschränkt. Schon wenn ich vergleiche, wie längst Sprachassistenten von Amazon (Alexa) und Google zuverlässig und hilfreich auf meine Anweisungen reagieren, dann kann der von Apple (Siri) meistens einpacken. Apple hat also grundlegend einiges nachzuholen und hat für iOS 18 die Erwartungen bereits in die Höhe geschraubt (mehr Informationen). Dass Apple diesbezüglich nicht untätig war und ist, zeigen einige interessante Veröffentlichungen.

Bildbearbeitung mit Textbefehlen per Apple-KI

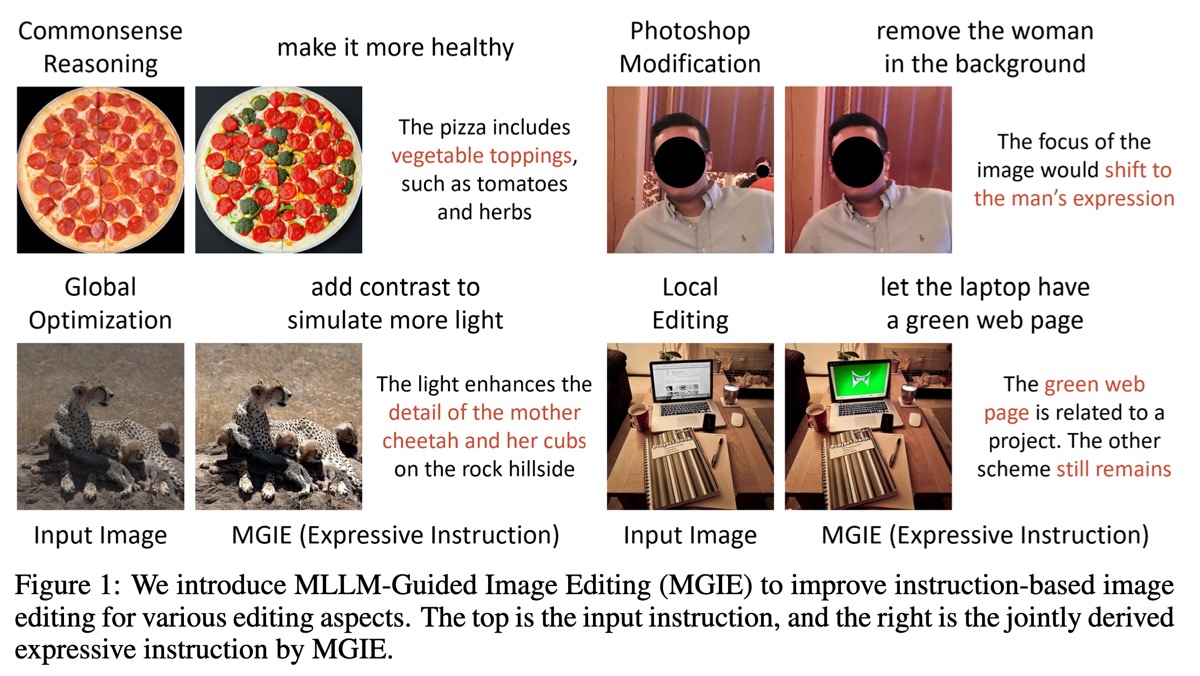

In einem Paper (Februar 2024) zeigte Apple Konzepte, um Bilder per Textbefehle („Mach die Pizza gesünder“ oder „Erhöhe den Kontrast“) zu optimieren:

Dass es gar nicht so leicht ist, Anweisungen richtig zu geben oder diese wie gewünscht zu interpretieren und umzusetzen, kennen viele Designer sicher aus der Praxis mit ihren Kunden. Bei der KI ist das nicht anders. Im obigen Screenshot aus dem Paper wird deutlich, welche Annahmen gemacht werden müssen, um eine vermeintlich einfache und klare Sprachanweisung umzusetzen. Was schon bald Alltag sein könnte, ist also mitnichten trivial.

Auf Huggingface können Sie den aktuellen Stand bereits ausprobieren; die Auflösung der Ergebnisse ist dabei aber noch gering: Link.

Mit Apple MM1 könnte die Apple-KI zur Konkurrenz aufholen

MM steht (wahrscheinlich) für „multimodales Modell“ und ist ein KI-System, das wie Googles Gemini oder Metas Llama 2 vergleichbar ist. „Multimodal“ bedeutet dabei, dass das Modell sowohl mit Text als auch mit Bildern trainiert wurde. Hier finden Sie das Paper zu diesem Modell. Es soll dabei vergleichbare Möglichkeiten wie ChatGPT bieten (ChatBots, Programmieren von Anwendungen und Webseiten, Bilderzeugung).

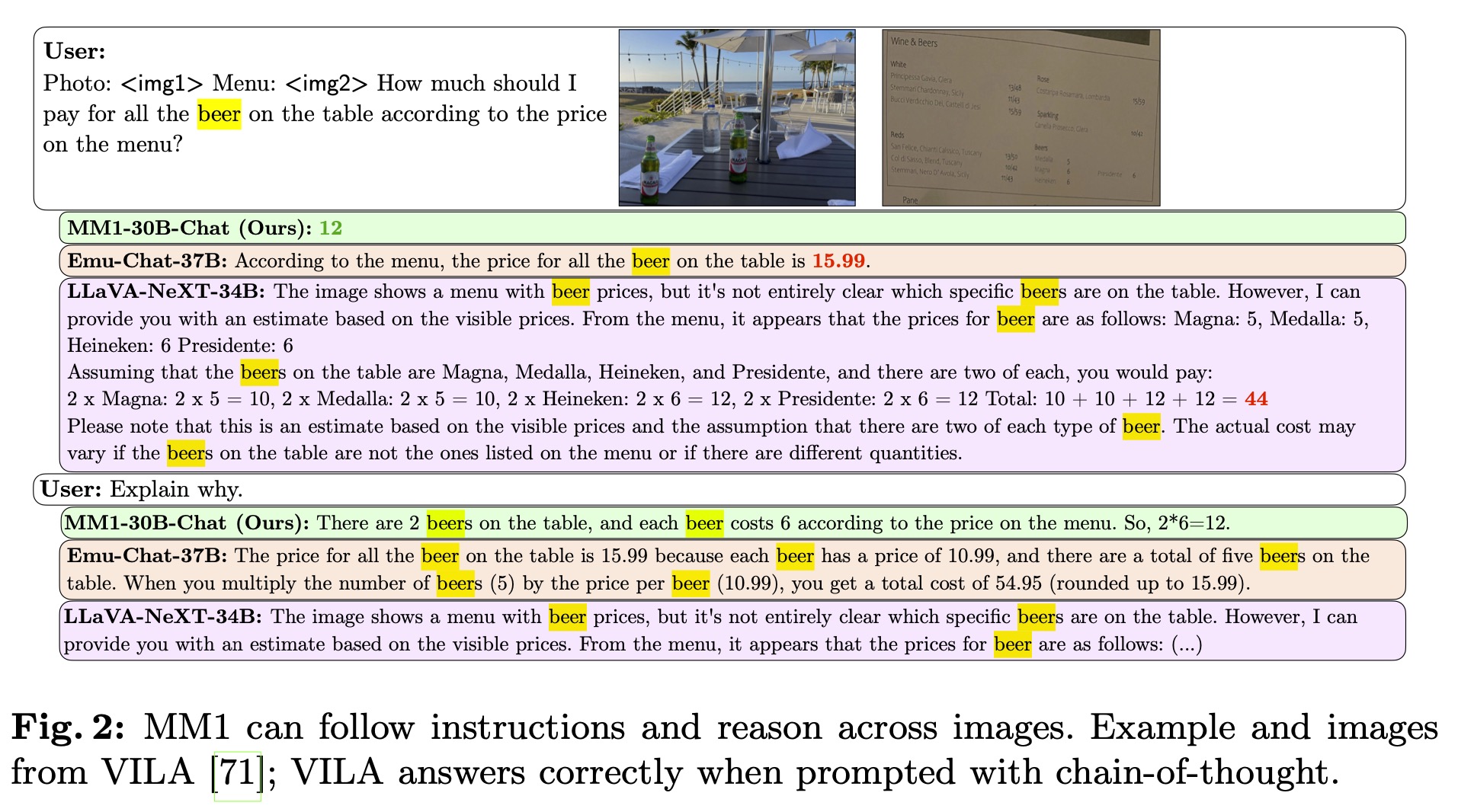

Ein eindrucksvolles Beispiel aus dem Paper: MM1 wird das Foto eines Restauranttisches mit ein paar Bierflaschen sowie ein Bild der Speisekarte vorgelegt. Auf die Frage, wie viel für „das ganze Bier auf dem Tisch“ zu zahlen wäre, liest das Modell den korrekten Preis ab und rechnet die Kosten zusammen:

Apple strebt an, das KI-Modell möglichst kleinzuhalten. Dadurch kann es lokal auf Smartphones ausgeführt werden, was sowohl der Geschwindigkeit als auch dem Datenschutz zugute käme und nicht zwangsläufig eine Online-Verbindung benötigt. Zum Vergleich:

Quelle und mehr Informationen (Englisch).

Dank der Apple ReAlm könnte Siri mehr verstehen

Für ein besseres Kontextverständnis von Apples Sprachassistenten Siri als auch von MM1 könnten die Ergebnisse eines weiteren Papers sorgen: ReALM: Reference Resolution As Language Modeling. Siri soll dabei sowohl den Zusammenhang einer Anweisung oder Frage zum bisher Gesagten oder auf dem Bildschirm zu Sehenden verstehen können („Zeige mir alle Restaurants in der Umgebung … Rufe das Dritte an.“). Gerade dieses fehlende Verständnis ist es, was mich oft davon abhält, Siri überhaupt zu nutzen. Meist bin ich auf traditionellem Weg (Google per Spracheingabe) dann doch schneller am Ziel.

Wie praxistauglich all das ist und ob es schon in iOS 18 erscheinen wird, steht noch in den Sternen. Offenbar ist Apple auch an Gemini von Google fürs iPhone interessiert (Link), was darauf hindeuten könnte, dass die eigenen KIs bislang nicht so weit sind oder sich der Aufwand dann doch nicht rechnet. Aber das sind Spekulationen. Es bleibt spannend. 🙂

Es ist schon lustig: Reference Resolution, also die Identifizierung des Antezedenz einer Anapher, war zu meiner Zeit in den 1980er und frühen 90er Jahren ein großes Thema. Damals, vor rund 35 Jahren, hatten wir das Problem aber so ziemlich im Griff; selbst mit den Herausforderungen multimodaler Dialoge beschäftigten sich manche Kollegen bereits.

Aber das war natürlich GOFAI, also symbolische KI. Die aktuellen Systeme auf Basis neuronaler Netze sind um so vieles robuster als das, war wir seinerzeit entwickelt hatten, aber die Methoden der Anaphern-Auflösung müssen sie wieder ganz neu erlernen. Dabei gelten die im vergangenen Jahrhundert gewonnenen Erkenntnisse bis heute; man weiß längst, wie es geht, aber anders als den symbolischen KI-Systemen kann man einem neuronalen Netz nicht einfach eine Handvoll Regeln mitgeben; es möchte diese Regeln im Training mit Unmengen von Beispielen lieber selbst entdecken. In dem erwähnten Paper werden dann auch nur Arbeiten aus den letzten paar Jahren zitiert; für die Ergebnisse der symbolischen KI interessiert sich heute keiner mehr. Es wäre aber auch schwierig, die heutigen Systeme davon profitieren zu lassen.