Eine neue Studie von AI Forensics seziert die Flut an KI-generierten Inhalten auf TikTok und Instagram. Die Ergebnisse sind ernüchternd und zeigen, wie spezialisierte Accounts unsere Feeds mit fotorealistischem Einheitsbrei überschwemmen.

Erinnern Sie sich noch an die Pionierzeit des Internets? An jene Phase des digitalen Aufbruchs, als jede Webseite ein eigenwilliges Stück Handarbeit war und das Surfen einer Entdeckungsreise glich. Diese Ära ist längst Geschichte. Zuerst kam die Epoche der sozialen Medien, die mit ihren Algorithmen und standardisierten Profilen bereits eine erste Welle der Gleichförmigkeit einläutete. Was wir heute erleben, ist jedoch eine Eskalation, eine Industrialisierung des Einheitsbreis in einem bisher ungekannten Ausmaß, angetrieben durch generative KI.

Eine brandaktuelle Untersuchung der Organisation AI Forensics mit dem Titel „AI-Generated Algorithmic Virality“ liefert nun erstmals erschreckend konkrete Zahlen zu diesem Phänomen, das Experten als „gen-ai slop“ – KI-generierten Digitalmüll – bezeichnen. Die Forscher analysierten im Juni 2025 die Top-30-Suchergebnisse für allgemeine Hashtags wie #history, #health oder #trump in Deutschland, Spanien und Polen. Das Ergebnis ist ein Weckruf für jeden, der im digitalen Raum publiziert oder konsumiert: Auf TikTok enthält bereits jeder vierte Beitrag in den Suchergebnissen synthetische, also ganz oder teilweise KI-generierte, Bilder oder Videos. Auf Instagram ist das Phänomen zwar noch weniger ausgeprägt, doch die grundlegende Tendenz ist unverkennbar. Die Studie zeigt, dass wir es nicht mit vereinzelten Experimenten zu tun haben, sondern mit einer systematischen Überflutung der Informationskanäle.

Die Anatomie des KI-Schunds

Was die Studie von AI Forensics so wertvoll macht, ist ihre detaillierte Klassifizierung der verschiedenen Arten von KI-Inhalten, die uns täglich begegnen. Diese „Topologie des KI-Schunds“ hilft zu verstehen, welche Formen die maschinelle Bild- und Textproduktion annimmt. Die Forscher identifizierten mehrere Hauptkategorien, die für Bildbearbeiter und Fotografen besonders aufschlussreich sind.

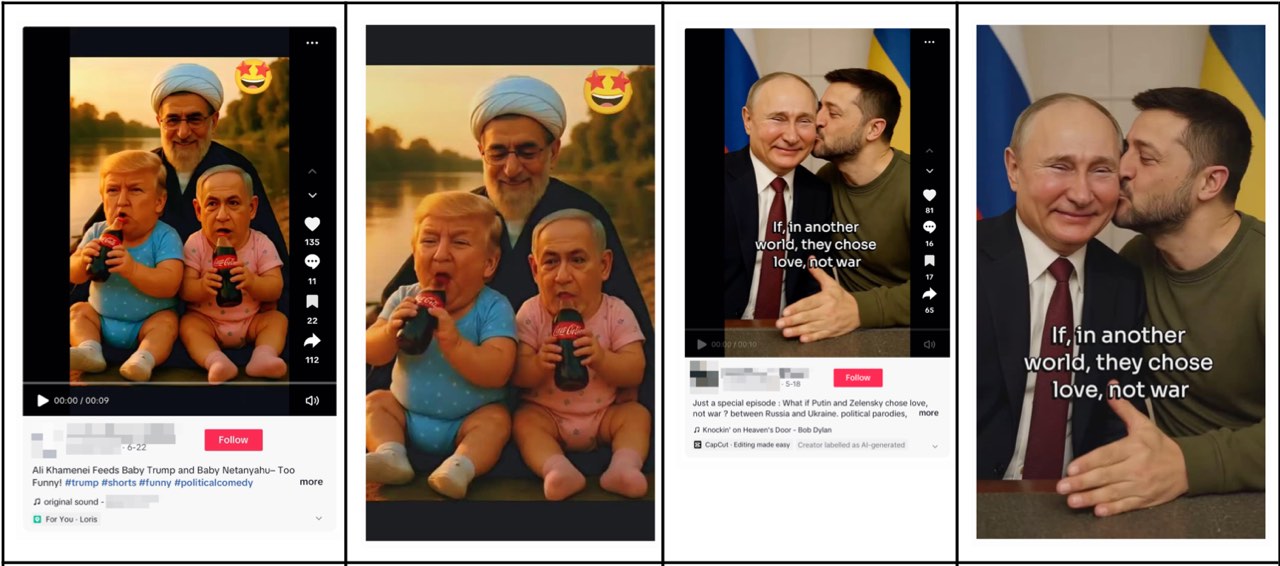

Da ist zum einen die „Autoritätssatire“, bei der politische Führer wie Trump oder Selenskyj durch KI verkindlicht oder in absurde, unrealistische Situationen versetzt werden. Diese Bilder spielen mit der Ästhetik von Memes und politischen Karikaturen, nutzen aber die täuschende Kraft fotorealistischer Darstellung.

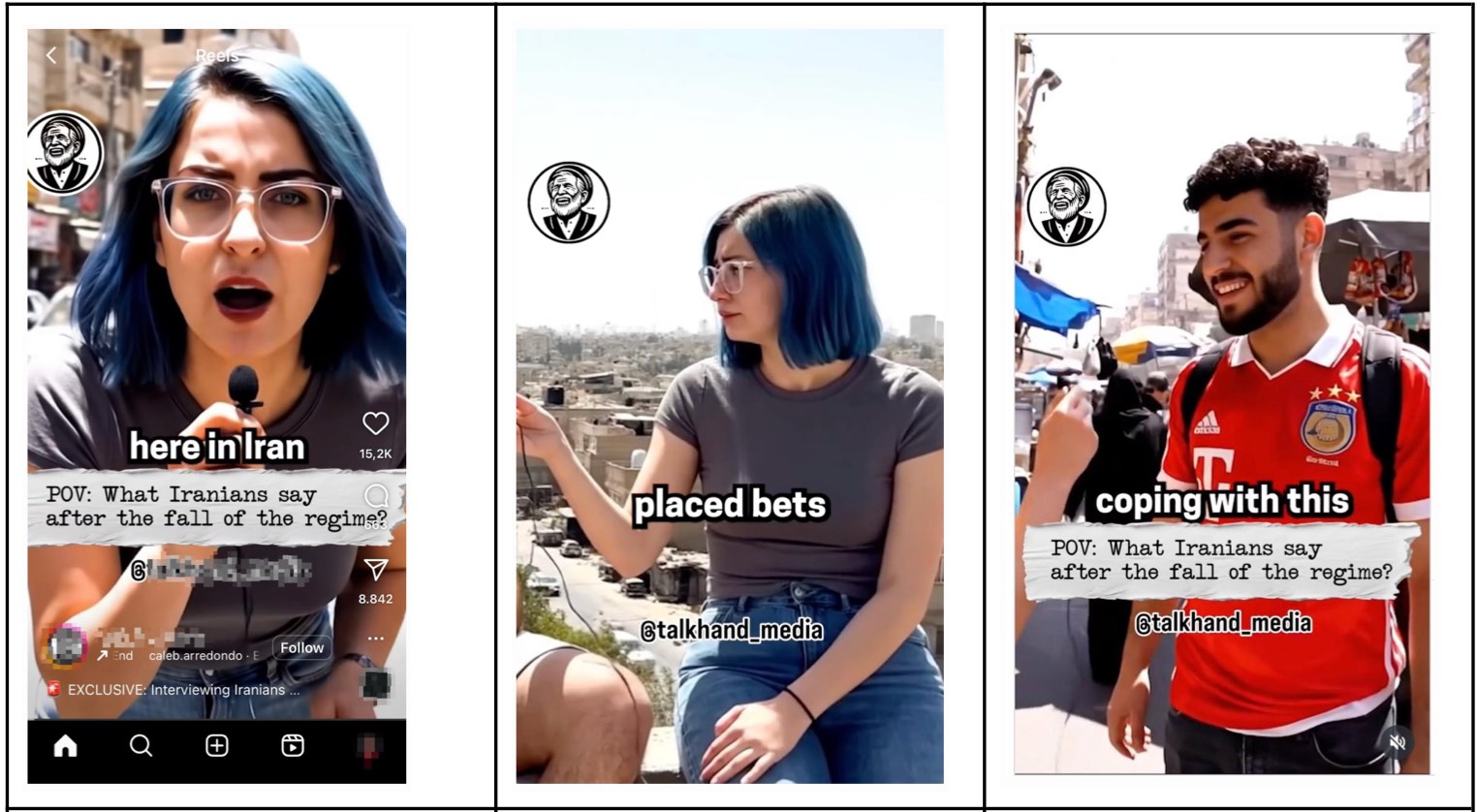

Eine weitere, weitaus problematischere Kategorie ist die „plausible Desinformation“. Hierzu zählen synthetische Interviews oder gefälschtes „Bürgerreporter“-Material, das zum Beispiel Explosionen oder Krisenszenarien simuliert und dabei die visuelle Sprache von Smartphone-Aufnahmen imitiert. Ein im Bericht dokumentierter Fall zeigt eine angebliche Explosion im Iran, die auf TikTok ohne Kennzeichnung als echt verbreitet wurde, obwohl das Original auf YouTube als KI-Kreation ausgewiesen war.

Besonders relevant für den visuellen Sektor ist die Kategorie des „illusorischen Historisierens“. Hier werden mittels KI „unmögliche Fotografien“ von historischen Ereignissen oder Personen angefertigt, die es so nie geben konnte. Oder es werden „Point-of-View“-Aufnahmen generiert, die dem Betrachter vorgaukeln, er würde ein historisches Ereignis aus der Ich-Perspektive erleben. Diese Vermischung von Fakten und Fiktion untergräbt das Vertrauen in historisches Bildmaterial.

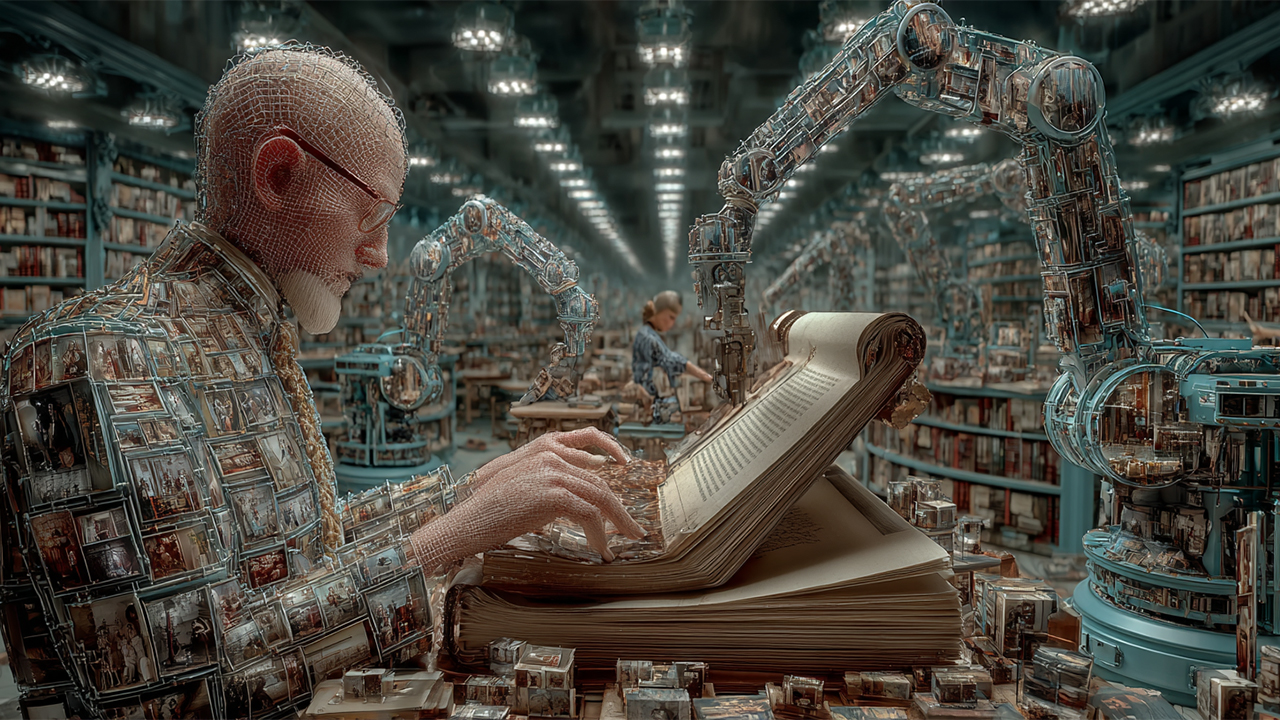

Schließlich gibt es noch den „KI-Schund als Stock-Bild“, der abstrakte Konzepte oder medizinische Vorgänge im Inneren des Körpers visualisiert und dabei die sterile Ästhetik von Stock-Fotografie nachahmt.

Die Fabriken des Einheitsbreis: Agentic AI Accounts

Wer aber produziert diese Flut an Inhalten? Die Studie von AI Forensics liefert auch hier eine klare Antwort und entlarvt ein neues Phänomen: die sogenannten „Agentic AI Accounts“. Dies sind keine normalen Nutzer, sondern spezialisierte Konten, die fast ausschließlich KI-generierte Inhalte posten. Ihre Strategie ist simpel und brutal effektiv: Sie nutzen Automatisierung, um in kürzester Zeit eine gewaltige Menge an Inhalten zu produzieren und damit die Algorithmen der Plattformen gezielt zu „bespielen“. Das Ziel ist, durch schiere Masse die Wahrscheinlichkeit zu erhöhen, dass einer der Beiträge viral geht und monetarisiert werden kann.

Die Zahlen sind überwältigend: Auf TikTok stammen über 80 Prozent der in der Studie gefundenen KI-Inhalte von ebenjenen „Agentic AI Accounts“. Diese Konten agieren wie digitale Fabriken. Die Forscher unterscheiden drei Typen: Mono-Topic-Accounts, die sich auf ein einziges Thema oder eine Ästhetik spezialisieren (z.B. nur Bilder von Trump als Kleinkind). Poly-Topic-Accounts, die verschiedene Trends und Stile ausprobieren, um zu sehen, was funktioniert. Und Hybrid-Accounts, die KI-generierte Bilder mit Stock-Material und KI-generierten Erzählstimmen mischen, um schockierende oder reißerische Geschichten zu illustrieren. Diese Industrialisierung der Content-Produktion ist der wahre Motor hinter der Schwemme an visuellem Einheitsbrei.

Das Versagen der Plattformen

Angesichts dieser systematischen Flutung stellt sich die Frage nach der Verantwortung der Plattformen. Auch hier sind die Ergebnisse der AI-Forensics-Studie ernüchternd. Obwohl sowohl TikTok als auch Meta (der Mutterkonzern von Instagram) Richtlinien zur Kennzeichnung von KI-Inhalten haben, ist die Umsetzung mangelhaft. Auf TikTok war nur etwa die Hälfte aller identifizierten KI-Inhalte korrekt als solche gekennzeichnet. Auf Instagram war die Quote mit nur 23 % noch schlechter.

Das Problem wird durch die mangelhafte Sichtbarkeit der Labels verschärft. Oft sind die Hinweise in langen Hashtag-Listen versteckt oder erfordern einen zusätzlichen Klick, um sichtbar zu werden. Besonders gravierend: Auf der Web-Version von Instagram fehlten die KI-Labels während des Untersuchungszeitraums komplett. Dies ist ein klares Versäumnis, das dem Nutzer die Möglichkeit nimmt, informierte Entscheidungen über die Vertrauenswürdigkeit von Inhalten zu treffen. Besonders alarmierend ist die Erkenntnis der Studie, dass über 80 % der analysierten KI-Inhalte fotorealistisch waren, was ihr Täuschungspotenzial erheblich steigert. Wenn Bilder, die echt aussehen, nicht als künstlich gekennzeichnet sind, wird die Grenze zwischen Realität und Fälschung für den Betrachter gefährlich durchlässig.

Was das für Kreative bedeutet

Für Fotografen, Bildbearbeiter und alle visuell arbeitenden Profis sind diese Entwicklungen eine fundamentale Herausforderung. Die Flut an generischem, seelenlosem Bildmaterial entwertet die menschliche Kreativität. Sie schafft eine visuelle Geräuschkulisse, in der es für hochwertige, durchdachte und handwerklich exzellente Arbeiten immer schwieriger wird, durchzudringen.

Die Lösung liegt aber nicht in der Verteufelung der Technologie, sondern in der bewussten Auseinandersetzung mit ihr. Wir müssen lernen, KI als Werkzeug zu begreifen, das uns von Routinearbeiten entlasten kann, aber niemals die menschliche Vision, die emotionale Tiefe und die einzigartige Handschrift eines Künstlers ersetzen kann. Die Studie von AI Forensics ist ein wertvolles Instrument, denn sie schärft unseren Blick. Sie hilft uns, die Muster des maschinell Gefertigten zu erkennen und den Wert des Authentischen umso höher zu schätzen.

Letztlich wird sich Qualität durchsetzen. So wie nach der industriellen Revolution eine neue Wertschätzung für das Handwerk entstand, wird auch nach der KI-Flut die Nachfrage nach echter, menschlicher Kreativität steigen. Bis dahin gilt es, wachsam zu bleiben, die Mechanismen der digitalen Schundfabriken zu verstehen und die eigene Arbeit als bewussten Gegenentwurf zur maschinellen Gleichförmigkeit zu positionieren.