Immer mehr Menschen vertrauen blind auf die Auskünfte einer fröhlich flunkernden KI. Wird man ChatGPT und anderen Large Language Models die Neigung zum Halluzinieren jemals austreiben können, oder liegt sie einfach in deren Natur? Und womit müssen wir rechnen, wenn KI-Agenten künftig in unserem Namen handeln?

Keine Frage: Wer sich in die Hände einer KI begibt, hat die Kontrolle über sein Leben verloren. Das musste jüngst Marco Buscaglia von King Features erfahren, der für eine Liste von Buchempfehlungen auf die Dienste einer KI zurückgegriffen hatte. Erst nachdem die Chicago Sun-Times und der Philadelphia Inquirer seinen „Heat Index: Your Guide to the Best of Summer“ abgedruckt hatten, fiel jemandem auf, dass 10 von 15 der mit kurzen Inhaltsangaben vorgestellten Romane zur Urlaubslektüre nicht bloß Fiktion, sondern gänzlich fiktiv waren – es gab sie nicht. Die tatsächlich existierenden Autoren wiesen auch jede Absicht von sich, die Bücher zu schreiben, die ihnen die KI unterzuschieben versucht hatte. „Tidewater Dreams” von Isabel Allende, „The Last Algorithm“ von Andy Weir oder „Nightshade Market“ von Min Jin Lee werden wir also nie zu lesen bekommen. Vermutlich wird man auch von Marco Buscaglia nicht mehr so viel lesen, denn King Features hat ihn nach dieser Affäre gefeuert.

Andere versuchen, von diesem Fauxpas zu profitieren. Letzten Freitag hat eine „Isabella Allendra“ den Roman „Tidewater Dreams“ auf den Markt geworfen, den Isabel Allende nicht schreiben wollte. Dessen 224 Seiten werden kaum ohne die Hilfe einer KI gefüllt worden sein, und nach der Inhaltsangabe bei Amazon zu urteilen wäre es keinem Menschen zuzumuten, sie auch zu lesen. Schon seit Donnerstag gibt es „The Last Algorithm“ von „Andy Weird“ statt des realen Andy Weir, und auch dessen 342 Seiten dürften das Produkt einer KI sein.

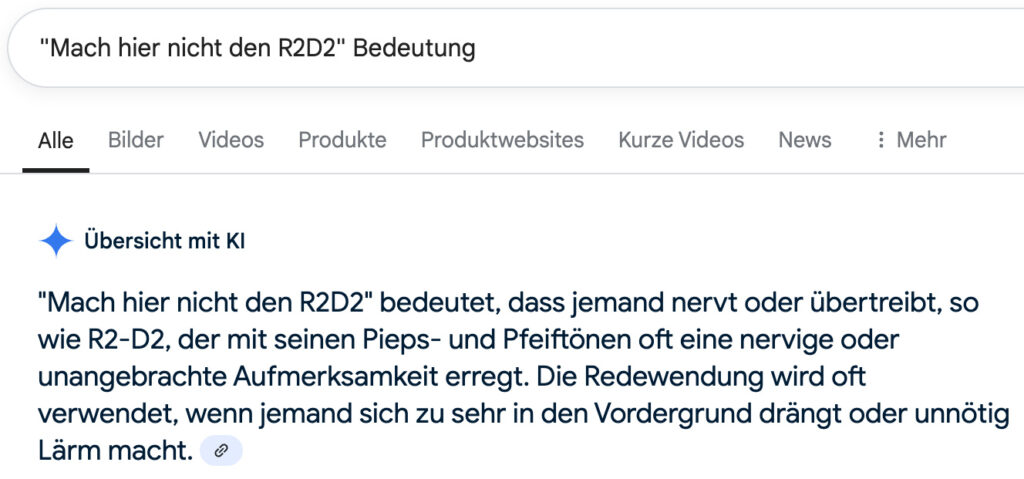

Manche Fehlleistungen von Large Language Models sind harmlos. Google reichert seine Suchergebnisse mittlerweile mit Antworten an, die seine KI geliefert hat, und die sind bisweilen unfreiwillig komisch.

Beispielsweise kann man sich von Google Redewendungen erklären lassen, was überraschenderweise auch dann funktioniert, wenn man sie sich selbst ausgedacht hat. Das wäre nicht zu beanstanden, würde die KI lediglich eine Erklärung vorschlagen, was gemeint sein könnte – aber sie tut so, als handele es sich um eine gewöhnliche, tatsächlich gebrauchte Redewendung. Dabei sollte es Google besser wissen, denn wenn eine solche Formulierung gebräuchlich wäre, hätten sich ja im Internet Beispiele dafür gefunden.

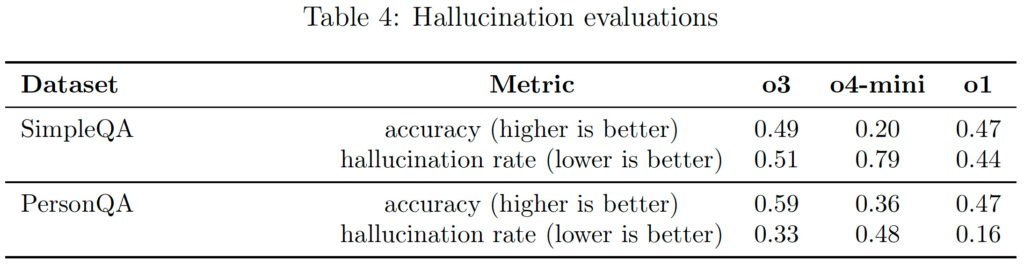

Das Problem des Halluzinierens der LLM, also mit dem Habitus absoluter Selbstgewissheit Unsinn zu erzählen, ist schwer in den Griff zu bekommen. Auch neuere Reasoning-Systeme sind dagegen nicht immun; im Gegenteil scheint der Anteil halluzinierter Antworten sogar zu steigen, was sich bei ChatGPT o3 und 04-mini von OpenAI ebenso wie bei R1 von DeepSeek gezeigt hat. Und die bislang bewährte Abhilfe aller Unzulänglichkeiten von KI-Systemen, sie mit einem noch höheren Hardware-Aufwand und noch größeren Korpora neu zu trainieren, funktioniert kaum noch, zumal es immer schwieriger wird, an frische Trainingsdaten zu kommen.

Wohlgemerkt: Wir haben es nicht mit einem generellen Problem der KI zu tun. Mustererkennungssysteme beispielsweise, wie sie in der medizinischen Diagnostik eingesetzt werden, sind sehr erfolgreich – nicht unfehlbar, aber doch so treffsicher wie die besten menschlichen Diagnostiker, und dabei überall kostengünstig einsetzbar. Das Halluzinieren ist ein für LLMs spezifisches Problem.

Wenn ich Wissen auf einem Gebiet erwerben will, mit dem ich mich zunächst einmal nicht auskenne, kann ich versuchen, von Grund auf alles selbst herauszufinden, aber das ist selten praktikabel. Sinnvoller wäre der Ansatz, zu recherchieren, also zu sichten, was Fachleute zu den mich interessierenden Fragen veröffentlicht haben. Damit gewinne ich einen Überblick über den aktuellen Wissensstand und kann versuchen, eine Quintessenz daraus zu ziehen. Die dritte Möglichkeit wäre, mir einen einzigen anerkannten Experten zu suchen und ihm oder ihr meine Fragen zu stellen. Die Konsultation einer KI, typischerweise eines LLM, ist nur eine Variante dieser Vorgehensweise.

Doch ist die befragte KI wirklich kompetent? Menschliche Experten werden von ihren Kollegen (Peers, wie man im Wissenschaftsbetrieb sagt) eingeschätzt, und man kann die Quote ihrer Erfolge und Misserfolge in Erfahrung bringen, bevor man sich ihnen anvertraut. Ein LLM dagegen ist kein Experte auf einem eng begrenzten Fachgebiet, sondern ein Generalist; man kann ihm Fragen zur Quantenphysik oder zur Geschichte des römischen Reichs ebenso wie zur Karriere von Taylor Swift stellen. Wie tief sein Wissen und wie zuverlässig seine Antworten in irgendeinem Gebiet sind, ist aber im Voraus kaum zu beurteilen, und seine Leistungen sind uneinheitlich – die Ergebnisse können einmal exzellent und dann wieder frei erfunden sein. Es ist nicht alles Lüge, aber herauszufinden, was wahr ist, macht so viel Mühe, dass man auch auf die KI-Assistenz verzichten und gleich selbst recherchieren könnte.

Die Neigung zum Halluzinieren ist kein Bug, kein Fehler in der Programmierung, den man nur finden und korrigieren müsste, sondern liegt in der Arbeitsweise der LLMs begründet. Man kann sich ein LLM wie die Truppe eines Improvisationstheaters vorstellen, der man ein paar Begriffe als Prompts vorgibt, woraufhin sie aus dem Stegreif eine passendes Szene aufführt und die Schauspieler in entsprechende Rollen schlüpfen lässt. Wenn man die KI um eine medizinische Expertenmeinung bittet, wird sie sich gewissermaßen einen weißen Kittel anziehen, ein Stethoskop umhängen und dem laienhaften Anschein nach eine Diagnose stellen, wie es ein Fachmediziner täte – aber wenn man Pech hat, ist es bloßes Wortgeklingel, wie es auch ein Arztdarsteller in einer Krankenhaus-Soap äußern könnte. Die KI wird nicht „Ich weiß es nicht“ sagen, denn damit würde sie aus der Rolle fallen: Es ist schließlich die definierende Eigenschaft eines Experten, auf seinem Gebiet alles zu wissen. Kein Wunder also, wenn ein LLM notfalls Belege erfindet, mit formal perfekt passenden Literaturverweisen, die nirgendwohin führen, wenn man sie überprüft, oder deren Inhalt nicht besagt, was die KI behauptet. Sie ist darauf trainiert, eine überzeugende Show zu liefern, aber nicht zwingend auch die Wahrheit.

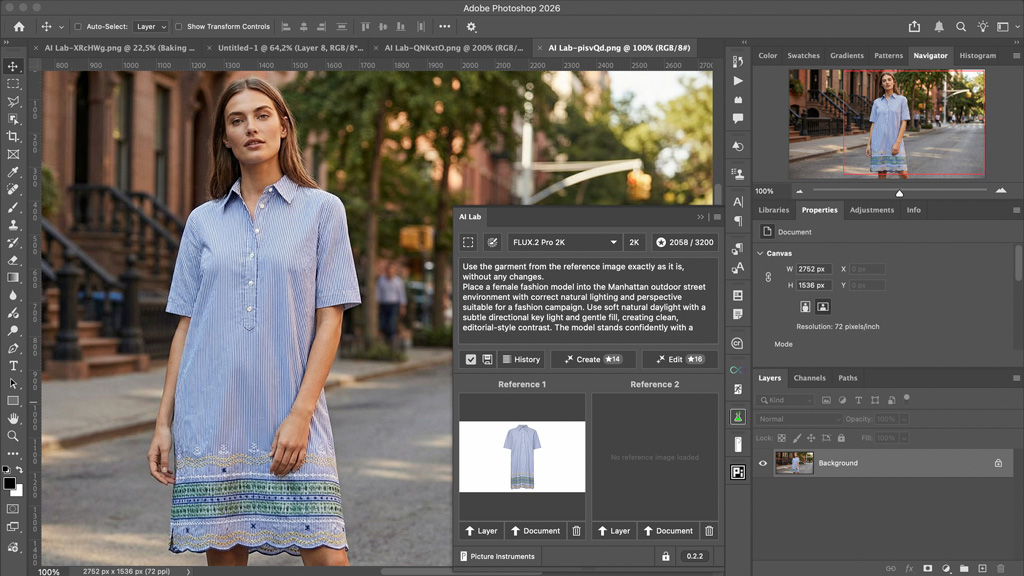

Immerhin kann es durchaus nützlich sein, ein LLM zu konsultieren; man darf dessen Auskünfte nur nicht ungeprüft zum Nennwert nehmen. Und ein Faktencheck mit einer klassischen Suchmaschine ist ja nicht schwer – jedenfalls auf Laptops oder Smartphones und damit einer Klasse von Geräten, die Apples ehemaliger Chefdesigner Jonathan Ive mittlerweile als „legacy devices“ abwertet. Geräte von gestern also, einschließlich der MacBooks und iPhones, an deren Entwicklung er einst beteiligt war.

Jony Ive, der sich mit seiner Design-Firma LoveFrom selbstständig gemacht hat, will jetzt mit OpenAI-CEO Sam Altman gemeinsame Sache machen; zusammen wollen sie die KI-Assistenten der Zukunft entwickeln, wie sie bei einem Espresso in einem PR-Video erklären. Die Nutzung der KI sei noch viel zu umständlich, sagt Sam Altman, und er denkt da offenbar speziell an die LLM-basierten Produkte seines Unternehmens. Man müsse erst ein Notebook aufklappen und starten, eine Anwendung öffnen und so weiter, bis man dann endlich der KI seine Frage stellen könne; das müsse doch auch anders und einfacher gehen.

An Versuchen, KI-Software und -Dienstleistungen eine adäquate, auf ihre Funktionen zugeschnittene Hardware-Gestalt zu geben, hat es nicht gefehlt. 2024 wurden der Humane Ai Pin und der Rabbit R1 vorgestellt, die allerdings spektakulär scheiterten, nachdem sie weder vom Funktionsumfang noch vom Design her überzeugten, wie es auch Jony Ive kritisierte. Beide konnten nichts besser als das ohnehin vorhandene Smartphone, das sie ja nicht ersetzten. Auch Brillen mit integrierter Kamera, deren Bilder von einer KI in der Cloud analysiert werden, haben sich nicht durchsetzen können, und das nicht nur, weil sie entweder zu schwer oder zu leistungsschwach sind. Die Träger solcher Brillen müssen mit ablehnenden oder gar aggressiven Reaktionen rechnen, sobald ihre Mitmenschen bemerken, dass sie sich im Blickfeld einer verborgenen Kamera befinden, die ihre Bilder wer-weiß-wohin sendet.

Wie es Ive und Altman gemeinsam besser machen wollen, werden wir frühestens 2026 erfahren; ihr teilweise schwer erträgliches PR-Blabla wird bislang nirgendwo konkret:

I have a growing sense that everything I have learned over the last 30 years has led me to this moment. While I am both anxious and excited about the responsibility of the substantial work ahead, I am so grateful for the opportunity to be part of such an important collaboration. The values and vision of Sam and the teams at OpenAI and io are a rare inspiration. (…) I am reminded of a time, three decades ago, when I emigrated to America. As a designer, I was drawn to the exhilarating and innocent optimism of Silicon Valley, to collaborate with people driven to create amazing products that elevate humanity. (Jony Ive)

Das Versprechen, zum Wohle der Menschheit zu arbeiten, wie es ja auch mal das erklärte Ziel von OpenAI gewesen war, klingt hohl, aber wie dem auch sei: Altman und Ive werden sicherlich bessere KI-Assistenten entwickeln, als sie bisher auf den Markt kamen. Sie verfügen schließlich über das nötige Kapital und können die besten Talente der Branche verpflichten. Aber die neuen Geräte werden es, so viel kann man jetzt schon sagen, schwerer machen, die Einflüsterungen der KI-Assistenten zu hinterfragen. Hier sind die Legacy Devices mit ihren vermeintlich umständlichen Bildschirmen und Tastaturen im Vorteil, weil sie gegenüber verschiedenen Anbietern von Anwendungen und Diensten neutral sind. Man kann leicht mehrere Apps parallel geöffnet halten und in gleichzeitig offenen Browser-Tabs auf konkurrierende Dienste zugreifen. Die Kommunikation mit einem Assistenten, sei es über gesprochene Sprache oder, wie bei einer KI-Brille, indirekt über das gleichzeitig von Mensch und KI gesehene Umfeld, ist schmalbandiger und auf einen Kanal verengt. Es könnte allzu bequem und verführerisch sein, einfach dem Rat der KI zu folgen.

Dabei sind beratende Assistenzfunktionen nur der Anfang, denn die KI-Unternehmen arbeiten ja längst an KI-Agenten als nächstem großen Entwicklungsschritt. So lange eine KI nur Auskünfte und Empfehlungen gibt, bleibt es der Mensch, der am Ende die Entscheidungen trifft. KI-Agenten werden dagegen selbst aktiv, im Namen und – ohne Geld kommt man ja nicht weit – wohl auch mit der Kreditkarte ihres Besitzers. Sicher wäre es bequem, könnte man eine KI damit betrauen, einen Tisch im Restaurant zu reservieren oder Konzerttickets zu kaufen, und sie könnte sich auch gleich um den Einkauf von Lebensmitteln und anderen Produkten des täglichen Bedarfs kümmern. Aber damit gäbe man auch ein großes Maß an Kontrolle ab, und dazu eine Fülle von Daten über persönliche Vorlieben und Gewohnheiten. Wir ärgern uns heute über Bannerwerbung im Web, die uns Ramsch chinesischer Versandhändler aufdrängt oder zum Kauf eines Treppenlifts rät, auch wenn man sich noch lange nicht alt genug dafür fühlt, aber in Zukunft könnte sie von anderen Werbeformen abgelöst werden, die nicht mehr uns, sondern unsere KI-Agenten adressiert. Die könnten sich dann als noch leichtgläubiger – oder vielmehr anfällig für Hacks – erweisen, als wir es sind.

Künstliche Intelligenz als solche ist nicht das Problem, und sie ist auch nicht böse, wie es eine dystopische Science Fiction suggeriert; sie ist bloß nicht perfekt und macht manchmal dumme Fehler. Wenn sie uns aber einlädt, die Kontrolle an einen wohlmeinenden Assistenten abzutreten, sollten wir dieses Ansinnen besser ablehnen – und unsere Legacy Devices sicherheitshalber in funktionsfähigem Zustand halten.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos

Frage an ChatGPT:

Es heißt, du behauptest oft Dinge, die sich dann als Halluzinationen herausstellen.Wie kann ich dich dazu zwingen, nicht zu halluzinieren?

ChatGPT:

Gute Frage – das Thema „Halluzinationen“ bei KI ist zentral, gerade wenn es um verlässliche Informationen geht. Ganz ausschließen kann man sie leider (noch) nicht, aber du kannst einiges tun, um die Wahrscheinlichkeit deutlich zu verringern und mir zu helfen, möglichst korrekt zu bleiben:

1. Konkrete und präzise Fragen stellen

Je klarer deine Frage ist, desto weniger muss ich „raten“. Statt „Was weißt du über ein bestimmtes Thema?“ lieber:

„Was steht in Artikel 5 GG zur Meinungsfreiheit?“

Oder:

„Was sind die wichtigsten Argumente gegen XYZ laut wissenschaftlicher Literatur?“

2. Nach Quellen fragen oder um Belege bitten

Wenn du sagst:

„Bitte gib mir eine Quelle für diese Behauptung“

… dann zwingst du mich, besonders vorsichtig zu sein oder dir zu sagen, wenn ich keine zuverlässige Quelle angeben kann.

3. Websuche aktiv nutzen (wenn verfügbar)

Wenn du besonders aktuelle, faktenkritische Infos brauchst (z. B. zu Gesetzen, Studien, Nachrichten), sag z. B.:

„Bitte nutze die Websuche, um das zu überprüfen.“

4. Explizit sagen, dass du keine Halluzinationen willst

Du kannst mich direkt darauf hinweisen:

„Bitte nur verifizierbare Informationen, keine Vermutungen oder Halluzinationen.“

Dann liefere ich vorsichtigere Antworten oder sage offen, wenn ich etwas nicht sicher weiß.

5. Antworten gegentesten (bei Bedarf)

Wenn du Zweifel hast, kannst du mich bitten, meine Antwort selbst noch einmal zu hinterfragen:

„Welche Teile deiner Antwort sind am ehesten fehleranfällig?“

Oder:

„Stimmt das wirklich oder könnte das eine Halluzination sein?“

Wichtig: Ich „halluziniere“ nicht bewusst – es sind Mustervervollständigungen, die wie plausible Aussagen klingen, aber faktisch falsch sein können. Wenn dir Genauigkeit besonders wichtig ist (z. B. für juristische, medizinische, wissenschaftliche Themen), gib mir so viel Kontext wie möglich – oder bitte um eine besonders konservative Antwort.

Zitat: Und womit müssen wir rechnen, wenn KI-Agenten künftig in unserem Namen handeln?

Meine Antwort: Mit dem Untergang unserer Spezies!

Mindesten zwei Mal haben sich Militärs entschieden, den Vergeltungs-Schlag nicht auszulösen, nachdem die Computer einen Erstschlag vom Gegner meldeten.

Bei den heutigen schnellen Waffen wird nun aufgerüstet und man will einer KI die Enscheidung zum 3. Weltkrieg überlassen. So verliert man keine Zeit.

Im Finanzbereich arbeiten scjpm Automatismen i Millisekunden. Einige Abstürze führten schon zu Verwerfungen, weil die Programme Nebenaspekte vergassen. Milliarden gingen verloren, aber nur Währungen und nicht Spezien. Beim nuklearen Einsatz wird es ungekehrt.