Die Perfektionierung KI-basierter Manipulationen markiert für professionelle Fotografen und Bildbearbeiter, deren Reputation untrennbar mit der Authentizität ihrer Arbeiten verbunden ist, einen kritischen Wendepunkt. Bei Deepfakes geht es längst nicht mehr nur um technische Spielereien, sondern um die Integrität des Visuellen an sich. Die Fähigkeit, synthetische Medien zu erkennen und die eigenen Werke vor unautorisierter Veränderung zu schützen, wird zur Kernkompetenz. Dieser Beitrag analysiert den Stand der Technik, effektive Verifikationsmethoden und die relevanten rechtlichen Rahmenbedingungen, um Profis für die Herausforderungen von heute und morgen zu wappnen.

Die neue Bildwirklichkeit: KI als Schöpfer und Fälscher

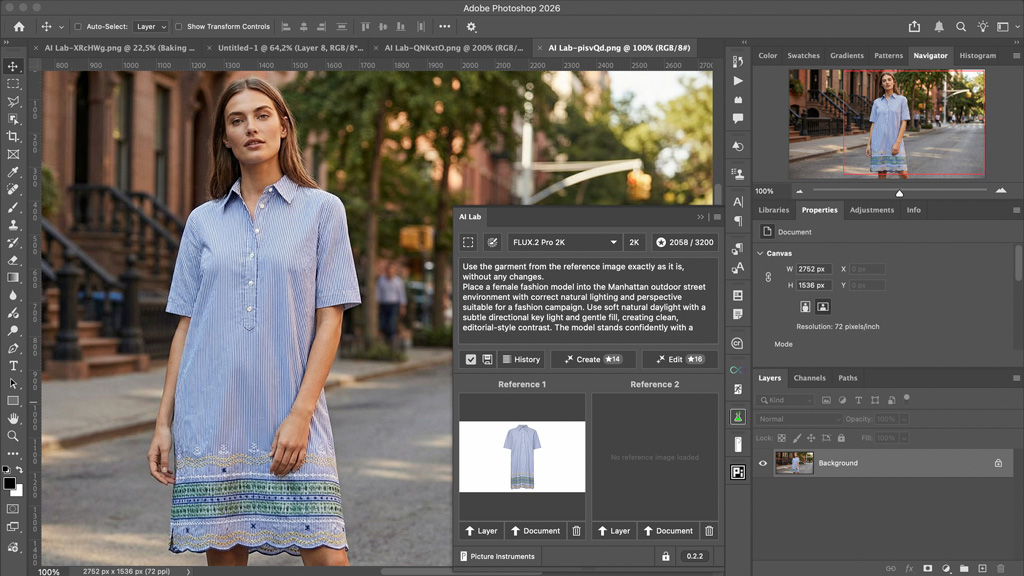

Fortschritte, insbesondere im Bereich der Generative Adversarial Networks (GANs), haben die Generierung täuschend echter Bilder und Videosequenzen auf ein Niveau gehoben, das selbst geschulte Augen vor immense Herausforderungen stellt. Die Werkzeuge zur Anfertigung solcher Inhalte werden nicht nur leistungsfähiger, sondern auch breiter verfügbar. Mimik, Gestik, sogar Stimmprofile lassen sich mit beängstigender Präzision nachbilden. Für Bildschaffende ergibt sich daraus eine ambivalente Situation: Einerseits eröffnen KI-Systeme neue Horizonte für kreative Prozesse, andererseits potenziert sich das Risiko des Missbrauchs durch unerkannte Manipulationen – mit potenziell gravierenden Folgen für Reputation und Vertrauen. Die New York Times hat unlängst die technologischen Fortschritte und die damit einhergehenden gesellschaftlichen Debatten um Meinungsfreiheit und notwendige Regulation beleuchtet.

Diese Entwicklung zwingt professionelle Fotografen und Bildbearbeiter, ihre etablierten Workflows zur Qualitätssicherung und Echtheitsprüfung kritisch zu hinterfragen und anzupassen. Es gilt, die Authentizität des Ursprungsmaterials zu gewährleisten, bevor es publiziert oder an Kunden weitergegeben wird, und die eigenen Werke vor nachträglicher, unbemerkter Verfälschung zu schützen.

Instrumente der Verifikation: Dem Fake auf der Spur

Angesichts der fortschreitenden Qualität von Deepfakes sind robuste Detektionsverfahren unerlässlich. Auch hier spielt künstliche Intelligenz eine Schlüsselrolle, indem sie Algorithmen bereitstellt, die subtile Inkonsistenzen, digitale Artefakte oder unnatürliche Muster in Bild- und Videodaten aufspüren – Indizien, die auf eine Manipulation hindeuten können.

Gängige Detektionswerkzeuge unterstützen inzwischen sowohl Standbildformate, was für Fotografen von fundamentaler Bedeutung ist. Auch Videoformate werden von einer großen Mehrheit der Systeme analysiert. Deutlich seltener finden sich direkte Browser-Integrationen oder kostenfreie Basisversionen der Werkzeuge, was verdeutlicht, dass spezialisierte Profi-Lösungen oft mit Investitionen verbunden sind.

Zu den namhaften Anbietern im europäischen Raum zählen beispielsweise OpenAI mit seinem Deepfake Detector, Hive AI, Sumsub, Oz Liveness, Sensity AI und Microsoft mit dem Video Authenticator. Thales hat mit cortAIx ein leistungsfähiges Metamodell vorgestellt, und X-PHY wirbt mit Echtzeit-Erkennung durch multimodale KI. Für eine schnelle Überprüfung direkt im Browser könnten Lösungen wie CounterSocial oder die in Großbritannien entwickelte Erweiterung DeepfakeProof von Interesse sein. Diese Werkzeuge kombinieren neuronale Netze, forensische Analysemethoden und die Auswertung von Metadaten, um Fälschungen zu identifizieren.

Rechtliche Leitplanken: Der regulatorische Umgang mit synthetischen Medien

Die Besorgnis über die missbräuchliche Verwendung von Deepfakes hat den Gesetzgeber alarmiert. Im deutschsprachigen Raum ist hier insbesondere der EU AI Act von zentraler Bedeutung. Seit August 2024 in Kraft, soll er bis August 2025 vollständig zur Anwendung gelangen und sieht unter anderem strenge Transparenzpflichten für KI-generierte Inhalte vor. Deepfakes müssen demnach klar als solche ausgewiesen werden, um eine Täuschung der Betrachter zu verhindern. Bestimmte KI-Anwendungen, die als hochriskant eingestuft werden, unterliegen noch strengeren Auflagen oder können gänzlich untersagt werden. Diese Regulierungen werden die Arbeitsweise von Fotografen, Bildagenturen und Medienhäusern nachhaltig beeinflussen, da sie eine sorgfältige Prüfung und Kennzeichnung von Inhalten unumgänglich machen.

Ein dynamisches Wettrüsten: Die Evolution von Fälschung und Detektion

Der Kampf gegen Deepfakes ist ein permanentes Katz-und-Maus-Spiel: Kaum sind neue Detektionsmethoden etabliert, arbeiten Entwickler von Fälschungssoftware bereits an Wegen, diese zu umgehen. Die Entwicklung verlief in den letzten Jahren rasant: Während die Generierungstechniken, ausgehend von frühen GAN-Experimenten, über die Demokratisierung entsprechender Werkzeuge bis hin zur Anfertigung hochauflösender, kaum von der Realität unterscheidbarer synthetischer Medien fortschritten, zogen auch die Detektionsmethoden nach. Die Palette reicht hier von zunächst einfacheren KI-basierten Analysetools über Ansätze zur Blockchain-Verifizierung der Authentizität digitaler Assets und die Auswertung von Metadaten bis hin zu komplexen multimodalen KI-Systemen und flankierenden regulatorischen Eingriffen wie dem EU AI Act.

Neben rein technischen Lösungen gewinnen auch Konzepte wie digitale Wasserzeichen und die Etablierung von Herkunftsnachweisen an Bedeutung. Kooperationen zwischen Technologieanbietern, Forschungsinstitutionen und staatlichen Stellen sind dabei von entscheidender Bedeutung, um umfassende und widerstandsfähige Erkennungsrahmen zu schaffen. Die Herausforderung bleibt jedoch, dass sich Deepfake-Technologien oft schneller verfeinern, als robuste Gegenmaßnahmen flächendeckend implementiert werden können.

Fazit

Für professionelle Bildproduzenten bedeutet dies, dass kontinuierliche Weiterbildung und die Bereitschaft zur Adaption neuer Technologien und Prüfverfahren unabdingbar sind. Die Sensibilisierung für die Manipulationsmöglichkeiten und die kritische, informierte Bewertung digitaler Inhalte werden zu Schlüsselqualifikationen in einer zunehmend von künstlicher Intelligenz geprägten Medienlandschaft. Der Einsatz aktueller Detektionswerkzeuge und die Kenntnis der rechtlichen Rahmenbedingungen sind für Profis in der visuellen Kommunikation unerlässlich, um die Authentizität ihrer Arbeit zu gewährleisten und das Vertrauen ihrer Kunden und des Publikums zu sichern.