Adobe Firefly: Neue Funktionen für Video- und Sound-Produktionen

Adobe hat umfassende Erweiterungen für die KI-Plattform „Adobe Firefly“ vorgestellt. Die Neuerungen sollen eine bessere Videoqualität, immersive Audioerlebnisse, mehr kreative Kontrolle sowie einfachere Arbeitsabläufe ermöglichen.

Verbesserte Videomodelle für realistischere Animationen

Das überarbeitete Firefly Video-Modell bietet jetzt eine höhere Bewegungsgenauigkeit, realistischere Animationen und flüssigere Übergänge. Landschaftsaufnahmen können beispielsweise mit sanft gleitenden Nebelschwaden, Regenschauern oder Lichtreflexen bereichert werden. Tierfilme zeigen laut Adobe Bewegungen, die an reale Sprünge, Läufe oder Flügelschläge erinnern. Auch atmosphärische Effekte wie Nebel, Regen oder Lichtspiele sollen sich überzeugender darstellen lassen.

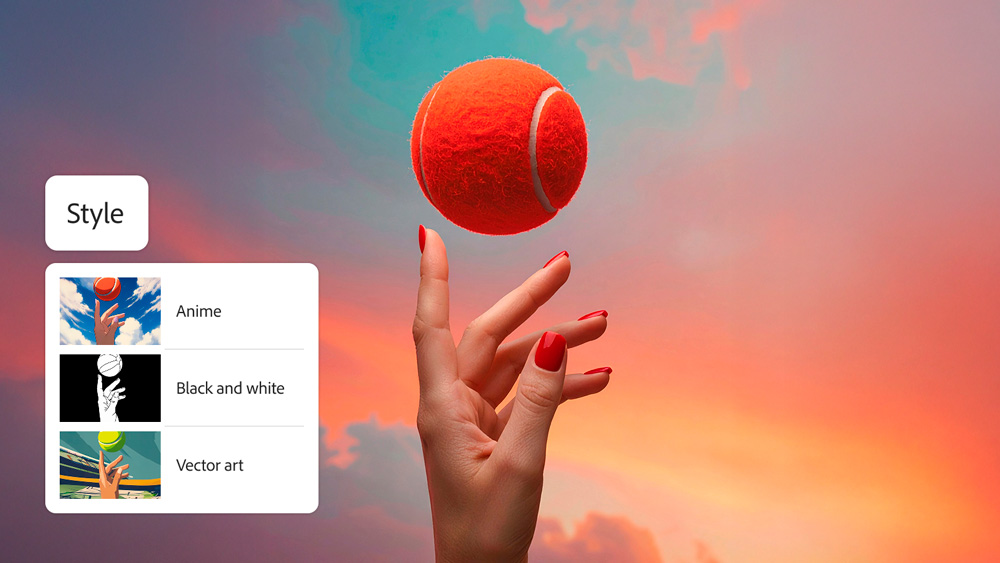

Mehr kreative Kontrolle durch Kompositions- und Stilwerkzeuge

Mit „Style Presets“ lassen sich Videoclips auf Knopfdruck im Stil von „Claymation“, „Anime“, „Line Art“ oder klassischen 2D-Designs gestalten. Beispielsweise wechselt ein Erklärvideo durch wenige Klicks vom Grafik-Look zur gezeichneten Animation.

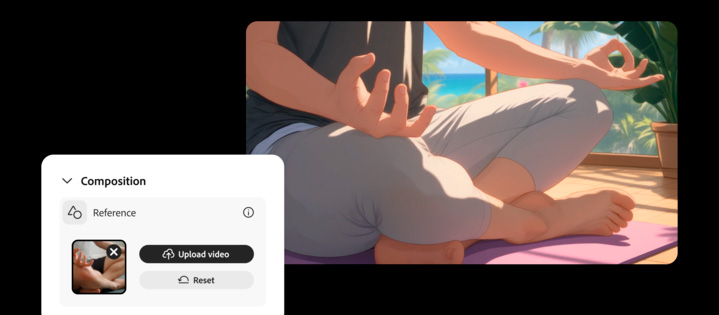

Die Funktion „Composition Reference“ überträgt Kompositionsmerkmale eines Referenzvideos auf neue Inhalte. So bleibt zum Beispiel der Aufbau einer Werbereihe über mehrere Spots hinweg konsistent.

Ein weiteres Werkzeug, „Keyframe Cropping“, erlaubt es, Anfangs- und Endbild vorzugeben. Firefly generiert daraus passgenaue Videosequenzen, praktisch für Storyboards oder Werbetrailer.

Das Seitenverhältnis – egal ob hochkant, quer oder quadratisch – lässt sich flexibel einstellen, ohne das Timeline-Springen oder nachträgliche Bearbeitungen. Formatanpassungen für Social Media, Kino oder Website laufen direkt im Generierungsprozess ab.

Soundeffekte per Text oder Stimme (Beta)

Die neue Beta-Funktion zur Soundeffekt-Erstellung erlaubt es, durch einen Textbefehl wie „Donnergrollen mit aufziehendem Wind“ oder durch Sprechen in das Mikrofon individuelle Sounddesigns zu erzeugen. Di KI erkennt Timing und Intensität der Stimme und legt die Soundkulisse passgenau zur Videosequenz an.

Beispielsweise kann eine Nahaufnahme von Wassertropfen mit punktgenau synchronisierten Platsch-Geräuschen angereichert oder einer Großstadtkulisse mit typischen Hintergrundgeräuschen versehen werden. Die Layer-Funktion erlaubt es, mehrere Sounds übereinanderzulegen – ein typisches Szenario für Podcasts oder Social-Media-Videos.

Text zu Avatar (Beta)

Mit der Beta-Funktion „Text zu Avatar“ wandelt Firefly Drehbücher oder Anleitungen direkt in avatarbasierte Videos um. Nutzer wählen aus einer Bibliothek digitaler Avatare, bestimmen Hintergrund und Sprechstil und fügen ihr Skript im Feld „Inhalt“ ein. Das System erstellt automatisch eine Videosequenz, bei der der gewählte Avatar den Text plausibel präsentiert. Die neue Funktion lässt sich etwa für Tutorials, Produktpräsentationen oder Erklärvideos einsetzen.

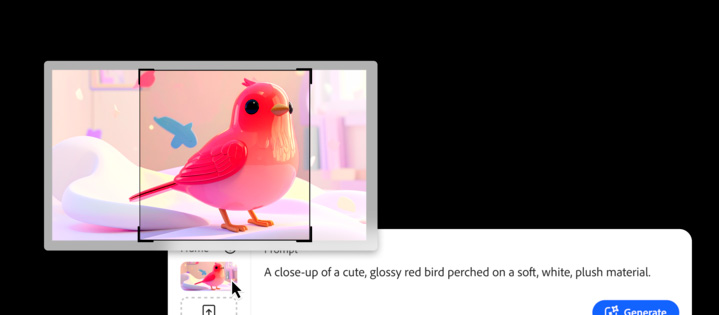

Effizientere Workflows mit „Enhance Prompt“

Die neue Funktion „Enhance Prompt“ ergänzt automatisch kontextrelevante Informationen zu knappen Benutzereingaben. So sollen stimmige, detailreiche Ergebnisse mit weniger Nachbesserungen gelingen. Ein kurzer Prompt wie beispielsweise „Goldene Stunde am See“ führt zu Vorschlägen für Lichtstimmung, Kameraeinstellung und atmosphärische Effekte.

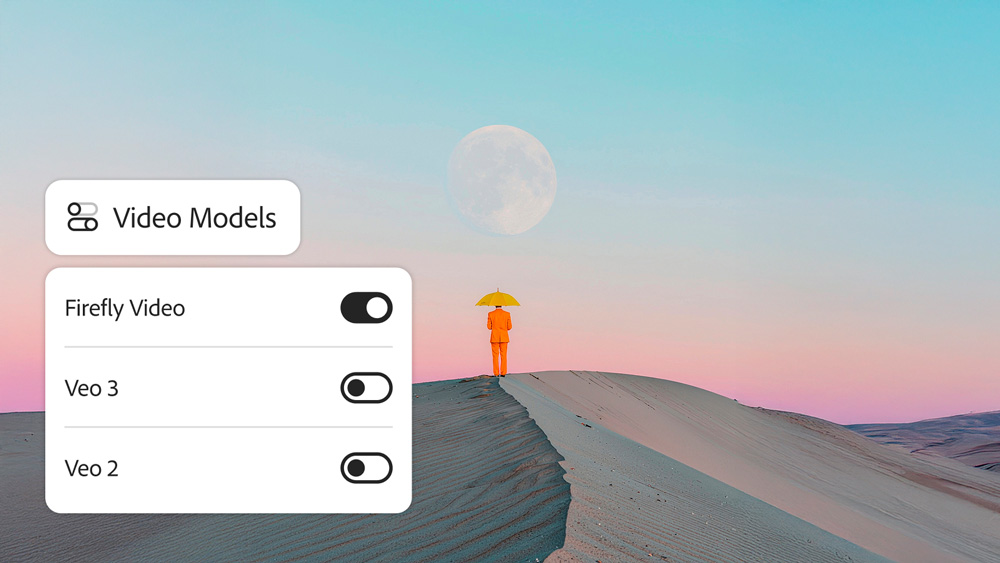

Integration führender KI-Modelle

Adobe setzt weiter auf Offenheit für Drittanbieter-KI:

- „Runway Gen-4 Video“ und „Google Veo3“ (mit Audio) stehen jetzt in Firefly Boards zur Verfügung, letzteres außerdem in Generate Video.

- Die Integration von „Topaz Bild- und Video-Upscaler“ sowie „Marey von Moonvalley“ ist in Vorbereitung.

- „Ray 2“ von Luma AI und „Pika 2.2“ sind bereits in Firefly Boards vorhanden und werden auch für die Videogenerierung verfügbar sein.

Verfügbarkeit

Alle Neuerungen sind ab sofort in der Webanwendung von Adobe Firefly nutzbar. Soundeffekte und Text zu Avatar befinden sich im Beta-Stadium. Tutorials und Best Practices sind im Firefly User Guide integriert. Weitere Informationen finden Sie im Adobe Blog.