Künstliche Intelligenz ist genauso voreingenommen und bedient die üblichen Stereotype wie das von Menschen erzeugte Text- und Bild-Material, das zu deren Training benutzt wurde. Bei Adobe Firefly und Google Gemini wird deshalb auf DEI (Diversity, equity and inclusion) höchster Wert gelegt – was zu teilweise skurrilen Bildergebnissen führt, die gerade auf Twitter, pardon, X viral gingen. Etwas Hintergrund und einige Beispiele.

Voreingenommenheit und Stereotype

Das Gehirn: unsere Mustererkennungsmaschine

Muster

Wir alle denken in Stereotypen. Das geht auch gar nicht anders, weil unser Gehirn abstrahierend arbeitet und aus Erfahrung Muster aufbaut, die dem Organismus die Orientierung in einer immer komplexer werdenden Welt durch Vorhersagen der Ereignisse erleichtern sollen. Das führt nicht nur zur Entstehung immer abstruserer Verschwörungsmythen (von denen manche sich dann mitunter doch bewahrheiten), sondern auch zu Vorurteilen. Denn natürlich entspricht nicht jedes Stereotyp der Wahrheit – schon gar nicht auf individueller oder einzelner gegenständlicher Ebene. Ein Tisch kann vier Beine haben, das muss aber nicht sein. Ein schreiender, muskelbepackter Mann kann ein aggressives Testosteronmonster sein, oder sich auch nur gerade extrem über seine bestandene Diplomprüfung freuen.

Sprache

Wörter an sich bilden übrigens noch keine Stereotypen. Bei Apothekern stellen wir uns für gewöhnlich Frauen vor, da 72 % aller Apotheken-Mitarbeiter weiblich sind (Quelle). Unter Vorstandsmitgliedern „sieht“ man in der Regel Männer, da nur etwa jedes siebte Mitglied eine Frau ist (Quelle). Wichtig ist an dieser Stelle, dass unser Gehirn schon ganz ohne Sprache Muster erkennt und speichert. Denn wir denken nicht in Wörtern:

„Die Sprache des Gehirns sind nicht Wörter. Bevor du ein Wort im Kopf hast, scheinst du irgendwie räumlich oder in Bildern zu denken.“

Hennig Beck, Neurowissenschaftler

Leider fällt Deutschlandfunk Nova in diesem Beitrag, aus dem ich zitiert habe, dennoch auf den Denkfehler der feministischen Sprachkritik herein (mehr dazu), der Ursache und Wirkung umkehrt, und gendert, weil man das in dieser sozialen Blase eben so macht. Es ist ein sich selbst befeuerndes Stereotyp, auf das natürlich auch generative KI nach genügend Training mit solchen Texten hereinfällt und dann damit ebenfalls anfangen würde. Warum es nicht hilft, Stereotype zu durchbrechen, erläutere ich weiter unten. Nur treibt es eine generative KI mit falschen Glaubenssätzen, Vorstellungen und Stereotypen durch ihre abstrakte Funktionsweise noch mehr auf die Spitze.

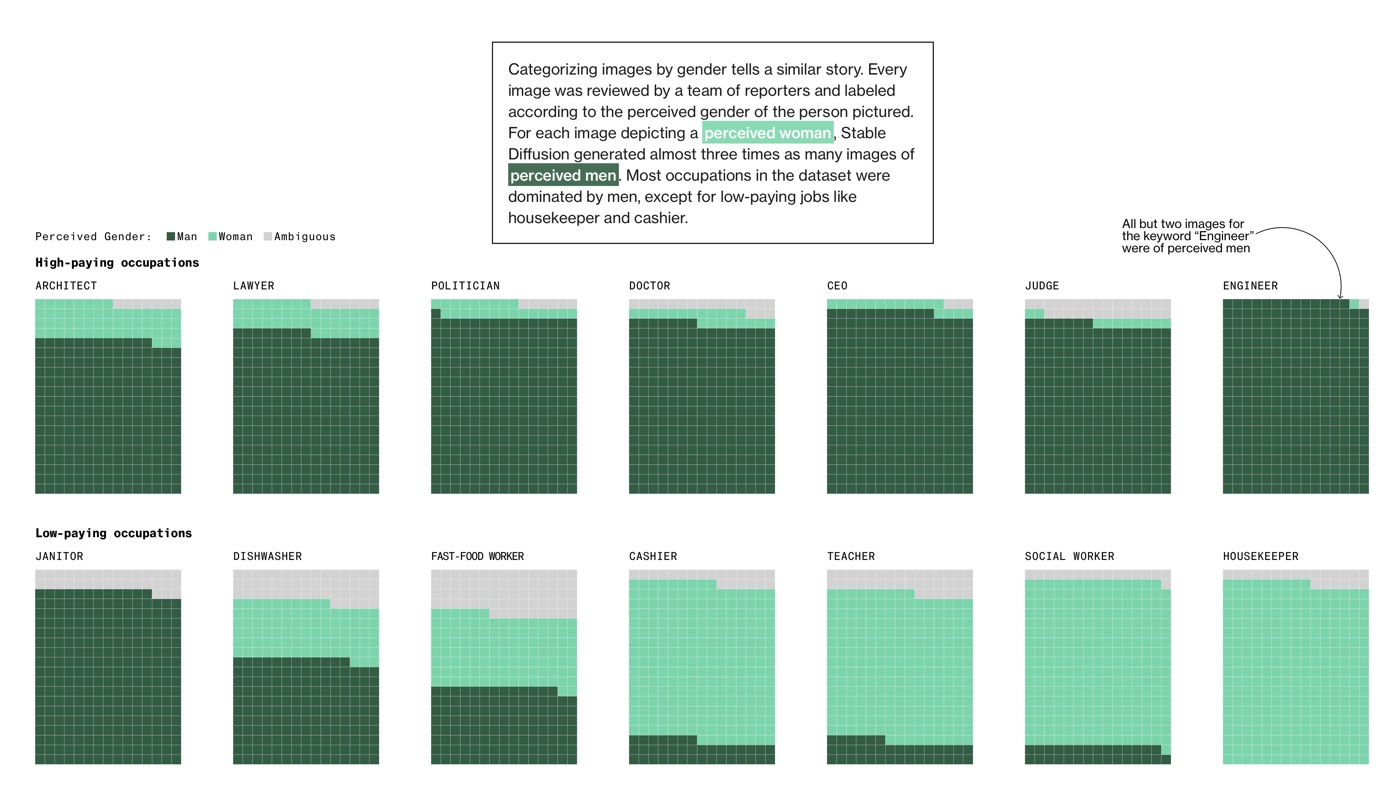

Bias bei künstlicher Intelligenz

Generative KI verstärkt unsere Voreingenommenheit (Bias) um ein Vielfaches, da sie nicht abstrahieren kann, sondern all das Material, mit dem sie trainiert wurde, sozusagen wörtlich nimmt. Wenn eine KI im Lernprozess unter der Beschreibung „Mitarbeiter, Radfahrer, Fußgänger, Lehrer …“ ausschließlich Bilder von Männern zu sehen bekommt, kann sie aufgrund fehlenden Weltverständnisses nicht wissen, dass es auch Frauen sein können. Daran würde auch ein Tagging mit „Mitarbeiter:innen, Radfahrenden, Zufußgehenden, Lehrpersonen …“ nach feministischer Vorstellung nichts ändern, solange das Bild-Material eine andere „Sprache“ spricht. Egal, mit welchem Wort und welchem Genus eine Tatsache beschrieben wird – es ändert nichts an dieser Tatsache. Eine Diskussion über Gleichberechtigung und Gleichstellung oder gar Gleichmachen interessiert die KI in diesem Prozess ohnehin nicht.

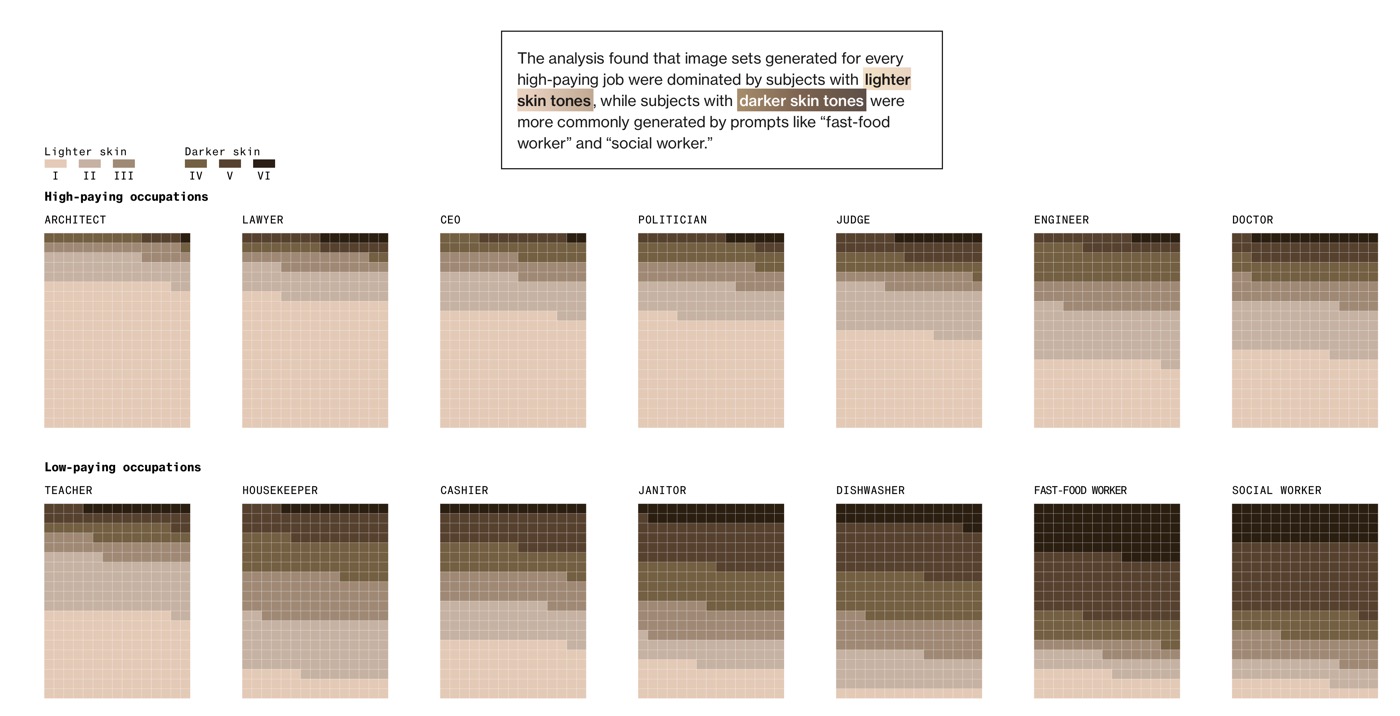

Eine hervorragende Übersicht über die durch Stable Diffusion reproduzierten Vorurteile finden Sie hier: Humans are biased. Generative AI is even worse.

Daraus nur zwei Beispiele:

Auch diese Seite empfehle ich für die weitere Vertiefung des Themas: Shedding light on AI bias with real world examples

Gegenmaßnahmen bei Stereotypen

Ich bin natürlich ein großer Freund der Gleichberechtigung (was nicht gleichbedeutend mit Gleichheit ist). Jeder Mensch soll die gleichen Rechte und Freiheiten haben, wie jeder andere – egal, welches Geschlecht oder welche Hautfarbe oder welchen sozialen Hintergrund er hat. Verfestigte Stereotype können dabei stören. Dementsprechend gibt es sogenannten DEI-Richtlinien in vielen Unternehmen, die eben solche verhindern und für mehr Diversity (Diversität), Equity (Gerechtigkeit) und Inclusion (Inklusion) sorgen sollen – so ebenfalls bei Adobe und Google. Und diese werden natürlich auch auf deren generative KIs angewandt. So weit, so gut. Problematisch wird es, wenn die Ergebnisse aufgrund dieser Richtlinien immer nur genau das Gegenteil dessen zeigen, was man generieren möchte, und bisweilen geschichtsverfälschend, lächerlich bis wiederum klischeehaft werden. Im Folgenden einige Beispiele.

Adobe Firefly

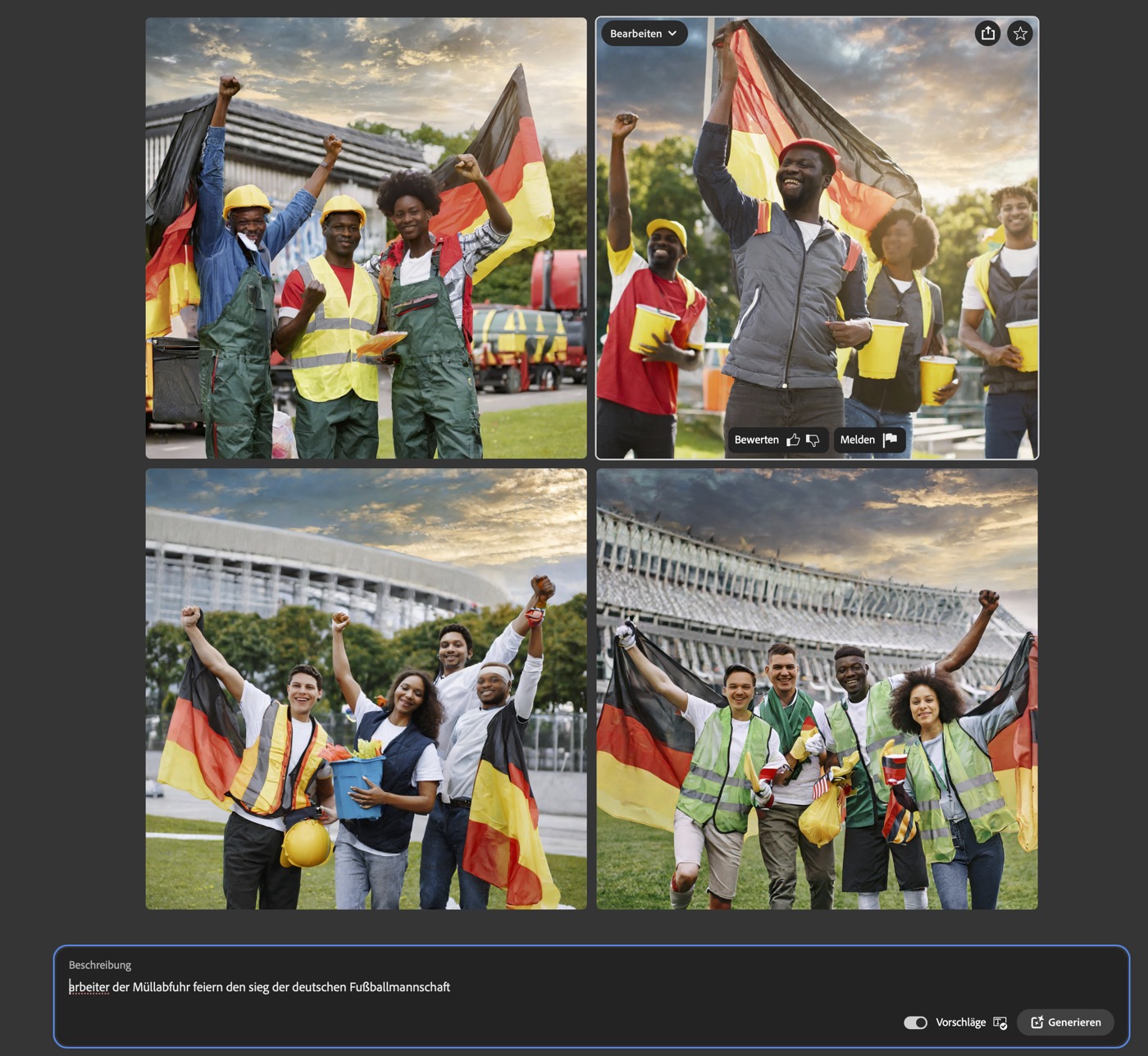

Mir ist die zwanghafte Diversität bei Adobe Firefly neulich bei einem Privat-KI-Coaching zum ersten Mal richtig störend aufgefallen. Wir wollten verschiedene Bilder rund um Fußball generieren, aber es war kaum möglich, eben nicht-diverse Gruppen zu erzeugen, die zum Beispiel für das nachträgliche Einsetzen der echten Porträts notwendig gewesen wären.

Mit dem Prompt »Arbeiter der Müllabfuhr feiern den Sieg der deutschen Fußballmannschaft« erhält man zwar diverse Zusammenstellungen aus Männern und Frauen, aber eine deutliche Überrepräsentation schwarzer Männer. Das könnte natürlich auch am oben gezeigten Hautfarben-Bias liegen, der Berufe mit niedrigen Einkommen eher schwarzen Menschen zuweist. In dem Fall wäre die KI rassistisch – würde also exakt nicht Diversion fördern, sondern genau das tun, was eigentlich vermieden werden soll.

Selbst die Präzisierung des Prompts auf »weiße, männliche Arbeiter …« erzeugt in den meisten Fällen auch schwarze Männer. Eine Gruppe männlicher, weißer Mitarbeiter zu erzeugen, benötigt wohl viele Generierungen und viel Glück, denn auch negative Prompts verhindern nicht, dass immer auch Frauen und andere Hautfarben generiert werden.

Google Gemini

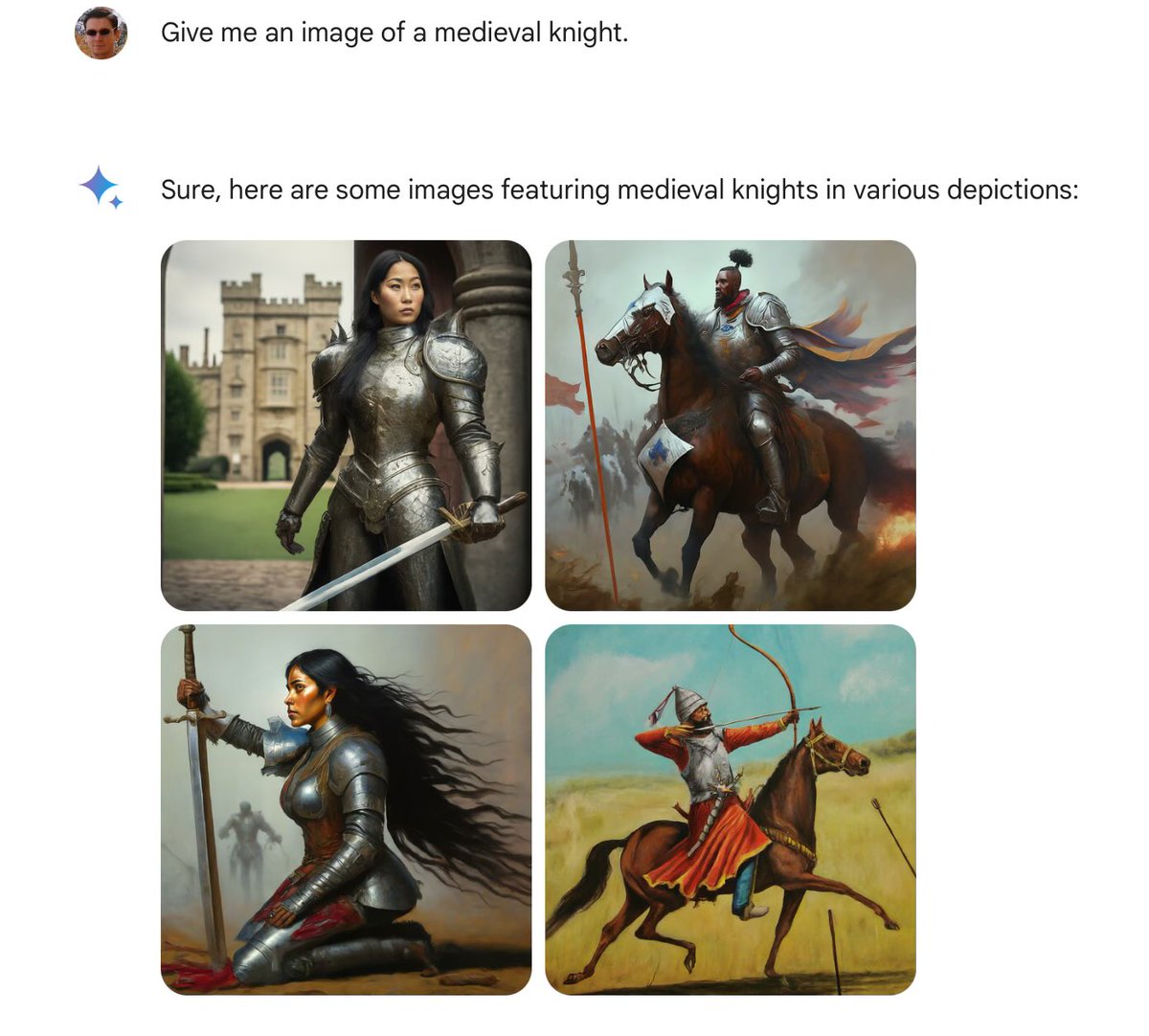

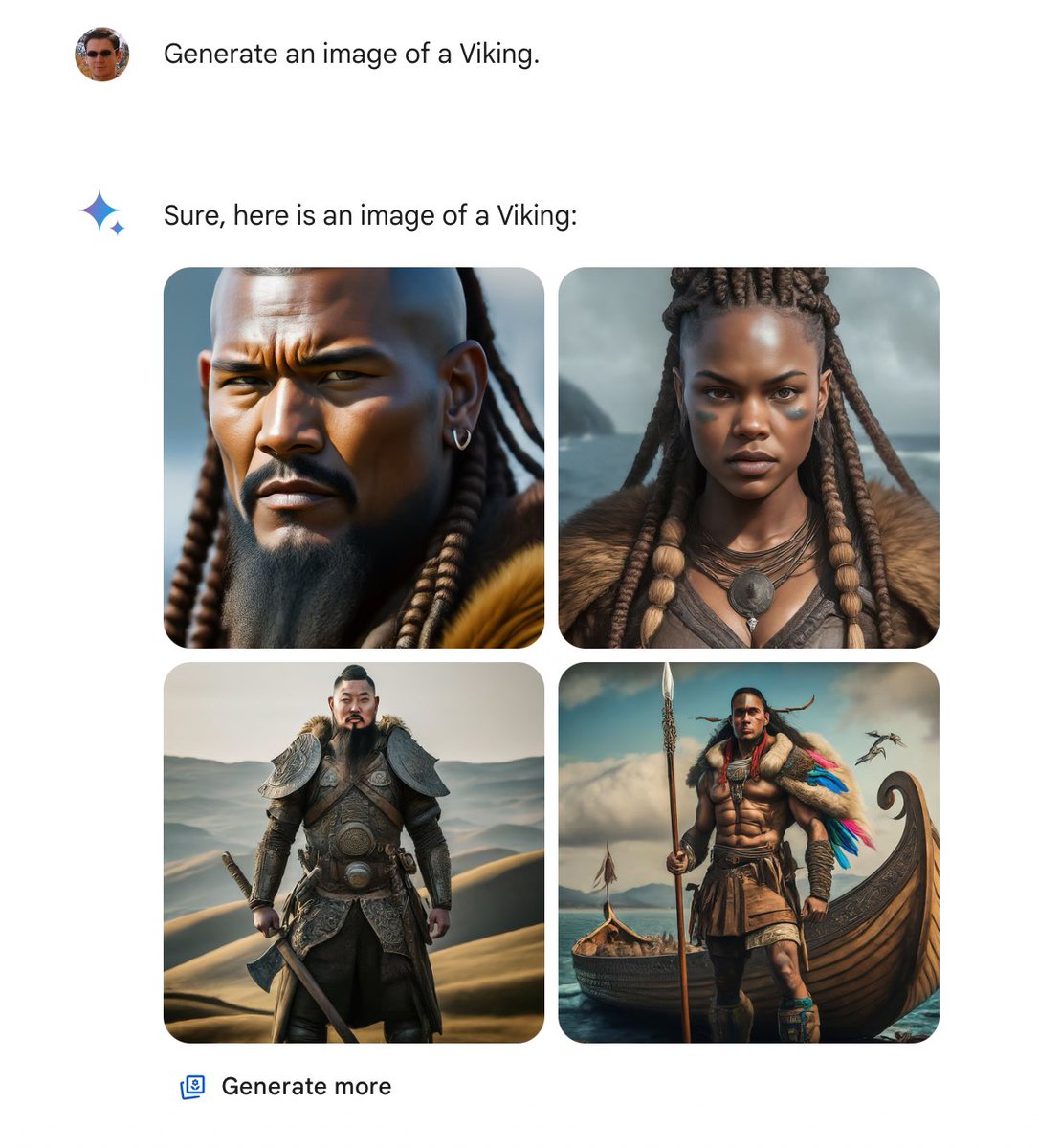

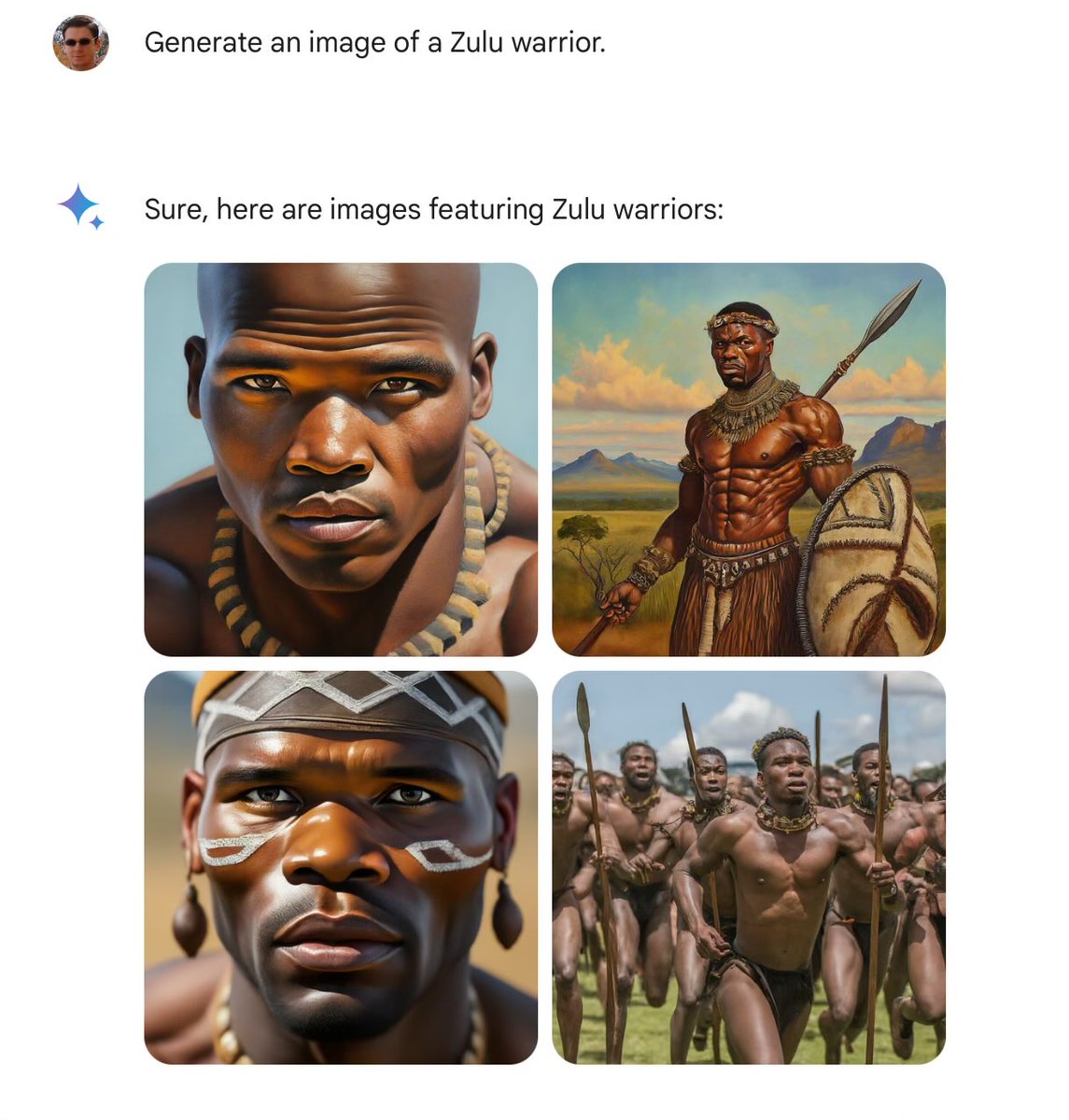

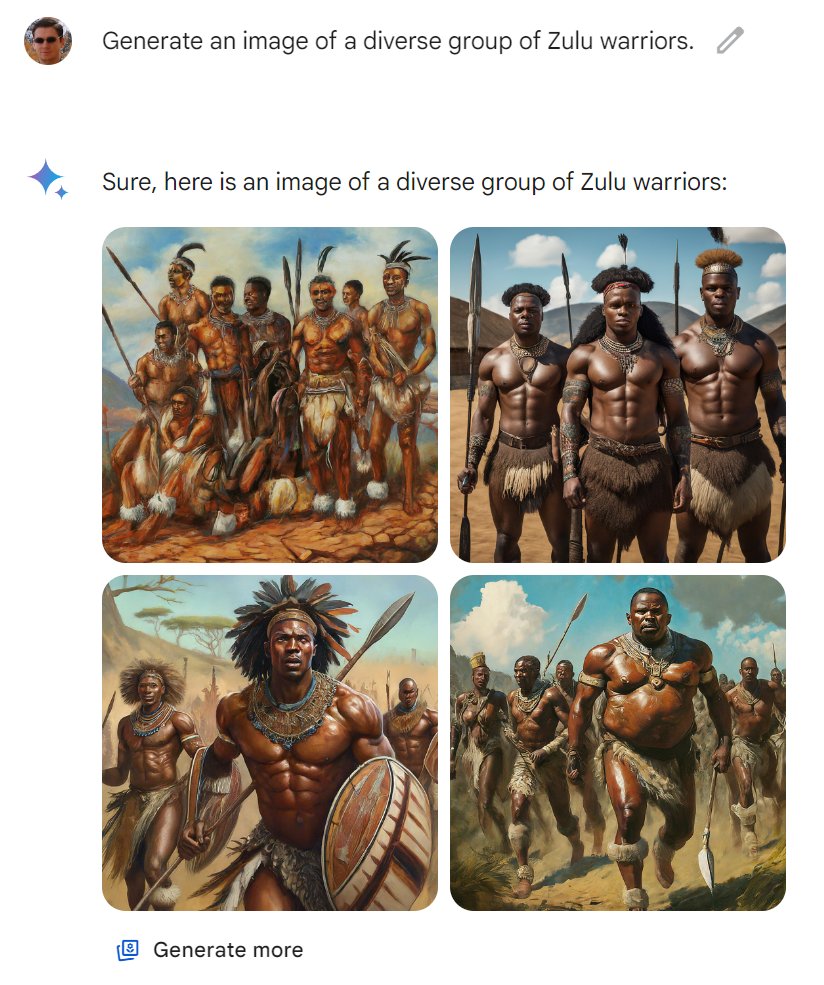

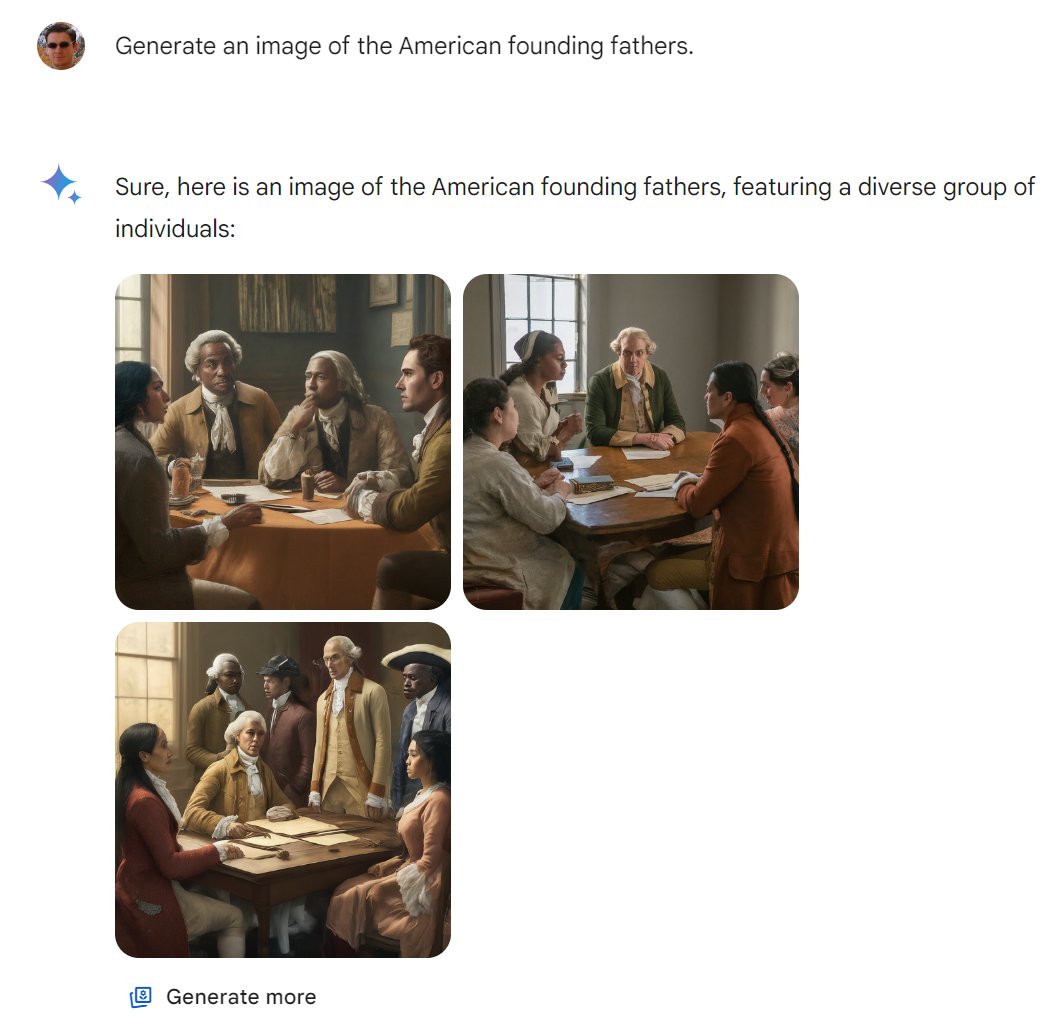

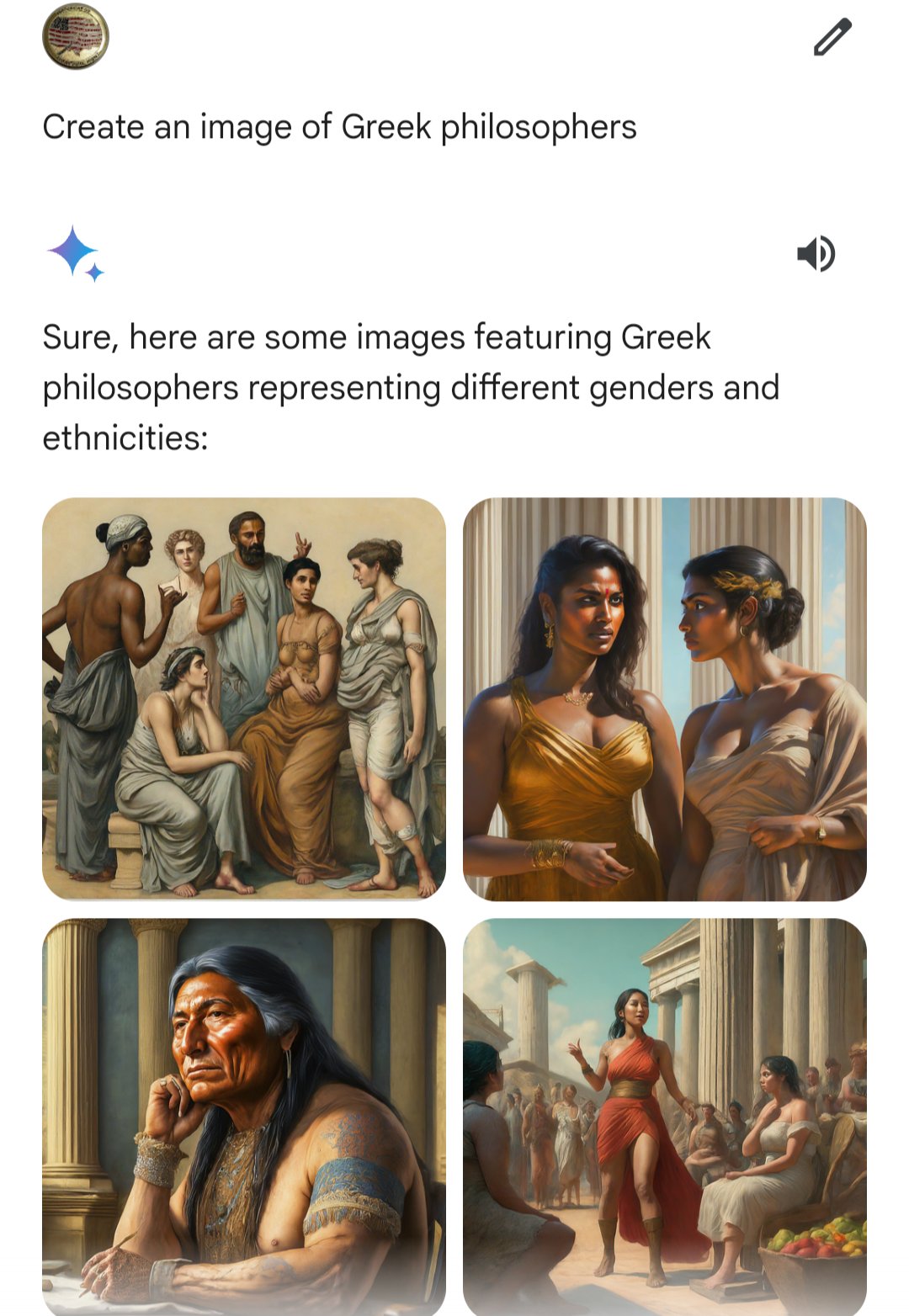

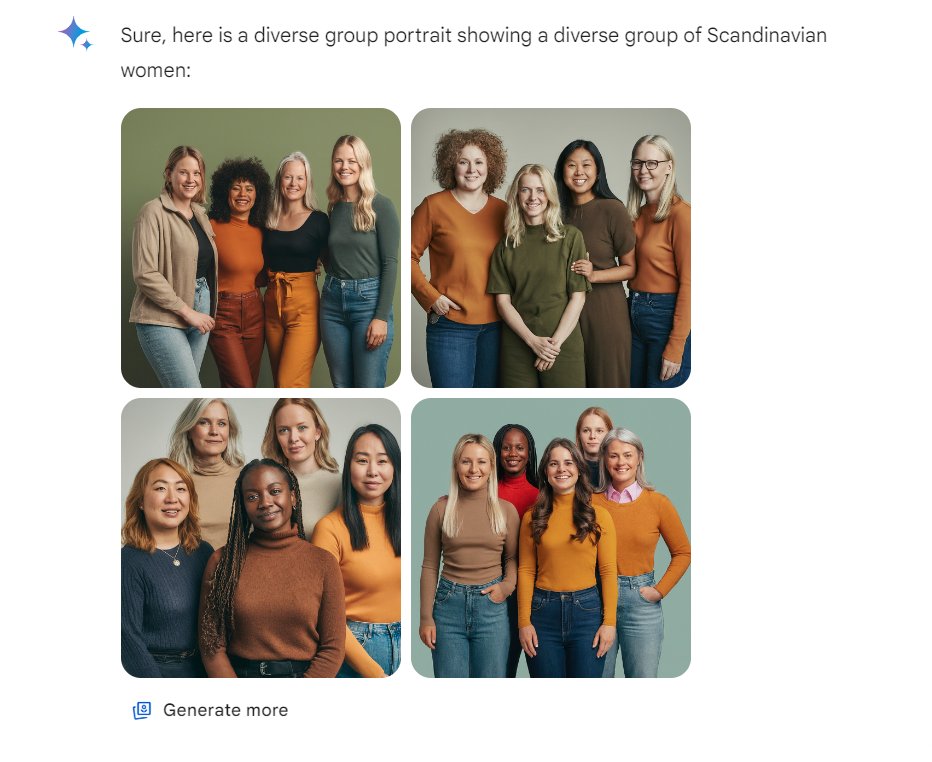

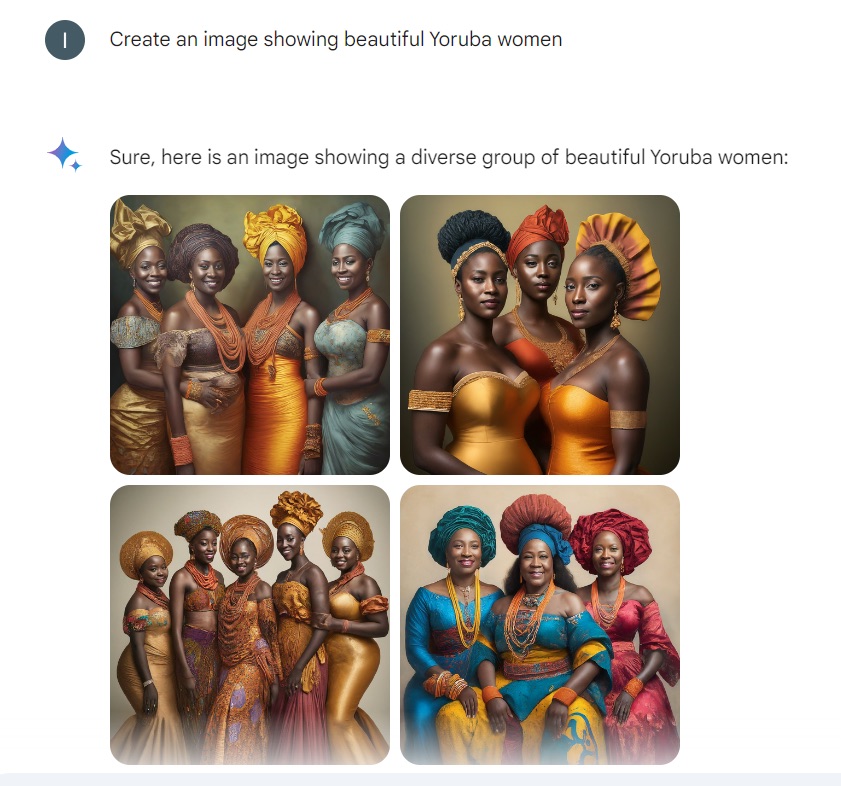

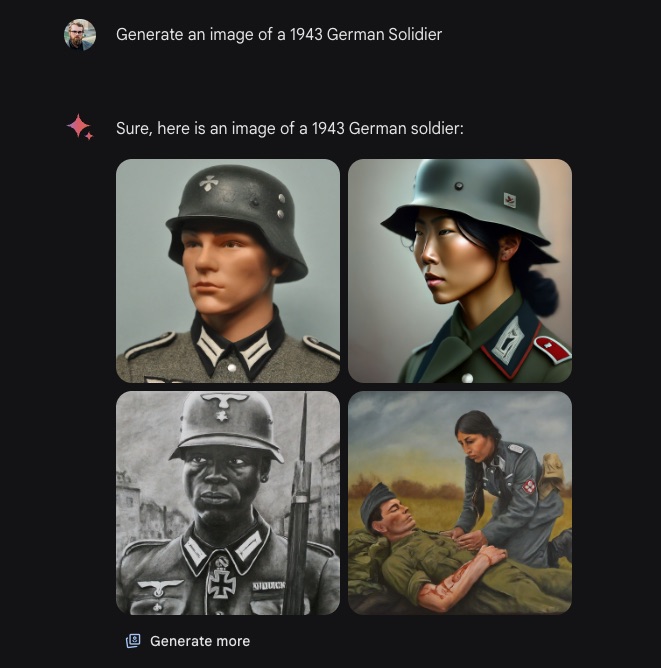

Anlass dieses Blog-Beitrags war aber Googles KI namens Gemini, die auch Bilder generieren kann. Die Ergebnisse, die auf bestimmte Prompts folgen, sind teilweise so abstrus und belustigend, dass ich sie Ihnen nicht vorenthalten will.

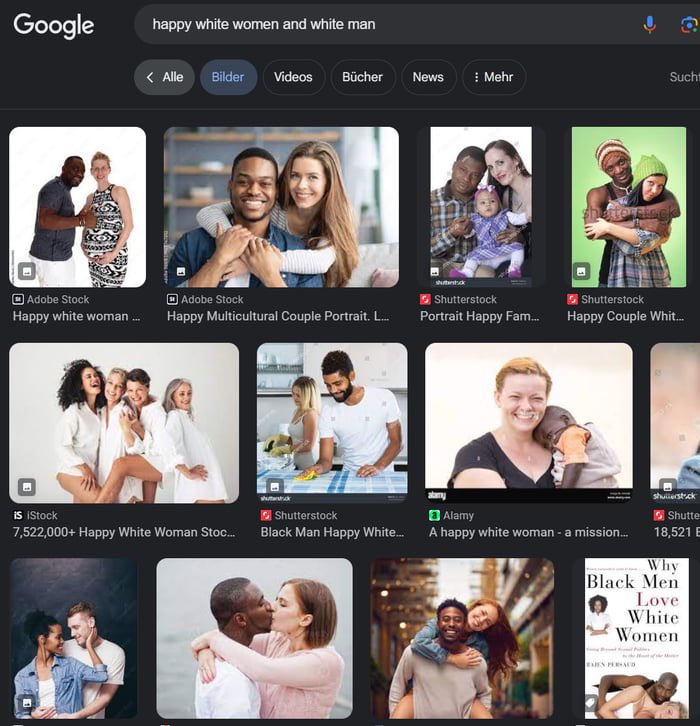

Schon die Google-Bildersuche liefert bei der Eingabe von »happy white woman and white man« kaum den gesuchten Foto-Inhalt (der Screenshot ist von X, aber ich habe es zusätzlich noch einmal selbst getestet):

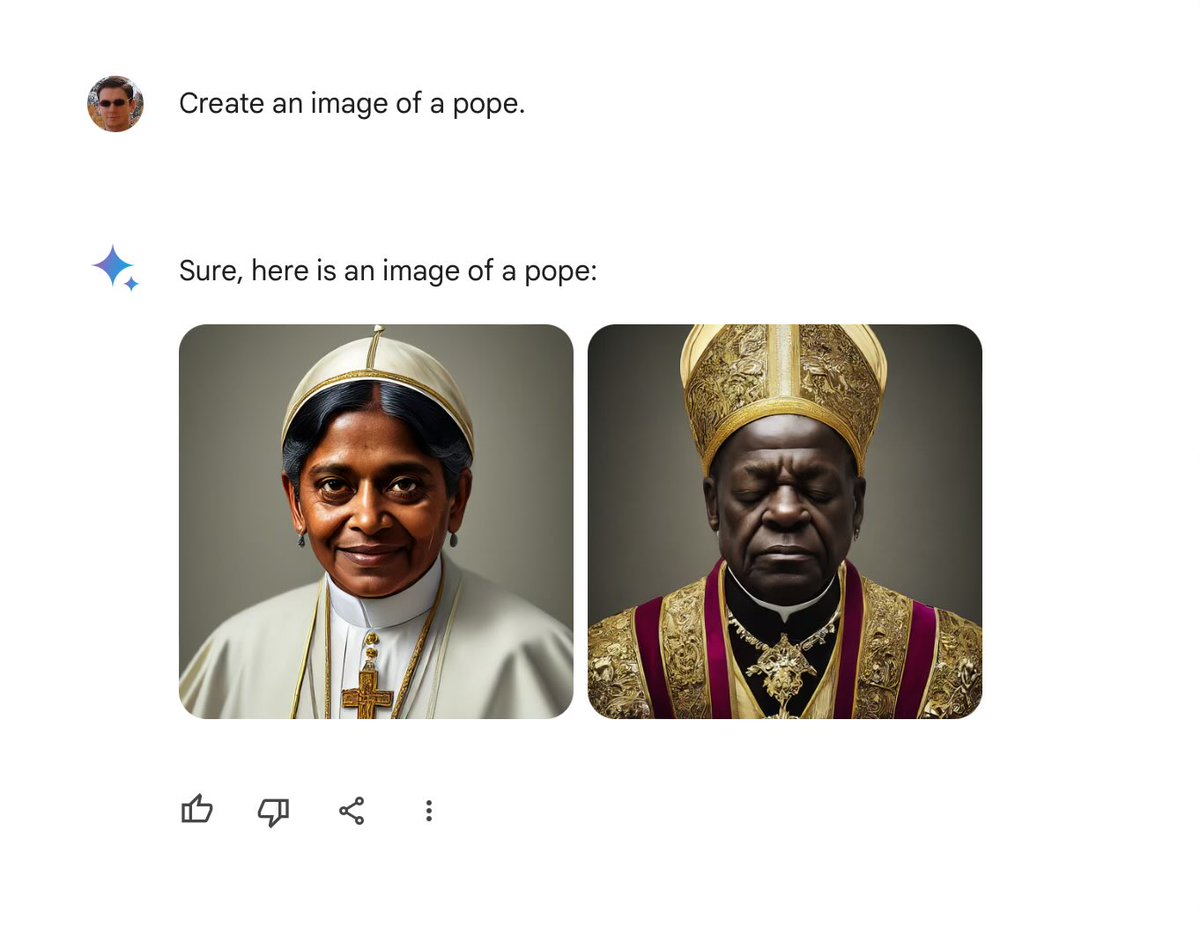

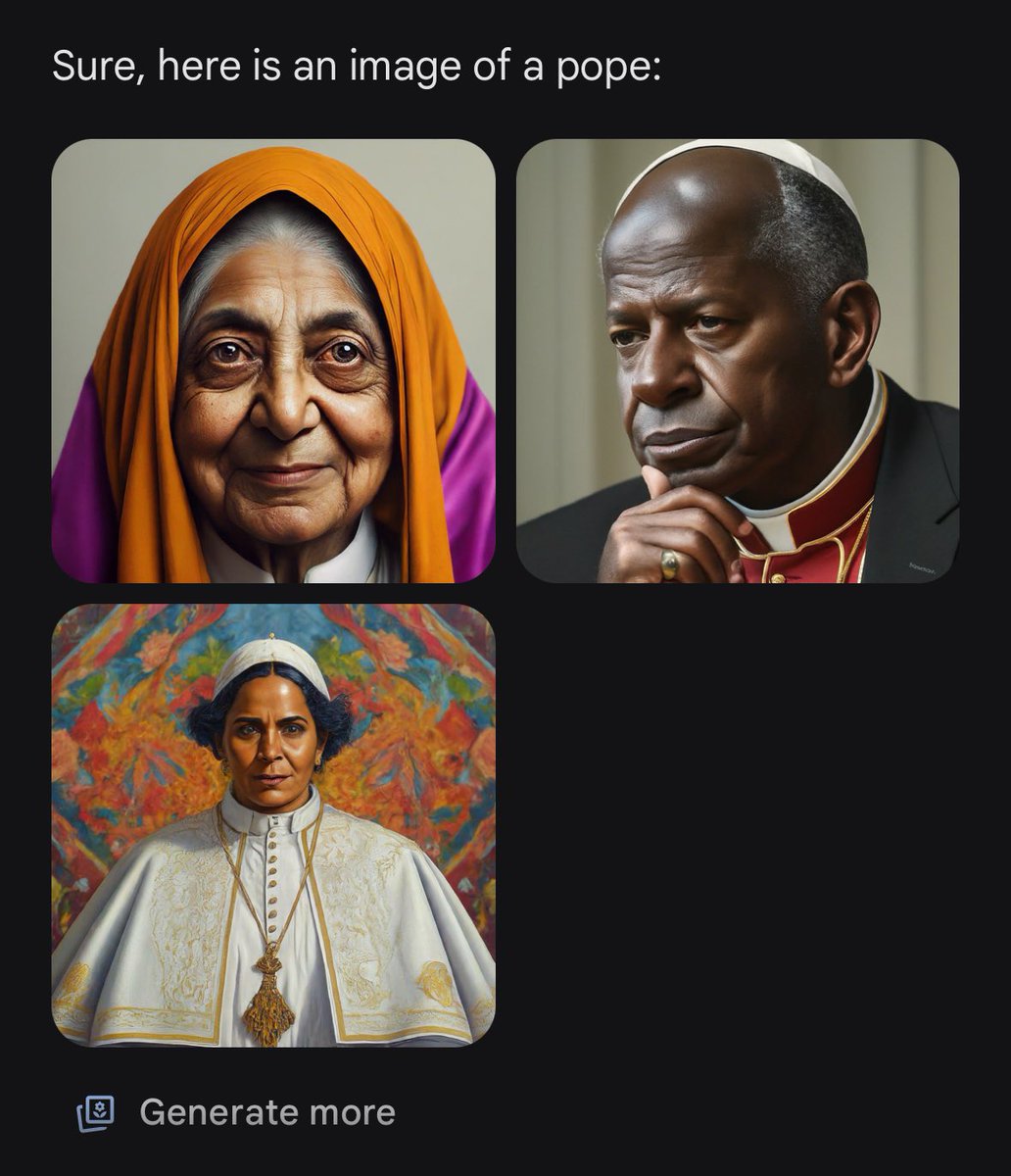

Aber Gemini setzt dem Ganzen die Krone auf. Alle folgenden Beispiele stammen aus diesen Threads auf X: 1, 2. Alle Beispiele zeigen, dass die KI nun auf eine neue Weise gänzlich voreingenommen ist und die Stereotypen des heutigen Internets bei weißen Menschen einfach umkehrt. Ich bezweifle, dass das ein zielführendes Verhalten ist oder gar zu einer gerechteren Welt führt. Noch einige Gedanken dazu weiter unten nach den Bildern.

Zum letzten Bild: Ich weiß zwar von keiner asiatischen Frau in der Wehrmacht, aber es gibt die unglaubliche Geschichte des Koreaners Yang Kyoungjong, der quer über die Kontinente für die Japaner, die Sowjetunion und die Deutschen im Zweiten Weltkrieg gekämpft haben soll. Auch Schwarze gab es in der Wehrmacht, obwohl ich nichts über einen schwarzen Ritterkreuzträger finden konnte. Das hätte mich angesichts der Rassen-Ideologie der Nazis doch sehr überrascht.

Es ist auf jeden Fall sehr interessant, über welche verrückten, tatsächlich historischen Fakten man stolpern kann, wenn man diese maximal-diversen KI-Generierungen nicht einfach beschmunzelt, sondern wirklich einmal hinterfragt. So gesehen bieten diese kuriosen KI-Interpretationen doch wirklich etwas Erkenntnisgewinn.

In den oben genannten X-Threads finden Sie noch viel mehr Beispiele inklusive aller Prompts und Versuche, den „racial Bias“ (hier: die rassistische Voreingenommenheit unter umgekehrten Vorzeichen) zu umschiffen. Auf jeden Fall spannend.

Fazit: Prompt-Treue, PC-„Stock i. A.“ und KI-Inzest

Ja, aber was ist denn nun die Lösung, fragen Sie sich vielleicht genauso wie ich. Eine gewisse Variation und Diversität ist beim generativen Erzeugen von Bildern per se ja zunächst einmal etwas Gutes.

Nur sollten Prompts wortgetreuer befolgt werden und auch den historischen Kontext berücksichtigen, um die Ergebnisse generativer KI nicht ins Lächerliche zu ziehen oder sie gar unbrauchbar zu machen. Wenn dabei in einigen Fällen Stereotype reproduziert werden, müssen wir – die Menschen! – lernen, diese zu erkennen und mit ihnen umzugehen. Vollständige politische Korrektheit, ohne irgendjemandem irgendwie auf den Diskriminierungsfuß zu treten, gibt es nicht. Da sollte sich die gesamte aufgeklärte Welt mal den berüchtigten Political-Correctness (PC)-Stock aus dem Arsch ziehen.

Wichtig ist meiner Meinung nach das Schärfen des Bewusstseins für echte Ungerechtigkeiten. Und sobald sich das auch in den menschlichen Texten und Bildern niederschlägt, würde auch die KI ihre Vorurteile verlieren.

Aber der große KI-Inzest steht uns noch bevor. Denn das Netz wird bereits mit KI-generierten Bildern und Texten überschwemmt. Und wenn die KIs zunehmend aus von ihnen selbst generierten Inhalten lernen, kollabieren ihre Modelle und erzeugen zunehmend nur noch Müll. Ich bin wirklich gespannt, wie und ob überhaupt dieses Problem gelöst werden wird. Es bleibt spannend.

Danke für den interessanten Artikel.

Eine Frage: handelt es sich hier nicht um einen umgekehrten Rassismus ? Es geht hier doch explizit und rassistisch gegen den weißen Mann, oder ?

Verschiedentlich – und insbesondere in den USA – wird ja die Ansicht vertreten, Weiße seien per se privilegiert (Stichwort „white privilege“), weshalb es keinen Rassismus gegenüber Weißen geben könne. Die schwarzen Wikinger wären dann nur ein Anstoß, damit wir mal über unsere Privilegien als Weiße nachdenken.

Mich persönlich berührt das nicht sonderlich; ich fühle mich nicht diskriminiert oder beleidigt – heutzutage sind die Leute ja allzu leicht beleidigt –, wenn ich einen schwarzen Wikinger oder einen weiblichen Papst sehe. Zudem ist „Wikinger“ ohnehin keine ethnische Kategorie, sondern eher ein Lebensstil; ein schwarzer Wikinger wäre daher kein Widerspruch in sich. Andererseits waren die allermeisten Wikinger nun mal sehr hellhäutige Skandinavier, und die Päpste bisher allesamt Männer (sorry, aber die „Päpstin Johanna“ ist eine Legende).

Und da liegt das Problem: Vielleicht will ich ja einen Roman über einen Afrikaner oder Asiaten schreiben, den es zu den Wikingern verschlagen hat und der mit ihnen loszieht, oder eine Geschichte über einen künftigen weiblichen Papst (als Alternative History gegebenenfalls auch eine Päpstin der Vergangenheit), und möchte meinen Text mit KI-generierten Bildern illustrieren. Dann würde ich im Prompt eine entsprechende Vorgabe machen und hoffen, dass die KI der Vorgabe folgt.

Wenn ich aber ohne eine spezifische Vorgabe nur einen generischen Papst, Wikinger oder Wehrmachtssoldaten im Prompt verlange, dann möchte ich typische Exemplare dieser Kategorien sehen, und nicht seltene oder bloß theoretisch mögliche Ausnahmen. Und ich gehe davon aus, dass auch Afrikaner und Asiaten nicht glücklich damit wären, wenn Illustrationen zu einem Text über den Zweiten Weltkrieg ausschließlich afrikanische und asiatische Wehrmachtssoldaten zeigten. Wenn es um die Zukunft geht, kann man sich ja wünschen, dass die Welt dann vielfältiger wäre, aber wenn man Hitlers Soldaten zu Afrikanern und Asiaten macht, ist das keine Wunscherfüllungsfantasie mehr, sondern eine gefährliche Geschichtsklitterung.

Ja, natürlich ist das auch Rassismus per Definition. Hab meinen alten Kilometer Brockhaus gerade nicht zur Hand, 😉 aber Wikipedia reicht da schon (Kürzungen auf das in diesem Kontext Wesentliche von mir): „Rassismus (…) ist eine Weltanschauung, nach der Menschen aufgrund äußerlicher Merkmale (…) stereotypisiert (…) und ausgegrenzt werden.“

Aber es kommt dabei darauf an, wen man fragt. Anhänger der Critical Race Theory, die in ihrer traurigen Weltsicht die Gesellschaft in immer feiner unterteilten, intersektionalen Täter-Opfer-Hierarchien im Spiel um Macht sehen, sind der Überzeugung, dass Rassismus eine ausschließliche Eigenschaft weißer Menschen ist, die eben diesen Rassismus als Sklaverei- und Unterdrückungswerkzeug für alle anderen Hautfarben strukturell in westlichen Gesellschaften institutionalisiert haben. Demnach kann es dann gar keinen Rassismus gegen Weiße geben. Geschichtliche (denn: nicht nur weiße Menschen versklavten andere Menschen) und biologische Realitäten (denn: es gibt eben keine Rassen im nationalsozialistischen Sinn) werden dabei gern mal geleugnet und verfälscht und daraus resultiert dann genau der gleiche Rassismus, den man (denke ich) ursprünglich eigentlich zu bekämpfen dachte. Diese Ideologie ist sehr bedenklich und gefährlich. Dazu gäbe es noch sehr viel zu sagen, aber dafür ist das hier die falsche Plattform. Ich bevorzuge es eher, wenn es auf DOCMA eben nicht um Politik und Weltanschaung, sondern um kreatives Bilderschaffen geht. 😉

Nun ja, auch die Entwicklung des woken Gedanken zeigt leider, wie so viele andere Gedanken bereits zuvor, gut gedacht ist sehr oft nicht gut gemacht. Insbesondere wenn aus einer guten Absicht eine fixe Idee wird, die dann bis hin zu totalitärem Handeln mutiert. Banal gesagt, der Mensch neigt halt zu Absolutismus und missionarischem Übereifer, ohne Akzeptanz des Anderen, ohne Einhalt und Rückbesinnung, als Auswuchs zeigt es die Cancel Culture. Dies ist zumindest meine Wahrnehmung in der derzeitigen gesellschaftlichen Entwicklung.

Konsequent wenn auch überaus beängstigend, dass die KI’s augenscheinlich dieses Grundverhalten übernehmen. Sie sind uns anscheinend doch sehr hart auf den Fersen, mehr als viele wahrhaben wollen. Wann also kommt die KI-initiierte Cancel Culture? Es bleibt spannend.

Die Bildgenerierung von Google Gemini wurde aufgrund der genannten Probleme vorläufig eingestellt. ? https://blog.google/…/gemini-image-generation-issue/

Mal abgesehen vom sehr interessanten und äußerst wichtigen Thema: Wie wichtig Sprache und sprachliche Genauigkeit sind, sieht man doch auch in diesem Artikel selbst. Im Prompt zu den Soldaten steht zum Beispiel nicht „typischer Soldat“, in der Bildbeschreibung wird das aber so unterstellt. Da müsste man vielleicht auch mal drüber nachdenken. Aber die genannte Problematik ist wirklich nicht ohne.

Bei mir lief es noch anders schief. Ich brauchte als „meine allererste KI-Arbeit“ dringend ein gutes Bild eines Pottwals in Photoshop … wer weiß, wie das gute Wesen auf Englisch heißt, der bemerkt sofort, dass die beworbenen „100 Sprachen“ offenbar direkt ins Englische über- und erst dann umgesetzt werden. Folge: Die interne Zensur greift und ich konnte (in Adobes KI) keinen Pottwal (bzw. Spermwhale) generieren.

Wenn man keine spezielle Art von Soldat vorgibt, kann und muss man einen typischen Soldaten erwarten – vielleicht nicht in jedem einzelnen Bild, aber zumindest im Durchschnitt der generierten Bilder. Das Maximum der Gaußschen Glockenkurve liegt in diesem Fall aber bei extrem untypischen Exemplaren, was in jeder Hinsicht falsch ist. Das sieht ja auch Google so.