Wie viele Megapixel hat das menschliche Auge?

Ein Beitrag im Image Sensors World Blog machte mich auf diverse Antworten auf die Frage aufmerksam, wie viele Megapixel das menschliche Auge auflöst: 576, 125, 7 oder nur 1 MP? Die Sache ist kompliziert …

Die Antworten – insgesamt sind es 80 – findet man auf quora.com, einer Website, auf der man Fragen aus allen möglichen Wissensgebieten stellen kann – und sie beantworten, wenn man sich für einen Experten auf dem jeweiligen Gebiet hält.

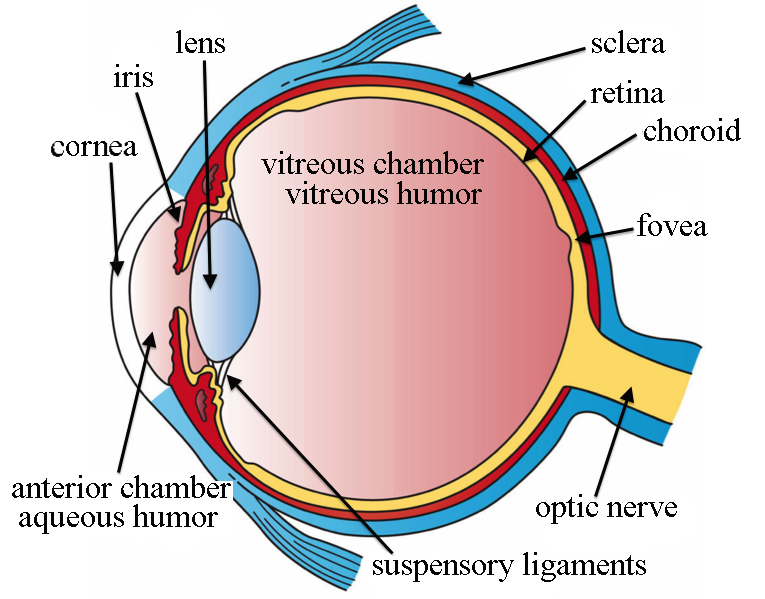

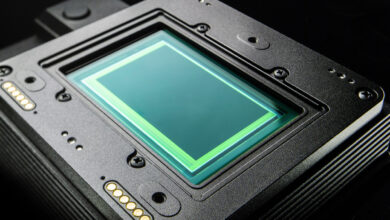

Der Witz bei dieser Frage ist natürlich, dass sie falsch gestellt ist und es eigentlich keine richtige Antwort gibt. Das Auge ist keine Kamera und die Netzhaut kein Sensor, wir wir ihn aus Digitalkameras kennen. Unsere Augen kennen keine Pixel – wie soll man da eine Zahl der Megapixel angeben?

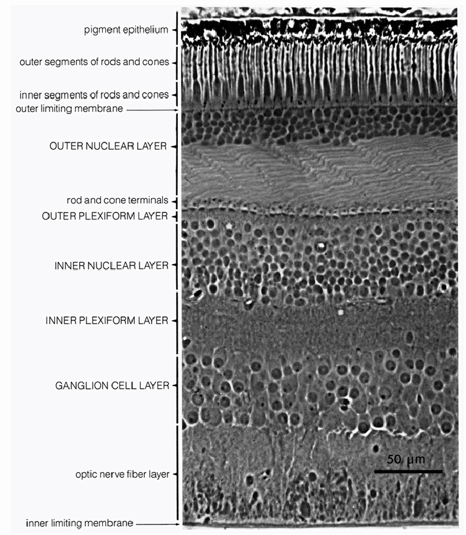

Immerhin enthält die Netzhaut der Augen lichtempfindliche Zellen, die man mit den Pixeln eines Sensors vergleichen könnte. Diese Sinneszellen liegen übrigens recht tief in der Netzhaut, so dass das Licht erst mehrere Schichten anderer Zellen passieren muss, bevor es registriert werden kann. Rund 3/4 des Lichts geht dabei verloren. Wäre die Netzhaut ein Sensor, dann wäre er vom FSI-Typ – ein Sensor mit klassischem Aufbau, bei dem das Licht erst die Schichten der Verdrahtung passieren muss, bevor es auf die Fotodiode eines Pixels trifft. Bei den immer öfter eingesetzten BSI-Sensoren mit umgedrehtem Aufbau liegen die lichtempfindlichen Fotodioden dagegen oben, aber die Evolution hat diesen Schritt noch nicht vollzogen.

Pro Auge gibt es rund 7 Millionen der farbempfindlichen Zapfen, so dass man von 7 MP ausgehen könnten. Dazu kommen aber 125 Millionen nur helligkeitsempfindlicher Stäbchen, womit wir auf 132 MP kämen. Diese Sinneszellen sind jedoch nicht, wie bei einem Sensor, in einem festen Raster angeordnet und auch nicht gleichmäßig verteilt. In einem zentralen Bereich ist die Dichte sehr viel größer als in der Peripherie unseres Gesichtsfelds, in der wir auch keine Farben mehr unterscheiden können. Das Gesichtsfeld, in dem wir wirklich scharf sehen können, umfasst nur etwa 2 Grad, und darin hat das Auge eine Winkelauflösung von rund 0,6 Bogenminuten für ein Linienpaar. Das entspräche dann nur noch einer Handvoll Megapixel. Allerdings wandert unser Blick in einem größeren Gesichtsfeld ständig hin und her, und wenn wir dieses größere Gesichtsfeld mit etwa 120 Grad Breite als Ausgangspunkt der Berechnung nehmen, kommt man auf 576 MP. Auf der anderen Seite gibt es im Sehnerv, der die Netzhaut mit dem visuellen Cortex des Gehirns verbindet, nur eine Million Nervenbahnen – sind es also doch eher nur 1 MP?

Wie gesagt: Genau genommen kann man die Frage nicht sinnvoll beantworten. Unsere Augen registrieren zwar zweidimensionale Bilder, die bereits vorverarbeitet über den Flaschenhals des Sehnervs zum Gehirn gelangen, und aus der Vielzahl der Bilder, die unser hin und her springender Blick auffängt, könnte man eine Art Panoramabild mit den genannten 576 Megapixeln stitchen. Aber so arbeitet unser Gehirn nicht. Das Gehirn sammelt ja keine hochaufgelösten Schnappschüsse, sondern es erkennt die Umwelt, in der wir uns bewegen. So hat es sich im Laufe der Evolution entwickelt, denn es geht darum, sich in der Welt zu orientieren und Gefahren genauso wie auch interessante Möglichkeiten zu entdecken.

Unser Gehirn erkennt also Objekte – in drei Dimensionen, die vor allem dank des Stereosehens mit zwei Augen rekonstruiert werden können. Das Ergebnis ähnelt mehr einem 3D-Modell als einem Bild, aber selbst die dreidimensionale Form der erkannten Objekte ist weniger relevant als das, was sie sind. Schon viel einfacher strukturierte Wirbeltiere als wir Menschen können auf einen Blick erkennen, ob sie es beispielsweise mit einem Raubtier, einem Konkurrenten oder einem potentiellen Sexualpartner zu tun haben, und unser visueller Cortex steht in dieser evolutionären Tradition. 576 MP wären eher hinderlich, wenn eine solche Erkennungsaufgabe zeitnah zu einem Ergebnis kommen soll.

Die Hersteller von Digitalkameras versuchen sich zwar auch darin, beispielsweise Gesichter von Menschen und Tieren zu erkennen und die automatische Belichtung und Fokussierung auf die erkannten Motive abzustimmen, aber das ist nur ein Hilfsmittel für den eigentlichen Zweck der Kamera, nämlich ein zweidimensionales Bild zu erzeugen.

Wie viele Megapixel hat das menschliche Auge? Man kann die Ausgangsfrage allerdings auch umgekehrt stellen, nämlich nach der Auflösung fragen, die ein Bild haben muss, das wir als scharf empfinden. Geht man von einem normalen Betrachtungsabstand aus, der der Bilddiagonale entspricht – bei einem solchen Betrachtungsabstand kann man das Bild noch mit einem Blick erfassen –, dann genügen schon 6 bis 8 MP. Auflösungen von 12 oder 16 MP würden auch dann noch hinreichen, wenn wir etwas näher an ein Bild heran treten, um Details zu würdigen. Aktuelle Kameramodelle haben insofern eine für fast alle praktischen Aufgabenstellungen mehr als ausreichende Auflösung, auch wenn eine höhere Auflösung die Bildqualität noch steigern kann – aber wir müssten schon sehr genau und aus nächster Nähe hinschauen, um den Unterschied zu erkennen.

Die Fragestellung ist, wie der Autor klar beantwortet, ziemlich unsinnig, weil eben das Auge nicht wie ein Sensor funktioniert.

Allerdings macht es etwas, was ein Fotoapparat nicht kann und etwas, das besonders schlechte Filmer tun: Es schwenkt den Blickpunkt bei der Betrachtung, der Betrachter kann sich einem Objekt nähern, es im Detail betrachten. So gesehen, kann manch ein Foto gar keine genügend hohe Auflösung haben, muss es aber nicht. Es kommt eben auf das Motiv an. Das Gigapixelbild einer Stadt, eines Gebäudes, eines Gemäldes bietet eben die Möglichkeit einer beachtlichen Detailansicht, bei einem Portrait oder einer Herbststimmung wird es nur selten einen Mehrwert bringen.

Derzeit ist es so, dass es zwar deutliche Verbesserungen der Sensorqualität, vor allem meine ich, jedoch die kamerainterne Software, also die Firmware, dafür sorgt, dass die vom Sensor gelieferten Daten recht ansehnliche Ergebnisse liefern. Dass dazu noch die interne JPG-Erzeugung sehr ansprechende Bilder liefert, beweisen spätestens die Smartphonekameras.

Und da nach meinem Wissensstand die Waverherstellung nicht wirklich in Dimensionen von analogen Mittel- oder sogar Großformatkameras vorstoßen kann, bleiben diese Formate nach wie vor der analogen Fotografie vorbehalten, also ein echtes Nischenprodukt.

Sollte es mal tatsächlich irgendwann mal Sensoren für 9×12 oder 13×18 geben, so bin ich auf die Rechner und die Software gespannt, die damit umgehen können.