Ein präziser Blick auf den jüngsten Vergleichstest von 100-Megapixel-Systemen enthüllt mehr als nur technische Unterschiede; er zeigt den schmalen Grat zwischen digitaler Bewahrung und finanzieller Realität im Museumsalltag. Daneben beantwortet er die Frage, warum eine Kamera, die für 99 Prozent aller Fotografen exzellent ist, für die Archivierung von Kulturgut ungeeignet sein kann.

In der Fotografie verlieren wir uns oft in subjektiven Debatten über Bildanmutung und Charakter. Aber gibt es eine Nische, in der nur harte, messbare Fakten zählen: die Digitalisierung von Kulturgut. Hier geht es nicht um gefällige Porträts oder dramatische Landschaften, sondern um die Schaffung eines digitalen Zwillings, der dem Original in jeder Hinsicht so nahe wie möglich kommt. Für diese sakrosankte Aufgabe hat sich in den USA ein Standard etabliert, der als unbestechlicher Richter fungiert: FADGI.

FADGI: Der gnadenlose TÜV für digitale Archive

FADGI, die „Federal Agencies Digital Guidelines Initiative“, ist im Grunde eine gemeinsame Anstrengung von US-Bundesbehörden, um verbindliche Richtlinien für die Digitalisierung von historischem und kulturellem Material zu schaffen. Diese Initiative hat ein vierstufiges Sternesystem entwickelt, das die Qualität einer digitalen Reproduktion anhand einer ganzen Reihe komplexer Parameter bewertet. Die höchste Stufe, FADGI 4 Sterne, ist das erklärte Ziel für die Langzeitarchivierung von unersetzlichen Objekten. Sie verlangt Perfektion in Bereichen wie Auflösung, geometrischer Genauigkeit, Rauschverhalten, Belichtungskonstanz und vor allem Farbtreue. Man könnte FADGI als den TÜV für die digitale Ewigkeit bezeichnen; ein Standard, der sicherstellen soll, dass Forscher in 200 Jahren einer digitalen Kopie genauso vertrauen können wie dem physischen Original. In Europa existieren mit den METAMORFOZE-Richtlinien ähnliche, wenn auch nicht identische Bestrebungen. Dem strengen FADGI-Regime hat das Team von Capture Integration, renommierte Experten für Mittelformatsysteme, nun drei der führenden 100-Megapixel-Kameras unterworfen. Ein Test, der für viele Archive, Museen und Bibliotheken von entscheidender Bedeutung ist.

Die Kontrahenten im Ring

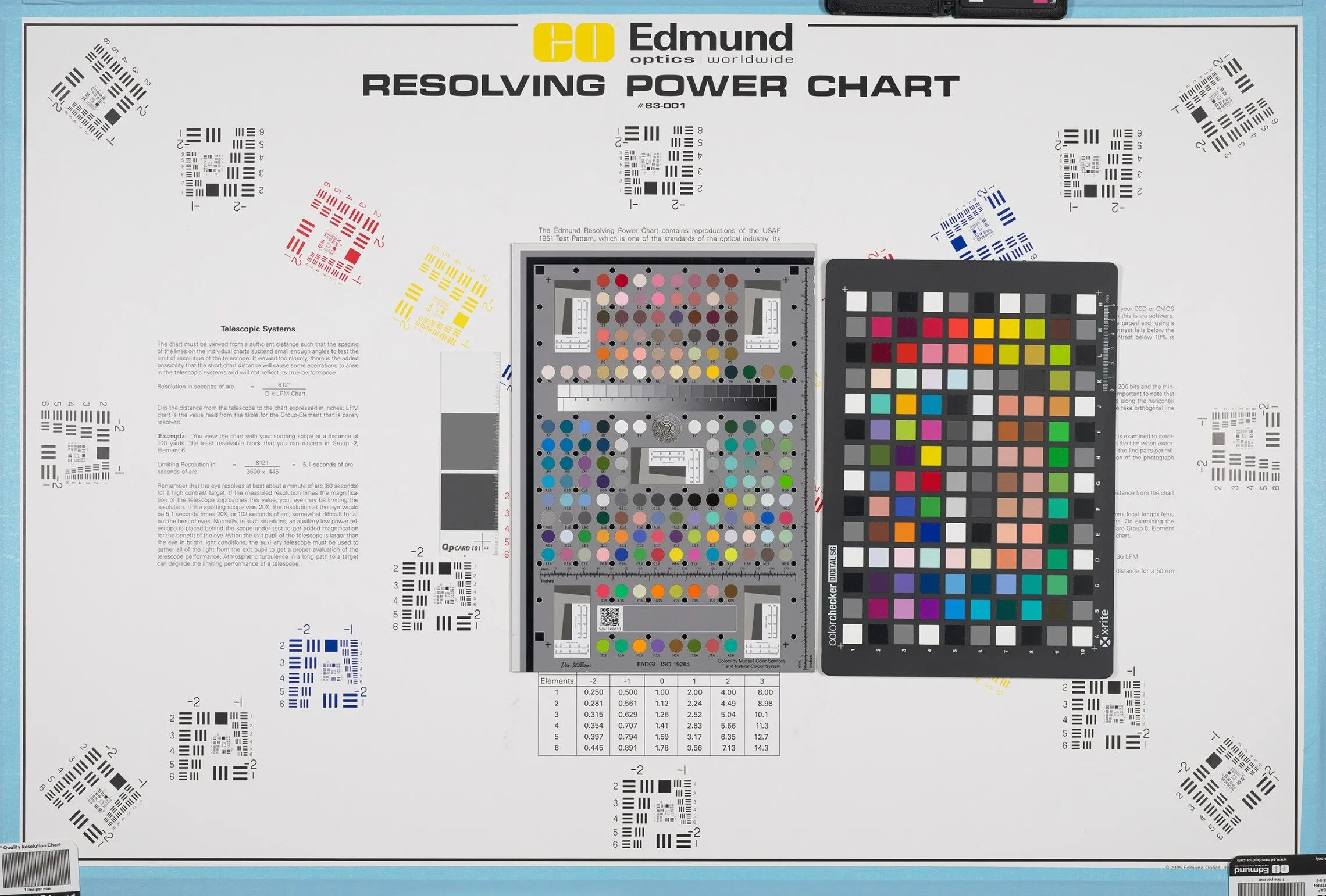

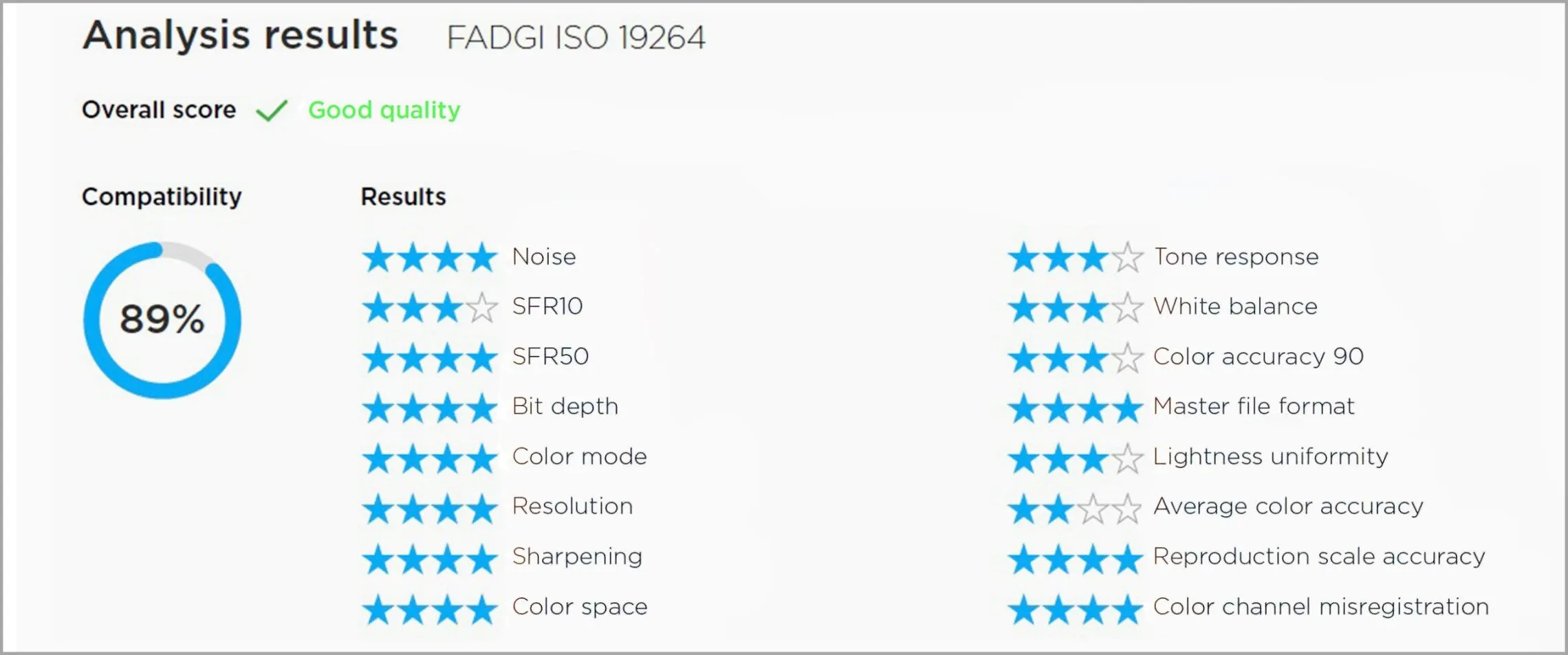

Um ein faires und vergleichbares Ergebnis zu erzielen, haben sie alle Systeme unter penibel kontrollierten Bedingungen getestet: Die Kameras wurden so positioniert, dass sie die Testcharts mit einer nativen Auflösung von 400 ppi erfassten, alle Objektive wurden auf Blende f/11 eingestellt und die ISO-Empfindlichkeit auf den Basiswert 100 fixiert. Die Auswertung der resultierenden TIFF-Dateien übernahm die spezialisierte Software NimbusQ∆ von Phase One, die ein Bild anhand von 16 Qualitätskategorien analysiert und einen FADGI-Konformitätswert in Prozent ausgibt.

Im Ring standen:

- Phase One IQ3 100MP: Das digitale Rückteil mit seinem 53,7 x 40,4 mm großen Sensor, montiert an einem XF-Kameragehäuse mit einem Schneider Kreuznach 80mm Blue Ring II Objektiv.

- Hasselblad X2D 100C: Die spiegellose Mittelformatkamera mit ihrem 43,8 x 32,9 mm großen Sensor und dem XCD 80mm f/1.9 Objektiv.

- Fujifilm GFX 100S II: Ebenfalls mit einem 43,8 x 32,9 mm Sensor ausgestattet und mit dem GF 80mm f/1.7 R WR Objektiv angetreten.

Das Urteil: Qualität, Kosten und ein unerwarteter Dämpfer

Das Ergebnis des Shootouts ist ebenso klar wie für manchen ernüchternd. Das System von Phase One erreichte im Einzelbildmodus einen FADGI-Score von 97% und erfüllt damit souverän die strengen Vier-Sterne-Anforderungen. Diese Leistung hat allerdings ihren Preis: Ein komplettes, FADGI-4-konformes Reproduktionssystem auf Basis der IQ3 100MP schlägt mit rund 46.000 US-Dollar zu Buche.

Die Hasselblad X2D 100C scheiterte im Einzelbildmodus an den hohen Hürden des Standards. Im Multi-Shot-Modus jedoch, bei dem die Kamera mittels Sensor-Shift mehrere Aufnahmen zu einem Bild mit höherer Farb- und Detailauflösung verrechnet, erreichte sie einen beeindruckenden Score von 91% und damit ebenfalls die FADGI-4-Konformität. Dies ist besonders bemerkenswert, da Hasselblad diese Funktion erst 2024 per Firmware-Update nachreichte. Der entscheidende Vorteil: Ein komplettes, FADGI-4-taugliches System auf Hasselblad-Basis lässt sich für weniger als die Hälfte des Preises des Phase-One-Systems zusammenstellen.

Die größte Überraschung lieferte die Fujifilm GFX 100S II. Obwohl sie im Einzelbildmodus die Hasselblad sogar übertraf, scheiterte auch sie an den FADGI-4-Normen. Gravierender waren jedoch fundamentale Probleme, die im hochkontrollierten Testumfeld zutage traten. Die Tester stellten eine inakzeptable Belichtungsinkonsistenz fest, die sowohl bei Dauerlicht als auch mit Blitz, mit mechanischem und elektronischem Verschluss auftrat. Noch problematischer war der Multi-Shot-Modus: Hier traten geometrische Verzerrungen und Skalierungsfehler auf, die das Bild über die Fläche hinweg veränderten – ein absolutes K.o.-Kriterium für die exakte Reproduktion von Kunstwerken. Das Fazit von Capture Integration ist daher unmissverständlich: Obwohl die GFX-Systeme für 99% aller Fotografen hervorragend sind, können sie für den speziellen Arbeitsablauf im Bereich des Kulturerbes derzeit nicht empfohlen werden.

Die Konsequenzen für die Praxis

Die Ergebnisse zeichnen ein klares Bild des Marktes. Für Institutionen mit dem nötigen Budget, die auf kompromisslose Qualität im Einzelbildmodus angewiesen sind, bleibt Phase One der unangefochtene Spitzenreiter im Bereich der Kulturerbe-Digitalisierung.

Für alle anderen stellt die Hasselblad X2D 100C im Multi-Shot-Modus eine technologisch ausgereifte und vor allem wirtschaftlich attraktive Alternative dar, um die höchsten Qualitätsstandards zu erfüllen. Sie demokratisiert den Zugang zu FADGI-4-konformer Digitalisierung und ermöglicht es auch kleineren Institutionen, ihre Schätze für die Nachwelt in höchster Güte zu bewahren.

Die Lehre aus diesem Vergleich ist vielschichtig. Er zeigt, dass allgemeine Bildqualität und die Eignung für einen hochspezialisierten, wissenschaftlichen Prozess zwei verschiedene Paar Schuhe sind. Und er zwingt jede Institution, die vor der gewaltigen Aufgabe der Digitalisierung ihrer Bestände steht, zu einer strategischen Entscheidung: Investiert man in die absolute, aber teure Perfektion für wenige ausgewählte Objekte oder wählt man den preislich vernünftigeren Weg, um mehr von unserem kollektiven Gedächtnis vor dem Verfall zu retten? Bei begrenzten Budgets ist dies keine technische, sondern eher eine kulturelle Frage.

Ich hatte darüber zuerst bei PetaPixel gelesen und mich über die Beschreibung der Belichtungsinkonsistenz bei der Fuji GFX gewundert – da war von einem „10 point shift in exposure“ die Rede, aber was sollten diese „Punkte“ überhaupt sein? Die Belichtung gibt man doch gewöhnlich in Lichtwerten (EV) an, wobei der in der Fotografie normalerweise verwendete ISO-Standard übrigens recht großzügig ist, was die Konsistenz betrifft. Leider habe ich keine GFX greifbar und kann es nicht nachprüfen, aber ich würde schon gerne wissen, was da passiert; eine gewisse Variabilität ist zwar in der Praxis irreleveant (wer mit einer Belichtungsautomatik und Mehrfeldmessung fotografiert, muss ohnehin mit noch größeren Abweichungen leben), aber wenn man unter kontrollierten Bedingungen arbeitet, sollte es sie gar nicht erst geben.

Aber wie auch immer … Die „Punkte“ beziehen sich nicht, wie ich zuerst dachte, auf irgendeine hochgenaue Maßeinheit der Belichtung, die die Tester für ihre Zwecke definiert hätten, denn im Originaltext ist davon keine Rede. Die Aussage steht vielmehr im Kontext der 256 8-Bit-Werte in den ausgewerteten TIFF-Dateien, und die „Punkte“ sind offenbar Differenzen dieser Werte. Mit „+/- 5 points“ könnten also beispielsweise Werte zwischen 120 und 130 gemeint sein. Sie beschreiben also nicht, wie die Kamera belichtet hat, sondern wie hell das Bild an einer Stelle erscheint. Was für ein in EV gemessener Belichtungsunterschied dem entspricht, lässt sich aber nicht von diesen Werten ablesen und auch nicht einfach umrechnen. Die 8-Bit-Werte im entwickelten Bild haben ja keine lineare Kennlinie und ±5 im mittleren Tonwertbereich entspricht einem geringeren Belichtungsunterschied als die gleiche Differenz in den Lichtern oder Schatten. Es ist schade, dass die Tester dem nicht näher nachgegangen sind.

Und dann ist da das kuriose Ergebnis, dass die Multishot-Bilder eine starke kissenförmige Verzeichnung aufweisen. Über deren Ursache schreiben die Tester nicht viel, und es ist ja nicht nachvollziehbar, warum aus der Verrechnung um halbe Pixelbreiten verschobener Bilder plötzlich eine Verzeichnung entstehen sollte, die man in den einzelnen Bildern und außerhalb des Multishot-Modus nicht sieht. Tatsächlich geht es auch um etwas ganz anderes. Die Tester hatten ein Objektiv gewählt, dessen Verzeichnung nicht schon optisch korrigiert ist; dafür sorgt erst eine digitale Korrektur, die entweder in der Kamera oder vom Raw-Konverter angewandt wird – die nötigen Korrekturanweisungen sind in den Metadaten der Raw-Datei gespeichert. (Für die Zwecke, um die es in diesem Vergleichstest ging, hätte ich ein optisch hoch korrigiertes Objektiv gewählt, aber egal …) Wenn man nun die Multishot-Aufnahmen mit verschobenem Sensor miteinander verrechnet, wozu eine von Fuji entwickelte Software nötig ist, muss das auf Basis der noch unkorrigierten Rohdaten passieren; anders wäre es technisch nicht möglich. Das zusammengesetzte Multishot-Bild mit vierfacher Auflösung ist also immer noch unkorrigiert und muss erst im Raw-Konverter korrigiert werden – aber das ist in diesem Test seltsamerweise nicht geschehen.

Die Ursache bleibt unklar, aber fest steht, dass die Verzeichnung nicht der Kamera, sondern dem Objektiv anzulasten ist, und dass sie so oder so gar nicht in Erscheinung treten würde, wenn im Workflow alles funktionieren würde, wie es soll. Was war nun schiefgegangen? Hatte Fujis Multishot-Software versäumt, die Korrekturanweisungen aus den Einzelbildern auch in das daraus verrechnete 400-Megapixel-Bild zu schreiben? Oder hatte Capture One diese Korrekturdaten ignoriert oder falsch angewandt? Dem sollte man mal nachgehen.

Danke für die Einordnung – die finde ich interessanter, als die offiziellen Testergebnisse.

Aus den Anmerkungen kann man was herleiten?:

Der Vergleich ist nicht das Elektron wert, mit dem er gespeichert und verbreitet ist.

Wenn man Äpfel mit Birnen vergleicht, braucht man sich über Unterschiede nicht wundern.

Da hätten die Amis (mal wieder) jemanden fragen sollen, der Ahnung hat…

Noch besser wäre gewesen, wenn die Einordnungen von Herrn Hußmann in den Artikel von Herrn Künne Eingang gefunden hätten – dann wäre das „sauber“ gewesen.

Nur berichten, um des Berichtens willen ist (gerade in einem eher fachlich-technisch affinen Umfeld) leider kein guter Journalismus.

Ihr Jungs solltet mehr miteinander reden…

😉

———————————————-

Aber interessant war es – beides zusammen.

Danke Michael Hussmann,

ich meine ihre Kritik ist sehr gut technisch, wissenschaftlich fundamendiert dagebracht. (Kamera-Objektiv-Software Problematik im Speziellen und Allgemeinen). Wie würde der Vergleich unter anderen Software/Kamera-Bedingungen ausfallen. Nicht zu vergessen auch das Farbmanagement und hier speziell die (Camera-)Profilsoftware, bzw. die zu gehörigen Aufnahmebedingungen. Mich stört vor allem diese Testvoraussetzung: „…….. 256 8-Bit-Werte in den ausgewerteten TIFF-Dateien“ als Grundlage für fachlich korrekte Vergleichswerte.

Abgesehen davon, welchen Anforderungen digitalisierte Reproduktionen von Kulturgut überhaupt gerecht werden kann, bzw. muß. Es handelt sich in welcher Qualität auch immer, um ein Abbild der realen (Stein, Papier, Leinwand, Farbpigment, etc.) Vorlagen.

mfG

Wolfram Orthacker

Ich hänge hier noch mal an, was ich im Fuji-X-Forum zu diesem Thema geschrieben habe:

Die Sache mit der Verzeichnung ließe sich recht einfach klären. Hier liegen Raw-Dateien vor, die digital korrigiert werden müssten, was aber nicht geschieht. Da zwei Anwendungen beteiligt sind, Fujis Pixel Shift Combiner und Capture One, muss man ermitteln, welche der beiden verantwortlich ist. Der Pixel Shift Combiner sollte die aus den Einzelbildern berechnete DNG-Datei entweder selbst korrigieren oder wiederum ein Korrekturprofil einbetten, damit es dann der Raw-Konverter anwenden kann. Jeder, der eine aktuelle GFX mit Multi-Shot-Modus und ein digital korrigiertes Systemobjektiv hat, könnte es leicht ausprobieren: Wenn die vom Pixel Shift Combiner erzeugte DNG-Datei ein Korrekturprofil hat – was beispielsweise auch Lightroom oder eine Software, die vollständige Exif-Daten anzeigt, verraten könnte; man braucht dazu kein Capture One –, wäre Fujis Software aus dem Schneider und es würde an einem Bug in Capture One liegen; andernfalls müsste Fuji nachbessern.

Die Sache mit der Belichtungsinkonsistenz ist etwas kniffliger. Ich gehe mal davon aus, dass sich die Tester nicht auf eine Belichtungsautomatik verlassen, sondern manuell belichtet haben; andernfalls wäre es möglich, dass die Kamera bei den einzelnen Bildern unterschiedlich gemessen hätte. Dann wären aber auch die Belichtungsparameter Verschlusszeit und/oder Blende unterschiedlich, was sich in den Exif-Daten niedergeschlagen hätte, wovon aber keine Rede war. Damit bleiben der Verschluss und die Blende als Übeltäter, die nicht die geforderte Verschlusszeit beziehungsweise Blendenöffnung realisieren.

Aus dem Text ergibt sich, dass die Inkonsistenzen bei insgesamt sechs GFX100s II und GFX100 II und sowohl mit dem Schlitzverschluss wie dem elektronischen Verschluss auftraten. Probleme mit dem Timing des Schlitzverschlusses waren zu Zeiten unserer Eltern und Großeltern noch alltäglich, aber bei den seit Jahrzehnten üblichen elektronisch gesteuerten Schlitzverschlüssen sollten sie nicht mehr auftreten, und selbst wenn: Ein solcher Defekt würde nicht bei mehreren Kameras gleichzeitig auftreten, und dann nicht gleichzeitig auch beim elektronischen Verschluss, der ja völlig anders arbeitet.

Damit verengt sich der Blick auf die Blende. Während von sechs verschiedenen Bodies die Rede war, gab es wohl nur ein einziges Objektiv, und wenn dessen Blende etwas gehakelt haben sollte, würde es die beobachtete Inkonsistenz erklären: Die Blende hätte sich dann nicht immer exakt auf den vorgegebenen Wert (f/11) geschlossen. Zum Vergleich müsste man nur mal dasselbe Motiv – eine Graukarte reicht – unter identischer Beleuchtung vom Stativ und mit manueller Belichtung im Multi-Shot-Modus fotografieren, um dann in der Bildbearbeitung die Helligkeit an der jeweils gleichen Stelle zu messen. Wenn es hier ein generelles Problem mit der GFX100s II und GFX100 II gäbe, müssten sich Inkonsistenzen zeigen, egal welches Objektiv man verwendet, aber wenn nicht, wäre das im Test verwendete Objektiv ein Fall für den Kundendienst gewesen. Das könnte jeder ausprobieren, der eine GFX100 II oder GFX100s II hat.

Noch etwas zum Vergleichstest als solchem:

Wenn es um Reproduktionsaufgaben geht, ist die für die Qualität entscheidende Komponente des Aufnahmesystems nicht die Kamera, sondern das Objektiv. Das gilt um so mehr, wenn man im Multi-Shot-Modus arbeitet, der die Objektive ja an ihre Grenzen bringt. Man sollte also Objektive wählen, die eine hohe Kontrastübertragung bis in die Ecken gewährleisten – zumindest bei der Blende, die man verwenden will – und nur eine minimale Verzeichnung aufweisen. Die heutzutage gängigen digitalen Korrekturen habe ich immer verteidigt, und sie sind auch sinnvoll, so lange es um die gewöhnliche bildmäßige Fotografie geht. Für Reproduktionsaufgaben verbietet es sich dagegen, auf eine starke digitale Verzeichnungskorrektur zu setzen, die die Schärfe in den Bildecken (bei einer tonnenförmigen Verzeichnung) oder der Mitte der Kanten (bei einer kissenförmigen Verzeichnung) beeinträchtigt, wogegen auch Abblenden nichts mehr ausrichten kann.

Tatsächlich haben die Tester diesem Thema aber überhaupt keine Aufmerksamkeit geschenkt, sondern stur Objektive derselben Brennweite gewählt, so als ob damit alles gesagt wäre. Dabei ergibt nicht einmal die Brennweitenwahl Sinn, denn im Bericht heißt es: „Since the sensors are a different size, there was discussion that we should go with the “normal” lenses of each size sensor. Instead, we chose not to change focal lengths from test to test and thus adding possible wide angle distortion characteristics.“ Mit Verlaub, aber das ist Quatsch. Ob mit Problemen aufgrund der Verzeichnung zu rechnen ist, hängt nicht von der absoluten Brennweite ab, sondern vom Verhältnis der Brennweite zur Bilddiagonalen. Es sind immer die Normalobjektive, die durchweg die geringste Verzeichnung aufweisen, unabhängig davon, was die Normalbrennweite des Systems ist. Die Wahl derselben Brennweite trotz unterschiedlicher Sensorgrößen ist also bereits ein handwerklicher Fehler, denn sie haben ein Normalobjektiv (Phase One) mit zwei leichten Teleobjektiven (Hasselblad und Fuji) verglichen. Wie stark eine etwaige Verzeichnung dann aber tatsächlich ist, hängt von der jeweiligen Objektivrechnung ab, wofür sich die Tester offenbar nicht weiter interessiert haben — „Schau’n wir mal, dann seh’n wir schon“ scheint die Devise gewesen zu sein.

Bei dieser Nonchalance in der Objektivwahl verwundert es dann auch nicht mehr, wenn die Tester feststellen, dass ein Fehler (wie in diesem Fall eine Inkonsistenz der Belichtung) mit sechs verschiedenen Kameras, zwei verschiedenen Kameramodellen und zwei verschiedenen Verschlussverfahren auftritt, aber überhaupt nicht auf die doch naheliegende Idee kommen, dass die Fehlerquelle bei der Komponente liegen könnte, die immer dieselbe war: nämlich dem Objektiv.

Hätten sie nur mal jemanden gefragt, der sich mit so etwas auskennt, idealerweise vor dem Vergleichstest, aber doch zumindest im Nachhinein!