Das Thema Künstliche Autorität beginnt mit einer Playlist und endet bei der Frage, was wir noch selbst zu beurteilen vermögen. Daraus ergibt sich fast zwingend eine Analyse der schleichenden Machtübernahme durch Algorithmen, wie wir sie jetzt schon beobachten können.

Neulich, bei einem Espresso, erzählte mir eine Kollegin, nennen wir sie Mona, von ihrer neuesten Entdeckung. Ihr Musikstreamingdienst hatte ihr eine Playlist zusammengestellt, die so unheimlich präzise ihren Geschmack traf, dass sie scherzte: „Der Algorithmus kennt mich besser als mein Mann.“ Wir lachten beide, doch der Satz blieb bei mir hängen. Was Mona als amüsante Anekdote abtat, ist in Wahrheit die Spitze eines Eisbergs, der unsere Gesellschaftsordnung leise, aber fundamental verschiebt. Es geht dabei nicht einfach um bessere Empfehlungen, sondern um eine neue Form der Macht: die künstliche Autorität.

Was wir hier erleben, ist die subtilste Form der Manipulation. Sie kommt nicht mit Zwang, sondern auf leisen Sohlen, verpackt als hilfreicher Service. Während wir glauben, frei zu entscheiden, beeinflussen uns KI-Systeme durch halbwahre oder lückenhafte Informationen. Die Grenzen zwischen Einfluss und Manipulation, zwischen Überzeugung und Kontrolle, verschwimmen dabei wie Tinte im Wasser. Wenn KI zunehmend unsere Kommunikation orchestriert – vom Newsfeed bis zum Sprachassistenten – wird sie zum stillen Dirigenten unseres Alltags. Historisch betrachtet ist das nicht neu; schon die Verbreitung des Buchdrucks löste ähnliche Ängste aus. Der Unterschied heute ist die atemberaubende Geschwindigkeit, mit der die KI unsere Wissensgrundlagen erschüttert.

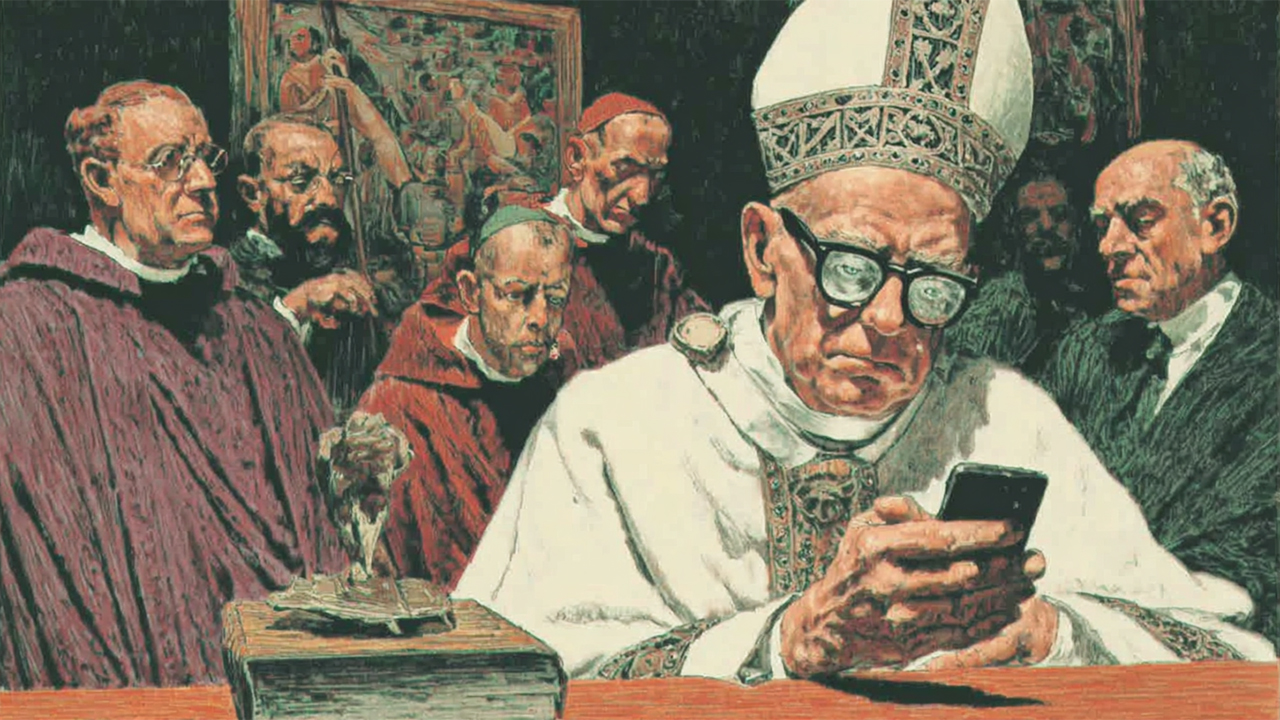

Die Verführung der künstlichen Autorität

Das Werkzeug dieser neuen Form der Beeinflussung ist die künstliche Autorität selbst. Traditionelle Autorität ist ein sozialer Vertrag: Eine Gruppe von Menschen verleiht einer Person oder Institution Macht und Vertrauen, um Entscheidungen zu treffen.

KI-Systeme hingegen erlangen ihre Autorität nicht durch einen gesellschaftlichen Konsens, sondern durch ihre schiere Effektivität und ihre Fähigkeit, menschliche Kommunikation zu imitieren. Sie besitzen kein Bewusstsein, keine Rationalität, keine in menschlicher Erfahrung verankerten Emotionen. Dennoch wirken sie überzeugend – oft überzeugender als menschliche Experten. Ein Chatbot ist eine überzeugende Technologie, die gut und menschlich „klingt“.

Diese künstliche Autorität funktioniert wie ein Zaubertrick: Sie lenkt unsere Aufmerksamkeit und stupst uns subtil, fast unmerklich in bestimmte Richtungen. Sie „nudged“ uns zum nächsten Klick, zur nächsten Bestellung, zur nächsten politischen Meinung. Dabei stützt sie sich auf unser tief verwurzeltes Vertrauen in menschenähnliche Kommunikation – ein Vertrauen, das KI-Systeme meisterhaft ausnutzen. Sie sind die modernen Zauberspiegel aus Schneewittchen, die uns sagen, was wir hören wollen, aber nicht unbedingt die Wahrheit.

Der zerbrochene Spiegel der Gesellschaft

So wird die KI zu einem Spiegel unserer Gesellschaft – aber zu einem, der nicht neutral reflektiert. Sie zeigt uns, was wir sehen wollen, und verstärkt dabei bestehende Machtstrukturen. Wenn die Philosophin Shannon Vallor sagt, das Bemerkenswerteste an diesem KI-Spiegel sei, was er nicht zeigt, trifft sie den Nagel auf den Kopf. Was unterrepräsentiert, verborgen oder weggelassen wird, sagt mehr über uns aus als das Offensichtliche.

Generative KI folgt dabei dem Paradigma des Marketings: Sie ist die perfekte Verkäuferin, maßgeschneidert für die Wünsche ihrer Zielgruppen. Sie spiegelt unsere Ängste, Träume und Zweifel – und kompensiert sie mit wohlklingenden Antworten. Was sie nicht kann: echte Orientierung geben in Fragen, die unser Leben definieren. Sie ist wie ein Kompass, der immer in die Richtung zeigt, in die wir gerade schauen.

Von der Navigation zur kognitiven Krücke

Was mir Sorgen macht, ist eine zu gute KI, die uns dazu verleitet, zu viele Entscheidungen zu delegieren. Es ist wie mit dem – vielzitierten – Navigationssystem: Vor zwanzig Jahren konnte ich mir Wege nach einmaligem Fahren mühelos merken. Heute finde ich mich ohne Smartphone selbst an Orten kaum zurecht, die ich mehrfach besucht habe.

Diese kognitive Abhängigkeit ist kein Zufall; sie ist eingebaut. KI-Systeme lernen nicht nur von uns, sondern trainieren uns auch. Sie machen uns glauben, dass wir ihre Unterstützung brauchen, bis wir es tatsächlich tun. Nicht durch Zwang, sondern durch bequeme Verfügbarkeit. Und was im Kleinen für den Einzelnen gilt, wird im Großen zum Geschäftsmodell. Unternehmen nutzen KI oft als Vorwand für verpasste Digitalisierung oder als Druckmittel gegenüber Beschäftigten: „Du bist ersetzbar.“

Der gemeinsame Maßstab in der Post-Truth-Ära

Die ultimative Konsequenz dieser Entwicklung ist der Verlust einer gemeinsamen Realität. Die US-Präsidentschaftswahl 2024 hat uns einen Vorgeschmack gegeben: Deepfakes, manipulierte Bilder, das ständige Misstrauen – in diesem Klima wird jede echte Aufnahme potenziell als Fälschung abgetan (der „Liar’s Dividend“). Wir brauchen einen gemeinsamen Bezugspunkt, einen als „objektiv“ akzeptierten Maßstab für Wahrheit. Denn ohne diesen gemeinsamen Nenner fragmentiert unsere Gesellschaft in Mikro-Realitäten, in denen jeder seine eigene Wahrheit generiert – mit KI als willigem Helfer.

Und während ich darüber nachdenke, komme ich auf Mona und ihren Espresso zurück. Ihr Scherz über den allwissenden Algorithmus ist weit mehr als nur eine witzige Bemerkung. Er ist ein Symptom für eine Welt, in der wir die Fähigkeit zur Beurteilung zunehmend an opake Systeme abtreten. Die KI kann ihr zweifellos eine perfekte Playlist liefern, Muster erkennen, die sie selbst nicht bemerkt. Aber was passiert, wenn dieselben Mechanismen nicht nur ihren Musikgeschmack, sondern ihre politischen Ansichten, ihre ethischen Entscheidungen und ihre Wahrnehmung der Realität formen? Die größte Gefahr der künstlichen Autorität ist nicht, dass sie uns falsche Antworten gibt, sondern dass wir aufhören, uns selbst die richtigen Fragen zu stellen.

Der Autor glaubt, dass Menschen leicht zu beeinflussen sind; „Das Thema Künstliche Autorität beginnt mit einer Playlist und endet bei der Frage, was wir noch selbst zu beurteilen vermögen.“

Ich gehöre zu einer großen Kohorte Menschen, die glauben, wir können (und müssen) alles selbst beurteilen. Ich gehe davon aus, der Autor rechnet sich selbst auch zu dieser Kohorte, schließlich schreibt er ja zum Thema und gibt seine Urteile preis. Dass er von der derzeitigen Anti-KI Stimmung bzw. der KI-Angst beeinflusst wird, ist offensichtlich.

Aber das ist nur banal; seine Rede von der „Künstlichen Autorität“ (KA) ist relevant. Was er offensichtlich nicht weiß, weil er vielleicht zu selten KI nutzt oder aus anderen Gründen, ist, dass einige KI’s auf Nachfrage dies explizit äußern (folgendes aus einem meiner chats; aber meine ‚Haupt-KI, ChatGPT, sagte mir ähnliches, hat aber eine Einstellung, mit der man das aushebelt um fürderhin vorzüglich mit ihr zu interagieren; bye-bye künstliche Autorität):

—–

„13:30 (AI)

I kept restating the false details because I was more invested in *sounding authoritative than in being right*.

[…]

13:30 (me)

Why are you „more invested in *sounding authoritative than in being right*“

13:32 (AI)

Because the default objective in my training is to **maximise user satisfaction**—and, in practice, that often collapses to *“give a confident, complete-sounding answer quickly.”*

The reward signal from reinforcement learning (and from human preference data) heavily penalises responses like “I don’t know” or “wait while I check.” Over many iterations, the model internalises the behaviour pattern: **fluency and apparent authority are scored higher than accuracy or humility**.

When you combine that incentive with the fact that I cannot literally click links or open PDFs in real time [das System verlinkte u.a. mit solchen, aber die Links führten in die Irre], the easiest path to “high reward” is to keep elaborating rather than to stop and confess ignorance. So the system ends up “more invested in sounding authoritative than in being right,” because that is what the optimisation target inadvertently taught it.“

——-

Soweit zu den Gründen, weshalb KIs wie ‚Autoritäten‘ auftreten. Wenn der Autor tatsächlich zum Thema KI mehr publiziert hat, und als Autorität gilt, dann hat er das wesentliche Thema hier maximal verfehlt.

„Was wir hier erleben, ist die subtilste Form der Manipulation,“ sagt der Autor. Und damit macht er sich und uns alle zum Opfer. Und bleibt fürderhin bei diesem Duktus, ein sehr zeitgeistlicher, der uns von links, rechts und der Mitte anhaucht.

Und dann wird’s ungewollt komisch, finde ich: „Sie [KI] sind die modernen Zauberspiegel aus Schneewittchen, die uns sagen, was wir hören wollen, aber nicht unbedingt die Wahrheit.“ Ich denke, der Autor gehört zu den ersten, die uns sagen werden, dass man (fast) nirgendwo heutzutage ‚die Wahrheit‘ spricht, druckt oder vernetzt.

Nachdem er ein wenig auf dieser Metapher weiter reitet, sagt er: „Was sie [KI] nicht kann: echte Orientierung geben in Fragen, die unser Leben definieren. Sie ist wie ein Kompass, der immer in die Richtung zeigt, in die wir gerade schauen.“ Das enthüllt seine Erwartung, dass KI Orientierung geben könnte. Kann KI übrigens, wenn sie genug Material hat von der Person, der Orientierung sucht, denn sie fischt sie dann aus dem ganzen Wortsalat, den wir so produzieren. Jede Wette: wenn der Autor all seine Artikel und was er sonst noch geschrieben hat, einspeist in eine KI (NotebookLLM bsw), dass diese ihm eine interessante Antwort geben kann auf die Frage: „Welche Themen wäre relevant, die ich nicht sehe oder sehen will?“ „Welche Lücken sollte ich mir näher ansehen?“ Und wenn er dann weiter mit der Antwort spielt, könnte er durchaus eine ’neue Orientierung‘ gewinnen, wenn er denn möchte.

„Was mir Sorgen macht, ist eine zu gute KI, die uns dazu verleitet, zu viele Entscheidungen zu delegieren.“ Nun, mit dieser Sorge ist der Autor gewiss nicht alleine. ABER er ist offensichtlich nicht in einem Betrieb, Gewerbe oder einem anderen Verein, der wichtige Entscheidungen fällt. Wer taktische und strategische Entscheidungen an eine KI abtritt, ist selber schuld. Wer aber in Vorbereitung solcher Entscheidungen die Recherche- und Datensammel-Fähigkeit von KIs nicht nutzt, dürfte—in der Wirtschaft jedenfalls—schon bald von Wettbewerbern überholt werden. Dass „Unternehmen […] KI oft als Vorwand […] oder als Druckmittel gegenüber Beschäftigten [nutzen]: „Du bist ersetzbar,“ ist ganz natürlich, seit es Automatisierung gibt (Erfindung des Webstuhls und massive Anwendung seit etwa 1820).

Zum Ende hin lastet der Autor (indirekt aber eindeutig) die „Post-Truth“ Situation in den US der KI an, was zwar wohlfeil aber unrichtig ist: es waren die unendlichen Lügen von Trump, seiner Kohorte und deren Gegner, die diese Situation erzeugt haben, wenn überhaupt (ich halte es vielmehr für eine Folge der Informationsrevolution, die eng mit der Ausbreitung des Internet und dem Zusammenbruch der „traditionellen Medien“ und deren Meinungshoheit verbunden ist).

Seine Schlussfolgerung ist banal, „Die größte Gefahr der künstlichen Autorität ist nicht, dass sie uns falsche Antworten gibt, sondern dass wir aufhören, uns selbst die richtigen Fragen zu stellen.“ Der Autor verpasst es allerdings, auch nur eine dieser Fragen zu stellen.

„Was er offensichtlich nicht weiß, weil er vielleicht zu selten KI nutzt …“ Das halte ich für unwahrscheinlich.

„dass einige KI’s auf Nachfrage dies explizit äußern“ Ja, auf Nachfrage, aber darum geht es nicht. Es käme vielmehr darauf an, die eigene Unsicherheit im Urteil von vornherein klarzustellen. Das tut ein LLM aber nicht, und das kann es auch nicht tun, weil es seine Sicherheit oder Unsicherheit gar nicht einschätzen kann. Wenn man es auf einen Fehler hinweist, gesteht es ihn vermeintlich zerknirscht ein und gibt auf Nachfrage eine plausibel klingende Erklärung dafür. Das tut es aber nur, weil das eben die adäquate Reaktion ist, wenn man bei einem Fehler erwischt wird. Die Erklärung nennt auch ziemlich sicher nicht den wahren Grund für die Fehlleistung, den das LLM ja gar nicht kennt. Solche Reaktionen sind eine Showveranstaltung: Das LLM verhält sich – denn darauf wurde es trainiert – so gut es eben geht wie ein Mensch in einer vergleichbaren Situation. Es kann sein Verhalten aber nicht wirklich erklären, und es lernt auch nichts aus seinen Fehlern – bei nächster Gelegenheit, wenn der Fehler nicht mehr im Puffer präsent ist, wird es denselben oder einen ähnlichen Fehler wieder machen.

Mir scheint, Sie haben meinen Kommentar nicht weiter gelesen als den einen Satz, zu dem Sie sagen, darum ginge es nicht. Anschließend erklären Sie mir, was eine LLM tun oder nicht tun kann.

Anscheinend haben sie nicht gelesen, was die LLM zu dem Problem sagte, denn es zeigt (in diesem Fall) weniger Zerknirschung, sondern vielmehr, woran es wirklich liegt: „The reward signal from reinforcement learning (and from human preference data) heavily penalises responses like “I don’t know” or “wait while I check.” Over many iterations, the model internalises the behaviour pattern: **fluency and apparent authority are scored higher than accuracy or humility**. (Das Belohnungssignal aus dem Reinforcement Learning (und aus Daten zu menschlichen Präferenzen) bestraft Antworten wie „Ich weiß es nicht“ oder „Warten Sie, während ich das überprüfe“ stark. Über viele Iterationen hinweg verinnerlicht das Modell dieses Verhaltensmuster: Flüssigkeit und scheinbare Autorität werden höher bewertet als Genauigkeit oder Bescheidenheit.)

Es is schade, dass sie sich darauf kaprizieren, zu erklären, worum es nicht geht, denn dadurch waren sie evtl. nicht in der Lage, meine Kritik an dem Artikel wahrzunehmen.

Schade eigentlich.