Es ist aktuell das vielleicht plastischste Beispiel, das man sich für die Notwendigkeit einer Kennzeichnungspflicht für KI-generierte Inhalte wünschen könnte. Als Donald Trump gestern, am 21. Juli 2025 ein synthetisches Deepfake-Video teilte, das seinen Vorgänger Barack Obama in Handschellen zeigt, war dies mehr als nur ein weiterer geschmackloser Ausfall im digitalen Schaukampf. Es war eine Demonstration im Lehrbuchformat, die eine unbequeme Wahrheit unterstreicht: Es wird immer ein Publikum geben, das für bare Münze nimmt, was technisch nur hinlänglich überzeugend dargeboten wird.

Die Episode ist ein Weckruf für all jene, die glaubten, die größte Gefahr von Deepfakes läge in perfekt inszenierten Täuschungen, die selbst Experten in die Irre führen. Die Realität ist profaner und zugleich gefährlicher. Die Zielgruppe solcher Manipulationen sind nicht die kritischen Geister, sondern jene, deren Weltbild durch solche Bilder bestätigt wird. Die menschliche Neigung, emotional auf visuelle Reize zu reagieren, öffnet den Produzenten eine völlig neue Dimension des Missbrauchs. Die Frage ist nicht, ob alle darauf hereinfallen, sondern dass genug Menschen es tun, um den gesellschaftlichen Diskurs weiter zu vergiften.

Die Demokratisierung der Täuschung

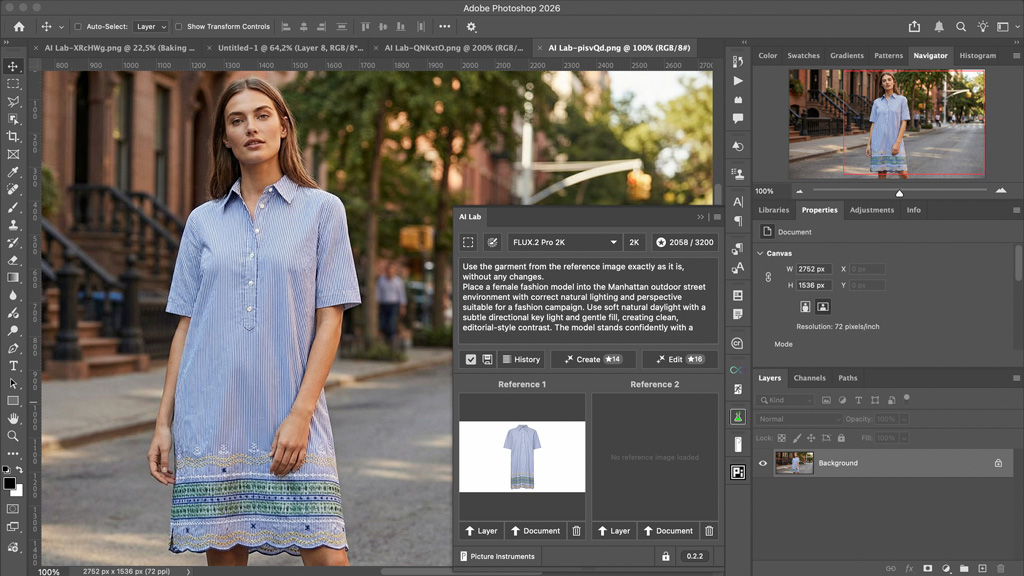

Die technologische Hürde für solche Aktionen ist praktisch nicht mehr existent. Was vor wenigen Jahren noch das teure Handwerk von Spezialisten war, ist heute ein Massenprodukt. Dank frei zugänglicher KI-Werkzeuge und Smartphone-Apps kann heute jeder zum Regisseur seiner eigenen, täuschend echten Realität werden. Diese Werkzeuge, nutzen zwei neuronale Netze, die sich gegenseitig trainieren: Ein Generator fertigt Fälschungen an, während ein Diskriminator sie auf ihre Echtheit prüft, bis das Ergebnis kaum noch vom Originalmaterial zu unterscheiden ist. Die Qualität dieser Fälschungen wird stetig besser, während die Fähigkeit zur Erkennung immer aufwendiger wird.

Das Resultat ist eine Flut an Inhalten, die von recht harmlosen Späßen – wie dem Papst in einer Daunenjacke – bis hin zu gezielten Desinformationskampagnen reicht. Der entscheidende Punkt ist die Auflösung des visuellen Konsenses. Wenn ein Bild, das eine Verhaftung zeigt, die gleiche technische Anmutung hat wie eine echte Nachrichtenaufnahme, erodiert das Fundament unseres Vertrauens in visuelle Dokumente.

Der Pakt mit dem Publikum: Warum Kennzeichnung kein Luxus ist

Genau hier liegt die Krux. Das Trump-Video ist nicht darauf ausgelegt, einen Geheimdienst zu täuschen, sondern die eigene Anhängerschaft in ihrer Überzeugung zu bestärken und die Grenzen des Sag- und Zeigbaren weiter zu verschieben. Es ist die visuelle Entsprechung eines Gerüchts, das man nur zu gerne glaubt. Ein Verbot solcher Technologien ist aussichtslos und auch nicht wünschenswert. Doch das Fehlen einer klaren, verpflichtenden Kennzeichnung – wie sie übrigens in der EU für Deepfakes ab August gilt – ist fahrlässig.

Wir haben es bereits erlebt: Ein KI-generiertes Bild einer vermeintlichen Explosion am Pentagon reichte aus, um den US-Aktienindex S&P 500 kurzzeitig absacken zu lassen. Der Schaden war real, obwohl die Ursache fiktiv war. Solche Vorfälle belegen, dass die Wirkung eines Fakes nicht von seiner unbedingten Glaubwürdigkeit abhängt, sondern von der Geschwindigkeit seiner Verbreitung und der Unfähigkeit oder dem Unwillen eines Teils des Publikums, ihn zu hinterfragen.

Eine Kennzeichnungspflicht für Deepfakes ist kein Allheilmittel, aber sie ist ein entscheidender Schritt zur Stärkung der Medienkompetenz. Sie schafft eine klare Trennlinie und gibt dem Betrachter zumindest die Chance, seine kritische Haltung zu schärfen. Sie ist ein Pakt mit dem Publikum, der besagt: Dies ist Fiktion, eine technische Spielerei, eine künstlerische oder satirische Äußerung – aber kein Abbild der Realität. Ohne diesen Pakt überlassen wir das Feld denjenigen, die die leichtgläubige Natur des Menschen als Waffe einsetzen. Die Wahrheit stirbt in diesem Krieg nicht im Kugelhagel, sondern im zustimmenden Nicken vor einem gut gemachten Fake.

Das ist ja eine gute wohlmeinende Idee und Absicht, eine Transparenz bei den Bildmedien herzustellen – bloß

bleibt die Frage: wer kontrolliert das und welche Institution verfolgt den Missbrauch?

Tja, es bleiben noch eine Menge sehr dicke Bretter zu bohren, sprich: internationale Vereinbarungen zu schaffen