Warum muss man für Kameratests die Auflösung messen?

Die Sensorauflösung einer Kamera scheint eine einfache Sache zu sein: soundso viele Pixel in der Breite mal soundso viele Pixel in der Höhe. Ganz so einfach ist es aber offenbar nicht, weshalb Kameratester die tatsächliche Auflösung messtechnisch ermitteln müssen.

Die Auflösung eines Bildes durch einen Sensor besteht darin, es in ein Raster quadratischer Pixel zu zerlegen, bei einem 24-Megapixel-Sensor beispielsweise in 6000 mal 4000 Pixel. Erfahrungsgemäß haben aber nicht alle 24-Megapixel-Kameras die gleiche Auflösung, was sich auch immer wieder in Kameratests erweist, die die effektive Auflösung meist in Linien(paaren) pro Bildhöhe angeben, seltener als Nettodateigröße – je nachdem, welches Testlabor die Werte ermittelt.

Vor 20 Jahren war ich selbst noch in diesem Metier aktiv, als ich für die ComputerFoto, die erste Fotozeitschrift, die sich allein der Digitalfotografie widmete, ein Testverfahren für Kameras entwickelte – zusammen mit meinem damaligen Kollegen Andreas Jordan, der heute beim fotoMAGAZIN das Test-Ressort leitet. Wir versuchten, den Einfluss des Objektivs möglichst auszuschließen, indem wir die Testbilder mit einem möglichst hochauflösenden Objektiv aufnahmen und auf einen für die Schärfe optimalen Blendenwert abblendeten – außerdem platzierten wir die Testcharts zur Auflösungsmessung in der Bildmitte, wo die Kontrastwiedergabe am höchsten war. Dennoch maßen wir keineswegs bei allen Kameras mit derselben Megapixelzahl dieselbe Auflösung.

Solche Auflösungsunterschiede können prinzipiell auf Unterschiede im Aufbau des Sensors zurückgehen. Wenn Lichtstrahlen in einem flachen Winkel auf den Sensor treffen, können sie die Mikrolinse und das Farbfilter eines Pixels durchlaufen, sich im Sensorchip aber weiter schräg ausbreiten und dann möglicherweise erst im Bereich eines Nachbarpixels absorbiert werden. Das Licht wird dann dem falschen Pixel und der falschen Farbe zugeordnet, was zu Unschärfe und Farbverschiebungen führt. Ein Sensor, der ein solches Übersprechen mit einer Grabenisolierung – zwischen den Pixeln werden „Gräben“ in den Chip geätzt und dann mit einem lichtundurchlässigen Material verfüllt – unterbindet, kann Details daher besser auflösen. Das ist jedoch nicht der wesentliche Grund für die Unterschiede bei der Auflösungsmessung. Diese gehen vielmehr auf das Demosaicing-Verfahren der Kamera zurück, mit dem die fehlenden Farbinformationen interpoliert werden – jedes Sensorpixel ist ja nur für eine der drei RGB-Grundfarben empfindlich. Daher misst man selbst dann oft unterschiedliche Auflösungen, wenn in zwei Kameras verschiedener Hersteller der gleiche oder fast gleiche Sensor arbeitet.

Damals, als ich noch regelmäßig Kameras testete, haben wir die Auflösung in der Horizontalen, Vertikalen und Diagonalen gemessen und die drei Messwerte gemittelt. Fast immer war die diagonale Auflösung deutlich höher als die horizontale und vertikale, denn wenn man Diagonalen durch die Sensorpixel zieht, beträgt deren Abstand nur rund 71 Prozent der Pixelbreite und -höhe. Allein Sonys Kameramodelle bildeten eine Ausnahme, denn sie lösten diagonale Strukturen nicht besser auf als waagerechte oder senkrechte Muster. Offenbar war Sonys Demosaicing-Verfahren nicht in der Lage, aus dem prinzipiell höheren Auflösungsvermögen für Diagonalen einen Nutzen zu ziehen, und so schnitt eine Sony-Kamera gegenüber beispielsweise einem Nikon-Modell mit demselben (Sony-) Sensor regelmäßig schlechter ab. Wie gesagt: Das ist lange her. Vermutlich hat Sony seinen Algorithmus mittlerweile verbessert, aber seit ich der Tretmühle der Kameratests entkommen bin, habe ich das nicht mehr verfolgt.

Die Entwicklung eines optimalen Demosaicing-Algorithmus ist eine knifflige Aufgabe, denn man muss einen guten Kompromiss finden – zwischen einem offensiven Interpolationsverfahren, das feinste Details reproduziert, und einem eher defensiven Verfahren, das Farbmoiré und verwandte Farbartefakte vermeidet. Das ist eine besonders anspruchsvollere Aufgabe, seit die Kamerahersteller immer öfter auf Tiefpassfilter vor dem Sensor verzichten, die zur Vermeidung von Moiré die optische Auflösung verringern. Eine Kamera, die besonders fein auflöst, tut dies möglicherweise um den Preis verstärkt auftretender Farbartefakte. In Kameratests des fotoMAGAZIN wird daher neben der Nettodateigröße, die ein Maß der Auflösung ist, noch eine Artefaktnote angegeben – eine reine Auflösungsmessung würde ein unvollständiges Bild von der Abbildungsqualität einer Kamera zeichnen.

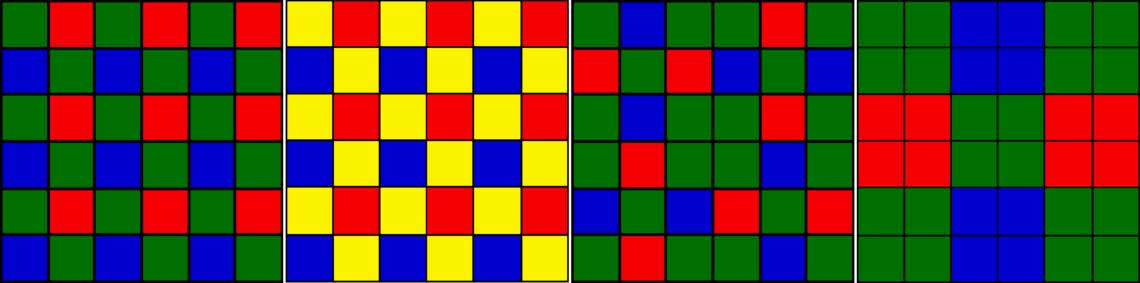

Für die Entwickler von Raw-Konvertern, die ein möglichst breites Spektrum von Kameramodellen unterstützen wollen, ist es mit einem einzigen Algorithmus nicht getan. Zwar verwenden die meisten Kameras Farbfiltermuster im Bayer-Muster, aber daneben müssen immer mehr Varianten berücksichtigt werden. Dazu gehört Fujis komplexeres X-Trans-Muster, das sich nicht alle zwei, sondern erst alle sechs Pixel wiederholt und auf diese Weise Moiré vermeiden soll, aber auch Farbfilter mit abweichenden Farben (beispielsweise Rot, Gelb und Blau oder Rot, Weiß und Blau) und Mustern (etwa das Quad-Bayer-Muster, bei dem je zwei mal zwei Sensorpixel Filter in gleicher Farbe tragen). Insbesondere bei den Kameramodulen von Smartphones gibt es eine große Vielfalt an Varianten.

Von innovativen Farbfiltermustern einmal abgesehen haben die algorithmischen Demosaicing-Verfahren mittlerweile aber einen hohen Standard erreicht, der keine dramatischen Verbesserungen mehr erwarten lässt. Die Zukunft liegt in Verfahren auf Basis neuronaler Netze wie Adobes „Details verbessern“ (oder jetzt nur noch „Verbessern“) in Lightroom und Camera Raw. Statt einen Algorithmus auszutüfteln, der möglichst feine Details ohne Artefakte produziert, werden neuronale Netze mit Milliarden von Beispielen hochaufgelöster Fotos und der zugehörigen Rohdaten trainiert. Das Netz lernt dabei kein einheitliches Verfahren für alle Bildern, sondern kann nach unterschiedlichen Motiven differenzieren; Vegetation, Hautstrukturen, Textilien oder das Wellengekräusel einer Wasseroberfläche werden auf eine jeweils eigene, angepasste Weise rekonstruiert. Die gewünschte Moiré-Unterdrückung ergibt sich dabei automatisch, denn in der Trainingsphase sieht das neuronale Netz nie Bilder, in denen ein moiré-typisches Muster das richtige Ergebnis wäre, und lernt also gar nicht erst, solche Muster zu produzieren.

Wenn es darum geht, ein neues Farbfiltermuster zu unterstützen, muss zwar ein weiteres neuronales Netz trainiert werden, aber dieser Aufwand ist von prinzipiell gleicher Art wie das Training für die bekannten Filtermuster. Man muss dazu keinen neuen Algorithmus entwickeln, was bisher meist dazu führte, dass das Demosaicing erst nach einigen Revisionen des Raw-Konverters wirklich gute Resultate lieferte – bei Fujis X-Trans-Sensoren war das beispielsweise so. Neuronale Netze fallen landläufig unter den Oberbegriff „künstliche Intelligenz“, aber mit Intelligenz hat das wenig zu tun – die Entwicklung eines optimalen Algorithmus erfordert Intelligenz, während das Training eines neuronalen Netzes vor allem eine hohe Rechenleistung erfordert – üblicherweise werden hierfür eine große Zahl parallel arbeitender Grafikchips genutzt, die die dafür ideale Prozessorarchitektur mitbringen.

Die Anwendung eines neuronalen Netzes ist viel weniger aufwendig als sein Training, nimmt die CPU und GPU eines Computers aber immer noch stark in Anspruch. Deshalb findet man solche Verfahren noch nicht in Kameras, deren Prozessoren im Interesse einer langen Batterielaufzeit möglichst wenig Strom verbrauchen sollen. Ich hoffe, dass die Elektronik künftiger Kameramodelle auch auf die schnelle Ausführung neuronaler Netze optimiert wird, etwa durch energiesparend konstruierte Koprozessoren, die einfache Rechenprozesse tausendfach parallel ausführen können, so wie es Grafikchips typischerweise tun. Dafür gäbe es eine Vielzahl nützlicher Anwendungen, von denen das Demosaicing nur eine ist. Mit einem auf neuronalen Netzen basierenden Demosaicing in der Kamera würden Kameras messbar höher auflösen (und weniger Artefakte produzieren), ohne dass dazu eine höhere Megapixelzahl nötig wäre.