Tops, Flops und ein Gendern-Highlight bei den Neuerungen in Photoshop, Camera Raw und Lightroom

Adobe hat die meiner Meinung nach besten Neuerungen dieses Jahr Camera Raw und Lightroom spendiert. Den Großteil an anderen Photoshop-Neuerungen finden Sie dieses Mal jedoch nur in der öffentlichen Beta-Version. Darunter auch die lustige „geschlechtergerechte“ Übersetzung eines neuen Text-zu-Textur-Filters.

Meine Tops und Flops der Neuerungen

Was es insgesamt an Neuerungen gibt, erfahren Sie in unserer News-Meldung oder auf der Neuerungen-Seite von Adobe – und natürlich ausführlicher im nächsten Heft (DOCMA 104). Hier möchte ich Ihnen nur meine Einschätzungen der Neuerungen mitteilen. Totalausfälle gibt es nicht, aber zwei Dinge haben mich ziemlich enttäuscht.

Neuerungen: Flops

Enttäuschend ist …

- dass der Großteil der Neuerungen nur in der öffentlichen Beta-Version von Photoshop veröffentlicht werden. Entsprechend halb fertig wirken beziehungsweise sind diese Funktionen. Nach meinen Tests können Sie die Beta-Version bedenkenlos einsetzen. Zumindest auf meinen Macs funktioniert sie stabil und zuverlässig.

- die Stagnation bei der Entwicklung der iPad-Version von Photoshop. Die Liste, was es hier im Gegensatz zur Desktop-Version an wichtigen Funktionen immer noch nicht gibt, wäre zu lang, um deren Punkte hier auch nur halbwegs aufzuzählen.

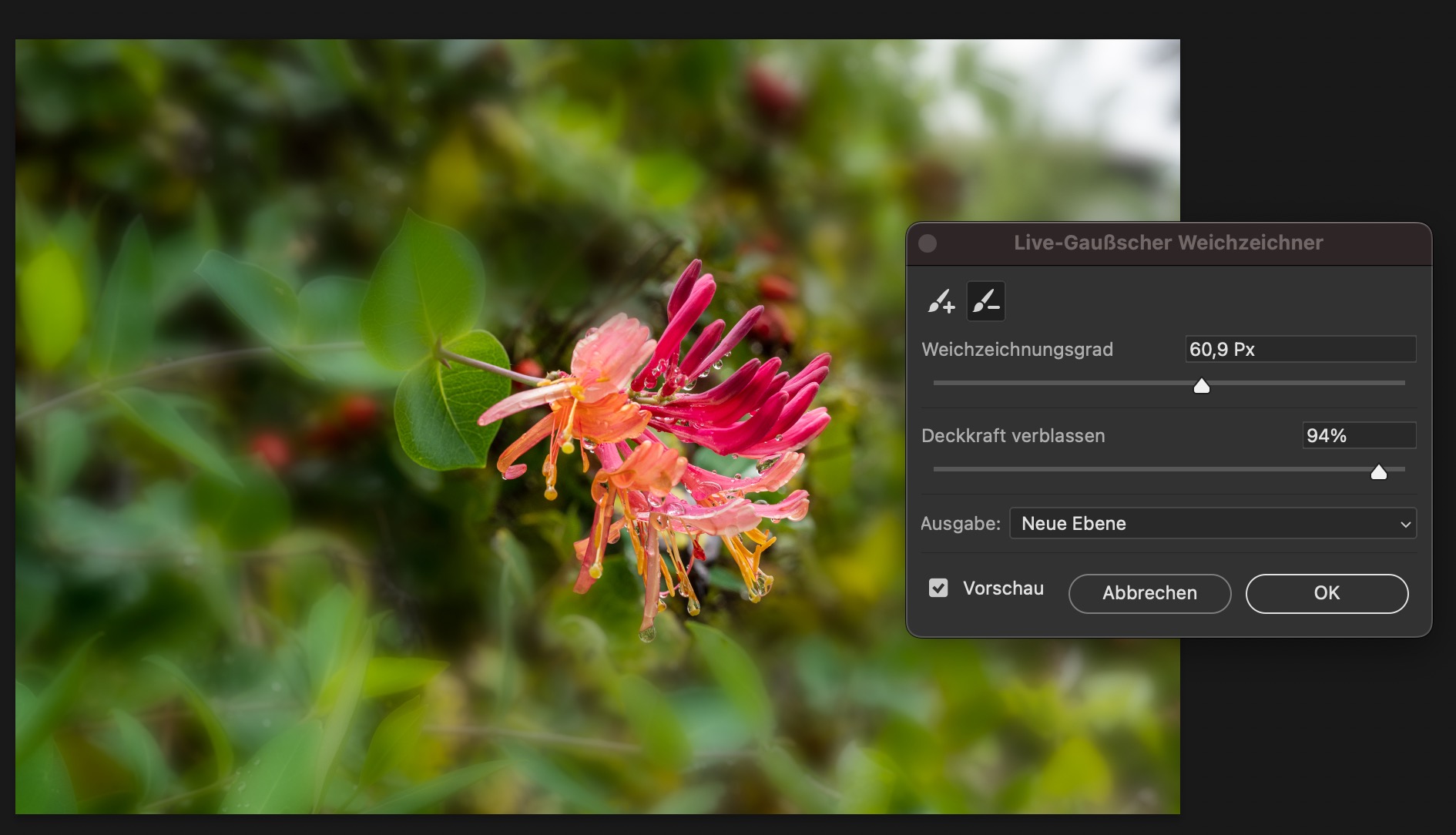

- der Live-Gaußsche Weichzeichner. Ich hatte mir nach all den technischen Verbesserungen unter der Haube von Photoshop erhofft, Filter als Einstellungsebene zu bekommen. Stattdessen kann man nun bei geöffnetem Dialog eine (ausgeblendete) Maske pinseln und Ebenenparameter ändern, während der Filterdialog offen ist. Besonders schnell ist der Filter trotz GPU-Unterstützung nicht und auch als Smartfilter lässt er sich nicht anwenden. Ich bin ja froh, dass Adobe sich auch endlich einmal der Verbesserung der klassischen Filter annimmt. Schauen wir mal, ob und was sich hier noch so in Zukunft tut und wie sich der Live-Gauß-Kollege in der Beta-Phase darüber hinaus entwickelt.

Neuerungen: Tops

Maskierung und Retusche

Wiederum echte Game-Changer sind die weiteren Verbesserungen in den Raw-Entwicklern von Adobe, also in Camera Raw, Lightroom Classic und Lightroom (Mobile/Cloud):

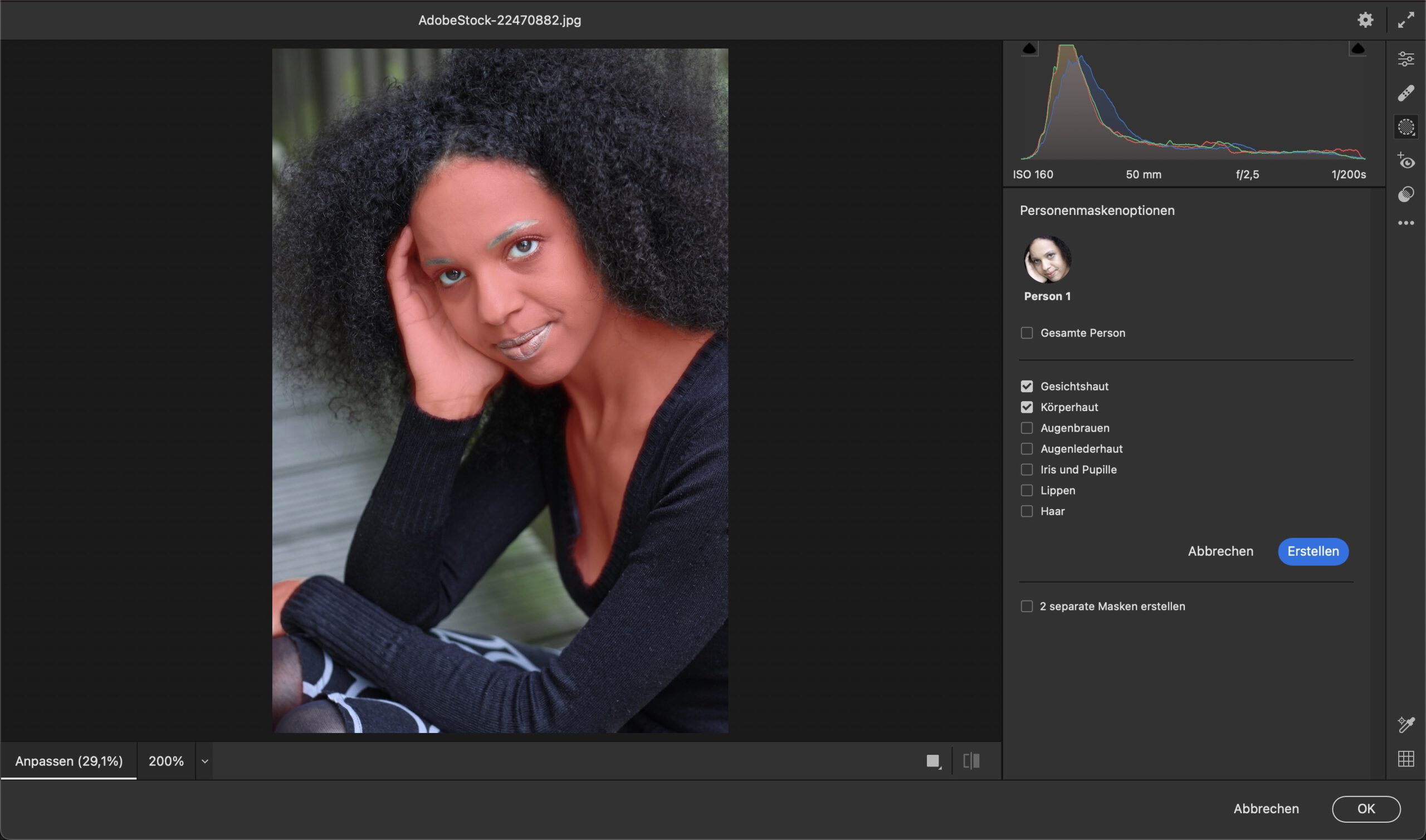

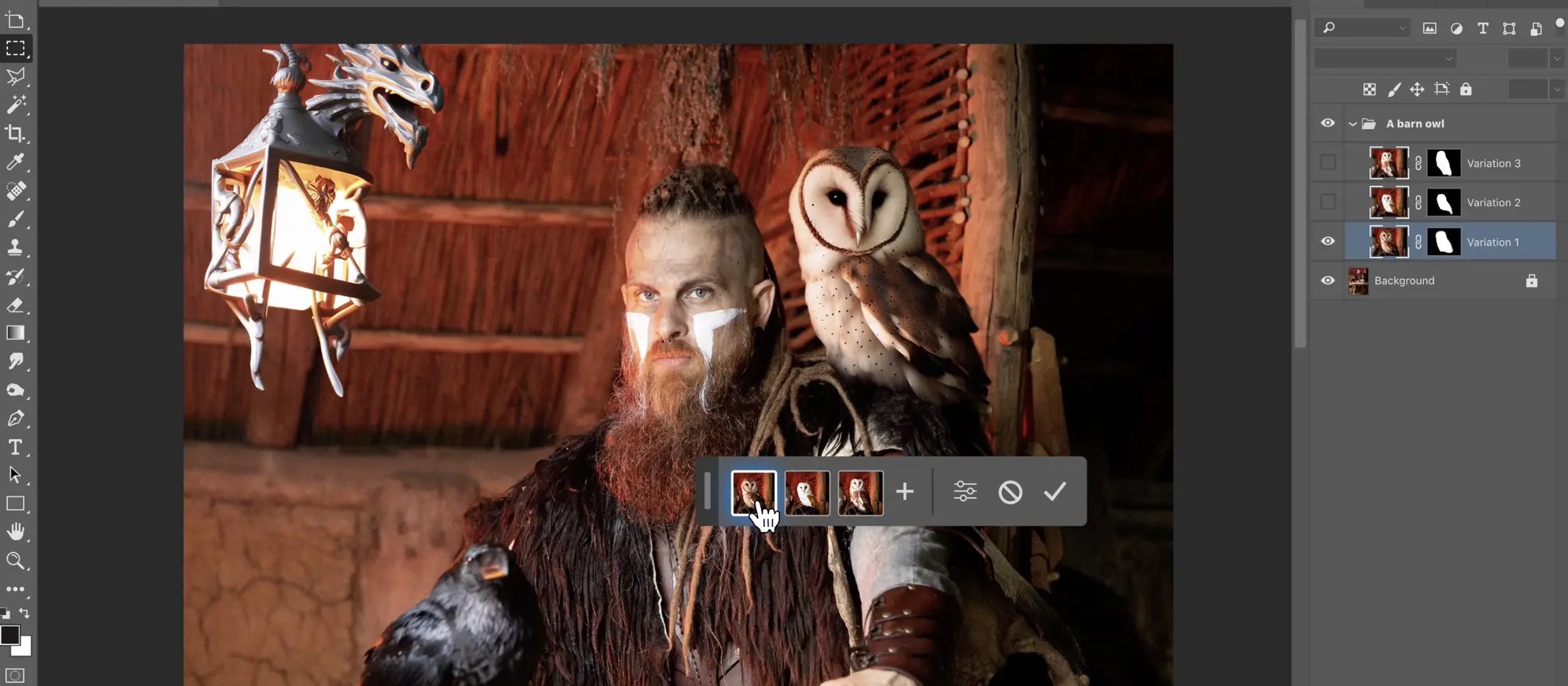

- KI-basierte Erkennung und Auswahl von Personen und Gesichts- und Körperbereichen. Gesichtshaut, Körperhaut, Frisur, Zähne, Iris, Augenweiß … auswählbar per Mausklick. Und das funktioniert erstaunlich zuverlässig und vor allem schnell. Und das Beste: Diese Auswahlen können Teil von adaptiven Presets sein. Augen und Zähne auswählen und aufhellen? Haut auswählen und Struktur optimieren? So etwas braucht zukünftig nur noch den einen Klick für das Zuweisen des Presets! Details der Masken kann man (und muss man teilweise) dennoch jederzeit optimieren. Klasse!

- KI-basierte Objektauswahl wie in Photoshop. Es funktioniert entweder per Rechteckauswahl oder durch Übermalen – die KI erkennt das Auszuwählende und verfeinert die Auswahl anschließend automatisch.

- Inhaltsbasiertes Retuschieren statt einfachem Kopieren/Reparieren. Und das heißt nichts anderes, als dass man nun für viele auch aufwendigere Retuschen gar nicht mehr zu Photoshop wechseln muss.

Dies sind beeindruckende Alltagsfunktionen, die man schon schnell nicht mehr missen will. Das Objektauswahl-Werkzeug in Photoshop selbst wurde übrigens auch verbessert. Es erkennt jetzt viel mehr Bildbereiche und erzeugt bei Haaren und Fell oft Auswahlen auf dem Niveau von „Auswahl > Motiv“. Wir nähern uns immer mehr dem Ein-Klick-Freistellen-und-Auswählen.

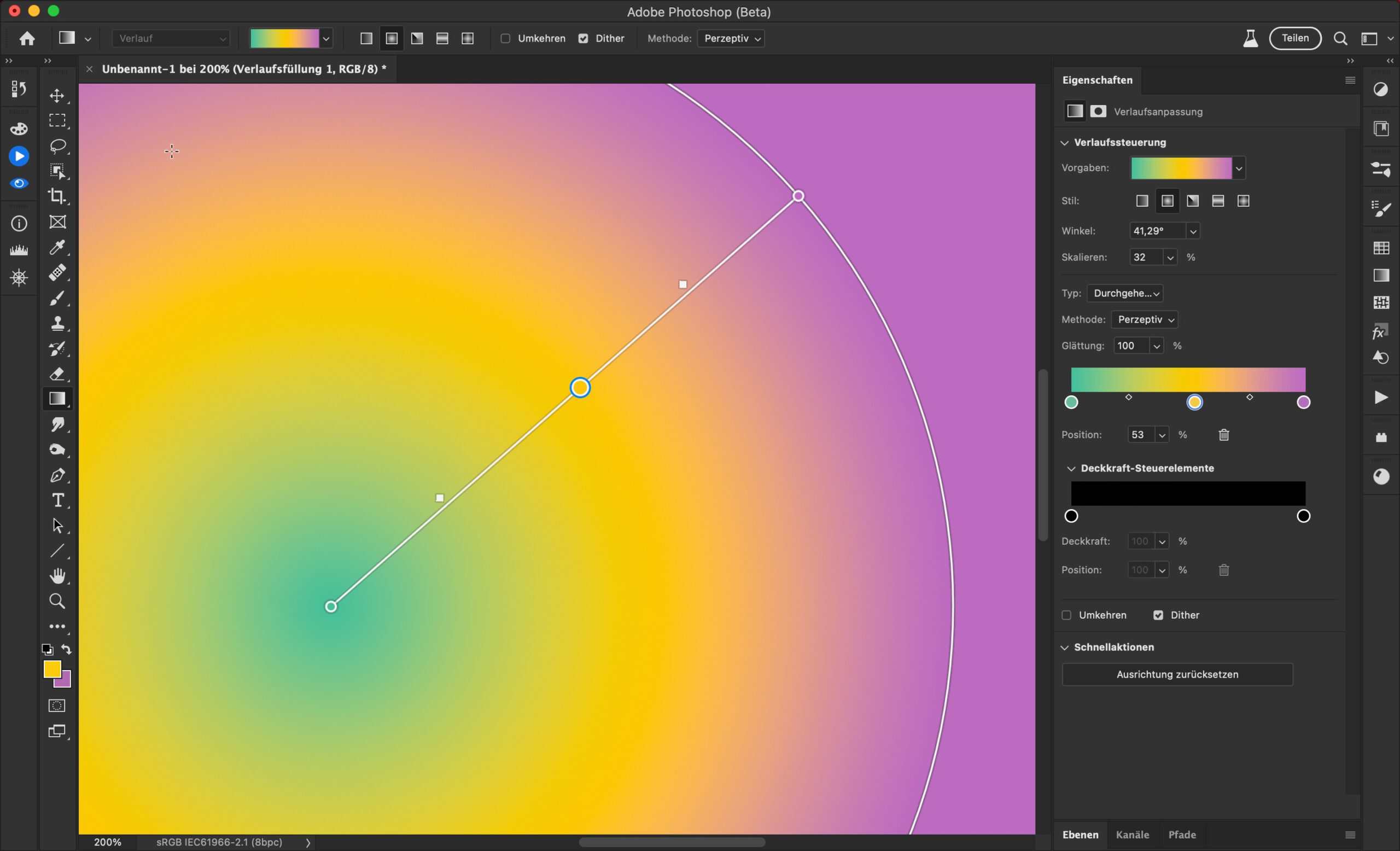

Modernes Verlaufswerkzeug

Nach Jahrzehnten Krampf mit einem Verlaufswerkzeug und einer zugehörigen Einstellungsebene, bei der die Verlaufsoptionen bis zu drei verschachtelte Dialoge tief vergraben waren, spendiert Adobe endlich ein neues Verlaufswerkzeug. Bei diesem kann man (wie übrigens in Affinity Photo von Tag 1 an), auf der Arbeitsfläche den Verlauf nicht nur mit Live-Vorschau aufziehen, sondern dort auch die Farbaufnehmer setzen und ändern. Alle übrigen Optionen findet man direkt im »Eigenschaften«-Bedienfeld. Unschön gelöst, ist das Setzen von Transparenz-Stopps über eine eigene Verlaufsleiste. Da wir es hier aber noch mit der Beta-Version zu tun haben, drücken wir einmal die Daumen, dass Adobe das noch verbessert.

Wünschenswert wäre auch, dass das Verlaufswerkzeug genauso in Masken funktioniert. Dort – und auch, falls Sie keine Einstellungsebene anlegen wollen – verhält es sich aktuell noch genauso wie das frühere Tool: ohne Live-Vorschau (man sieht das Ergebnis erst nach dem Loslassen der Maustaste) und ohne Widget auf der Arbeitsfläche.

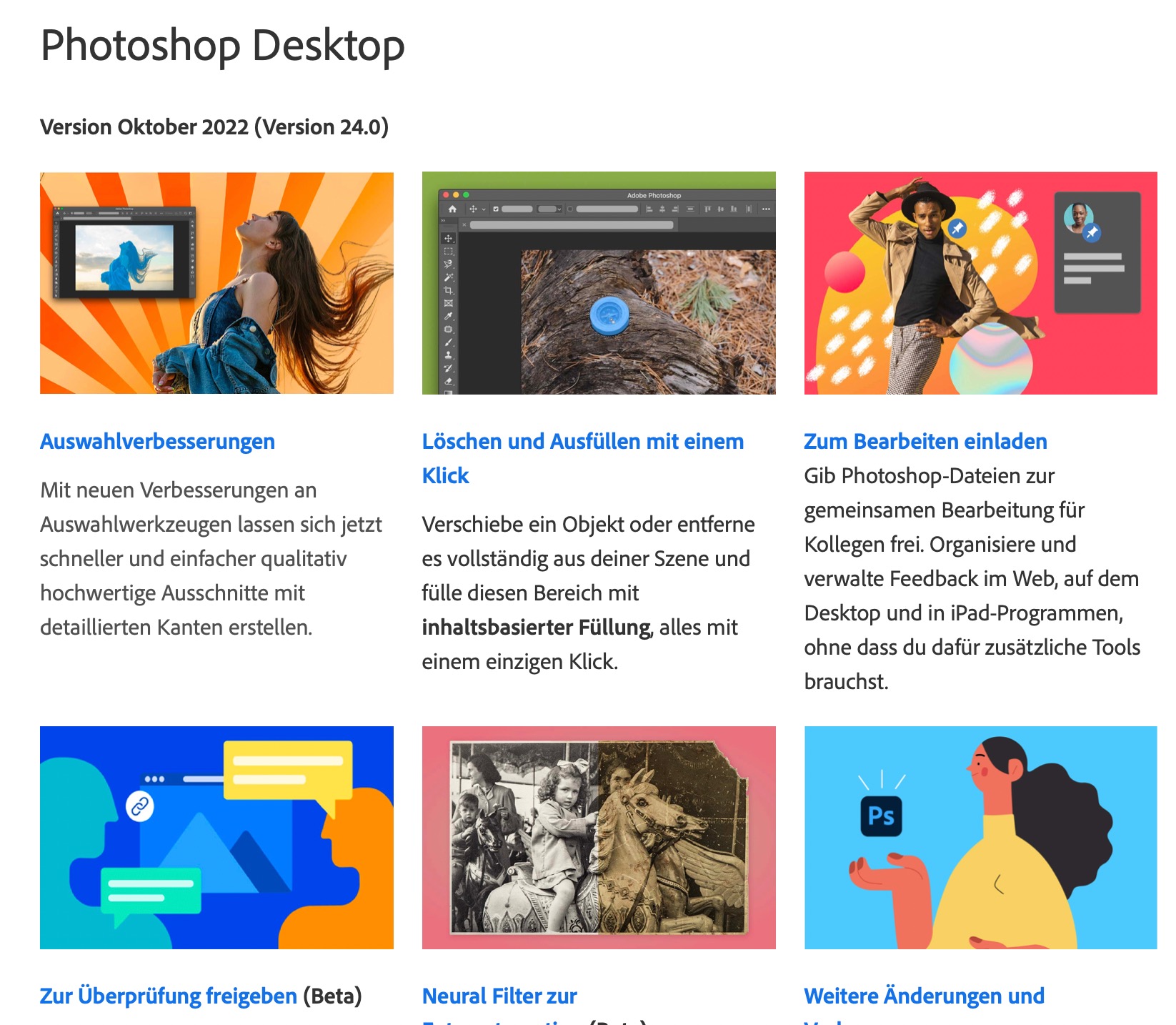

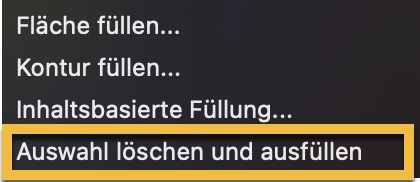

Auswahl löschen und ausfüllen

Bei dieser Funktion geht es um das Auswählen eines Objektes und dessen Löschen „mit einem Klick“ – wie Adobe es hier beschreibt. Tatsächlich benötigt man aber einen Klick mit dem Objektauswahl-Werkzeug plus einen weiteren Rechtsklick zur Wahl des Befehls aus dem Kontextmenü.

Alternativ können Sie auch das Tastenkürzel Shift-Löschen-Taste nutzen – aber der funktioniert nicht bei einer normalen Ebene oder wenn eine Datei mehrere Ebenen hat (was auch immer sich Adobe dabei gedacht hat). Das Prinzip: Photoshop erweitert die Objektauswahl um einige Pixel und füllt dann den Bereich inhaltsbasiert. Eine super Idee, um möglichst effizient Objekte aus einem Bild zu entfernen – also ohne unnötig viele Pixel zu verlieren. Würde Adobe eine kleine „Löschen-Modus“-Checkbox beim Objektauswahl-Werkzeug einbauen, hätte man tatsächlich eine Löschen-mit-einem-Klick-Funktion. Aber auf mich hört ja keiner. 😉

Kurios: Schlecht übersetzt – aber Hauptsache gegendert?!

Wer gendert, will etwas Gutes tun. Da sind wir uns vielleicht einig. Ob das Ganze überhaupt sinnvoll und nicht nur den meisten egal ist, oder sie sogar nervt (Zahlen), lasse ich einmal dahingestellt.

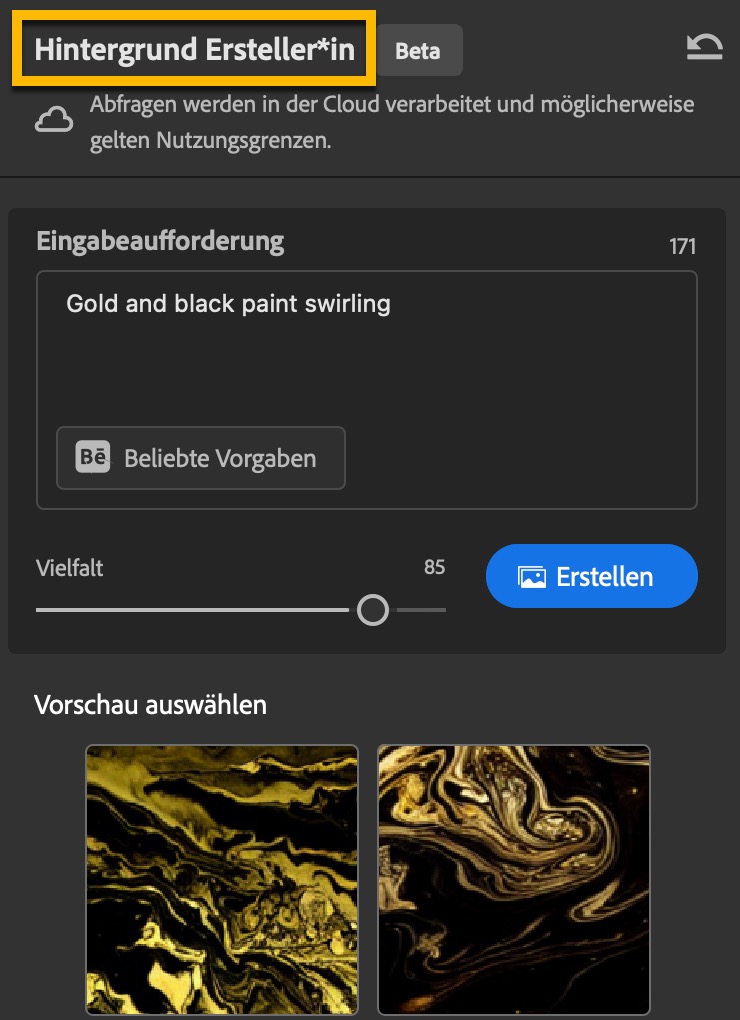

Aber den Vogel abgeschossen haben (wieder einmal) Adobes „Übersetzer:innen“. In der öffentlichen Beta-Version von Photoshop übersetzen sie die Neural Filter-Bezeichnung »Backdrop« (wörtlich: Hintergrund oder Kulisse) mit »Hintergrund Ersteller*in«.

Da wird also nicht nur ein Wort hinzugefügt, das im englischen Original doch auch nicht notwendig war. Es wird zudem noch das unsägliche „Erstellen“ benutzt, das in Newslettern und Werbetexten inflationär und generisch für alles Mögliche verwendet wird. Und dieses Wort wird auch noch gegendert. „Schön“ mit Sternchen.

Der einzige Beweggrund (neben den wie üblich mangelnden Deutschkenntnissen), der mir dafür einfällt, ist, dass die Adobe-Übersetzer davon ausgehen, dass die technologische Singularität bevorsteht und Adobe Sensei (das ist Adobes künstliche Intelligenz) die Macht übernimmt. Und die könnte natürlich ziemlich gendersensibel ausfallen und sich selbst als binär, non-binär oder techno*/bürokratisch identifizieren … und dann richtig sauer werden, wenn die Bezeichnung des neuesten Neural Filters vor der Singularität nicht genderneutral ausgefallen ist. Die künstliche Intelligenz könnte sich ja in irgendeiner Weise marginalisiert oder diskriminiert fühlen.

Also zumindest die Übersetzer der deutschen Version wären dann mit »Hintergrund Ersteller*in« auf der sicheren Seite. Es sei denn, die KI ist „bindestrich-empfindlich“ … dann wird es eng.

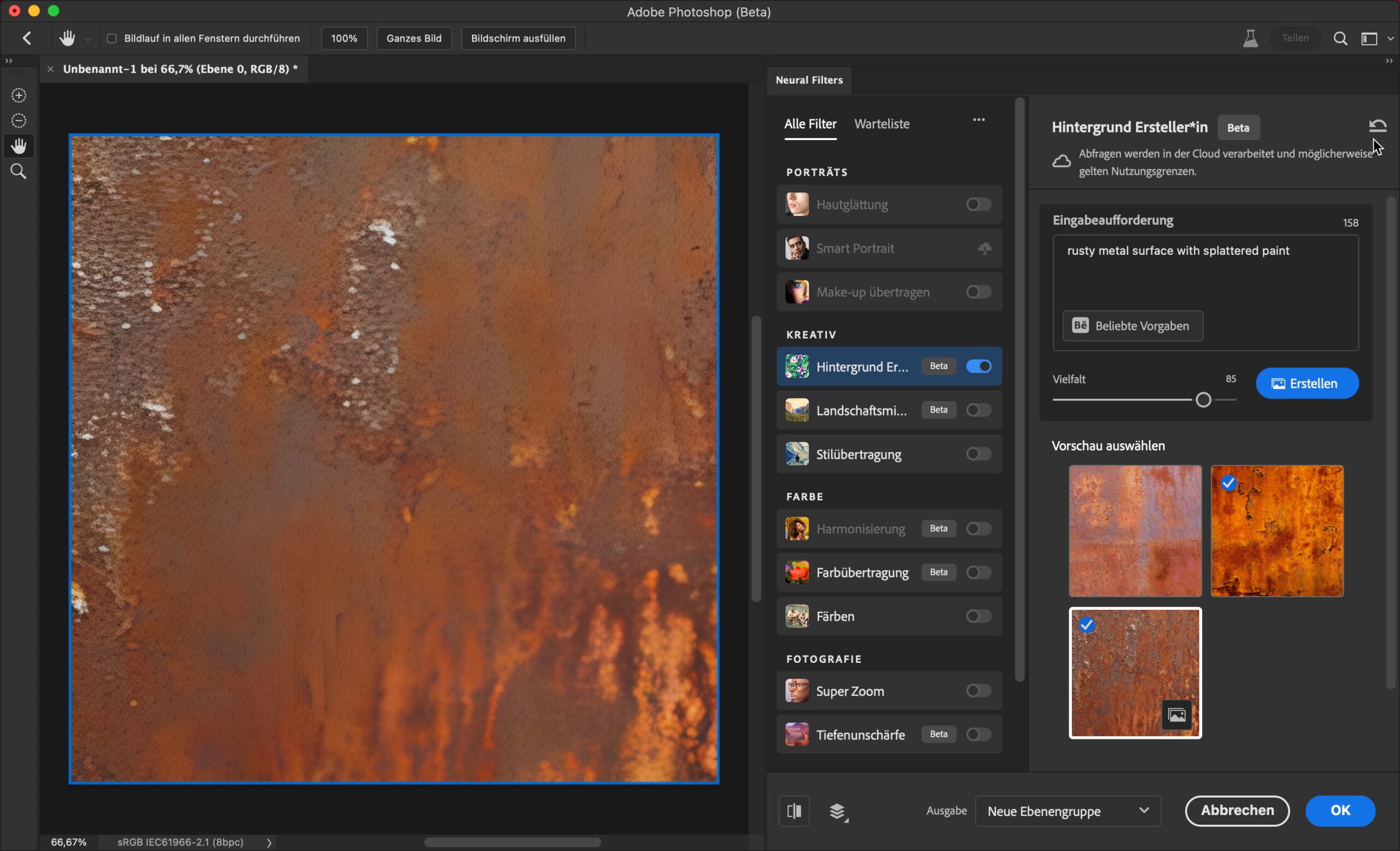

Gegenderter Filter – aber auch nützlich?

Bildkreation per Texteingabe ist eine der KI-Kerntechnologien der Zukunft (siehe mein Beitrag über die Zukunft der Bildbearbeitungstechniken). Der Backdrop-Neural-Filter ist die erste derartige Einbindung einer KI in Photoshop. Insofern ein wichtiger Schritt von Adobe. Im Hinblick auf die praktische Anwendbarkeit muss ich Ihnen aber vorerst den Wind aus den Segeln nehmen. Denn an sich funktioniert der Filter super, aber die Auflösung seiner Ergebnisse ist leider viel zu gering. Eine KI-basierte Hochskalierenfunktion wäre deshalb wünschenswert, ebenso eine Option für das Erzeugen nahtloser Muster.

Ich denke, dass Adobe diese Probleme lösen können wird. Denn technologisch sind sie bereits mehrere Schritte weiter als das, was der Backdrop-Filter jetzt schon kann. Schauen Sie sich nur einmal diese Demo an.

Wow!