Malen nach Zahlen, Teil 2

In der Bildbearbeitung mit dem Computer geht es darum, bestimmte visuelle Eindrücke zu erzeugen, und das Mittel dazu sind mathematische Berechnungen. Einige Probleme, die sich daraus ergeben, hatte ich bereits vor zwei Monaten hier geschildert, aber es gibt noch ein paar mehr.

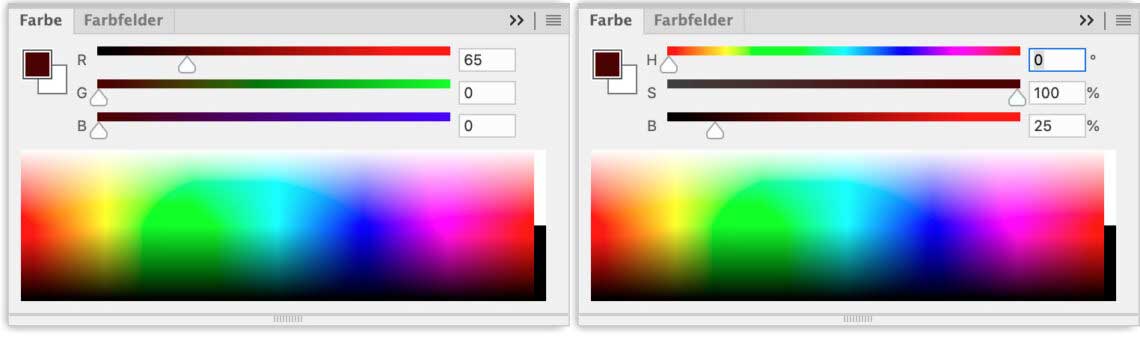

Wenn man im Farbwähler von Photoshop zwischen RGB und HSB (kurz für „Hue“, „Saturation“ und „Brightness“, also „Farbton“, „Sättigung“ und „Helligkeit“) umschaltet, zeigt sich eine Merkwürdigkeit bei der Sättigung dunkler Farben. Eine Farbe kann noch so dunkel sein – so lange wenigstens eine der drei RGB-Komponenten gleich Null ist, wird eine Sättigung von 100 Prozent angezeigt:

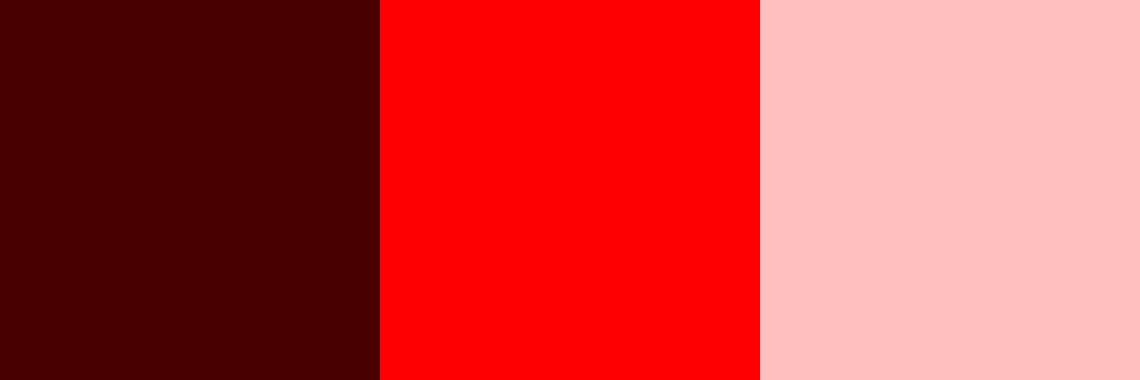

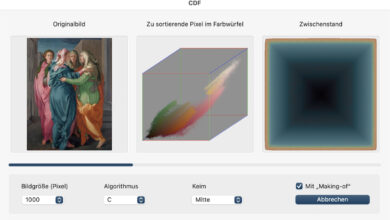

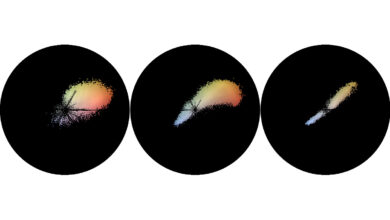

Eine solche Farbe entspricht aber kaum unserer intuitiven Vorstellung von „voll gesättigt“. Wie ich schon in der ersten Folge erwähnt hatte, beschäftige ich mich damit, die Farben in Bildern so zu charakterisieren, dass man Bilder in ihrer Farbigkeit vergleichen kann – um beispielsweise nach Bildern zu suchen, die ähnliche dominante Farben haben wie ein oder mehrere vorgegebene Bilder. Wenn das Ergebnis plausibel sein soll, muss die Charakterisierung der Farben aber unserer Intuition entsprechen. Ich habe deshalb eine andere Definition von Sättigung gewählt: Die Sättigung einer RGB-Farbe ist die Differenz des Maximums der drei RGB-Komponenten und deren Minimum. Im Beispiel oben haben wir im Rotkanal den Wert 65 (von 255) und im Grün- und Blaukanal jeweils 0; die Sättigung beträgt daher 65/255 oder 25 Prozent. Erst ein Rot mit maximaler Helligkeit gilt als vollständig gesättigt. Fügt man Grün und Blau hinzu, wird das Rot blasser, und da die Differenz damit sinkt, sinkt auch die Sättigung – so, wie es dem (oder jedenfalls meinem) visuellen Eindruck entspricht:

In diesem Beispiel hat das blasse Rot die Werte 255,190,190, so dass die Differenz zwischen der hellsten und der dunkelsten RGB-Komponente ebenso groß ist wie beim dunklen Rot. Nach meinem Verständnis sind die Farbfelder links und rechts tatsächlich gleichermaßen schwach gesättigt, während das HSB-Modell das dunkle Rot als ebenso gesättigt wie das reine Rot in der Mitte ansieht.

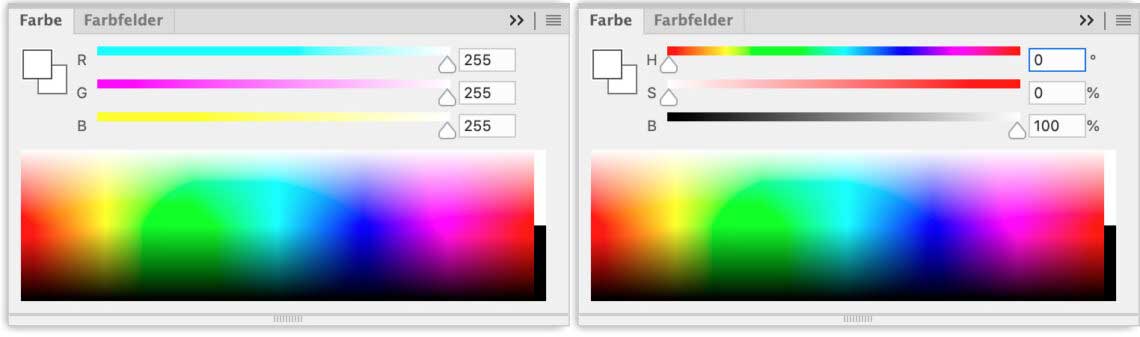

Andere Probleme gibt es bei der Helligkeit, im HSB-Modell also der Brightness. Dieser Wert entspricht dem Wert der hellsten Komponente, so dass ein Rot mit maximaler Helligkeit (255,0,0) eine Helligkeit von 100 Prozent hat:

Das erscheint zunächst plausibel – schließlich ist es ja wirklich das hellste Rot, das in einem RGB-Farbraum darstellbar ist. Aber was ist dann, wenn weitere Grundfarben hinzu kommen? Weiß entspricht im RGB-Farbmodell 255,255,255, und da RGB auf einer additiven Farbmischung beruht, bedeutet es, dass mehr Licht hinzu kommt – zum roten Licht noch ebenso viel grünes und blaues Licht. Der Brightness-Wert bleibt jedoch bei 100 Prozent; Weiß gilt also als bloß ebenso hell wie das hellste Rot:

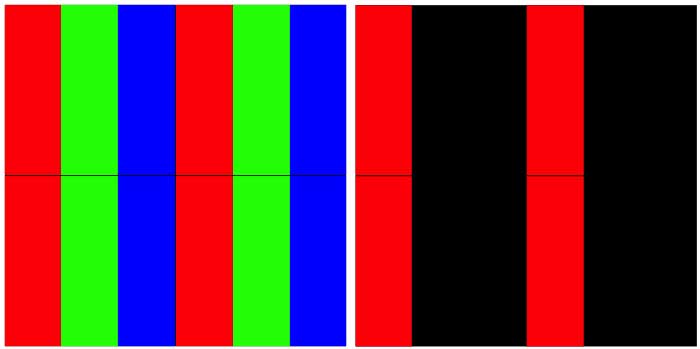

Das kann natürlich nicht stimmen. Auf einem Bildschirm sieht es so aus, dass zur Anzeige von Rot nur die roten Bildpunkte aufleuchten, zur Anzeige von Weiß aber zusätzlich die grünen und blauen; Weiß erscheint daher heller als Rot:

Genau genommen ist es noch ein bisschen komplizierter, denn selbst das hellste Rot erscheint uns weniger hell als das hellste Grün, und Blau wirkt noch einmal dunkler. Als Alternative zur Brightness bietet sich daher die Luminanz an, die ein gewichtetes Mittel der Helligkeit von Rot, Grün und Blau ist. Rot geht zu 29,9 Prozent, Grün zu 58,7 Prozent und Blau zu 11,4 Prozent in die Luminanz ein. So berechnet hat allein Weiß die größte Helligkeit; Grün fällt dagegen etwas ab und selbst die hellsten Rot- und Blautöne gelten als noch weniger hell.

Die Behandlung der Helligkeit im HSB-Modell verdeckt ein generelles Problem des RGB-Farbmodells. Die Mischfarben Cyan, Magenta und Gelb können deutlich heller als die Grundfarben Rot, Grün und Blau sein, da ja jeweils zwei Grundfarben beteiligt sind. Der maximale Brightness-Wert beträgt zwar in jedem Fall 100 Prozent, aber der visuelle Helligkeitseindruck ist keineswegs derselbe. Wenn man beispielsweise einen Verlauf zwischen reinen und Mischfarben erzeugen will, bei dem sich nur der Farbton, nicht jedoch der visuelle Helligkeitseindruck ändert, muss man sich bei den Mischfarben künstlich beschränken – das jeweils hellste Cyan, Magenta oder Gelb sind also nur eingeschränkt nutzbar. Das liegt allerdings in der Natur der Sache bei einem additiven Farbmodell und lässt sich nicht ändern.

Eine Abbildung der Wirklichkeit, soweit man das, was einem der Körper als Wirklichkeit darstellt, als Wirklichkeit bezeichnen kann, ist, wie der Begriff Abbild schon verdeutlicht, mit jedem Verfahren eine Reduzierung auf das, was die jeweiligen Möglichkeiten zulassen.

Das galt für das Zeichnen, die Malerei und auch für die Fotografie. Die Digitalisierung von Bildern setzt da noch einen drauf, denn es werden einerseits nur kleinste Ausschnitte der Wirklichkeit, nämlich die Pixel, genommen, und diese werden bei RGB auf 3 Grundfarben mit jeweils 2 hoch 8 Farbabstufungen reduziert.

Wie weit das Ergebnis von der Wirklichkeit entfernt ist zeigen ja die verschiedenen Modelle, also HSL, RGB LAB und dann die Umsetzung von Farben beim Drucken.

Die Linearität der Farb- und Helligkeitswerten entspricht eben nicht der Wahrnehmung der Augen, besonders gut erkennbar, wenn man ein kräftige Farben bei ziemlicher Dunkelheit betrachtet. Die sind dann nicht mehr kräftig.

Eine Erhöhung der Bittiefe bringt nur in der Qualität des Bildmaterials und bei der Weiterbearbeitung große Vorteile, löst jedoch nicht das Problem der Linearität.

Wie wir Farben wahrnehmen ist also nicht eine Sache der Intuition, sondern der Physiologie. Diese mit Mathematik und Algorithmen nachzubilden ist bisher nicht gelungen und wird vermutlich auch in absehbarer Zeit nicht gelingen, auch wenn uns die Marketingleute mit KI-Jubelmeldungen überschwemmen. Ich warte nur auf den ersten Reiskocher mit KI, Axela, oder wie das Ding genannt wird, wird es sicher bals integriert haben.

Bis dahin werden wir weiterhin, je nach Anwendungsfall mit verschiedenen Farbmodellen arbeiten müssen.

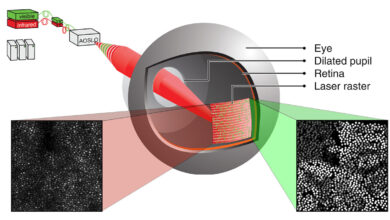

Die Unterscheidung von nur drei additiven Grundfarben durch den Sensor und im RGB-Farbmodell funktioniert, weil unsere Augen ebenfalls nur drei überlappende Wellenbereiche unterscheiden können (im visuellen Kortex wird daraus dann noch eine vierte Grundfarbe hinzugerechnet). Die Durchlasskurven der Sensor-Farbfilter werden den Empfindlichkeitsbereichen der drei Typen von Zapfen möglichst weit angeglichen, damit Kamera und Augen die gleichen Farben sehen. Früher gab es zum Beispiel oft Probleme mit Violett, das nicht zuverlässig von Blau unterschieden werden konnte.

Sowohl für unsere Augen wie für unsere Kameras ist Metamerie ein Thema: Es gibt unendlich viele Kombinationen von Wellenlängen, die den exakt gleichen Farbeindruck erzeugen. Das ist meist kein Problem (außer wenn wir nach dem Shopping feststellen, dass die gewählte Farbe draußen im Tageslicht ganz anders aussieht und die Hose nicht schwarz, sondern blau oder braun ist), aber wenn sich die Empfindlichkeitsbereiche von Auge und Sensor deutlich unterschieden, würden Farbabweichungen entstehen, die auch ein Weißabgleich nicht beheben könnte.

Eine lineare Kennlinie verwendet vor allem der Sensor; die meisten Schritte der Bildverarbeitung arbeiten mit einer nichtlinearen (annähernd logarithmischen) Kennlinie. Bis zum Demosaicing bleibt man aber besser im linearen Modus. Die Signale nichtlinearer Sensoren (die es durchaus gibt) oder die Werte eines nichtlinearen A/D-Wandlers (den es ebenfalls gibt) müsste man für die Rekonstruktion der Farbe doch wieder in die lineare Domäne umrechnen, weshalb die Kameraindustrie beim linearen Sensor und linearen A/D-Wandler geblieben ist.

Durch die spätere Umrechnung der Kennlinie wird die Tonwertauflösung allerdings ungleichmäßig – auf die höchste Lichtwertstufe entfällt die Hälfte aller Werte, auf die zweithöchste ein Viertel und so weiter. Zur Differenzierung der Schatten bleiben nur wenige Werte übrig. Wenn man die Bittiefe erhöht, tut man das daher nur zugunsten der Schatten; die Auflösung in den Lichtern ist schon bei 12 Bit unnötig hoch und kann ohne Nachteile ausgedünnt werden. Nikon geht so bei der verlustbehafteten NEF-Komprimierung vor, und Leica machte es früher ähnlich, indem sie die 14-Bit-Werte der M8 mit 4 multiplizierten und daraus die Quadratwurzel zogen. Die 8 Bit, die dabei übrig blieben, reichten erstaunlicherweise aus, um eine in der Praxis hinreichend feine Tonwertdifferenzierung zu bewahren.

Hinzuzufügen wäre noch, dass eine allzu großzügige Vergrößerung der Bittiefe wenig sinnvoll wäre – sie würde die Geschwindigkeit begrenzen, da mehr Bits auch eine längere Integrationszeit bei der A/D-Wandlung erfordern, und letztendlich auch nur Rauschen digitalisieren. Zudem wird die Bittiefe immer unwichtiger, je höher die Sensorauflösung ist – Oversampling durch eine größere Zahl kleinerer Sensorpixel macht hohe Bittiefen überflüssig. Gut möglich, dass wir irgendwann – vielleicht bei 100 MP im Kleinbildformat – wieder zu 12-Bit-Wandlern zurückkehren, weil 14 Bits keinen Vorteil mehr bringen.

»Die Unterscheidung von nur drei additiven Grundfarben durch den Sensor …«

Bei Sensoren kennen Sie sich ja bestens aus – doch welcher könnte Farben unterscheiden?! Wieder einmal eine missverständliche Formulierung, die dann Amateure von »farbempfindlichen Sensoren« palavern lässt.