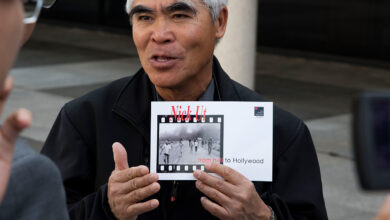

PENTAX K-3 Mark III Monochrome – APS-C-Spiegelreflexkamera für Schwarzweißfotographie

Ricoh präsentiert mit der PENTAX K-3 Mark III Monochrome eine APS-C-Spiegelreflexkamera, die ausschließlich für Schwarzweißfotographie entwickelt wurde. Das neue Modell basiert auf der PENTAX K-3 Mark III, ist jedoch mit einem Monochrom-Bildsensor ausgestattet, der nur Helligkeitsinformationen erfasst. Der CMOS-Sensor mit 25,73 Megapixeln kommt zudem ohne Tiefpassfilter aus. Die Kamera bietet drei Bildanpassungsmodi, die jeweils noch mit Einstellungen wie Tonwert, Low-key/High-key, Kontrast und Schärfe modifiziert werden können – den Standard-Modus, den Hochkontrast-Modus für besonders kontrastreiche Bilder sowie den Soft-Modus für High-Key-Aufnahmen mit reduziertem Kontrast.

Dass die Kamera nur für die Schwarzweissfotographie konzipiert ist, schlägt sich auch im Gehäusedesign und der Bedienung nieder. Das Kameramenü ist standardmäßig in Schwarz-Weiß, und die Bedienelemente und aufgedruckten Symbole sind in drei Graustufen gehalten. Hinzu kommt ein „Monochrome“-Schriftzug auf der Rückseite. Gegenüber der PENTAX K-3 Mark III gibt es außerdem noch kleinere Unterschiede bei technischen Details und Funktionen.

Die PENTAX K-3 Mark III Monochrome ist ab Ende April für 2500 Euro erhältlich. Da die Auflage limitiert ist, kann es laut Ricoh zu Lieferverzögerungen kommen. Weitere Informationen finden Sie auf den Pentax-Internetseiten.

»… ist jedoch mit einem Monochrom-Bildsensor ausgestattet, der nur Helligkeitsinformationen erfasst.«

Welcher Sensor kann mehr als nur Helligkeitsinfos erfassen? Welcher Sensor ist nicht Monochrom?

…

…

Brennweitenverlängerung …!?

Schärfentiefe abhängig vom Bildformat … !?

Wann hört der Unfug auf?

Die meisten Sensoren können Farbinformationen erfassen, weil vor jedem Sensorpixel ein Farbfilter sitzt – meist in den Farben Rot, Grün oder Blau. Die Sensorpixel messen daher nicht die Gesamthelligkeit, sondern die Helligkeit im roten, grünen beziehungsweise blauen Teil des sichtbaren Spektrums. (Das ist etwas vereinfacht, weil sich die Durchlassbereiche der Filter tatsächlich überlappen, was entscheidend für die Unterscheidung der Farbtöne zwischen den drei Grundfarben ist.) Beim Demosaicing in der Kamera oder im Raw-Konverter werden aus den Sensordaten vollständige RGB-Pixel berechnet, indem die fehlenden beiden Grundfarben aus den für diese Farben empfindlichen Nachbarpixeln interpoliert werden, und erst aus diesen RGB-Pixeln lassen sich am Ende auch Helligkeitsinformationen berechnen, wie es bei einer nachträglichen Schwarzweißumsetzung von Farbbildern geschieht.

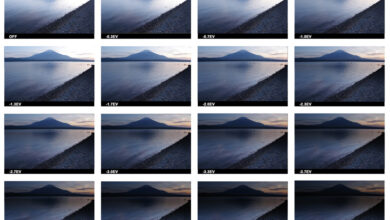

Bei einem monochromen Sensor ohne Farbfilter (und ohne ein daher unnötiges Tiefpassfilter) registriert jedes Sensorpixel die vollständigen Helligkeitsinformationen, woraus ein monochromer Sensor seine hohe effektive Auflösung gewinnt. Ein monochromer 26-MP-Sensor kann tatsächlich 26 Millionen Pixel auflösen, während die effektive Auflösung eines 26-MP-Farbsensors nur etwa halb so groß ist – sie entspricht annähernd der Zahl der grünempfindlichen Sensorpixel, deren Anteil bei Verwendung des Bayer-Farbfiltermusters 50 Prozent beträgt.

Unterschiede zeigen sich auch beim Rauschen: Im Farbsensor entsteht aufgrund der Farbfilter neben dem Luminanzrauschen das (meist störendere) Farbrauschen, also zufällige Abweichungen der Farbe vom Sollwert. Eine nachträgliche Schwarzweißumsetzung macht aus dem Farbrauschen wiederum zusätzliches Helligkeitsrauschen. Die Bilder monochromer Sensoren enthalten nur das ursprüngliche Helligkeitsrauschen, das zudem sehr feinkörnig ist. Erfahrungsgemäß ist es unnötig und lohnt sich auch kaum, dieses Rauschen zu unterdrücken, was ja auch mit einem Verlust an Auflösung und Schärfe verbunden wäre.

Spezialkameras, wie sie beispielsweise in Raumsonden verwendet werden, verwenden statt Filtern vor jedem Sensorpixel ein Filterrad mit verschiedenen Farbfiltern, die nacheinander den ganzen Sensor bedecken. Aus nacheinander aufgenommenen Farbauszügen lässt sich ohne Interpolation ein Farbbild zusammensetzen, womit der Auflösungsverlust vermieden wird. Diese Technik kennt man natürlich schon aus der Frühzeit der Farbfotografie, etwa den Fotos von Adolf Miethe (zum Beispiel https://upload.wikimedia.org/wikipedia/commons/f/f6/Color_photograph_by_Adolf_Miethe_1902.jpg).

NEIN, weder einzelne Sensorpixel oder deren Zusammensetzung zum komplexen Sensor können FARBinformationen erfassen. Sensoren können lediglich Licht in elektrische Spannung wandeln – viel Licht = viel Strom, weniger Licht = weniger Strom. Und da jedes Sensorpixel gleich dem Benachbarten ist, sind es immer nur unterschiedliche Helligkeitsinformationen. Roten, blauen oder grünen Strom können Sensoren nicht erzeugen.

.

Allerdings macht man sich die Tatsache zu nutzen, dass durch Farbfilter bestimmte Lichtspektren herausgefiltert werden, weshalb weniger Licht auf dem einzelnen Sensorpixel ankommt. Da nun drei verschiedene Filter installiert sind, kommt es zu mehr oder weniger großen Differenzen bei den Spannungen. Diese messbaren Unterschiede sind allerdings keineswegs schon Farben – vielmehr werden solche per DEFINITION zugewiesen. Farben werden willkürlich festgelegt, auch wenn sie nachvollziehbar bei »normalen« Kameras weitestgehend denen entsprechen, die Menschen wahrnehmen können. Doch so ist es möglich, auch Wärmebildkameras »normale« Farben wie rot, blau, gelb oder grün zuzuordnen, obwohl diese Kameras mit Sicherheit ein anderes Spektrum sehen, als ein Menschen wahrnehmen kann.

Wer sich jedoch nicht vorstellen kann, wie aus unterschiedlichen Helligkeiten Farben definiert werden, der soll sich einmal in Photoshop die einzelnen Kanäle einer Bilddatei anschauen.

.

Eine Unterscheidung in Farbsensoren und monochrome Sensoren ist schlicht unsinnig. Erst wenn die von Sensoren ausgegebenen Informationen (beispielsweise durch ein Bayermosaikfilter) manipuliert werden, können Farben errechnet bzw. definiert werden.

.

Bedauerlich ist, dass Tatsachen häufig solange vereinfacht werden, bis nur noch Halbwissen übrig bleibt. Dies mag populistisch und anschaulich sein, ist aber grundsätzlich FALSCH.

Tja, wie es schon in dem alter Witz heißt: „EIN Geisterfahrer? Hunderte!“

Will heißen: Wenn man merkt, dass man mit seiner Sicht der Dinge alleine da steht, sollte es Grund genug sein, mal darüber nachzudenken, ob man nicht selbst falsch liegt.

Ich erkläre solche Dinge ja nicht, weil ich Sie zu überzeugen hoffe, aber es gibt genug andere Leser, die ich etwas klüger machen kann.

Sicher haben Sie sich in Ihrer Tätigkeit vieles angelesen. Und ich wünschte mir, Sie würden auch verstehen, von was Sie schreiben. Jedoch sind Sie leider nur ein Paradebeispiel des Peter-Prinzips.

Lieber elliz, wir haben inzwischen alle verstanden, dass Sie mit unserer Beschränktheit Ihre Probleme haben. Und das seit vielen Jahren. Wie wäre es, wenn Sie unsere Texte einfach einfach nicht mehr lesen? Dann müssen Sie sich auch nicht so erregen. Ich zumindest bin von Ihrem Kluggescheiße maximal genervt. Und ich vermute, viele andere sind es ebenfalls. Also seien Sie bitte so nett und kommentieren Sie woanders.

ich gebe ja auch gern mal den klugscheißer und spalte gern haare, aber hier muss ich mal partei für den artikelverfasser ergreifen.

mir ist ehrlich gesagt schon immer scheißegal, auf welchen technisch-physikjalischen gesetzmäßigkeiten meine fotozeugs basiert, solange ich verstehe, was für mich PRAXISRELEVANT ist.beispiel:

ich muss verstehen, welche bildwirkung die verstellung der blende hat, damit ich sie gezielt nutzen kann, um eine bildwirkung zu erreichen, die ich beabsichtige. WESHALB diese bildwirkung durch eine blendenverstellung erzielt wird, ist mir da vollkommen schnurzpiepwurstegal.

ganz genau so ist das bei unterschiedlichen verfügbaren sensoren und deren auswirkungen.

die DOCMA ist – soweit ich das verstehe – ein (populär-informatives) magazin für anwender, nicht für wissenschaftler.

ich muss auch nicht wissen, wie strom funktioniert oder welche chemischen grundlagen waschmittel möglich machen, um meine wäsche zu waschen – mich interessiert nur, welche knöpfe ich drücken und wie viele löffen pulver ich reintun muss, damit meine wäsch sauber wird…

NERD-kommentare sind zwar manchmal interessant, aber eben nur periphär bedeutsam – in diesem fall nichtmal unterhaltsam, sondern nur lästig (und verbessert hier noch nicht einmal den inhaltlichen ertrag des Artikels!).

@elliz: setzen, sechs!

Wobei wir bei DOCMA schon darauf achten, dass wir auch komplexe Sachverhalte korrekt erklären. Vor Jahren las ich mal in irgendeinem (wohl nicht mehr existierenden) Magazin eine Erklärung, wie Bezierkurven funktionieren. Diese Erklärung konnte man leicht nachvollziehen, aber wenn man das tat, stellte es sich heraus, dass sie völlig falsch war. Der Autor rechtfertigte sich damit, dass seine Erklärung vielleicht nicht richtig, aber wenigstens verständlich sei … So etwas soll es bei uns nicht geben, und diesem Anspruch werden wir auch meist gerecht.

leider kann ich meinen kommentar nicht editieren und habe zu schnell abgeschickt – ich bitte die zu vielen tippfehler zu entschuligen.