Laser Eyes – die LiDAR-Technologie

Die LiDAR-Technologie, mit der beispielsweise autonome Fahrzeuge ihre Umgebung abtasten und so andere Verkehrsteilnehmer erkennen, findet neuerdings auch Eingang in Smartphones wie dem iPhone 12 Pro (Max). Wie funktionieren die immer weiter miniaturisierten LiDAR-Module und wozu sind sie aus fotografischer Sicht gut?

„LiDAR“ klingt ein bisschen wie „Radar“, und die Abkürzung hat auch den gleichen Ursprung: LiDAR ist ein Radar, das mit Licht statt mit Mikrowellen arbeitet. Ein LiDAR-Modul schickt einen – infraroten und daher unsichtbaren – Laserimpuls aus, misst die Zeit, bis das reflektierte Licht zurückkehrt, und berechnet aus der Verzögerung, wie weit das reflektierende Objekt entfernt ist.

Nun ist Licht mit Lichtgeschwindigkeit unterwegs und folglich sehr schnell; die Strecke zum Mond legt es in wenig mehr als einer Sekunde zurück. Von einem ein paar Meter oder nur Zentimeter entfernten Objekt ist das reflektierte Licht so schnell wieder zurück, dass Zeiten im Bereich von Picosekunden gemessen werden müssen, wenn die so ermittelte Entfernung hinreichend präzise sein soll.

Manche LiDAR-Geräte tasten die Umgebung mit einem beweglichen Laser ab, ähnlich wie eine rotierende Radar-Antenne. Für den Einsatz im Umfeld der Fotografie ist allerdings ein Flash-LiDAR interessanter, das einen breit aufgefächerten Laserblitz aussendet, der das gesamte Bildfeld einer gekoppelten Kamera abdeckt. Ein Time-of-Flight-Bildsensor (ToF) dient als Empfänger, und ein solcher Sensor registriert nicht die Helligkeit des Lichts, das auf die einzelnen Sensorpixel trifft, sondern die Zeit, die zwischen dem Laserblitz und dem Auftreffen der reflektierten Photonen vergeht. ToF-Sensoren sind für Sensorhersteller ein wichtiges Produktsegment geworden, was zu einem großen Teil auf die Nachfrage aus der Automobilindustrie zurückgeht.

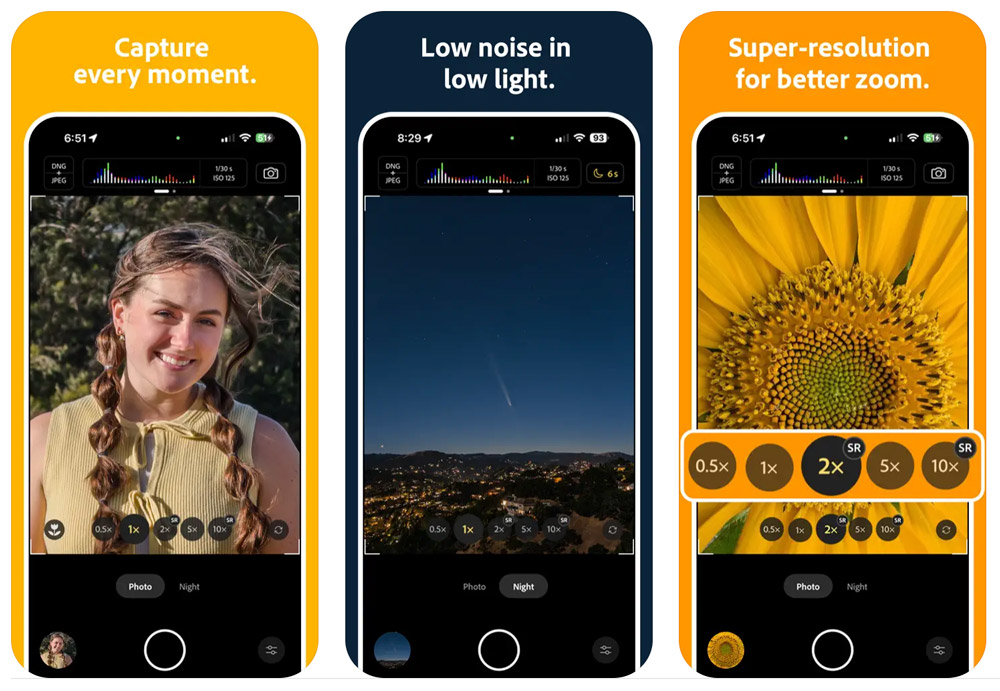

Ein LiDAR-Modul erzeugt eine Tiefenkarte, was für sich genommen noch nichts Neues ist. Viele Smartphones haben zwei oder mehr Kameramodule, die auf Basis der Parallaxe zwischen zwei Kameras eine solche Tiefenkarte berechnen können. Ein LiDAR liefert aber nicht nur präzisere Ergebnisse, insbesondere bei größeren Entfernungen, sondern es ist auch unabhängig von den Lichtverhältnissen, da es ja sein eigenes Licht produziert. Eine Simulation der Hintergrundunschärfe, die auf Basis einer Tiefenkarte erzeugt wird, funktioniert damit auch bei schummrigem Licht.

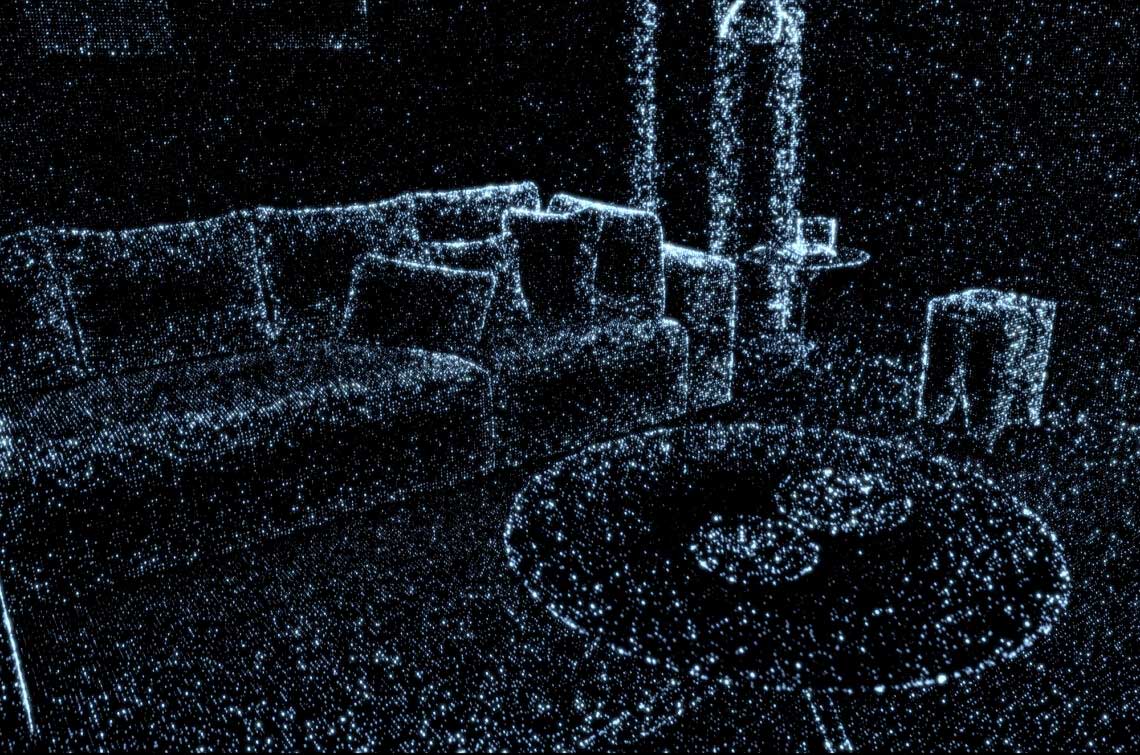

Apple scheint hinsichtlich der LiDAR-Technologie vor allem Anwendungen im Bereich der Augmented Reality im Sinn zu haben. Um einer realen, von einer der Kameras des Smartphones erfassten Szene künstlich erzeugte Objekte zu überlagern, muss sich das Smartphone präzise in der dreidimensionalen Umwelt orientieren können, und ein LiDAR schafft die dazu nötige Basis. Daneben sind aber auch viele andere fotografische Anwendungen denkbar, also beispielsweise beim Autofokus und zur automatischen Szenenerkennung. Aus einem Schwenk durch einen Raum könnte das Smartphone auch ein dreidimensionales Modell erzeugen. Wie man so sagt: Everything’s better with Lasers!

In der Fotografie haben sich TTL-Autofokusverfahren durchgesetzt, die also das vom Objektiv erzeugte Bild auswerten. Polaroid hatte früher Sofortbildkameras mit einem Ultraschallentfernungsmesser gebaut, der die Laufzeit von Ultraschallsignalen auswertete. Für Kameras mit Wechselobjektiven hätte das allerdings nicht so gut funktioniert. Bei langen Brennweiten wäre es kaum noch möglich, ein Motiv gezielt anzumessen, ganz abgesehen davon, dass man ja auch weit entfernte Motive fokussieren möchte, die der Ultraschall-AF gar nicht mehr erreicht. Mit Licht statt Ultraschall und einem ToF-Sensor könnte das etwas besser funktionieren, aber auch nur für Entfernungen bis zu ein paar Metern. Mit einem gerichteten Laserstrahl, der die Umgebung abtastet, sind größere Reichweiten von einem Kilometer und sogar noch mehr möglich, abhängig von der Leistung des Lasers, aber solche Geräte eignen sich nicht für den Einbau in Kameras.

Bei Smartphones sieht die Sache anders aus, denn die Brennweiten sind überwiegend kurz (selbst als Tele apostrophierte Objektive sind meist eher Normalbrennweiten), die Schärfentiefe ist groß, der AF muss nicht sehr präzise sein und größere Entfernungen sind für die Belange der Fokussierung sowieso „unendlich“. Der Vorteil eines LiDAR für den Autofokus liegt hier nicht so sehr in der Präzision, sondern darin, dass ein ToF-Sensor sehr schnell ein relativ hoch aufgelöstes Tiefenbild erzeugt, das die Kamera auswerten kann. Es ist weniger eine bloße Entfernungsmessung als die Konstruktion eines 3D-Modells der Umgebung, das zum Beispiel auch die Motivverfolgung unterstützen kann, so dass der Fokus einem Motiv nachgeführt wird, das sich innerhalb des Bildfelds bewegt. Klassische Kameras ließen sich durch ein LiDAR-Modul erweitern, aber es könnte den Phasendetektions- oder Kontrast-AF nur ergänzen, nicht ersetzen.