Bilder einer Ausstellung: KI und Musik

Um KI kommt man heutzutage in keinem Lebensbereich mehr herum, wie man auch in der Ausstellung Can you hear it? im Hamburger Museum für Kunst & Gewerbe sieht.

Dabei begann die Planung der heute eröffneten Ausstellung schon vor zwei Jahren, also vor dem aktuellen Hype um die generative KI. Die Kuratoren Prof. Rolf Bader (Institut für Systematische Musikwissenschaft der Universität Hamburg) und Olaf Kirsch (Museum für Kunst & Gewerbe) haben verschiedene Anwendungen der KI zur Analyse, Klassifikation und Generierung von Musik ausgewählt und in zehn Abteilungen präsentiert – teilweise wird auch Unternehmen die Gelegenheit gegeben, ihre Produkte anzupreisen, etwa für eine bessere Analyse der musikalischen Vorlieben von Kunden der Streamingdienste, um ihnen nicht nur Varianten des immer Gleichen zu präsentieren.

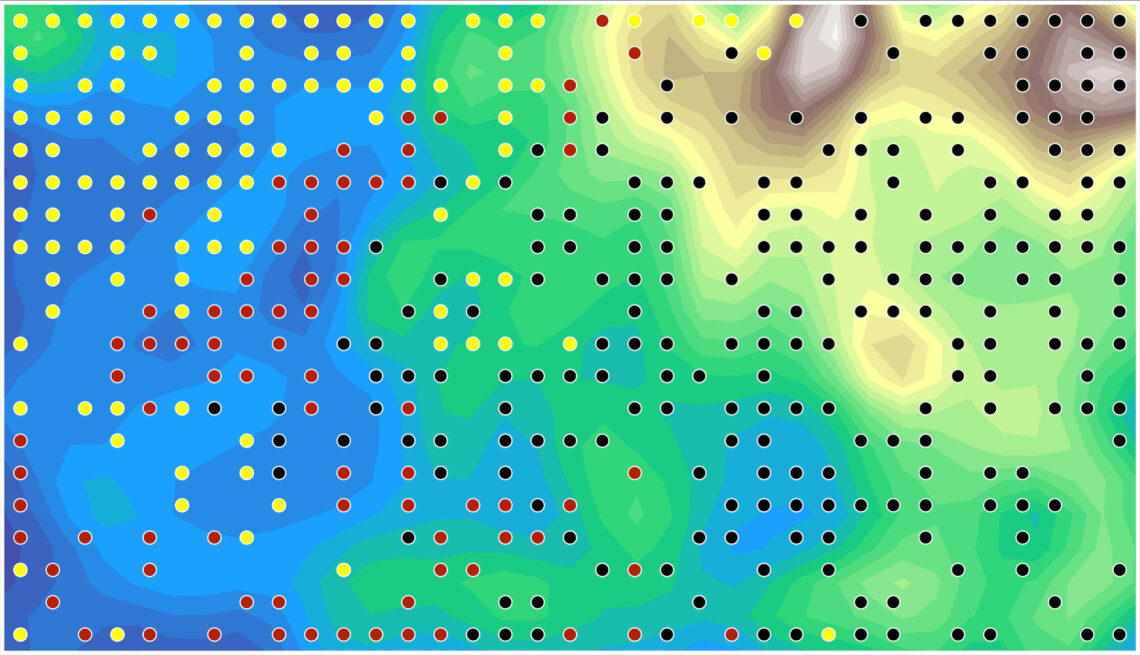

Viele Präsentationen arbeiten mit selbstorganisierenden Karten (nach ihrem Erfinder Teuvo Kohonen auch Kohonen-Karten genannt), einer zweidimensionalen Art von neuronalen Netzen, die sich im Training so organisieren, dass ähnliche Inputs benachbarte Neuronen anregen. Eine Visualisierung solcher Netze macht Ähnlichkeiten augenfällig, und in der Ausstellung wird beispielsweise gezeigt, wie sich auf diese Weise verschiedene Hip-Hop-Stile unterscheiden lassen, oder wie sich der Klang eines Flügels verändert hat, nachdem er ein Jahr bespielt worden ist. Musikwissenschaftler trauen sich auch zu, verschiedene Ethnien anhand ihrer bevorzugten Musik zu unterscheiden, was zuverlässiger als eine Unterscheidung nach der Sprache sein soll. Übrigens finden selbstorganisierende Karten auch Anwendung in der Bildbearbeitung: Man kann damit unter anderem die Zahl der Farben eines Bildes so reduzieren, dass der Verlust möglichst unmerklich bleibt, indem viel genutzte Farbbereiche feiner aufgelöst werden als solche, die seltener im Bild vorkommen.

Der große Vorteil der zweidimensionalen Karten gegenüber Deep Neural Networks aus mehreren Schichten besteht darin, dass man ihnen ansehen kann, was sie gelernt haben; als Bild dargestellt können sie sogar helfen, Unterschiede verschiedener Klassen von Inputs anschaulich zu machen. Es wären wohl auch Anwendungen in der Analyse großer Bildbestände denkbar, indem man die Ausprägungen verschiedener formaler Bildmerkmale in einer solchen Karte darstellt.

Natürlich darf auch eine generative KI nicht fehlen, in diesem Fall die Software Ricercar, die Musik im Stil verschiedener Komponisten von Bach über Beethoven bis Schumann erzeugt. Das Prinzip gleicht dem der großen Sprachmodelle, wie sie ChatGPT und Bard zugrunde liegen: Die Software hat anhand von 25.000 klassischen Stücken gelernt, welche Noten mit größter Wahrscheinlichkeit auf ein vorgegebenes Fragment folgen. Die so generierten Kompositionen beginnen dann mit ein paar originalen Noten eines Komponisten, beispielsweise dem vertrauten Da da da Damm von Beethovens 5. Sinfonie, lassen aber auf sich gestellt dann jede Inspiration vermissen und erschöpfen sich in willenlosen Wiederholungen und Geklimper – das Niveau, das generative KI-Systeme im Bereich von Bildern und Texten erreichen, lässt Ricercar im Bereich der Musik noch vermissen.

Die Ausstellung geht dann allerdings über die bekannten KI-Ansätze hinaus und zeigt, was stattdessen mit dem Verfahren des Physical Modeling möglich ist. Die Idee ist, das Verhalten einzelner Teile von Musikinstrumenten durch nichtlineare Gleichungen zu beschreiben und auf dieser Basis die Klangerzeugung zu simulieren. In ähnlicher Weise ist auch das Zusammenspiel mehrerer Musiker modellierbar, also wie beispielsweise improvisierende Jazzmusiker auf ihre Kollegen eingehen. Der Ausstellungsbesucher kann zu einer Musik tanzen, die er mit seinen Tanzschritten wiederum in Geschwindigkeit und Rhythmus beeinflusst; die Musik passt sich so dem Tänzer an. Übertragen auf die Bilddomäne entspräche dem Physical Modeling eher die 3D-Modellierung als der generativen KI als Methode zur Bilderzeugung.

Die Ausstellung Can you hear it? ist noch bis zum 31. Oktober 2023 im Hamburger Museum für Kunst & Gewerbe zu sehen.