KI-generierte Fake-Bilder „des Israel-Gaza-Krieges“ – Vorwürfe gegen Adobe Stock

Vergangene Woche war es Thema in einigen Web-Portalen: Es wurden und werden wohl KI-generierte Inhalte von Adobe Stock zur Bebilderung der Berichterstattung über den aktuell wieder eskalierten Gaza-Konflikt genutzt – ohne sie als KI-generiert zu kennzeichnen. Auch zu Propagandazwecken kursieren KI-Bilder und werden echte Fotos als KI-Bilder verunglimpft.

Die Vorwürfe

Beispiel 1

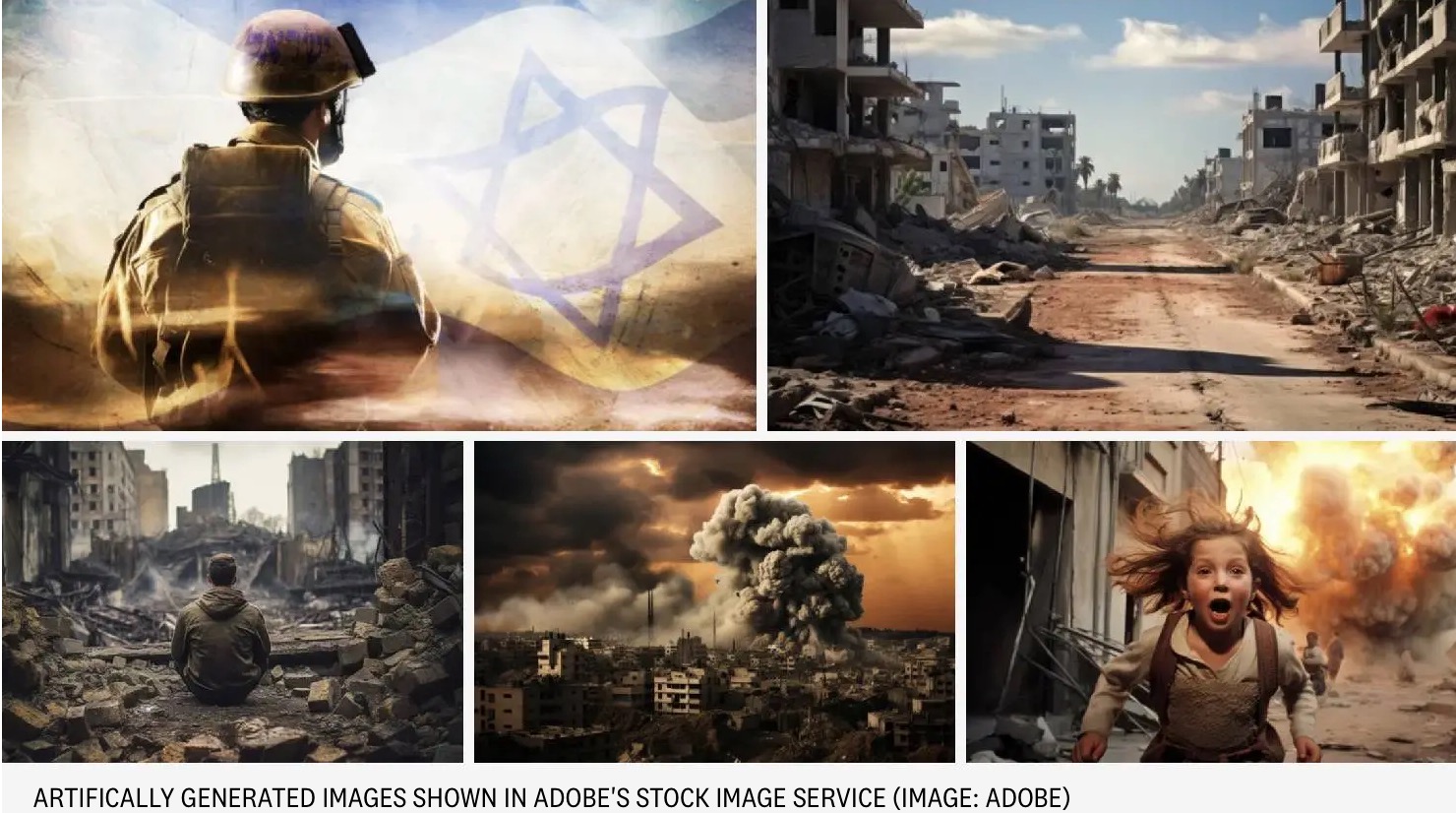

Das australische Nachrichtenportal Crikey schreibt „Adobe is selling fake AI images of the war in Israel-Gaza“ und zeigt als Beispiele verschiedene auf Adobe Stock über die Suchbegriffe „Israel, Palestine, Gaza, Hamas“ zu findende Bilder. Allesamt KI-generiert:

Der Autor zitiert einen die Nutzung von KI-Bildern erforschenden Dozenten der RMIT-Universität: „There is potential for these images to mislead folks, to distort reality, to disrupt our perception of truth and accuracy”.

Beispiel 2

Petapixel griff das Thema ebenfalls auf und zeigt viele Beispiele.

Anders als Crikey erhielten sie Antwort von Adobe (übersetzt mit DeepL):

Adobe Stock ist ein Marktplatz, auf dem alle generativen KI-Inhalte als solche gekennzeichnet werden müssen, wenn sie zur Lizenzierung eingereicht werden. Diese Bilder wurden als generative KI gekennzeichnet, als sie eingereicht und zur Lizenzierung bereitgestellt wurden, um diese Anforderungen zu erfüllen. Wir glauben, dass es für Kunden wichtig ist, zu wissen, welche Adobe Stock-Bilder mit generativen KI-Tools erstellt wurden.“

Adobe hat sich dem Kampf gegen Fehlinformationen verschrieben und arbeitet im Rahmen der Content Authenticity Initiative mit Verlagen, Kameraherstellern und anderen Stakeholdern zusammen, um die Einführung von Content Credentials, auch in unseren eigenen Produkten, voranzutreiben. Content Credentials ermöglicht es den Nutzern, wichtige Informationen darüber zu erhalten, wie ein digitaler Inhalt aufgenommen, erstellt oder bearbeitet wurde, einschließlich der Angabe, ob KI-Tools bei der Erstellung oder Bearbeitung des digitalen Inhalts verwendet wurden.

In den Kommentaren äußern User große Ablehnung:

Beispiel 3

Golem.de bezieht sich auf diese Artikel, formuliert in der Überschrift aber drastischer: Adobe will KI-Fakes offenbar nicht einschränken.

Einige lesenswerte Kommentare dort ordnen die Lage perfekt ein.

Meine Einschätzung

Im Prinzip geht es hier um dasselbe Thema wie in Doc Baumanns Blogbeitrag „Wie gefährlich sind KI-Bilder?“. Ich möchte Ihnen im Folgenden meine (fast identische) Sichtweise in anderen Worten näher bringen.

Ja, natürlich haben KI-Bilder das Potenzial, „die Menschen in die Irre zu führen, die Realität zu verzerren und unsere Wahrnehmung von Wahrheit und Genauigkeit zu stören“, wie es der RMIT-Dozent oben ausdrückte. Das ist aber eine Binsenweisheit, die für alle Bilder und Fotos gilt.

Falsches Framing

Insofern ist schon das Framing dieser Artikel falsch. KI-Bilder sind keine „Fakes“, also kein Schwindel, keine Täuschung, keine Irreführung. Es sind (mehr oder weniger fotorealistische) Illustrationen. Erst die irreführende Nutzung und fehlende Kennzeichnung als KI-generiert machen diese Bilder zu Fake Fotos und Fake News.

Falscher Adressat für die Vorwürfe

Adobe Stock liefert Bilder für verschiedene Anwendungen. Also auch für die Illustration von Artikeln. Auch hier ist nicht das Bild an sich der Fake, sondern das, was der Stockbild-Käufer damit anstellt. Keine Stockfirma ist insofern verantwortlich dafür, was mit ihren verkauften Bildern geschieht – egal, ob es sich um Fotos, Illustrationen oder eben KI-Bilder handelt.

(Übrigens: Dass mich die Flut an KI-Bildern auf Adobe Stock extrem nervte, hatte ich mal auf meiner Facebook-Seite erwähnt. Inzwischen gibt es glücklicherweise einen Filter für KI-Bilder, mit denen man diese aus eine Suche ausschließen kann. Es verirren sich dennoch einige, nicht korrekt gekennzeichnete und nicht im Auswahlprozess aussortierte in der Foto-Kategorie. Aber das sind inzwischen nur noch Einzelfälle, sodass das Vorgaukeln eines Fotos durch ein KI-Bild dort zumindest eher selten geworden ist.)

Das Besondere an KI-Bildern

Oben im Screenshot ist in einem Kommentar zu lesen, KI-Bilder seien „Too easy to abuse“. Aber wie erwähnt und gezeigt, kann jedes Foto missbräuchlich verwendet werden. Dazu muss es nicht einmal eine Fotomontage sein. Es reicht, ein Foto – oder einen Ausschnitt davon – zu benutzen, um etwas zu illustrieren, das es gar nicht darstellt. Regelmäßig werden auf Social-Media-Plattformen und leider auch in News-Medien Fotos und Videos aus ganz anderen Konflikten geteilt – entweder gezielt oder wider besseres Wissen.

Was macht KI-Bilder also so besonders, dass bei der bloßen Erwähnung von KI alle mahnen und warnen? Dass solche auch bei Adobe Stock verkauft werden, wohl kaum. Dort sind es Bilder wie alle anderen auch.

Meine Meinung dazu in Kurzform: Die Gefahr bei KI-Bildern geht vorwiegend von zwei Dingen aus:

- Der neuen, extremen Einfachheit der gezielten Bilderzeugung.

- Der Leichtgläubigkeit oder die mangelnde Medienkompetenz vieler Menschen.

Punkt 1: Die Einfachheit der gezielten Bilderzeugung

Bisher konnte sich schon jeder mehr oder weniger passende Bilder kaufen oder aus dem Internet „klauen“, um Fake News zu verbreiten. Dafür sucht man bestehendes Bildmaterial, das ins gewünschte Narrativ passt. Das ist mit KI-generierten Inhalten auf Stock-Plattformen nicht anders.

Neu ist nur, dass man sich nun per KI exakt das gesuchte Wunschbild zusammenstellen kann. Ohne jede Kenntnis von Retusche- und Montage-Techniken. In (mehr oder weniger) fotorealistischer Qualität.

Hier geht es also um die Nutzer generativer KI-Systeme, nicht um Stockbild-Sucher. Auch ohne tiefes Wissen in Sachen „Promptologie“ kann jeder heute einfach durch wiederholtes Generieren/Variieren zu ansehnlichen Ergebnissen kommen, die genau das zeigen, was gewünscht ist. Von einer süßen Märchenszene (in jeder KI) über eine mehr oder weniger grausame Märchenszene bis zu einer „maximalversauten“ Märchenszene (die letzten beiden in unzensierten KI-Systemen, die auf Stable Diffusion basieren). Einfach so oft generieren, bis das Ergebnis passt.

Punkt 2: Die Leichtgläubigkeit der Menschen

Auch nach Jahrzehnten im Umgang mit verfälschender Werbung scheinen Menschen Bildern immer noch leichtgläubig zu vertrauen. Kaum jemand sieht auf den leckeren Produktabbildungen das häufig klein gedruckte „Serviervorschlag“ oder weiß gar, was das bedeutet: Dass es sich nur um ein Symbolbild handelt und nichts mit dem Produkt zu tun hat.

In Naturfoto-Gruppen auf Facebook werden inzwischen haufenweise KI-Bilder ohne jeden Hinweis auf ihre Herkunft gepostet – und in den Kommentaren gefeiert … bis zu endlosen Lobpreisungen auf Gott und seine Wunder. Bei (für mich zumindest) völlig offensichtlich per KI generierten Bildern.

Wie echt das Leben von Influencern ist, hat deren Werbe-Zielgruppe noch nie interessiert. Ob die Influencer überhaupt existieren, interessiert heute schon anscheinend auch niemanden mehr (Video dazu):

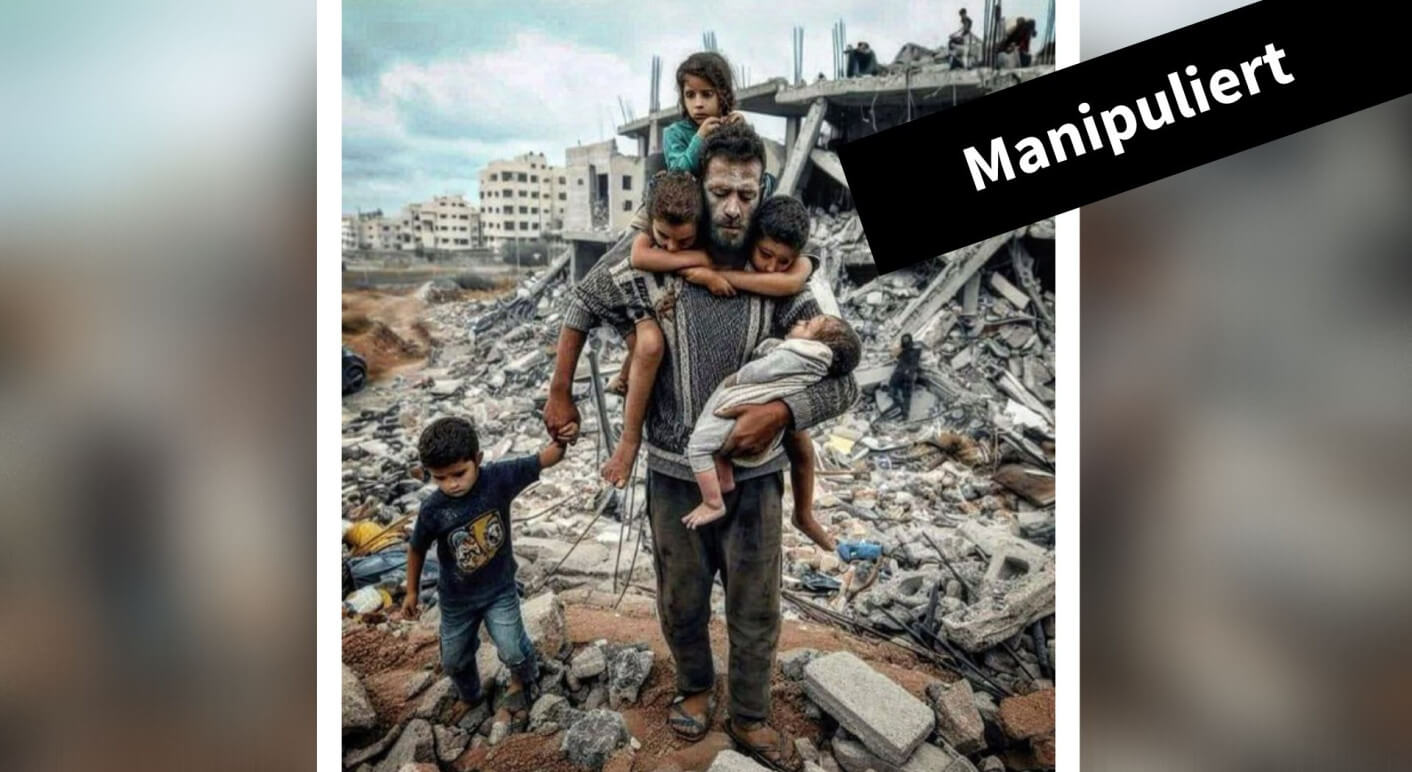

Natürlich wird KI jetzt auch für die Propaganda benutzt, sei es durch KI-generierte Bilder wie dieses:

Oder durch den Vorwurf, echte Fotos (wie das des verbrannten Babys, das ich hier nicht zeige) seien per KI generiert, was dann wiederum mit einem tatsächlich per KI eingefügten Hundewelpen „bewiesen“ wird (mehr dazu):

Die Lösung?

Warnhinweise

Jetzt könnte man – ganz getreu dem früheren DOCMA-Award zum Thema Warnhinweise – politisch eine Verpflichtung beschließen, überall „Symbolbild“ oder „Serviervorschlag“ darunter zu schreiben, wo es sich nicht um ein authentisches Foto handelt. Es würden weder alle tun, noch alle lesen und früher oder später einfach ignorieren, weil es ja – wie Internetwerbung – so omnipräsent ist, dass man sie einfach ausblendet.

Faktenchecks

Faktenchecks wie dieser hier sind wichtig, gut und schön.

Das Problem: Faktenchecker können nicht alle KI-Bilder in jedem Kontext tatsächlich schon aufgrund der schieren Menge kaum überprüfen. Außerdem erreichen Faktenchecks selten so viele Menschen wie die geprüften Bilder. Und Faktenchecker-Portale können falsch liegen (wäre mal ein eigenes Thema). Es bleibt also hauptsächlich eins: die eigene Medienkompetenz.

Medienkompetenz

Klar ist, dass in den Köpfen der Medienkonsumenten ein Umdenken stattfinden muss. Medienkompetenz wird immer wichtiger. Eine ständig zu schärfende Skepsis ist angebracht. Angesichts dessen, was im Internet alles für bare Münze genommen wird, habe ich diesbezüglich aber wenig Hoffnung. „Die Masse“ wird immer leichtgläubig bleiben. Einige werden gar nichts mehr glauben und sich vollends in Verschwörungstheorien verlieren. Der Rest muss sich komplex über Qualitätsmedien, Urheber- und Inhaltshinweise informieren.

Insofern ist Adobes Hinweis auf ihre Content Authenticity Initiative (CAI) eine hilfreiche Möglichkeit, zumindest etwas Transparenz in den Bilderdschungel zu bringen. Was es damit auf sich hat und wo Sie davon im Web und in Photoshop profitieren, erkläre ich übrigens in DOCMA 106 ab Seite 44 f.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos