Aus Textbeschreibungen werden Bilder

Es war gar nicht so einfach, in dieser Überschrift knapp zusammenzufassen, worum es hier geht: Nicht um Bilder, die aus Buchstaben bestehen, sondern um solche, die eine Künstliche Intelligenz eigenständig lediglich aufgrund einer Textbeschreibung erzeugt. Das reicht von „ein Sessel in Form einer Avocado“ über „ein kleiner roter Würfel auf einem großen grünen Würfel“ bis zu „ein Porträt, das wie ein Seestern aussieht“. Aus Textbeschreibungen werden Bilder: Doc Baumann hat sich die Ergebnisse angeschaut.

Falls sich diese Anwendung Künstlicher Intelligenz durchsetzen sollte, dürften bald eine Menge Illustratoren und Bildbearbeiterinnen arbeitslos werden – dann wäre es hilfreich, wenn gleich eine weitere K.I. Vorschläge entwickelt, womit diese Menschen künftig ihr Geld verdienen könnten.

Worum geht’s? Stellen Sie sich vor, Sie haben eine Bildidee. Das kann etwas ganz Reales sein (etwa „die Golden Gate Bridge“) – aber auch etwas Verrücktes wie „ein Würfel mit der Struktur eines Stachelschweins“. Nur setzen Sie das in diesem Fall nicht um, indem Sie im eigenen Archiv oder in Bilddatenbanken nach dem geeigneten Ausgangsmaterial suchen und dann darüber nachdenken, wie sich der Würfel und das Stachelschwein plausibel und pfiffig kombinieren lassen, sondern Sie haben Zugang zu einem Künstliche-Intelligenz-System, das darauf trainiert ist, kurze beschreibende Texte in Bilder umzuwandeln.

Also tippen Sie ein: „ein Würfel, aus einem Stachelschwein hergestellt“, und um die Wahrscheinlichkeit zu erhöhen, dass die K.I. Sie auch richtig versteht, hängen Sie vorsichtshalber noch an: „Ein Würfel mit der Struktur eines Stachelschweins“.

Das System rechnet eine Weile – wie lange, geht aus dem Text vom Entwickler OpenAI leider nicht hervor – und wirft Ihnen schließlich 512 Bilder aus, die alle mehr oder weniger der Textbeschreibung entsprechen. Viele sind unbrauchbar, etwa ein Würfel mit dem Bild eines Stachelschweins darauf, ein Stachelschwein neben einem Würfel, ein Würfel mit aufprojizierten Stachelschweinen, ein zu einem Würfel zusammengestauchtes Stachelschwein und so weiter – aber es sind erstaunlich viele darunter, bei denen Betrachter, die um eine Beschreibung dessen gebeten würden, was sie da sehen, sagen würden: „Hm, das sieht irgendwie aus wie ein Würfel, der die Struktur eines Stachelschweins hat“.

Bei einfachen Aufgaben macht das KI-System kaum Fehler. Bei „Ein Sessel in Form einer Avocado“, „eine fünfeckige Uhr“ oder eine „Skizze einer Katze“ entstehen fast ausnahmslos brauchbare Resultate. Mitunter liegt es an der Uneindeutigkeit der Sprache, wenn Seltsames entsteht: „A collection of glasses is sitting on a table“ kann sowohl Trinkgefäße wie Brillen bezeichnen, und entsprechend liefert die KI das eine wie das andere oder auch deren Mischungen. Und wenn es zu kompliziert wird, gibt es kaum noch Bilder, die genau der Beschreibung entsprechen: „Ein Stapel aus drei Würfeln. Ganz oben ist ein roter Würfel, der auf einem grünen Würfel liegt. Der grüne Würfel ist in der Mitte, er liegt auf einem blauen Würfel. Der blaue Würfel liegt auf dem Boden“. Es gibt also Grenzen.

Besser als manche Bildmonteure

Nun ist die Sache als solche schon faszinierend genug, und dass nicht alles damit machbar ist, liegt auf der Hand. Neben vielem, was das KI-System (noch) nicht kann, ist es aber faszinierend zu sehen, was es bereits leistet. Die Textbeschreibungen oben enthalten nicht mehr an Informationen, als hier zitiert wurde. Es steht also nirgends, was alles berücksichtigt werden soll außer dem, was explizit benannt wurde.

Schaut man sich aber zum Beispiel die Bilder an, die auf der Basis von „eine Zusammenstellung von Gläsern (Trinkgefäßen/Brillen), auf einem Tisch“ zustande kommen, so sind diese völlig realistisch insofern, als diese Objekte Schatten werfen, Glanzlichter und Reflexionen von Lichtquellen aufweisen, den Hintergrund verzerren, sich in der glatten Tischoberfläche spiegeln und so weiter … mehr also, als manche Monteure bei einer solchen Aufgabenstellung berücksichtigen würden. Und niemand hat dem System gesagt, dass es auf diese Aspekte besonders aufpassen soll, das hat es von ganz allein getan.

Ein „Wasserschwein auf einer Wiese“ zum Beispiel wird teilweise von Halmen im Vordergrund verdeckt. Im „Schlafzimmer im Dachgeschoss mit einem weißem Bett neben einem Nachttisch. Es gibt ein Aquarium, das neben dem Bett steht“ wird der Lichtabfall vom schrägen Dachfenster realistisch nachvollzogen und der Raum um nicht beschriebene Elemente ergänzt (Schrank, Kissen, Bild an der Wand).

Werden dem System am oberen Rand des zu generierenden Bildes einige Pixelreihen vorgegeben, so werden diese 1:1 übernommen und in die Szene integriert. Das hat zum Beispiel zur Folge, dass blaue Pixel am oberen Rand aus „ein Foto der Golden Gate Bridge in San Francisco“ zu einem Tageslicht-„Foto“ der Brücke mit blauem Himmel führen. Gibt es zusätzlich oben rechts eine Gruppe heller Pixel in der Vorgabe, wird daraus ein blauer, aber nun bewölkter Himmel. Der schmale Rand eines orangefarbenen radialen Verlaufs wird als Sonnenuntergang interpretiert – entsprechend ist auf allen Umsetzungen die Brücke nur noch als dunkle Silhouette zu sehen. Und bei einer fast schwarzen Vorgabe für den oberen Rand macht das System daraus erwartungsgemäß eine Nachtszene …, „denkt“ aber auch daran, die Schweinwerfer einzuschalten und sogar Lichtspuren der fahrenden Autos zu berücksichtigen.

Wer hat’s gemacht?

DALL·E ist ein KI-Projekt der Firma OpenAI; der Projektname ist übrigens eine Mischung aus dem des surrealistischen Malers Salvador Dali und dem des Endzeit-Roboters aus dem Film WALL·E.

Das System wurde mit einer gewaltigen Anzahl von Bildern trainiert, die jeweils mit einer passenden sprachlichen Bezeichnung kombiniert waren. Aus Urheberrechtsgründen kann ich Ihnen leider die hier beschriebenen Bildergebnisse nicht zeigen, Sie können sie aber alle auf der entsprechenden Webseite von OpenAi anschauen und dort auch die ausführlicheren Texte dazu lesen.

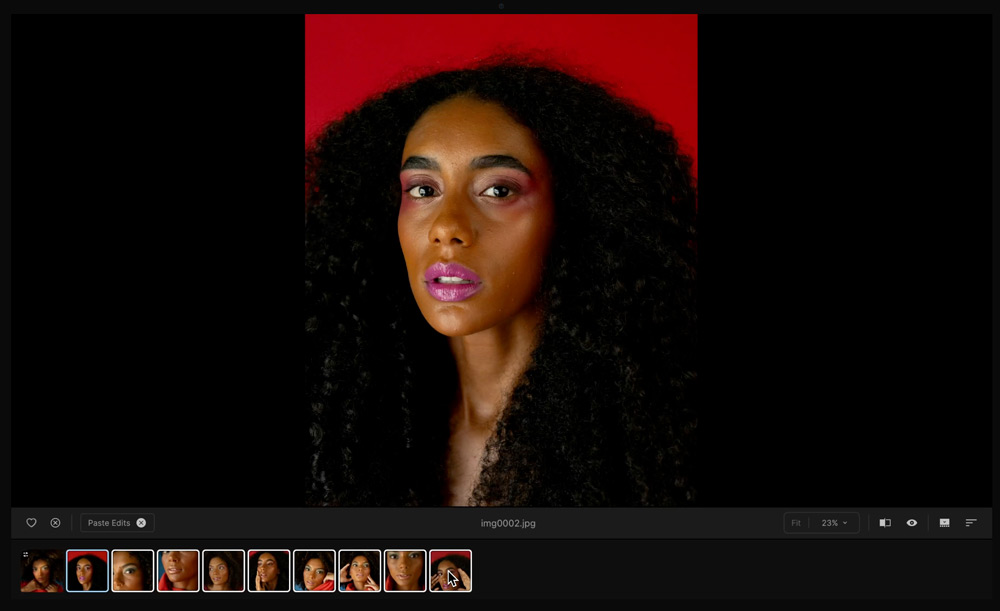

Das Bildbeispiel mit Seestern und Porträt gehört übrigens nicht zu den DALL·E-Ergebnissen, sondern ist eine davon inspirierte eigene Montage; bislang generiert das System auch „nur“ kleine, quadratische Bilder mit 256 Pixel Seitenlänge.

Wir werden sehen, wie das weitergeht und wie es fortentwickelt wird. Doch selbst, wenn die Bildergebnisse einstweilen von Größe, Auflösung und Renderingqualität noch keine professionelle Verwendung erlauben sollten, wäre das System hinsichtlich seiner kreativen und assoziativen Ideen (bitte alles in Anführungsstrichen zu denken) ein tolles Werkzeug. Hoffen wir, dass es nicht zu gut wird und dann viele Kolleg/innen ersetzt. Aber sich dem entgegenzustellen, würde erfahrungsgemäß wenig nützen und hat schon den Webern im 19. Jahrhundert nicht geholfen. (Ich danke meinem Freund Peter in Berlin, der mich auf diese Projekt aufmerksam gemacht hat.)