Sensorgeflüster: Zweistöckige Pixel und neue Auflösungsrekorde

Fotografen schauen schon länger eifersüchtig auf Smartphones, deren Kameramodule all die neuen Sensortechnologien als Erste bekommen; wer „richtige“ Kameras bevorzugt, muss sich hinten anstellen und warten, bis die Reihe an ihm ist. Aber was hilft’s …

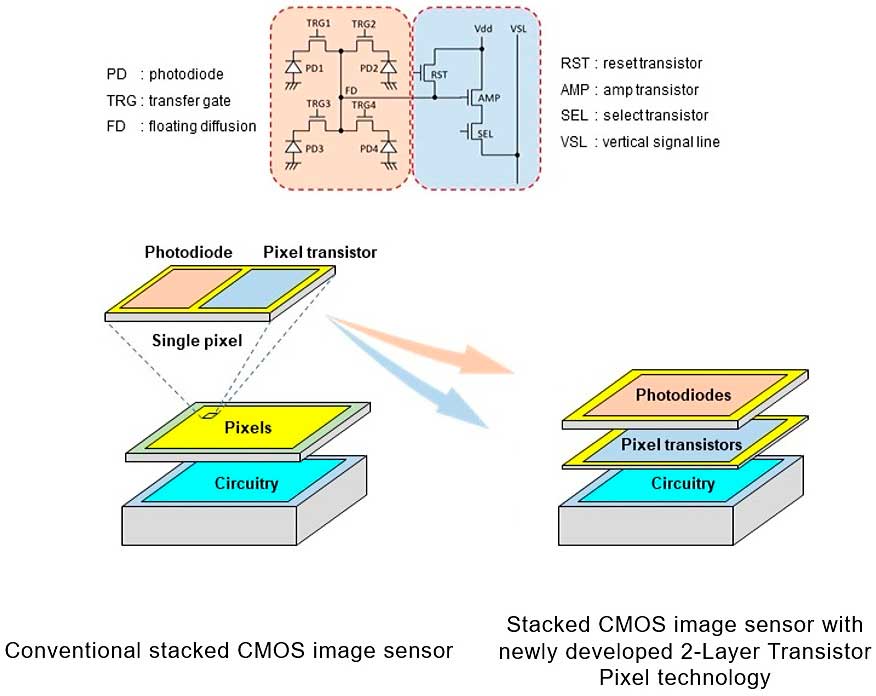

„Stacked“ (also gestapelte) Sensoren aus zwei oder mehr Siliziumschichten gibt es ja schon seit geraumer Zeit. Indem Hersteller wie Sony oder Canon die Analog/Digital-Wandler und schnelle Zwischenspeicher für die digitalisierten Pixelwerte in eigene Schichten auslagern, machen sie die Sensoren schneller, was Artefakte durch einen elektronischen Verschluss nach dem Rolling-Shutter-Prinzip verringert und für ruckel- und blackoutfreie Sucherbilder sorgt. Sony hat nun im letzten Monat eine neue Technologie vorgestellt: Schon die Sensorpixel selbst werden damit auf zwei Schichten verteilt.

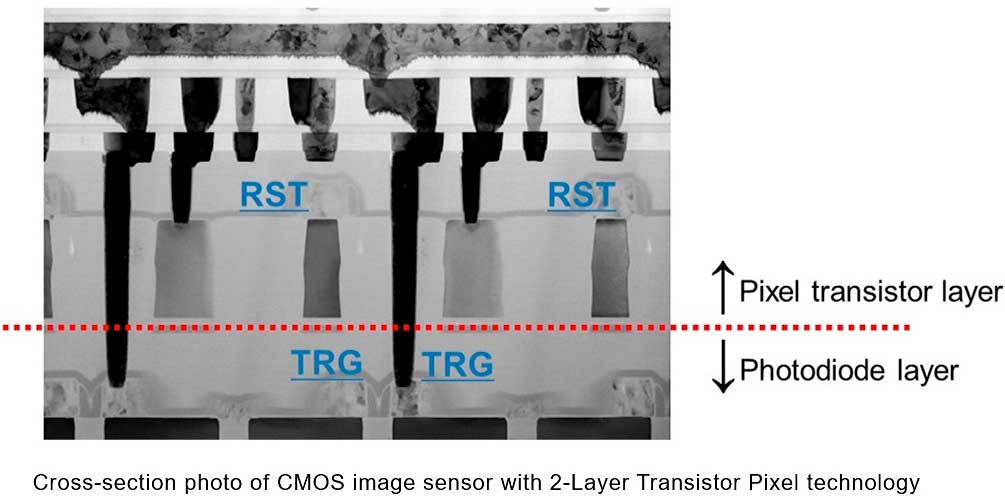

Ein Sensorpixel enthält eine lichtempfindliche Fotodiode, in der auftreffende Photonen Elektronen freisetzen, und dazu mehrere Transistoren, die unter anderem zur Verstärkung der geringen Spannungen nötig sind. Beim klassischen Sensordesign müssen sich die Fotodiode und die Transistoren die Fläche des Pixels teilen, so dass nicht das ganze Pixel lichtempfindlich ist. Legt man die Pixel nun aber zweistöckig an und verbannt die Transistoren in das lichtlose Souterrain, profitieren beide Seiten: Die Fotodioden können sich oben über die gesamte Pixelfläche erstrecken und werden damit empfindlicher; sie empfangen mehr Licht und erzeugen entsprechend höhere Spannungen. Die Transistoren bekommen unten ebenfalls mehr Platz, und größere Transistoren erzeugen bei der Signalverstärkung weniger Rauschen. Beide Faktoren zusammen führen zu einem höheren Rauschabstand und einem vergrößerten Dynamikumfang. Obwohl sich Sony nicht weiter dazu auslässt, scheint ihr Konzept noch eine dritte Halbleiterschicht mit weiteren Schaltkreisen vorzusehen; hier ließen sich die A/D-Wandler und nötigenfalls schnelle Pufferspeicher unterbringen.

Wohlgemerkt ist das zunächst nur eine neue Technologie; einen darauf basierenden neuen Sensor hat Sony noch nicht angekündigt. Wie schon länger üblich, sollen die zweistöckigen Pixel aber zuerst in Sensoren für Smartphones zum Einsatz kommen – zugegebenermaßen eine naheliegende Entscheidung, denn deren kleine Pixel fangen nur wenige Photonen ein und können von größeren Fotodioden am meisten profitieren.

Dass die Pixel künftig noch kleiner werden, illustriert ein neuer Sensor von Omnivision. Der OVBOB löst mit Pixeln im 0,61-Mikrometer-Raster insgesamt 200 Megapixel auf – ein Wert, den man bislang nur im Mittelformat für möglich hielt, während OVBOB nur 10,1 mm × 7,6 mm misst. Da so winzige Pixel nur bei guten Lichtverhältnissen halbwegs rauscharme Bilder liefern, hat der Sensor einen Binning-Modus, in dem 16 Sensorpixel miteinander verrechnet werden, wodurch die Auflösung auf weniger spektakuläre 12,5 Megapixel sinkt. Der Sensor unterstützt trotz des engen Pixelrasters einen Phasendetektions-Autofokus mit „Quad Phase Detection“ (QPD), und das heißt, dass der Autofokus im gesamten Bildfeld mit Kreuzsensoren arbeitet, die auf waagerechte wie senkrechte Strukturen gleichermaßen gut scharfstellen können. Die integrierten A/D-Wandler liefern Rohdaten mit 10 Bit pro Pixel – das erscheint wenig, vergleicht man diesen Wert mit den meist 14 und seltener 12 Bit, die unsere Kameras liefern, aber wenn sich ein Bild aus 200 Millionen Pixeln aufbaut, genügen schon 10 Bit, um fein aufgelöste Farb- und Tonwertverläufe zu erzeugen.

Auch dieser Sensor ist natürlich für Smartphones gedacht, und wir können nicht damit rechnen, dass es bald Kleinbildsensoren mit 2,3 Gigapixeln geben wird, wie sie sich rechnerisch bei diesem Pixelraster ergeben würden. Immer mehr (und dafür kleinere) Pixel sind aber in allen Formaten zu erwarten, auch im Kleinbild- oder APS-C-Bereich. Und es wäre nicht überraschend, wenn die A/D-Wandler dann eher weniger Bits als heute üblich digitalisieren würden. Manche wünschen sich ja 16-Bit-Wandler, die sich aber nur für größere Pixel empfehlen – bei kleineren Pixeln würden die zusätzlichen Bits bloß Rauschen enthalten. Wenn man aber die Zahl der Pixel vergrößert, spielt die Zahl der Bits pro Pixel eine immer geringere Rolle für die Bildqualität. Wir kennen das Prinzip von den Tintendruckern, die aus mehreren Tausend Farbtröpfchen pro Zoll fein abgestufte Verläufe erzeugen. Obwohl jeder Farbtropfen nur aus einer von vier (und manchmal bis zu neun) Druckfarben besteht, entsteht auf diesem Weg der Eindruck von Millionen von Farben und Hunderten von Tonwerten, ohne dass sichtbare Abrisse entstünden. Entsprechend genügen bei extrem hochauflösenden Sensoren weniger Bits, was wiederum deren Auslesezeit verkürzt.

Nicht neu, denn die Sony 7R IV hat die Transstoren schon unter den lichtempfindlichen Pixeln, die ohne Lücken die gesamte Fläche bedecken. und bei der 7S III werden 4 Pixel zusammengefasst, um deutlich mehr Lichtempfindlichkeit (ISO) auf Kosten der Auflösung (Megapixel) zu erreichen.

Letzteres wird bei Handys schon lange gemacht, denn die dort angegebenen Megapixel sind reines Marketing. Die bis 100 Megapixel findet man auf keinen fertigen Bildern. Die Objektive schaffen das nicht annähernd.

Die Bits wiederum beziehen sich auf die Dynamik. Sony hat frühzeitig 14 Bit (mit der Möglichkeit von 16 Bit) festgelegt. Das ist der Unterschied zwischen der dunkelsten und hellsten Stelle. Dadurch kann man bei einer RAW-Datei nachträglich die abgesoffenen Tiefen und überstrahlten hellen Stellen korrigieren. Dies ist wichtig, da JPG gerade mal 8 bit schafft, was etwa der Möglichkeiten beim besten Offse-Druck entspricht. Auch Monitore liegen meist bei 8 Bit und erreichen bei bestens kalibrierten Grafik-Modellen höchstens 10 Bit.

Interessant ist die 11er-Leica, wo man das Binning bei der Aufnahme in 3 Stufen wählen kan. Von 60 Megapixeln und normaler Empfindlichkeit bis zu relativ geringer Auflösung, aber höchster Empfindlichkeit. Bei Sony braucht es dazu zwei unterschiedliche Bodys 🙁

Nun, bei Sony weiß man schon, ob etwas neu ist oder man es längst erfunden hat, und die Aufteilung der Transistoren eines Pixel auf zwei Ebenen gab es noch nicht – und gibt es auch jetzt noch nicht in einem vermarkteten Sensor. Stacked Sensoren sind in der Tat nicht neu, aber bei diesen befanden sich die Pixel-Transistoren bislang in einer Schicht; die zweite oder dritte Schicht war für A/D-Wandler, DRAM, KI-Funktionen oder (bei Time-of-Flight-Sensoren) zur Laufzeitmessung des Lichts vorgesehen.

Bei der Alpha 7S III werden übrigens keine vier Pixel zusammengefasst, sondern die Pixel sind von Anfang an so groß, dass nur rund 12 Millionen auf einen Kleinbildsensor passen. Der Trend geht allerdings dahin, die Zahl der Sensorpixel so weit wie möglich zu steigern und für niedrigere Auflösungen mehrere Pixel zu verrechnen, wie man das von Smartphones kennt. Smartphones haben dann allerdings meist Quad-Bayer-Sensoren, bei denen jeweils zwei mal zwei Pixel für dieselbe Farbe empfindlich sind, was die Verrechnung vereinfacht – man bildet einfach jeweils die Durchschnittswerte dieser vier benachbarten Pixel und erhält eine Raw-Datei im Bayer-Schema. Bei Sensoren mit Farbfiltern im klassischen Bayer-Muster ist das kniffliger, aber Canon unterstützt das schon länger und Leica neuerdings auch.

Was die Zahl der digitalisierten Bits betrifft, so steht sie in keinem strikten Zusammenhang zum Dynamikumfang. Deshalb ist es ja möglich, beispielsweise 14 Bits zu digitalisieren und damit einen Dynamikumfang von 15 EV zu bewältigen. Die Bittiefe von JPEG-Dateien steht in gar keinem Zusammenhang mit dem Dynamikumfang, weshalb man beispielsweise einen Kontrastumfang von 15 EV auch in einem JPEG mit nur 8 Bit pro Kanal abbilden kann, wenn auch nicht mit der feinen Tonwertauflösung, die man sich vielleicht wünschen würde.