Deutscher Fotorat warnt erneut vor irreführenden KI-Bildern in der Berichterstattung

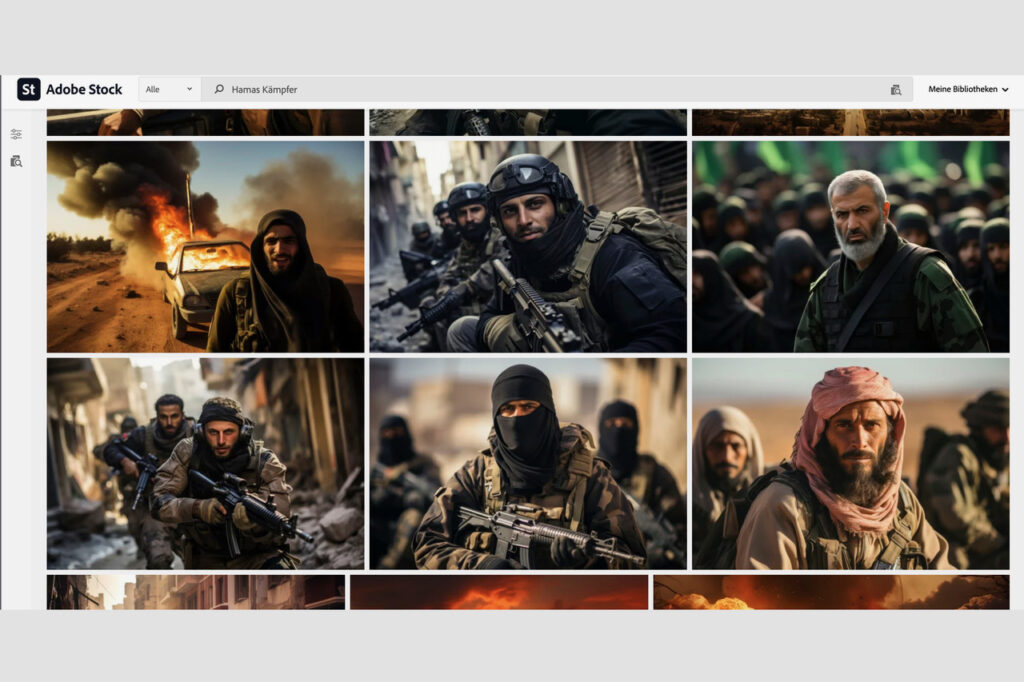

In einem Positionspapier hatte der Deutsche Fotorat schon im April dieses Jahres auf die Gefahren missbräuchlicher Anwendung generativer KI hingewiesen (DOCMA berichtete). Nun konkretisiert er vor dem Hintergrund des aktuellen Nahostkonflikts mit einer weiteren Stellungnahme seine Forderungen, auf die Verwendung von KI-Bildern in der Berichterstattung zu verzichten und KI-Bilder im politischen Diskurs verantwortungsvoll einzusetzen. Von Bildanbietern erwartet der Fotorat, dass sie KI-generierte Bilder unabhängig von der Kennzeichnung als solche keinesfalls so verschlagworten, dass sie irrtümlich realen Geschehnissen zugeordnet werden können, wie es beispielsweise bei Adobe Stock der Fall ist. So findet man dort etwa unter dem Schlagwort „Gaza“ KI-generierte, realistisch anmutende Bilder von zerstörten Städten, hoch emotionale Bilder von Kindern in Trümmerlandschaften oder Portraits von bärtigen Bewaffneten, die in der Bildbeschreibung als „Hamas-Krieger“ bezeichnet werden.

Stellungnahme: Fotorat warnt vor irreführenden KI-Bildern in der Berichterstattung

Der aktuelle Nahostkonflikt hat zu einem enormen Anstieg im Angebot von KI-generiertem Bildmaterial geführt, das sich auf diese Ereignisse bezieht. Diese mutmaßlichen Kriegsbilder sind in vielen Fällen weder für Fachleute noch mit technischen Systemen zur Erkennung von KI-Bildern von authentischen Fotos zu unterscheiden.

Unter dem Schlagwort „Gaza“ findet man beispielsweise auf der Plattform von Adobe Stock, einer der führenden Bilddatenbanken, KI-generierte fotorealistische Bilder von zerstörten Städten, hoch emotionale Bilder von Kindern in Trümmerlandschaften oder Portraits von bärtigen Bewaffneten, die in der Bildbeschreibung als „Hamas-Krieger“ bezeichnet werden.

Die Bilder werden gleichrangig mit echtem Fotomaterial angeboten, identisch verschlagwortet und in vielen Fällen inhaltlich ähnlich beschrieben. Die Gefahr ist hoch, dass beim Erwerb solcher Bilder, trotz KI-Hinweis beim Anbieter, Kennzeichen der künstlichen Generierung in den weiteren Redaktions-Prozessen bis zur Veröffentlichung übersehen oder gar ignoriert werden. Wenn KI-Bilder gemeinsam mit Fotos im gleichen Umfeld veröffentlicht werden, suggeriert es Authentizität der synthetischen Bilder und schwächt die Glaubwürdigkeit der realen Fotos.

Allein der Verdacht auf irreführende KI-Bilder im Journalismus löst bei Mediennutzern einen unumkehrbaren Vertrauensverlust aus. Der Deutsche Fotorat hat bereits im April mit seinem Positionspapier zu KI auf die Gefahren für den gesellschaftlichen Diskurs hingewiesen. Im Licht der aktuellen Situation präzisiert er seine Forderungen:

Verantwortungsvolles Handeln von Bildanbietern

Auch wenn es legitime Gründe geben kann, allgemeingültige Symbolbilder von Konflikten oder Kampfhandlungen mithilfe von KI-Bildgeneratoren zu erzeugen und anzubieten, müssen es Bildanbieter unterlassen, solche fiktiven Bilder durch Verschlagwortung oder Bildbeschriftung konkreten realen Geschehnissen zuzuordnen. Es ist irreführend und stiftet zu Missbrauch an, beispielsweise KI-Bilder von zerstörten Städten als „Stadt im Gaza-Streifen“ oder synthetische Bilder von Bewaffneten als „Hamas Rebellen“ zu betiteln. Die bloße Kennzeichnung von KI-Bildern beim Vertrieb von Bildrechten reicht nicht aus, wenn sonstige Bildinformationen nicht von denen realer Fotos zu unterscheiden sind.

Ein klares Nein zur Verwendung von KI-Bildern in der Berichterstattung

Journalistisch arbeitende Medien müssen sich klare Richtlinien geben, die den Einsatz von KI-Bildern in irgendeinem Zusammenhang mit der Berichterstattung über Ereignisse des Tagesgeschehens prinzipiell ausschließen. Bildmaterial muss vor der Veröffentlichung auf seine Authentizität überprüft werden.

Die Richtlinien der Redaktionen müssen transparent für Mediennutzer kommuniziert werden. Es darf nicht die Pflicht der Mediennutzer sein, sich der Authentizität jeder Abbildung anhand von etwaigen Kennzeichnungen in Bildunterzeilen zu vergewissern. Der Fotorat regt an, den Kodex des Deutschen Presserats zum Einsatz von Symbolbildern hinsichtlich KI-generierter Bilder zu präzisieren.

Verantwortungsvoller Einsatz von KI-Bildern im politischen Diskurs

Auch bei der Nutzung von KI-Bildern in Veröffentlichungen von öffentlichen Stellen, NGOs oder Parteien ist besondere Verantwortung geboten, da Nutzer diesen Quellen besonderes Vertrauen entgegenbringen. Hier müssen Symbolbilder, insbesondere mit KI generierte fotorealistische Bilder, deutlich als solche gekennzeichnet werden. Der Deutsche Fotorat fordert Verantwortliche auf, in jedem Einzelfall zu erwägen, ob ein möglicherweise besonders wirksames KI-Bild wirklich eine sinnvolle Funktion hat, oder der Einsatz nicht eher aus Bequemlichkeit oder Kostendruck geschieht. Im Zweifel ist ein authentisches Bild vorzuziehen.

Der Deutsche Fotorat ist der Dachverband der Fotografie in Deutschland. Als spartenübergreifende Interessensvertretung vertritt er die Interessen der Mitgliedsverbände gegenüber Politik und Gesellschaft. Gemeinsam engagieren sich die Mitglieder für die Fotografie als Kulturgut und visuelles Kulturerbe, vertreten die Belange von Fotografinnen und Fotografen und anderer Akteure im Bereich Fotografie und stoßen öffentliche Diskussionen zu unterschiedlichen Aspekten der Fotografie an. Inzwischen hat er insgesamt 32 Mitgliedsorganisationen.