Auf fast 600 bunten Seiten und in eindrucksvollem Großformat präsentiert der Taschen Verlag handkolorierte Fotos aus dem Italien um 1900. Das ist nicht nur für alle interessant, die schon mal dort waren (wahlweise: das sieht ja heute immer noch so aus wie damals – das sieht ja heute ganz anders aus); der Band erlaubt auch einen spannenden Vergleich zwischen den damaligen Möglichkeiten manueller Kolorierung und dem, was inzwischen Photoshops KI-gesteuerte Einfärbung leistet.

Das Problem ist heute noch dasselbe wie vor über 100 Jahren: Ich habe ein Graustufenbild, das nach der Bearbeitung aussehen soll wie ein Farbbild. Die Aufgabenstellung hat zwei Aspekte: Die Vermutung, welche Farben welchen Grauwerten entsprechen und die technische Umsetzung dieser Vermutung.

Wir haben uns in DOCMA mit diesem Problem immer wieder beschäftigt und in Tutorials Ratschläge dazu gegeben – jedenfalls zu dem zweiten Aspekt, dem der Technik. Das ist gar nicht so einfach, denn es ist ja nicht so, dass einem bestimmten Grauton ein bestimmter Farbton entspräche. Graustufen zeigen die Helligkeit an und geben wenig Auskunft über die Farben des Abgebildeten. Und es ist nicht so, dass man einfach sagen könnte: Wir überlagern die Graustufenebene mit einer im Modus „Farbe“ und malen dort. Mal funktioniert das ganz gut, mal ist zum Beispiel „Multiplizieren“ geeigneter oder ein anderer Modus, vielleicht auch das Arbeiten im Lab-Modus.

Doch die Anwendung der Technik setzt voraus, dass wir wissen, welcher Bildbereich wie gefärbt werden sollte. Dazu müssen wir unsere ganze visuelle Erfahrung mit der Welt heranziehen und uns auf unsere Erinnerungen stützen: Die einheitliche oder wolkige Fläche am oberen Bildrand stellt den Himmel dar und der ist meist blau, ein Baum und eine Wiese sind – unterschiedlich – grün, ein Dach ist wohl mit roten Ziegeln gedeckt, eine Hauswand wahrscheinlich beige und so weiter. Schon bei der „wirklichen“ Farbe von Steinen oder Wasser können wir danebenliegen, ebenso bei Fell- oder Gefieder, und bei künstlich eingefärbten Objekten wie Kleidung, Autolacken oder angestrichenen Flächen können wir nur noch raten, sofern wir das Abgebildete nicht selbst gesehen haben.

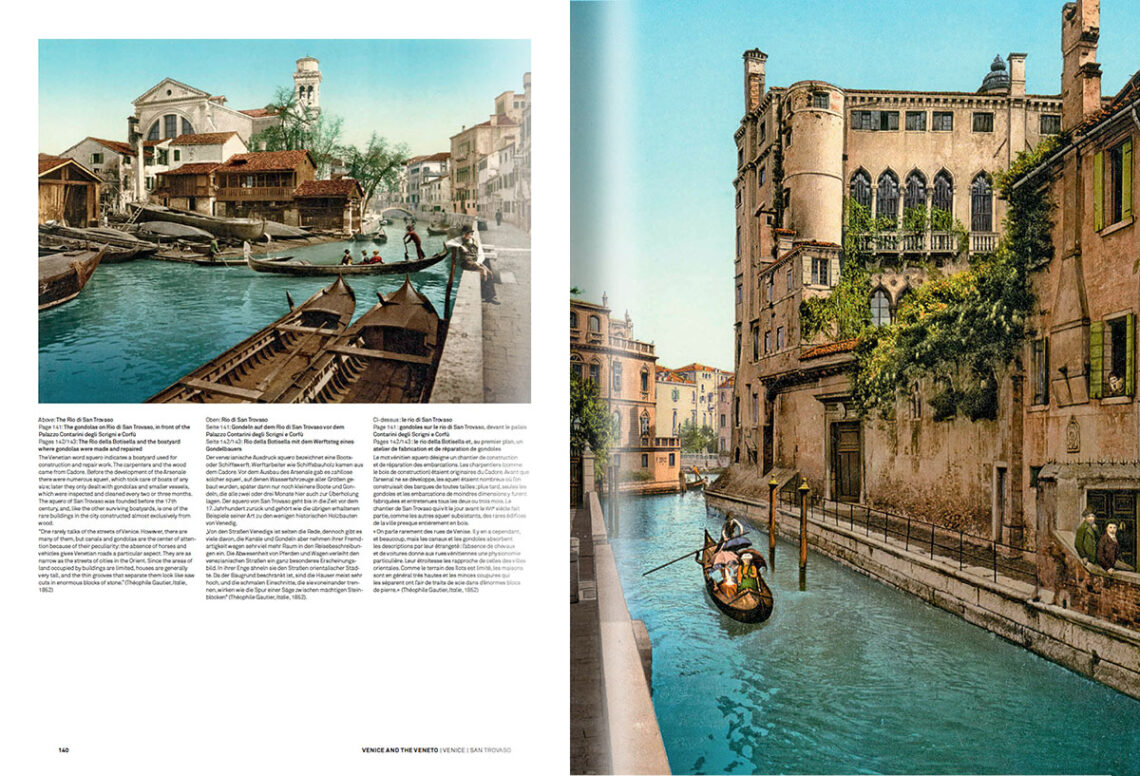

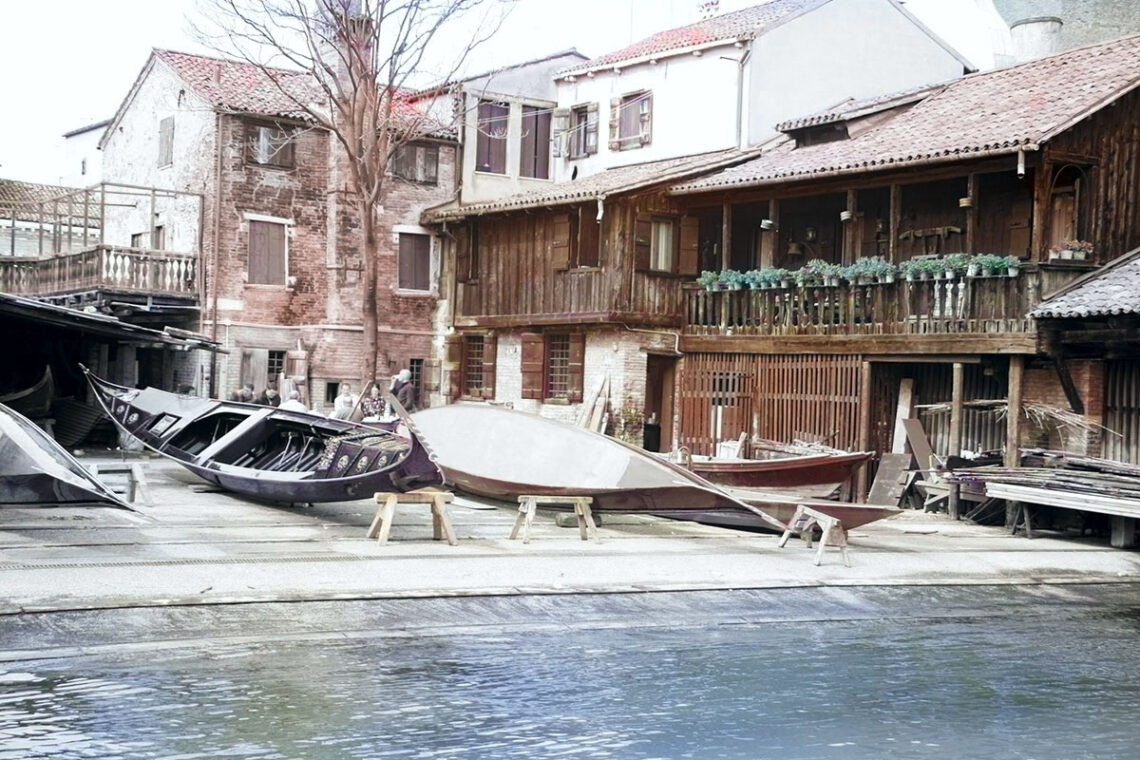

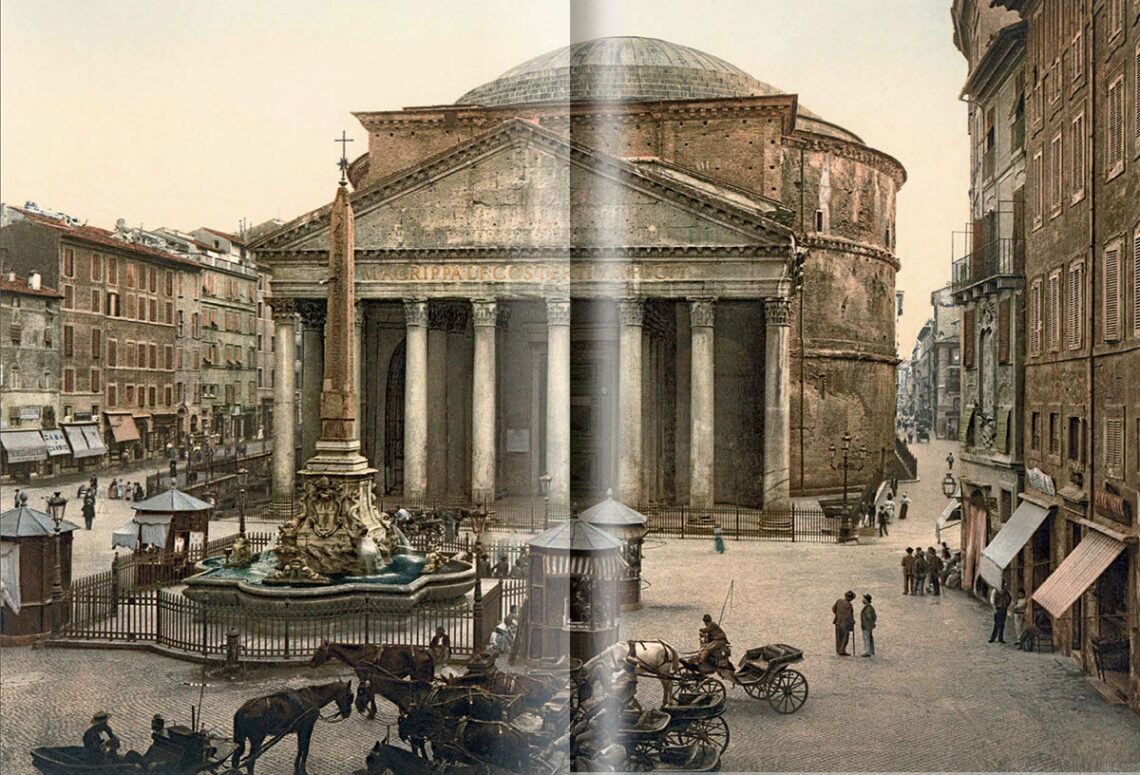

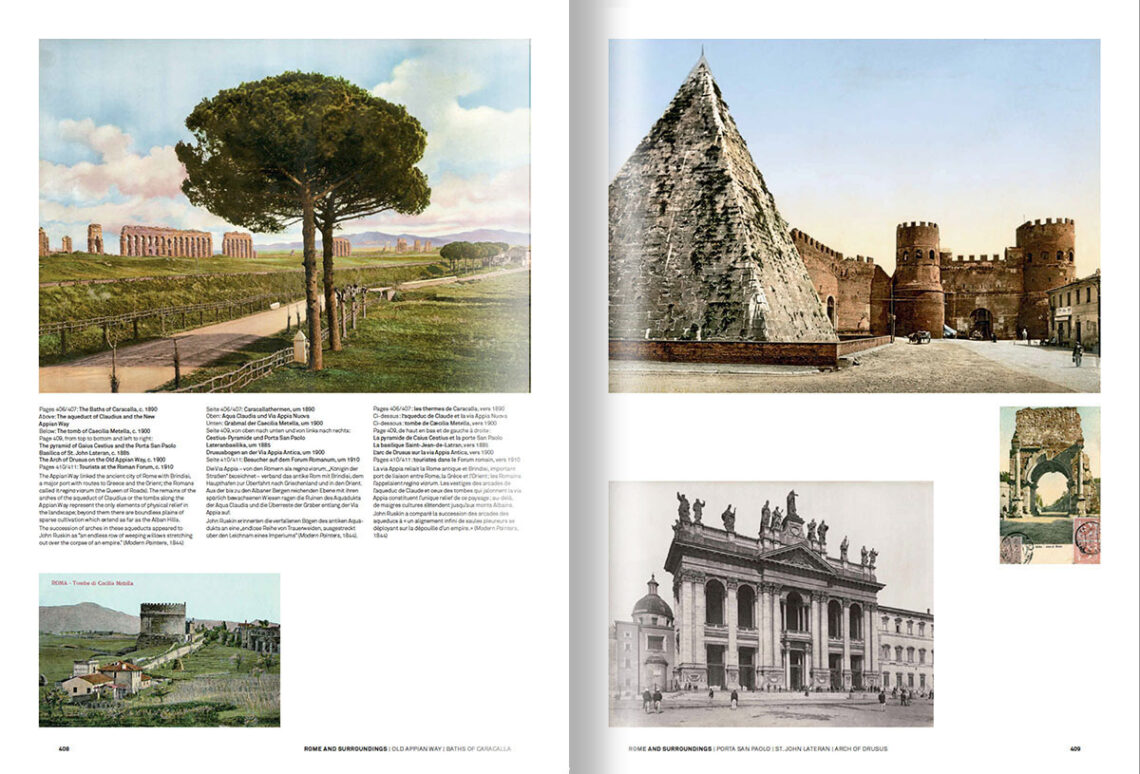

Bemerkenswert ist nun, wie das Weltwissen der alten Bildkolorierer, deren Werke in diesem Band vorgestellt werden, sehr überzeugend von Photoshops Neuralfilter „Färben“ (und anderer Software) KI-basiert simuliert wird. Das lässt sich recht einfach überprüfen: Ich habe aus meinem Archiv vier Fotos ausgesucht, die mit entsprechenden Ansichten des „Italien 1900“-Bandes korrespondieren. Sie können nun also drei Varianten vergleichen: Die alte handkolorierte Fassung, aktuelle Fotos derselben Szene aus dem letzten Jahrzehnt und das, was Photoshop daraus gemacht hat, nachdem das jeweilige Foto zwischendurch (einfach über Entsättigen, also ohne jede manuelle Gewichtung von Helligkeiten und Farben) in Graustufen umgewandelt worden war. Dabei habe ich die Farben mal so belassen, wie Photoshop sie vorgeschlagen hat, mal an einzelnen Stellen den manuellen Modus aktiviert und die Kolorierung angepasst.

Die Ergebnisse zeigen, dass die KI genauso vorgeht (und vorgehen muss) wie die frühen Retuscheure: Wo dank Weltwissens die Sachlage einigermaßen klar ist – blauer Himmel, blaues Wasser, grüne Pflanzen, beige Mauern –, kann man sich auf die Automatik weitgehend verlassen. Was voraussetzt, dass Photoshop irgendwie „erkennt“: Das ist ein Stück Himmel, das ein Dach, jenes eine Pflanze. Bei Kleidung, lackierten Oberflächen und dergleichen wird die Zuweisung willkürlich. (Vielleicht werden künftige Versionen da treffsicherer, wenn man ihnen das Aufnahmedatum mitliefert und sie abschätzen, welche Farbgebungen seinerzeit „in“ waren.)

links oben das Foto einer Gondel-Werft

die Balkonbepflanzung wurde im Filterdialog manuell nachbearbeitet

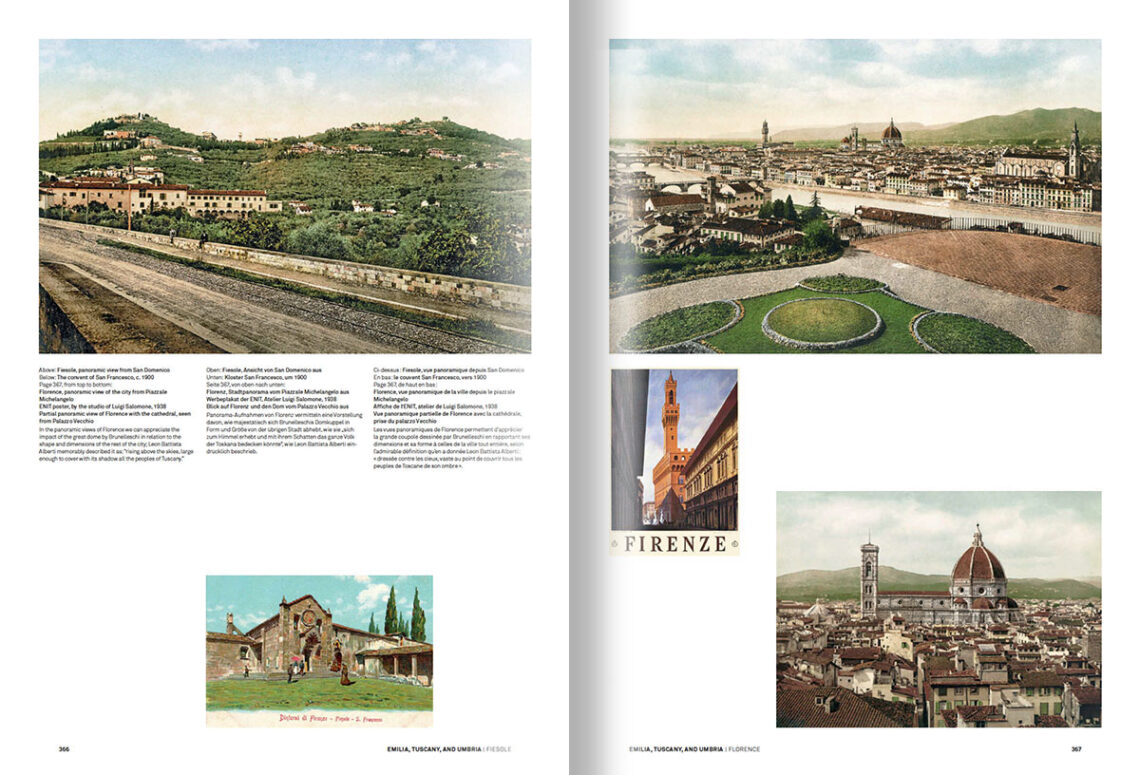

Soviel zur Technik, die zwar Leserinnen und Leser von DOCMA an diesem Buch interessieren könnte, aber kaum die Mehrzahl seiner Käufer. Natürlich ist es ganz allgemein aufschlussreich zu sehen, wie es vor rund 120 Jahren in Italien aussah. Aber diese Betrachtung gewinnt doch eine ganz andere Intensität, wenn sie mit eigenen Erfahrungen einhergeht.

Die meisten Italien-Touristen werden kaum durch mehr oder weniger moderne, mehr oder weniger glanzvolle oder heruntergekommene Stadtviertel wandern, sondern sich Kulturgüter und Architektur anschauen, die bereits auf einige Jahrhunderte, wenn nicht Jahrtausende zurückblicken können. Und während sie etwa bei den barocken Rom-Veduten von Piranesi, Rossini oder Vasi doch etliche Unterschiede zum heutigen Zustand feststellen könnten (geringere hingegen bei den Venedig-Gemälden Canalettos), lässt einen der Vergleich der eigenen Erinnerungen (und Fotos) mit den kolorierten Fotos dieses Bildbandes immer wieder ausrufen: Das hat sich ja kaum verändert seit damals, das sieht ja fast noch genau so aus!

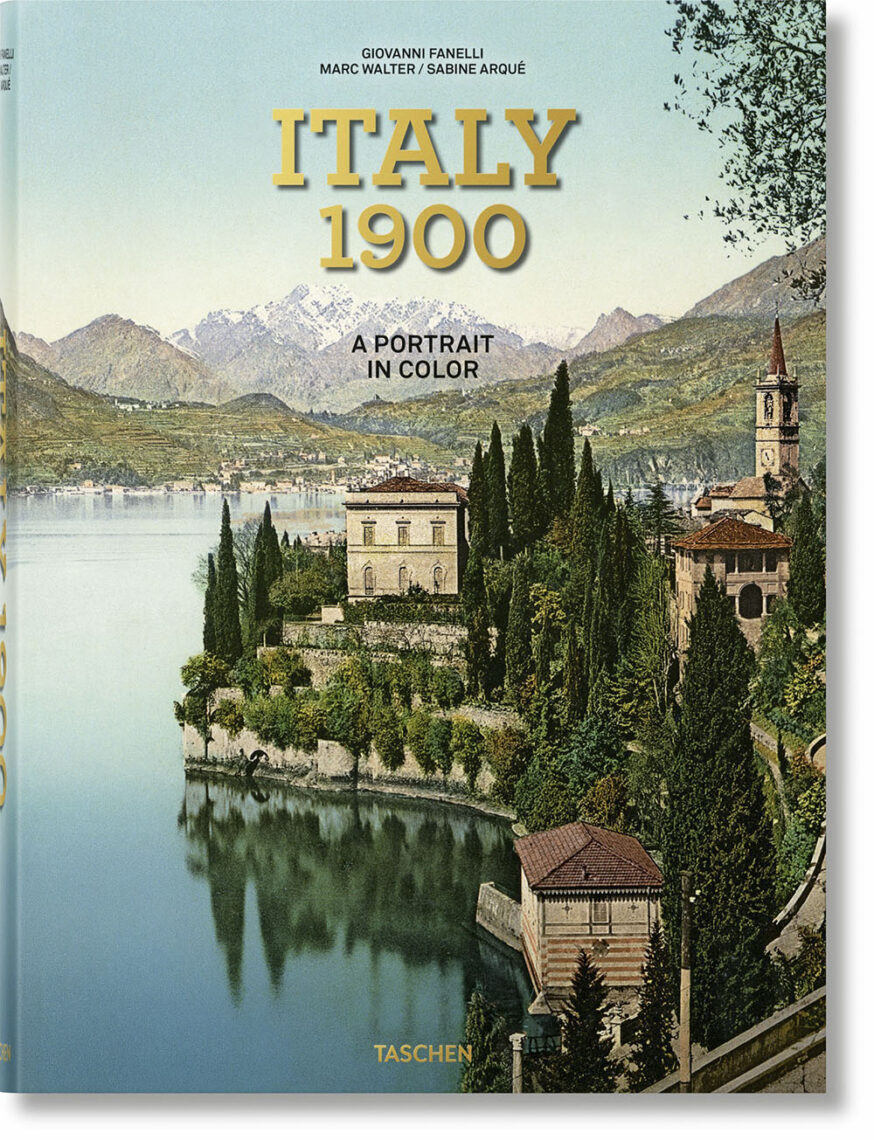

Und so ist dieses voluminöse Buch denn auch vor allem für Menschen zu empfehlen, die zumindest einige der Motive aus eigener Anschauung kennen. Aber auch allen anderen dürfte das Durchblättern der fast 600 großformatigen Seiten mit ihren farbenfrohen Abbildungen schöne Stunden bereiten. Der Einführungstext erläutert in deutscher, englischer und französischer Sprache die Geschichte der angewandten Kolorierungsverfahren; weitere Texte leiten die Kapitel zu den einzelnen Landesteilen ein. Lediglich die dreisprachigen Bildlegenden sind etwas klein und damit nicht gut lesbar geraten.

Giovanni Fanelli, Marc Walter, Sabine Arqué

Italy 1900. Ein Porträt in Farbe

Taschen Verlag 2022

580 Seiten, Großformat, 25×34 cm, voll farbig

Preis 60 Euro

Handkolorieren war zur Zeit ohne Farbfilme nützlich. Heute wird In vielen Fällen jedoch die Grenze zur Fälschung überschritten. Bei alten Spielfilmen halte ich diese Kolorierung meist nur peinlich, besonders deshalb, weil s/w-Filme meist eine entsprechende Ausleuchtung haben. Ist natürlich Geschmacksfrage.

Dass Photoshop eine KI-Kolorierung einführt wundert nicht, jedoch wäre mir lieber, würde bei dem Programm mehr natürliche Intelligenz eingesetzt. Bereits der erste Bildvergleich mit den 3 Bildern zeigt ja, wie wenig Intelligenz die KI-Kolorierung besitzt, denn der unintelligenteste menschliche Maler würde dem linken Dachsegment keinen Himmelblaustich verpassen. Und die KI-kolorierte Fassung der Cestius-Pyramide könnte einen Weißabgleich vertragen, für den würde man nicht mal Intelligenz benötigen.

Das kann man so sehen – ich dagegen bin eher beeindruckt davon, wieviel die KI überhaupt schon korrekt erkennt und dann farblich zuweist. Der Vorschlag mit „mehr natürlicher Intelligenz bei dem Programm“ ist interessant – ich denke, wenn Sie den KI-Forschern das Konzept dafür liefern, wie sie diese Kleinigkeit implementieren können, haben Sie am nächsten Monatsende ein paar Milliarden auf dem Konto.

Das mit der natürliche Intelligenz bezog sich natürlich auf die Programmierer, also die Menschen. Dass Software nach den derzeitigen mathematischen Algorithmen und mit allem „Deep Learning“ keinen Funken von Intelligenz besitzen, sollte jeder und jedem spätestens nach einigem Nachdenken klar sein.

Und die Bewunderung von farblicher Zuweisung ist für mich auch endendwollend. Wenn man Landschaftsbilder betrachtet, dass ist es ganz offensichtlich, dass der Himmel blau, die Mauern irgendwo zwischen schmutzigweiß und hellocker, Dächer ziegelrot, Boden und Pflanzen je nach Struktur irgendwie braun bis irgendwie grün sind. Anhaltspunkte liefern da ja Grauwerte.

Und die KI besteht darin, dass Leute die Ergebnisse der Algorithmen kritisch prüfen, sie verbessern, Ergebnisse kritisch verbessern, Algorithmen adaptieren usw. Das ist die Tiefe von „Deep Learning“.

Recht gut an dem blaustischigen Dachsegment zu beobachte, da konnte sicher Algorithmus nicht kapieren, dass die Dachziegel eine so raue Oberfläche haben, dass das Blau des Himmels nicht signifikant reflektiert wird. Da Algorithmen nicht intelligent sind, können sie ohne die Information über das Material des Dachziegels keine korrekte Entscheidung treffen.

Man kann mit geeigneten Bildern diese Algorithmen noch besser vorführen, doch das blaustichige Segment sollte ja Hinweis genug sein.

Der Hype um die KI ist menschlich verständlich, denn von Schamanen über Zauberkünstlern bis KI brauchen Menschen immer Staunenswertes, welches den triesten Alltag lebenswert macht. In ein paar Jahren werden dann findige Marketingleute sich wieder etwas anderes einfallen lassen und alle haben KI vergessen, auch wenn die für viele Zwecke brauchbaren Algorithmen nach wie vor in Programmen integriert sein werden. Nur kein Hahn kräht danach, sie sind eben im Alltag angekommen.

Maschinelles Lernen heißt so, weil daran nur Maschinen beteiligt sind. Es gibt keine menschliche Instanz, die die Ergebnisse in jedem von unzähligen Lernschritten bewerten würde. Das wäre gar nicht durchführbar, denn der Lernprozess würde dann Jahre dauern und sehr viel Personal erfordern; zudem sind menschliche Urteile über die Zeit nicht so stabil, wie das nötig wäre. Das „Deep“ in „Deep Learning“ bezieht sich lediglich auf die Struktur der trainierten neuronalen Netzwerke (in https://www.docma.info/blog/deep-learning-was-haenschen-nicht-lernt hatte ich das erklärt).

Natürlich schaut man sich das „ausgelernte“ Netzwerk dann noch einmal an und prüft stichprobenartig, ob ihm irgendwelche krassen Fehler unterlaufen, aber auch dann wird nicht an irgendwelchen Algorithmen gefeilt. Beim Deep Learning sind nur zwei Arten von Algorithmen im Spiel, der Algorithmus zur Simulation neuronaler Netze und der für das Lernverfahren selbst, aber beide bleiben unverändert und hängen auch nicht vom Netzwerk und der zu erlernenden Fähigkeit ab. Wenn etwas schief gegangen ist, muss man erst einmal herausfinden, was das Netzwerk da überhaupt falsch gemacht hat, und das ist bereits eine Herausforderung; danach kann man die Struktur des Netzes anpassen und/oder den Korpus des Trainingsmaterials ändern und den Lernprozess komplett neu starten.

Eingriffe in das Netzwerk in der Art, wie man Fehler in Programmen korrigiert, gibt es beim Deep Learning nicht; sie wären auch gar nicht praktikabel. Man kann auch nicht später irgendwelche „brauchbaren Algorithmen“ extrahieren, denn so funktioniert das nicht. Mit Algorithmen und der klassischen Softwareentwicklung hat maschinelles Lernen nichts mehr zu tun. Deshalb erlebt man es immer wieder mal, dass eine neue Version einer auf neuronalen Netzen basierenden Anwendung zwar manches besser macht, aber an anderen Stellen auch hinter den bereits erreichten Stand zurückfällt – man kann leider nicht einfach die guten Teile hinüberretten und bloß neue Komponenten hinzufügen, so wie es in der konventionellen Softwareentwicklung möglich ist (aber auch nicht immer praktiziert wird – ein Thema für sich, mit dem Adobe-Kunden vertraut sind).

Es ist jedoch ein riesiger Unterschied zwischen den Rechnern, die so etwas errechnen und den Kameras bis PCs, die dann die erhaltenden Programme zur Nutzung bekommen. Diese beiden Welten werden nie unterschieden. Das, was leistungsfähige Rechner beispielsweise bei der Analyse von vielen Bildern als Ergebnis bringen, wird auf Plausibilität und praktischen Nutzen von Menschen geprüft. Diese Vorgänge werden offensichtlich laufend durchgeführt und hoffentlich verbessert. Es ist nicht so, dass da eine künstliche Intelligenz eine Bewertung durchführt und danach eigenständig Verbesserungen schafft. Da müssen, hoffentlich intelligente Menschen, Ausgangswerte, Parameter. Gewichtungen usw. adaptieren.

Kommt danach ein zufriedenstellendes Ergebnis heraus, dann muss das erst in ein Mickey-Maus-Programm für einen vergleichsweise schwachen Rechner implementiert werden. Dieses Programm kann keine anspruchsvollen Analysen in Baumstrukturen zum Bewerten des Bildmaterials durchführen. Will man die Unterschiede bildlich quantifiziert darstellen, so bleibt im Rechner des Anwenders gerade mal der Bodensatz von Schwebstoffen in einem Krug. Und diese Anwendung wird vom Marketing als großartige KI verkauft.

Nun, dass auf meine präzisen Einwände beim „Erkennen“ eines Bilds nicht eingegangen wird, bin ich schon gewohnt. Bei Antworten wird nie auf andere eingegangen, so führt man eben Diskussionen.

„Es ist nicht so, dass da eine künstliche Intelligenz eine Bewertung durchführt und danach eigenständig Verbesserungen schafft. Da müssen, hoffentlich intelligente Menschen, Ausgangswerte, Parameter. Gewichtungen usw. adaptieren.“

Da sind Sie im Irrtum, denn die Bewertung erfolgt maschinell. Allerdings nicht mit künstlicher Intelligenz, sondern viel einfacher: Es gibt ein vorgegebenes Ergebnis, mit dem der Output des neuronalen Netzes verglichen wird. Das ist simple Arithmetik.

„Kommt danach ein zufriedenstellendes Ergebnis heraus, dann muss das erst in ein Mickey-Maus-Programm für einen vergleichsweise schwachen Rechner implementiert werden. Dieses Programm kann keine anspruchsvollen Analysen in Baumstrukturen zum Bewerten des Bildmaterials durchführen. Will man die Unterschiede bildlich quantifiziert darstellen, so bleibt im Rechner des Anwenders gerade mal der Bodensatz von Schwebstoffen in einem Krug.“

Auch das hat nichts mit dem zu tun, was hier tatsächlich geschieht. Das Ergebnis des Lernprozesses ist eine Matrix von Koeffizienten, die die Verbindungen zwischen den simulierten Neuronen beschreiben. Das so beschriebene Netzwerk wird dann genauso auch im PC oder in einer Kamera simuliert, und zwar prinzipiell genauso wie in der Lernphase. Die nötigen Berechnungen sind ja recht einfach – eigentlich sind es nur Multiplikationen und Additionen. Allerdings müssen sehr viele solcher Rechenoperationen ausgeführt werden, weshalb die Geschwindigkeit von einer Parallelisierung profitiert. Grafikchips mit typischerweise Tausenden von einfachen Recheneinheiten haben die dafür ideale Architektur, weshalb sie üblicherweise für solche Aufgaben eingesetzt werden. Inzwischen besitzen auch manche der in Kameras verbauten CPUs Koprozessoren für KI-Anwendungen, die so aufgebaut sind. Ein „Mickey-Maus-Programm“ als irgendwie vereinfachte Version gibt es nicht.

Das Training eines neuronalen Netzes benötigt eine sehr viel höhere Rechenleistung als die letztendliche Ausführung des fertigen Netzes. Das liegt aber nicht daran, dass in beiden Fällen etwas anderes geschähe; die Berechnungen sind vielmehr exakt dieselben. Der weit höhere Aufwand für das Training entsteht, weil dabei Hunderttausende, wenn nicht Millionen von Bildern vom Netzwerk verarbeitet werden müssen – und das ist dann nur einer von unzähligen Trainingsschritten, bis das Netzwerk die gewünschte Leistung zeigt. Das fertige, ausgelernte Netzwerk braucht dann aber nur noch je ein Bild einmal zu verarbeiten. Deshalb liegen ein paar Größenordnungen zwischen dem Aufwand für das Training und dem für die Anwendung auf dem Computer (oder der Kamera) des Anwenders.

Übrigens nutzte die Nikon F5 schon vor 26 Jahren ein neuronales Netz zur Auswertung der Matrixmessung. Verglichen mit heute eingesetzten neuronalen Netzen war es aber natürlich noch relativ einfach aufgebaut.

Sie schreiben: „Wenn man Landschaftsbilder betrachtet, dass ist es ganz offensichtlich, dass der Himmel blau, die Mauern irgendwo zwischen schmutzigweiß und hellocker, Dächer ziegelrot, …“ Ich kann da bei Weitem nicht so kompetent mitreden wie mein Kollege Michael J. Hußmann. Aber ich stolpere schon über Ihr zweites Wort: „man“. Klar, dass WIR wissen, dass der Himmel blau ist – aber eine KI muss ja erst mal lernen, diese Fläche als Himmel zu „erkennen“, ein Dach als Dach, eine Mauer als Mauer usw. (Hatte ich ja alles im Text beschrieben.) Das ist ja keineswegs leicht und selbstverständlich.

Das ist etwa so, als würde „man“ als Deutschsprachiger selbstverständlich wissen, dass das Wort „Himmel“ das Blaue da oben bezeichnet, und sich fürchterlich wundern, dass jemand, der noch nie ein Wort Deutsch gehört hat, auch nach dreißigmaloiger Wiederholung „HIMMEL!“ noch immer nicht kapiert hat, was damit gemeint ist. (Der mögliche Hinweis auf zeigen verfängt bei dieser Analogie nicht.)

Ich finde die Handcolorierung von Florenz gelungener als das Farbbild und das KI Ergebnis.

Man muss aber dabei bedenken, dass zu jeder Tageszeit das Licht anders ist und von ständig die Richtung ändert. Alle KI hin oder her, am Ende macht der Fotograf das Bild 😀 zum Glück!

LG Bernhard

https://deramateurphotograph.de/