Autofokus in drei Dimensionen

Vor zwei Wochen hatte ich hier beschrieben, wie die Belichtungszeit im Zusammenspiel von Belichtungs- und ISO-Automatik festgelegt wird – falls man sich der Automatik anvertraut. Auch hinter modernen Autofokussystemen stehen zwei verschiedene Verfahren mit unterschiedlichen Aufgaben, die idealerweise so zusammenwirken, dass am Ende scharf ist, was scharf sein soll.

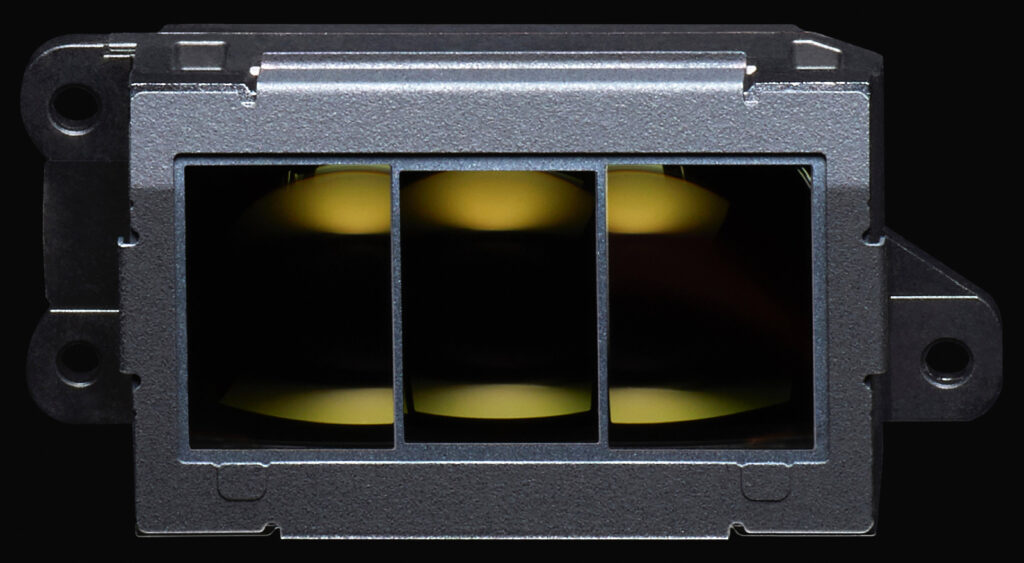

Der Autofokus ist mittlerweile so komplex geworden, dass seine eigentliche Aufgabe aus dem Blick gerät: die Linsen des Objektivs – alle zusammen oder nur eine oder mehrere Fokussiergruppen individuell – so zu verschieben, dass in der Sensor- oder Filmebene ein scharfes Bild entsteht. Die klassische AF-Methode in der analogen und lange auch noch in der digitalen Ära war die Phasendetektion mit einem dedizierten AF-Sensor im Boden einer Spiegelreflexkamera, der sein Licht über einen Sekundärspiegel hinter dem halbtransparenten Rückschwingspiegel erhielt. Ein Strahlenteiler lenkte dieses Licht so auf zwei Sensoren um, dass diese durch verschiedene Hälften des Objektivs schauten; so entstand eine Parallaxverschiebung, aus der sich berechnen ließ, wie die Linsen zur Fokussierung verschoben werden mussten.

Dieses Funktionsprinzip hatte Minolta erstmals 1985 in der Dynax 7000 eingeführt. Dabei konnten sie auf Ideen zurückgreifen, die Werner Holle schon seit 1960 bei Leitz (heute Leica) entwickelt hatte; Leitz selbst hatte später das Interesse am Autofokus verloren und überließ diese Erfindung seinem japanischen Kooperationspartner.

Indem die Kamera die Signale des AF-Sensors in schneller Folge immer wieder auswertete, konnte sie erkennen, ob und mit welcher Geschwindigkeit sich das Motiv auf die Kamera zu oder von ihr weg bewegte, und ein prädiktiver Autofokus sagte voraus, wohin sich das Motiv in der kurzen Zeit zwischen der letzten Entfernungsmessung und der Belichtung weiterbewegen würde. Damit konnte die Fokussierung im kontinuierlichen AF-Modus auch schnellen Bewegungen präzise folgen.

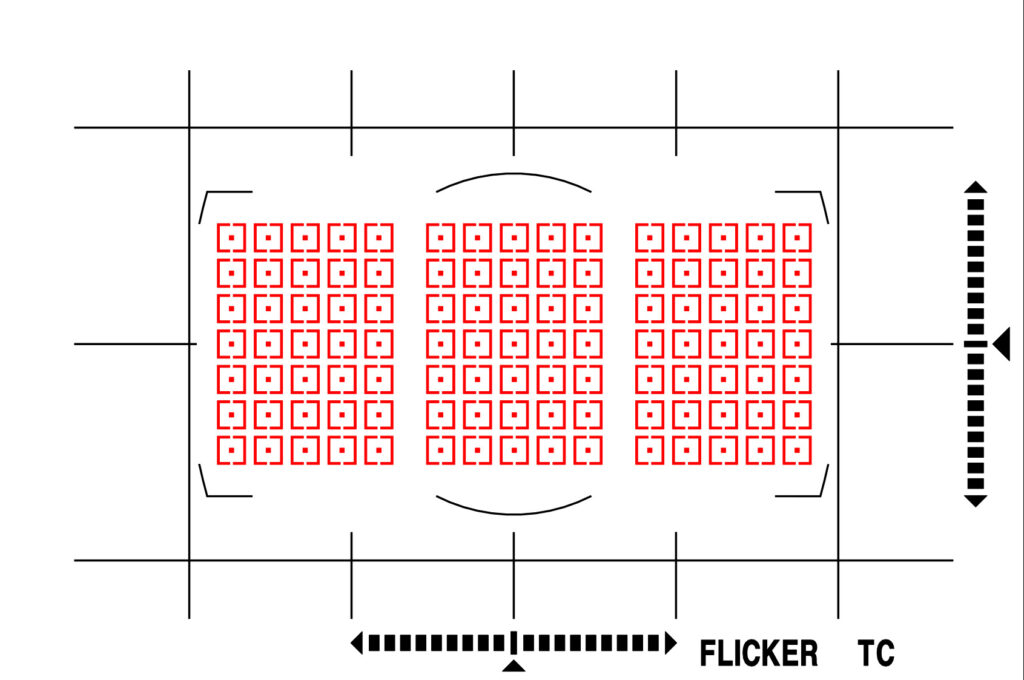

Die ersten AF-Sensoren hatten nur ein einziges Messfeld in der Bildmitte, womit es schwierig war, Motive frei im Bildfeld zu positionieren. Peilte man sein Motiv erst mit dem zentralen Messfeld an und änderte danach den Bildausschnitt, lag der Fokus mehr oder minder weit hinter dem Motiv, und bei großen Blenden konnte dieser Focus-and-Recompose-Fehler sichtbar werden. Schon 1986 brachte Minolta die Dynax 7000i mit einem 3-Feld-AF heraus, und die Zahl der Messfelder stieg in den folgenden Jahren immer weiter an. Konstruktionsbedingt blieb der Bildwinkel dedizierter Phasendetektionssensoren jedoch eingeschränkt; erst spiegellose Systemkameras, die mit Phasendetektionspixeln auf dem Bildsensor selbst scharfstellen, schaffen es mittlerweile, im gesamten Bildfeld zu fokussieren.

Egal welches Messfeld man wählt, berücksichtigt der Autofokus nur eine Dimension: die Bildtiefe. Bewegt sich das Motiv nicht bloß auf die Kamera zu oder von ihr weg, sondern auch in den übrigen beiden Dimensionen, bekommt der AF das nicht mit und verliert den Fokus – er stellt dann auf einen Punkt scharf, an dem das Motiv längst nicht mehr ist. Als Behelf konnte man eine automatische Messfeldwahl nutzen, die aber wenig Intelligenz zeigte: Sie maß mit jedem Messfeld die Distanz zu was immer sich dort im Bildfeld befand, und entschied sich für die kürzeste von ihnen. Dieses grobschlächtige Verfahren versagte, wenn sich irgendetwas in das Bildfeld hinein bewegte und dabei den Fokus kaperte, oder man zwischen unwichtigen Objekten im Vordergrund hindurch auf ein Hintergrundmotiv scharfstellen wollte.

Die erste „intelligente“ Motivverfolgung in zwei Dimensionen führte Nikon 1996 mit der F5 ein. Ihr AF-Sensor hatte zwar nur fünf Messfelder, aber wenn man mit einem dieser Felder ein Motiv in den Fokus gebracht hatte, schaltete der Autofokus immer auf das jeweils passende Messfeld um, wenn sich dieses Motiv im Bildfeld bewegte. Der AF-Sensor selbst wäre dazu nicht in der Lage gewesen, und als analoge Spiegelreflexkamera hatte die F5 auch keinen Bildsensor (wobei auch der Bildsensor einer DSLR vor dem Hochklappen des Spiegels kein Licht gesehen hätte). Sie besaß allerdings einen Belichtungsmesssensor mit 1005 Pixeln, der sogar die roten, grünen und blauen Anteile des Lichts und damit Farben unterscheiden konnte, und dieser Sensor im Prismensucher hatte das Bild schon vor der Aufnahme im Blick.

Die eigentliche Aufgabe dieses CCDs war die Matrix-Belichtungsmessung, aber Nikons Entwickler waren auf die für die Zukunft entscheidende Idee gekommen, dass sich die Belichtungs- und Entfernungsmessung zum beiderseitigen Nutzen kombinieren ließe. Zwar erschien die Auflösung des Belichtungssensors lächerlich gering, aber sie reichte durchweg aus, Motive (vor allem an ihrer Farbe) zu erkennen und durch das Bildfeld zu verfolgen. Die Belichtungsmessung wurde damit zum Helfer des Autofokus: Der AF teilte der Belichtungsmessung mit, mit welchem Messfeld er fokussiert hatte, die Belichtungsmessung analysierte die Farbe und Helligkeit des in diesem Bereich liegenden Motivs und versuchte dann, ihm zu folgen, wenn es sich im Bildfeld bewegte. So lange es in dem vom Autofokus insgesamt abgedeckten Bereich blieb, konnte der über die Bewegung informierte AF immer auf das Messfeld umschalten, in dessen Bereich sich das Motiv gerade befand.

Aus diesem Zusammenspiel von Entfernungs- und Belichtungsmessung war also schon in der analogen Ära ein 3D-Autofokus entstanden, der alle Bewegungen eines Motivs nachvollziehen konnte. Die Hilfestellung erfolgte übrigens in beiden Richtungen, denn die Matrixmessung nutzte auch die Entfernungsdaten des Autofokus, um vermutlich bildwichtige Motive zu identifizieren und für die Belichtung höher zu gewichten, weshalb Nikon das Verfahren als 3D-Color-Matrixmessung bezeichnete.

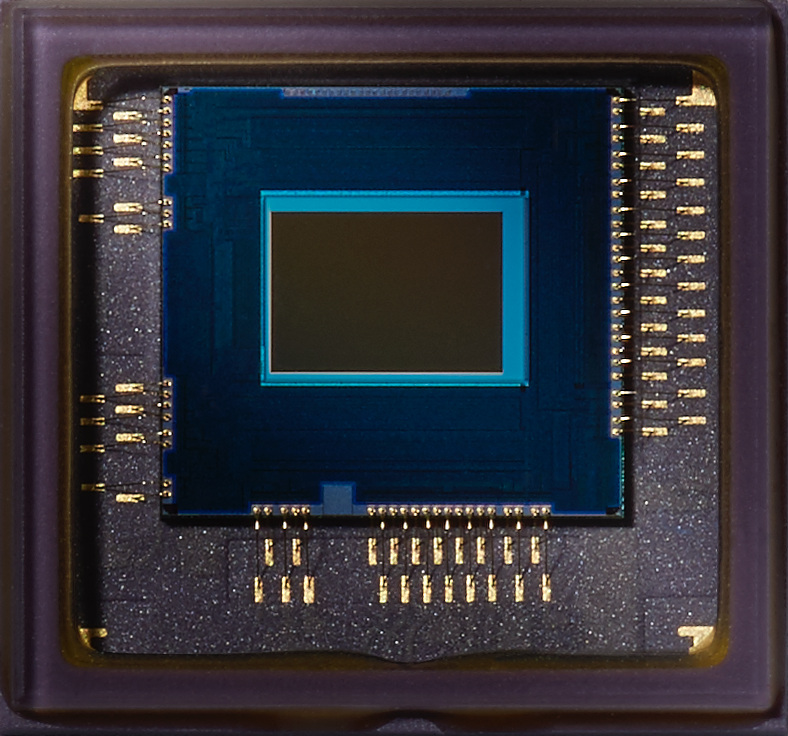

In den fast drei Jahrzehnten danach hat sich dieses Grundprinzip allgemein durchgesetzt und wurde immer weiter verfeinert. Spiegellose Kameras nutzen den Bildwandler auch für die Entfernungs- und Belichtungsmessung, und zwar mittlerweile im gesamten Bildfeld, womit sie über alle relevanten Daten verfügen – Spiegelreflexkameras mussten dagegen noch mit Scheuklappen fokussieren und ihr Belichtungssensor hatte bestenfalls Tausende statt Millionen von Pixeln. Die gestiegene Zahl der Daten wurde zudem mit immer intelligenteren Verfahren analysiert. 2005 kamen die ersten Kameramodelle mit einer Gesichtserkennung auf den Markt, und nachdem zunächst nur menschliche Gesichter von vorne erkannt wurden, kamen im Laufe der Jahre auch seitliche Ansichten und die Erkennung von Tieren hinzu – erst typische Haustiere wie Hunde und Katzen, aber inzwischen auch Wildtiere verschiedenster Gattungen. Die Voraussetzungen, Motive in wechselnden Ansichten wiederzuerkennen und ihren Bewegungen zu folgen, sind damit deutlich verbessert.

Wenn der Autofokus nun aber mal daneben liegt, was auch bei den fortschrittlichsten Verfahren noch passieren kann, muss man unterscheiden, welche Komponente hier jeweils versagt hat. Eine fehlgeleitete Motiverkennung und -verfolgung kann den Autofokus in die Irre schicken, denn er fokussiert dann vielleicht perfekt, nur auf die falsche Stelle. Umgekehrt kann auch die Motiverkennung den Bewegungen des Motivs zwar getreulich folgen, aber da sie selbst nicht scharfstellt, sondern dem Autofokus nur signalisiert, worauf er fokussieren soll, kann dieser das Ergebnis noch verderben.

Im DOCMAshop finden Sie alle Infos zum aktuellen Heft:

Das ausführliche Inhaltsverzeichnis sowie einige Seiten als Kostprobe.

Das DOCMA-Magazin können Sie als Print-Ausgabe und als E-Paper kaufen oder abonnieren. Alternativ bieten wir die Inhalte der jeweils aktuellsten DOCMA-Ausgabe auch im Abo in Form der DOCMA2go als wöchentliche E-Mails an (verteilt über 13 Wochen).

Zu den Print-Abos | Zu den Digital-Abos